A NVIDIA anunciou recentemente o aplicativo Chat with RTX para executar chatbots locais em computadores com placas gráficas RTX. Agora a AMD revelou como executar um chatbot de IA localmente em um de seus modelos abertos de linguagem grande (LLMs) usando seus processadores e placas gráficas. A empresa sugere o uso do aplicativo de terceiros LM Studio.

Fonte da imagem: AMD

Para executar um chatbot de IA, você precisará de um sistema com o acelerador Ryzen AI, que está disponível apenas em algumas APUs das séries Ryzen 7000 e 8000 (Phoenix e Hawk Point), ou uma placa gráfica AMD Radeon RX série 7000.

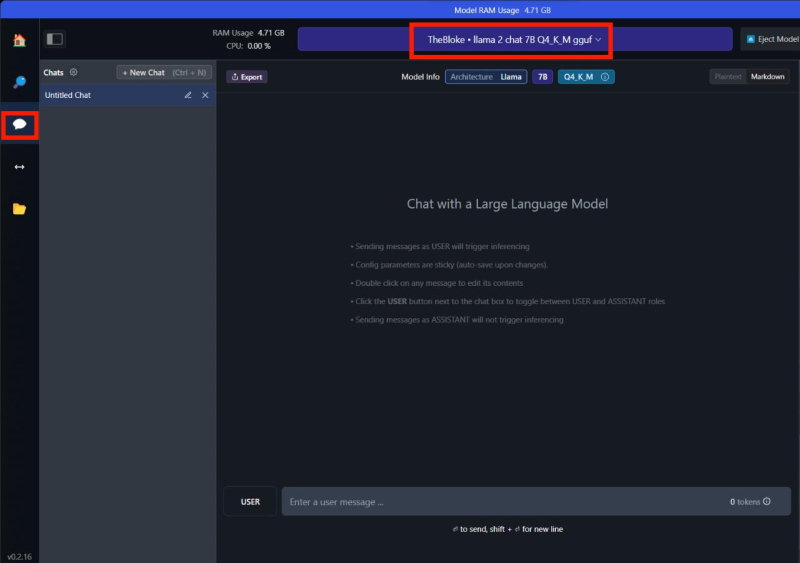

O primeiro passo é instalar o LM Studio para Windows, e para acelerar a IA usando uma placa de vídeo, você precisará de uma versão com suporte ROCm. Em seguida, você precisa inserir TheBloke/OpenHermes-2.5-Mistral-7B-GGUF na barra de pesquisa para iniciar um bot baseado em Mistral 7b ou TheBloke/Llama-2-7B-Chat-GGUF para usar LLAMA v2 7b, dependendo do modelo de interesse. Então você precisa encontrar no painel direito e baixar o arquivo do modelo Q4 K M. Finalmente, você pode ir para a aba de chat e começar a se comunicar com a IA.

Para acelerar a IA usando uma placa de vídeo da série Radeon RX 7000, você precisa seguir mais algumas etapas: definir o valor máximo de descarregamento de GPU nas configurações e certificar-se de que AMD ROCm seja exibido no bloco Detected GPU Type.

Assim, ao contrário da NVIDIA, a AMD ainda não está pronta para apresentar a sua própria aplicação para comunicação com um chatbot, mas isso não significa que isso não acontecerá no futuro.