A Meta✴ este ano implantará sistemas baseados em chips de IA de segunda geração de seu próprio projeto em seus data centers, escreve a Reuters. Cada vez mais empresas de tecnologia estão caminhando para a criação de sistemas de IA integrados verticalmente, baseados em seu próprio hardware, em vez de aceleradores escassos e caros da NVIDIA, AMD e outros fabricantes terceiros.

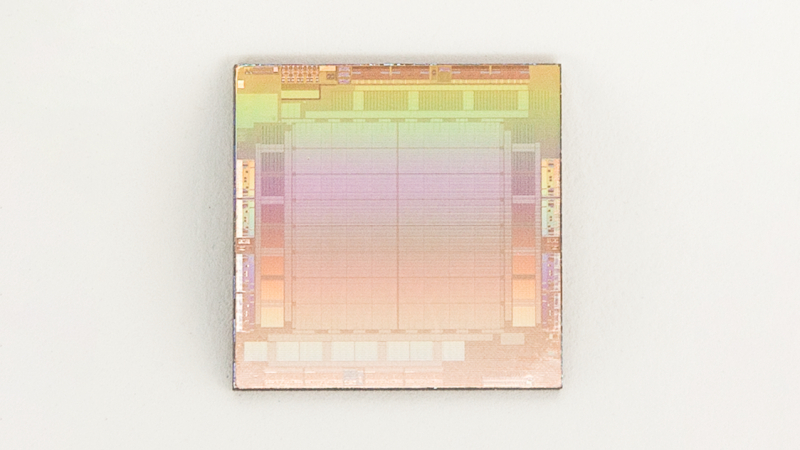

Chip Meta✴ AI de primeira geração. Fonte da imagem: Meta✴

O chip Meta✴ AI de segunda geração, anunciado pela Meta✴ no ano passado, pode ajudar a empresa a reduzir sua dependência dos aceleradores de IA da NVIDIA, que capturaram mais de 70% do mercado, e controlar melhor os custos cada vez maiores da IA. A empresa precisa aumentar o poder de computação para os produtos generativos de IA que está lançando no Facebook✴, Instagram✴ e WhatsApp, bem como dispositivos de hardware como os óculos inteligentes Ray-Ban. A Meta✴ está atualmente gastando bilhões de dólares na compra de chips especializados e na atualização de data centers.

Na escala em que a Meta✴ opera, a implementação bem-sucedida de seu próprio chip poderia economizar centenas de milhões de dólares anualmente em custos de energia, bem como bilhões em custos de aquisição, de acordo com Dylan Patel, fundador do grupo de mercado de chips da empresa de pesquisa SemiAnalysis. . salgadinhos. Os chips, a infra-estrutura e a energia necessários para fazer funcionar os sistemas de IA tornaram-se um gigantesco canal de investimento para as empresas tecnológicas, anulando de certa forma os ganhos obtidos com a propaganda da tecnologia.

Um porta-voz da Meta✴ confirmou à Reuters os planos de iniciar a produção do chip Meta✴ atualizado em 2024, dizendo que funcionará em coordenação com centenas de milhares de GPUs novas e existentes. “Acreditamos que nossos aceleradores proprietários são altamente complementares às GPUs disponíveis comercialmente, fornecendo a combinação ideal de desempenho e eficiência em cargas de trabalho específicas do Meta✴”, disse um porta-voz do Meta✴ em comunicado.

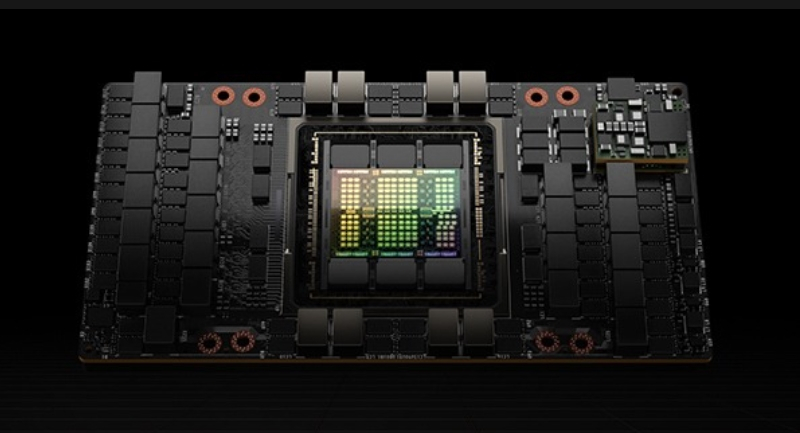

O CEO da Meta✴, Mark Zuckerberg, disse no mês passado que a empresa espera ter cerca de 350.000 aceleradores NVIDIA H100 carro-chefe até o final de 2024. Quando combinado com outros sistemas, o Meta✴ será capaz de acumular poder computacional equivalente a 600.000 aceleradores H100, disse ele.

Acelerador NVIDIA H100 AI. Fonte da imagem: NVIDIA

Observe que a Meta✴ já havia criado seus próprios chips de IA, mas em 2022 a administração da empresa decidiu abandonar o chip de primeira geração. Em vez disso, a empresa decidiu comprar GPUs NVIDIA no valor de bilhões de dólares.

O novo chip, de codinome interno Artemis, assim como seu antecessor, só pode ser usado para lançar redes neurais já treinadas, mas não para treiná-las. O chip no qual as redes neurais já treinadas serão executadas pode ser significativamente mais eficiente em tarefas Meta✴ do que os chips NVIDIA que consomem muita energia. Chips de terceiros continuarão a ser usados para treinar IA, mas no ano passado foi relatado que a Meta✴ também estava trabalhando em um chip mais ambicioso que também poderia treinar e operar redes neurais.

Acelerador de IA Google Cloud TPU v5p. Fonte da imagem: Google

Outras grandes empresas de tecnologia – Amazon, Google e Microsoft – também estão desenvolvendo seus próprios chips para diversas tarefas de IA. Google e Amazon há muito produzem chips para seus próprios data centers. No final do ano passado, o Google revelou seu acelerador de IA mais rápido, Cloud TPU v5p, e a Amazon lançou aceleradores Trainium2 para treinar grandes modelos de IA. A Microsoft está tentando acompanhar e criou o acelerador Maia 100 AI, bem como o processador Cobalt 100 Arm – ambos os chips são projetados para acelerar as tarefas de IA.

Sistema acelerado por IA Microsoft Maia 100. Fonte da imagem: Microsoft

A NVIDIA vendeu 2,5 milhões de chips no ano passado por cerca de US$ 15 mil cada, segundo estimativas do analista Pierre Ferragu, da New Street Research. Ao mesmo tempo, o Google gastou cerca de US$ 2 a 3 bilhões na criação de cerca de um milhão de seus próprios chips de IA, diz o especialista, ou seja, cada chip custou apenas US$ 2 a 3 mil. Por sua vez, a Amazon gastou US$ 200 milhões em 100.000 de seus próprios chips no ano passado.

Também houve relatos recentes de que a OpenAI, desenvolvedora do ChatGPT, também está interessada em criar seu próprio chip. O chefe da empresa, Sam Altman, já está negociando com investidores e fabricantes contratados de chips. Assim, cada vez mais empresas tentam se livrar da dependência da NVIDIA, cujos aceleradores, embora sejam os melhores do mercado, são um produto extremamente escasso (os pedidos estão agendados com um ano de antecedência), e também custam bastante muito.