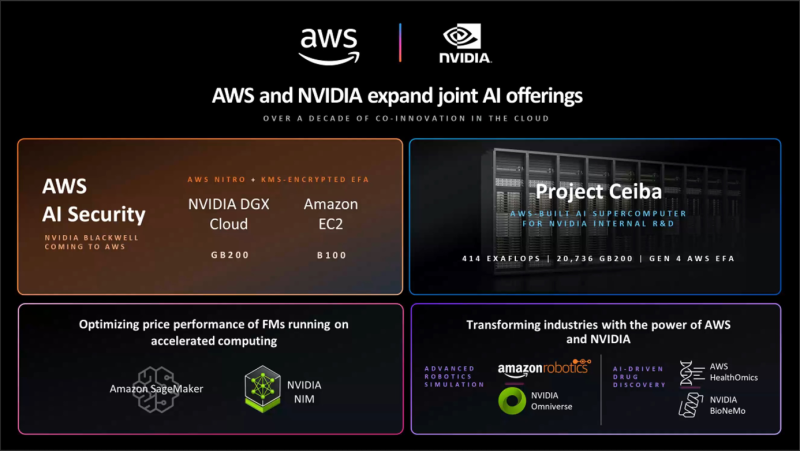

Amazon Web Services (AWS) e NVIDIA anunciaram uma colaboração ampliada que em breve trará os aceleradores GB200 e B100 para a nuvem AWS. Além disso, as empresas anunciaram a integração do Amazon SageMaker com NVIDIA NIM para fornecer aos clientes inferência mais rápida e barata, o aparecimento de novos modelos básicos NVIDIA BioNeMo no AWS HealthOmics e suporte da AWS para a plataforma NVIDIA AI Enterprise atualizada.

A colaboração das duas empresas reúne suas tecnologias mais recentes em uma única infraestrutura, incluindo sistemas multi-nós baseados em chips NVIDIA Blackwell, software de IA, AWS Nitro, AWS Key Management Service (AWS KMS), Elastic Fabric Network Adapters (EFA) e Clusters EC2 UltraCluster. A infraestrutura e as ferramentas propostas permitirão que os clientes criem e executem LLMs de vários trilhões de parâmetros com mais rapidez, escala e custo menor do que as instâncias EC2 com aceleradores NVIDIA da geração anterior.

A AWS oferecerá EC2 UltraClusters de superaceleradores GB200 NVL72 que agregarão milhares de chips GB200. O GB200 também estará disponível como parte das instâncias NVIDIA DGX Cloud. A AWS também oferecerá EC2 UltraClusters com aceleradores B100. A Amazon observa que a combinação de AWS Nitro e NVIDIA GB200 aumentará ainda mais a segurança dos modelos de IA: GB200 fornece criptografia NVLink, EFA criptografa dados em trânsito entre nós de cluster e KMS permite gerenciar centralmente chaves de criptografia.

Fonte da imagem: NVIDIA

O hipervisor de hardware AWS Nitro, como antes, descarrega a CPU dos nós, assumindo o processamento das operações de E/S e também protege o código e os dados enquanto trabalha com eles. Este recurso, disponível apenas em serviços AWS, foi testado e verificado pelo Grupo NCC. As instâncias GB200 oferecem suporte ao AWS Nitro Enclaves, permitindo que você interaja diretamente com o acelerador e os dados em um ambiente isolado e seguro que nem mesmo os funcionários da Amazon podem acessar.

Fonte da imagem: NVIDIA

Os chips Blackwell serão usados no supercomputador em nuvem atualizado do AWS Project Ceiba, que será usado pela NVIDIA para pesquisa e desenvolvimento nas áreas de LLM, geração de imagem/vídeo/3D, modelagem, biologia digital, robótica, carros autônomos, clima previsão, etc. Esta máquina GB200 baseada em NVL72, inédita, consistirá em 20.736 superchips GB200, cada um com conectividade EFA de 800 Gbps. O desempenho máximo do sistema no FP8 será de 414 Eflops.