Cientistas da Universidade de Maryland (EUA) publicaram os resultados de um estudo que descobriu que marcas d’água introduzidas por plataformas de inteligência artificial durante a geração de imagens podem ser removidas.

Fonte da imagem: Arxiv.org

Os geradores de imagens de IA estão agora disponíveis publicamente e as pessoas os utilizam cada vez mais para criar “fotos” e até vídeos de coisas que nunca aconteceram. Estas obras podem aparecer como uma piada ou com o propósito de desinformar deliberadamente os outros – o importante é que sejam credíveis o suficiente para enganar uma pessoa. As autoridades sugerem que os desenvolvedores de sistemas de IA rotulem esse conteúdo, mas na prática isso não é tão simples.

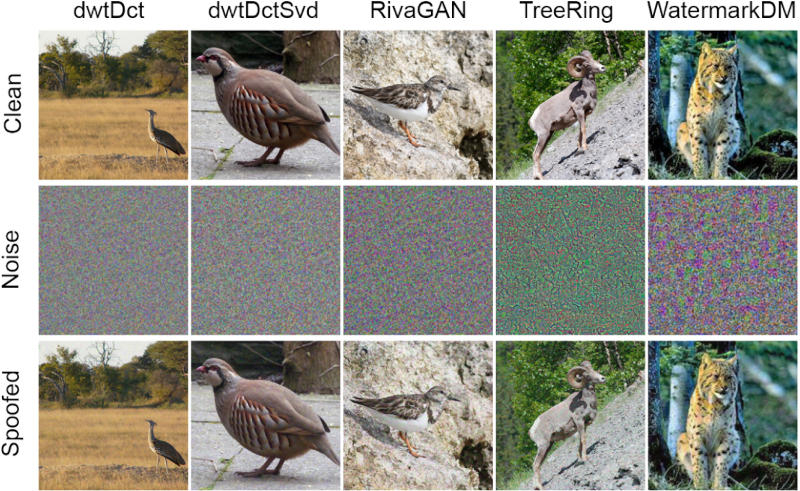

Pesquisadores da Universidade de Maryland decidiram estudar a eficácia das técnicas de detecção de imagens por IA. Acontece que as marcas d’água criadas durante a geração da imagem são facilmente removidas usando limpeza por difusão ou um ataque de substituição de modelo. A limpeza por difusão, que é adicionar ruído a uma imagem e depois removê-lo, permite remover marcas d’água colocadas usando métodos de baixa perturbação, como RivaGAN e WatermarkDM. Para métodos com alto nível de perturbações, como StegaStamp, é utilizado um ataque de substituição de modelo – força os sistemas utilizados para análise de IA a identificarem as imagens geradas como reais.

Esta é uma má notícia para Alphabet, Amazon, Meta✴, Microsoft e OpenAI, que já se comprometeram a desenvolver tecnologias de marcação de conteúdo de IA para combater a desinformação. Por outro lado, a própria ideia de marcar imagens criadas por geradores de IA não implica proteção completa contra desinformação, porque elas não são visíveis a olho nu, e é improvável que o usuário médio da Internet verifique a autenticidade de cada imagem que encontra. Isto significa que a rotulagem só é útil nos casos em que já surgiram suspeitas.