A NVIDIA apresentou hoje o acelerador de computação mais poderoso do mundo, o H200. Ele é construído na já familiar arquitetura NVIDIA Hopper e é, na verdade, uma versão atualizada do popular acelerador H100 com memória HBM3e mais rápida. A nova memória permitirá que o acelerador processe grandes quantidades de dados com mais rapidez para IA generativa e cargas de trabalho de computação de alto desempenho.

Fonte da imagem: NVIDIA

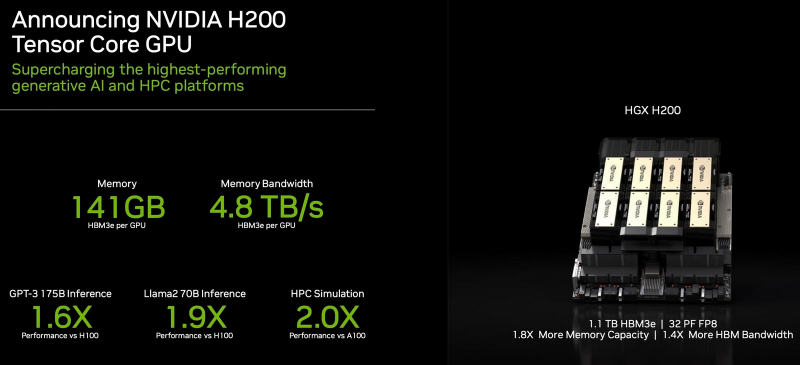

A NVIDIA H200 é a primeira GPU a apresentar memória HBM3e, que é mais rápida que o HBM3 normal. NVIDIA H200 recebeu 141 GB de memória HBM3e com velocidade de 4,8 TB/s, o que é quase o dobro em volume e 2,4 vezes mais em largura de banda em comparação com a memória do acelerador NVIDIA A100 da geração anterior. Para efeito de comparação, o H100 tem 80 GB de HBM3 a 3,35 TB/s, enquanto o próximo Instinct MI300X da AMD contará com 192 GB de HBM3 a 5,2 TB/s.

Devido ao upgrade de memória, o H200 proporcionará um aumento significativo de desempenho no trabalho de sistemas de inteligência artificial (inferência) já treinados. Por exemplo, a NVIDIA promete um aumento na velocidade do modelo de linguagem grande Llama 2 com 70 bilhões de parâmetros em 1,9 vezes em comparação com o H100. E o novo produto irá acelerar em 1,6 vezes o trabalho de um modelo GPT-3 treinado com 175 bilhões de parâmetros.

NVIDIA H200 estará disponível nas placas para servidores NVIDIA HGX H200 em configurações de quatro e oito aceleradores. Além disso, os novos produtos são compatíveis com hardware e software dos sistemas HGX H100. Fabricantes de servidores incluindo ASRock Rack, ASUS, Dell Technologies, Eviden, GIGABYTE, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron e Wiwynn lançarão seus sistemas com aceleradores H200. Por sua vez, Amazon Web Services, Google Cloud, Microsoft Azure e Oracle Cloud Infrastructure estarão entre os primeiros provedores de serviços em nuvem a oferecer instâncias baseadas em H200 a partir do próximo ano.

A NVIDIA observa que o sistema HGX H200, com oito aceleradores, oferece mais de 32 Pflops (32 quatrilhões de operações por segundo) de desempenho computacional de aprendizagem profunda FP8. Além disso, tal sistema fornecerá um total de 1,1 TB de memória de alta largura de banda para o mais alto desempenho em aplicações generativas de IA e HPC.

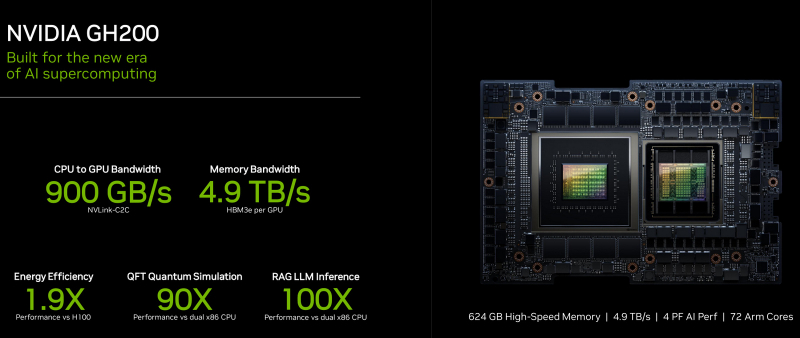

Emparelhado com processadores NVIDIA Grace Arm com interface NVLink-C2C ultrarrápida, o H200 forma o superchip GH200 Grace Hopper com HBM3e. A NVIDIA posiciona esses módulos integrados como soluções de alto desempenho para trabalhar com aplicações HPC e IA em uma escala gigantesca.

A NVIDIA também apresentou a placa Quad GH200 com quatro superchips GH200, onde todos os aceleradores são conectados entre si via NVLink em um esquema each-to-each. No total, a placa carrega mais de 2 TB de memória de alta velocidade e 288 núcleos Arm, e seu desempenho chega a 16 Pflops no FP8. Até o final do próximo ano, o desempenho total de IA dos sistemas com o GH200, segundo estimativas da NVIDIA, chegará a 200 Eflops.

O acelerador NVIDIA H200 estará disponível no segundo trimestre de 2024.