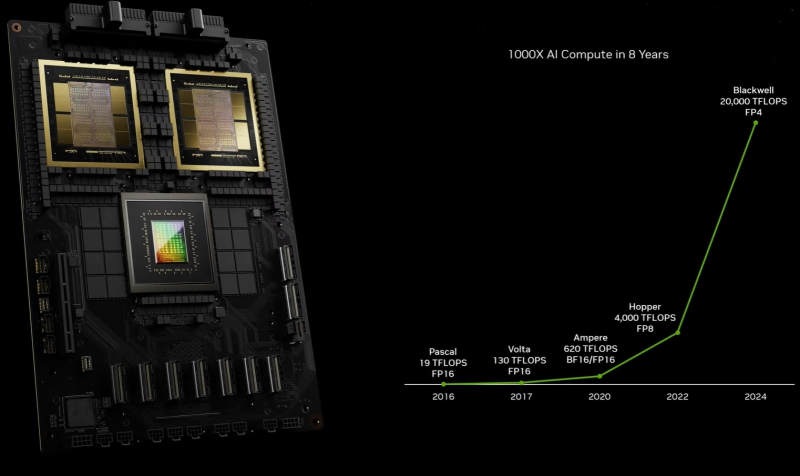

A Nvidia apresentou aceleradores de IA de próxima geração em GPUs com arquitetura Blackwell na conferência GTC 2024. De acordo com o fabricante, os próximos aceleradores de IA permitirão a criação de redes neurais ainda maiores, incluindo o trabalho com grandes modelos de linguagem (LLMs) com trilhões de parâmetros, e serão até 25 vezes mais eficientes em termos energéticos e econômicos em comparação com Funil.

Fonte da imagem: NVIDIA

A arquitetura da GPU Blackwell leva o nome do matemático americano David Harold Blackwell e inclui uma gama de tecnologias inovadoras de aceleração computacional que ajudarão a alcançar avanços em processamento de dados, simulação de engenharia, automação de projeto eletrônico, projeto de medicamentos auxiliado por computador, computação quântica e IA generativa. Além disso, a Nvidia dá ênfase especial a este último: “A IA generativa é a tecnologia que define o nosso tempo. As GPUs Blackwell são o motor da nova revolução industrial”, disse o CEO da Nvidia, Jensen Huang, durante a apresentação.

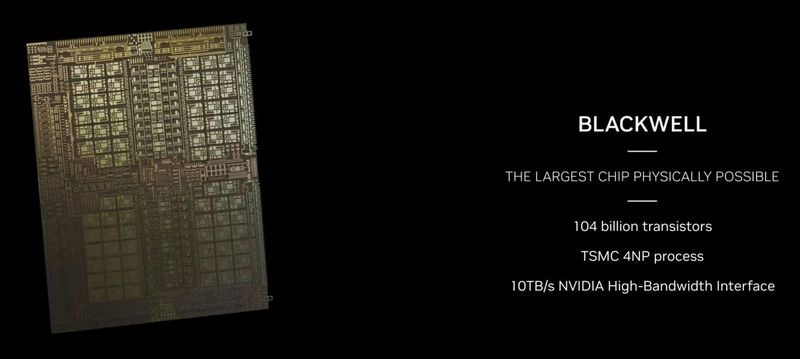

O fabricante, sem modéstia indevida, chama o processador gráfico Nvidia B200 de o chip mais poderoso do mundo. Na computação FP4 e FP8, a nova GPU oferece desempenho de até 20 e 10 Pflops, respectivamente. A nova GPU consiste em dois cristais, que são produzidos usando uma versão especial da tecnologia de processo TSMC 4NP 4nm e combinados com embalagem 2.5D CoWoS-L. Esta é a primeira GPU da Nvidia com layout de chip. Os chips são conectados por um barramento NV-HBI com taxa de transferência de 10 TB/s e operam como uma única GPU. No total, o novo produto conta com 208 bilhões de transistores.

Um cristal Blackwell – existem dois desses cristais na GPU

Nas laterais dos cristais da GPU estão oito pilhas de memória HBM3e com capacidade total de 192 GB. Seu rendimento chega a 8 TB/s. E para combinar vários aceleradores Blackwell em um sistema, a nova GPU recebeu suporte para a interface NVLink de quinta geração, que fornece taxa de transferência de até 1,8 TB/s em ambas as direções. Usando esta interface (switch NVSwitch 7.2T), até 576 GPUs podem ser combinadas em um pacote.

Uma das principais fontes do maior desempenho do B200 foram os novos Tensor Cores e a segunda geração do Transformer Engine. Este último aprendeu a selecionar com mais precisão a precisão de cálculo necessária para determinadas tarefas, o que afeta tanto a velocidade de treinamento e operação das redes neurais, quanto o volume máximo de LLMs suportados. Agora a Nvidia oferece treinamento de IA no formato FP8, e FP4 é suficiente para executar redes neurais treinadas. Mas observe que a Blackwell suporta uma ampla variedade de formatos, incluindo FP4, FP6, FP8, INT8, BF16, FP16, TF32 e FP64. E em todos os casos, exceto no último, há suporte para computação esparsa.

O principal acelerador da nova arquitetura será o Nvidia Grace Blackwell Superchip, que combina um par de GPUs B200 e um processador Nvidia Grace central Arm com 72 núcleos Neoverse V2. Este acelerador tem metade da largura de um rack de servidor e um TDP de até 2,7 kW. O desempenho nas operações FP4 chega a 40 Pflops, enquanto nas operações FP8/FP6/INT8 o novo GB200 é capaz de entregar 10 Pflops.

Como a própria Nvidia observa, o novo produto oferece um aumento de 30 vezes no desempenho em comparação com o Nvidia H100 para cargas de trabalho associadas a modelos de linguagem grande, e é até 25 vezes mais econômico e eficiente em termos de energia.

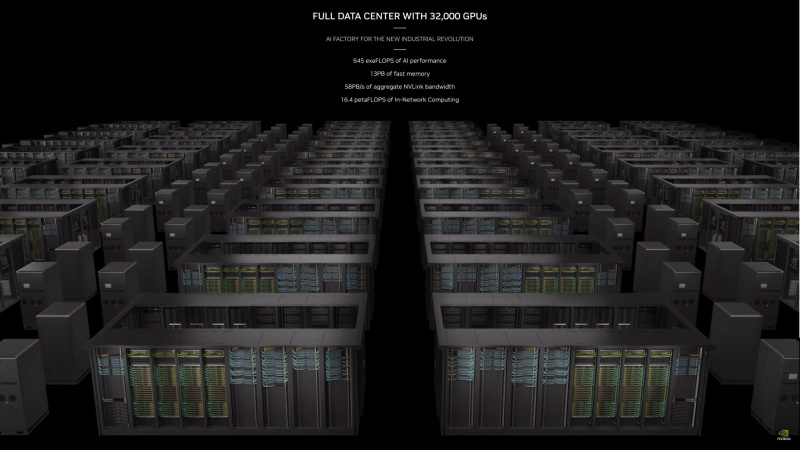

A Nvidia também apresentou o sistema GB200 NVL72 – na verdade, este é um rack de servidor que combina 36 Superchips Grace Blackwell e um par de switches NVSwitch 7.2T. Assim, este sistema inclui 72 GPUs Blackwell B200 e 36 CPUs Grace conectadas por NVLink de quinta geração. O sistema possui 13,5 TB de memória HBM3e com largura de banda total de até 576 TB/s, e a quantidade total de RAM chega a 30 TB.

A plataforma GB200 NVL72 opera como uma única GPU com desempenho de IA de 1,4 exaflops (FP4) e 720 pflops (FP8). Este sistema será a base do mais novo supercomputador da Nvidia, o DGX SuperPOD.

Em primeiro plano está um sistema HGX com oito Blackwells. Na parte traseira há um superchip GB200

Finalmente, a Nvidia apresentou os sistemas de servidores HGX B100, HGX B200 e DGX B200. Todos eles oferecem oito aceleradores Blackwell, interligados por NVLink 5. Os sistemas HGX B100 e HGX B200 não possuem CPU própria, e diferem apenas no consumo de energia e, consequentemente, na potência. O HGX B100 é limitado a um TDP de 700W e oferece desempenho de até 112 e 56 Pflops em operações FP4 e FP8/FP6/INT8, respectivamente. Por sua vez, o HGX B200 possui TDP de 1000 W e oferece até 144 e 72 Pflops em operações FP4 e FP8/FP6/INT8, respectivamente.

Finalmente, o DGX B200 espelha o HGX B200 em termos de desempenho, mas é um sistema completo com um par de CPUs Intel Xeon Emerald Rapids. De acordo com a Nvidia, o DGX B200 é até 15 vezes mais rápido na execução de modelos pré-treinados de trilhões de dólares em comparação com seu antecessor.

Para criar os sistemas de IA de maior escala, incluindo de 10 mil a 100 mil aceleradores GB200 em um data center, a Nvidia propõe combiná-los em clusters usando as interfaces de rede Ethernet Nvidia Quantum-X800 InfiniBand e Spectrum-X800. Eles também foram anunciados hoje e fornecerão recursos avançados de rede com velocidades de até 800 Gbps.

Muitos fabricantes apresentarão em breve seus sistemas baseados em Nvidia B200, incluindo Aivres, ASRock Rack, ASUS, Eviden, Foxconn, GIGABYTE, Inventec, Pegatron, QCT, Wistron, Wiwynn e ZT Systems. Também Nvidia GB200 como parte da plataforma Nvidia DGX Cloud e, ainda este ano, soluções neste super chip estarão disponíveis nos principais provedores de nuvem, incluindo AWS, Google Cloud e Oracle Cloud.