O Google falou sobre seus próprios supercomputadores, que usa para treinar sistemas de inteligência artificial como o chatbot Bard. De acordo com a empresa, esses sistemas são mais rápidos e eficientes do que os aceleradores NVIDIA A100 comparáveis.

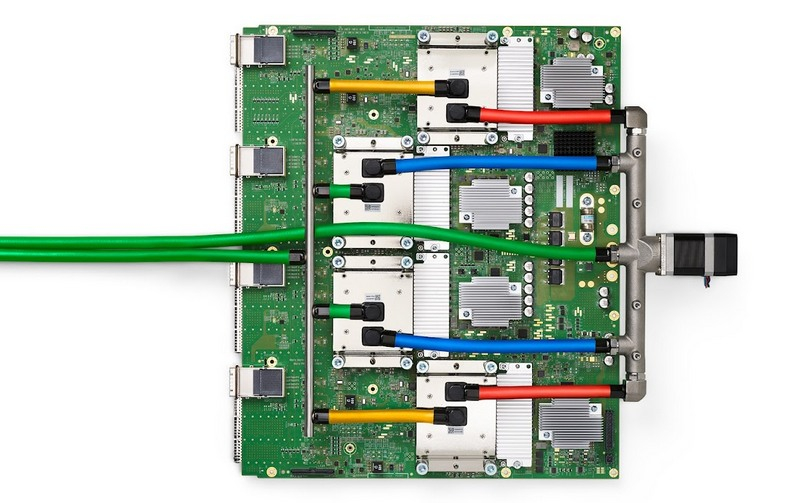

Google TPU v4. Fonte da imagem: Google

Os engenheiros do Google desenvolveram sua própria Unidade de Processamento Tensor ou chip TPU, que é usado em mais de 90% das tarefas de treinamento de IA da empresa, resultando em chatbots que podem se comunicar quase como uma pessoa e sistemas que geram imagens. Agora a empresa está trabalhando com TPU para a quarta geração – um artigo publicado pelos engenheiros do Google fala sobre um supercomputador baseado em mais de 4.000 desses chips e linhas de comunicação óptica entre os componentes do sistema.

O modelo de linguagem grande do Google PaLM, o maior de seu tipo para o público, foi treinado em dois supercomputadores de 4.000 chips por 50 dias. Os supercomputadores possuem mecanismos para reconfigurar as conexões entre os chips em tempo real – isso ajuda a evitar falhas e melhora o desempenho.

O Google acaba de revelar detalhes sobre o sistema desenvolvido por seus engenheiros, mas destacou que esse supercomputador foi lançado pela primeira vez em 2020 em um data center no condado de Mays (EUA, Oklahoma). Em particular, foi usado para treinar AI Midjourney – essa rede neural gera imagens a partir de uma descrição de texto. De acordo com o Google, seu chip TPU de quarta geração é 1,7 vezes mais rápido e 1,9 vezes mais eficiente em termos de energia do que o acelerador NVIDIA A100 lançado ao mesmo tempo. Nenhuma comparação foi feita com o modelo H100 – ele entrou no mercado mais tarde e é baseado em tecnologias mais modernas. No entanto, a empresa deu a entender que pode estar trabalhando em um novo TPU que possa competir com o H100.