O Google lançou um novo mecanismo de inferência para sua plataforma Android TensorFlow que roda em aceleradores móveis via OpenCL. Ele está disponível na versão mais recente da biblioteca TensorFlow Lite, e a empresa afirma que o mecanismo oferece até 2x a velocidade de seu mecanismo OpenGL existente ao executar modelos de IA de “tamanho razoável”.

Khari Johnson / VentureBeat

OpenGL tem evoluído por três décadas como uma API independente de plataforma para renderização 2D e 3D. Os sombreadores de computação foram adicionados ao OpenGL ES 3.1, mas a equipe do TensorFlow afirmou que, devido à compatibilidade com versões anteriores, esta API não permite todo o potencial das GPUs. Por outro lado, o OpenCL foi desenvolvido desde o início como um padrão para computação usando vários aceleradores e é mais adequado para implementar mecanismos de inferência em aceleradores móveis. Isso levou a equipe do TensorFlow a fazer pesquisas e, eventualmente, migrar para um mecanismo baseado em OpenCL.

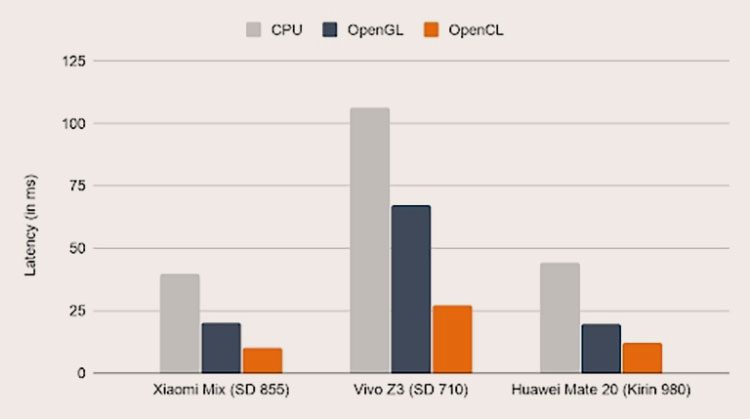

Velocidade de inferência ao executar o modelo MNASNet 1.3 em alguns dispositivos Android (CPU, OpenGL e OpenCL)

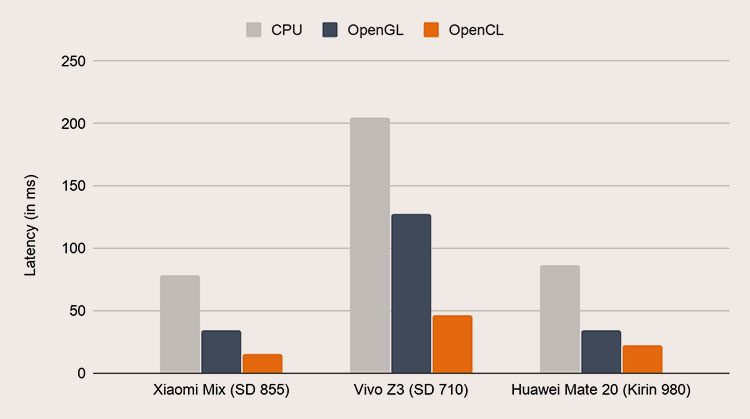

Com suporte para FP16 e outros recursos de GPU no novo mecanismo de inferência TensorFlow, alguns aceleradores mais antigos, como o Adreno 305 2012, agora serão capazes de funcionar em velocidade total. Em alguns casos, o aumento acaba sendo mais do que o dobro. Por exemplo, quando o sistema neural de pesquisa MNASNet 1.3 está em execução por meio da nova biblioteca TensorFlow, os atrasos foram reduzidos de 100 ms em um Vivo Z3 com um mecanismo baseado em OpenGL para 25 ms com uma nova versão baseada em OpenCL. Em outro teste com o algoritmo de detecção de objeto SSD MobileNet v3 no Huawei Mate 20, ele também reduziu a latência de quase 100 ms para menos de 25 ms.

Velocidade de inferência ao executar o modelo SSD MobileNet v3 em alguns dispositivos Android (CPU, OpenGL e OpenCL)

O Google observou que o OpenCL não faz parte da distribuição padrão do Android, tornando a nova biblioteca indisponível para alguns usuários. Como medida temporária, o TensorFlow Lite agora verifica a presença de OpenCL e, se a API não estiver disponível, muda para um mecanismo baseado em OpenGL.