Em 2017, investigadores das Universidades de Oxford e Yale publicaram uma previsão consolidada sobre o ritmo de desenvolvimento da inteligência artificial, entrevistando mais de 350 veneráveis especialistas neste tema e calculando a média das respostas recebidas. Com o conhecimento atual, pode argumentar-se que os cientistas e engenheiros formularam as suas previsões não apenas com extrema cautela (em média), mas também com uma distribuição significativa das realizações esperadas da IA ao longo da escala temporal. Assim, a inteligência das máquinas, segundo esta opinião generalizada, terá que superar a inteligência biológica nas seguintes áreas:

- Traduções de uma língua (humana) para outra – até 2024,

- Escrever redações para programas de ensino superior – até 2026,

- Dirigir um caminhão em vias públicas – até 2027,

- Trabalhar no comércio varejista – até 2031,

- Criando um best-seller literário até 2049,

- Realização de operações cirúrgicas – até 2053.

Em geral, os entrevistados acreditam que há 50% de probabilidade de que a IA execute com confiança todas as tarefas atualmente realizadas pelos humanos nos próximos 45 anos (contando a partir de 2017, lembramos) e que em 120 anos no planeta, em princípio, haverá não restaram atividades não automatizadas que as bolsas de couro pudessem reservar exclusivamente para si (“Você vai comer para mim?!” – “Sim…”).

A realidade, como costuma acontecer na indústria de TI, não quis obedecer às previsões dos especialistas. A ascensão meteórica da IA generativa, que há seis anos era apenas uma das muitas abordagens à aprendizagem automática, acelerou claramente o progresso em direcções criativas, por assim dizer. Até o final de 2023, os chatbots lidarão bem com a redação de trabalhos de conclusão de curso bastante convincentes, com a expansão/aprofundamento do funil de vendas no varejo e com traduções, inclusive de voz e voz (sintetizadas por um sistema de computador também em tempo real). Sim, embora a máquina não execute todas estas tarefas obviamente melhor do que um especialista escolhido aleatoriamente nesta área específica, ela já conseguiu causar muita preocupação entre os representantes das profissões criativas ao longo do ano. E eles não são os únicos!

Como as formas dos processos judiciais americanos são persistentemente conservadoras, não conseguimos obter uma fotografia do futuro próximo de um advogado-robô falando em um julgamento – apenas este esboço (fonte: geração de IA baseada no modelo SDXL 1.0)

⇡#Janeiro

O advogado robô não foi autorizado a comparecer ao tribunal. A startup americana DoNotPay, que em 2015 desenvolveu um aplicativo que permite aos clientes resolver rapidamente questões jurídicas padrão a seu favor – recorrer de multas emitidas pela polícia por estacionamento ilegal, por exemplo, ou encerrar assinaturas irritantes sem comissões – decidiu ir mais longe e ofereceu US$ 1 milhão .USA para quem ousar confiar sua defesa em tribunal a um advogado de IA criado pela mesma empresa. Mas até agora sem sucesso: os processos judiciais americanos são difíceis de lidar com a tecnologia no tribunal (porque, por exemplo, os repórteres não podem usar câmaras fotográficas ou de vídeo), por isso a tarefa era puramente tecnicamente difícil – para não mencionar as preocupações sobre a qualidade da tecnologia. será um advogado-bot operando com base no GPT-3 e com quem registrará reclamações se ainda perder o caso no tribunal.

Sibila Benevolente. Pesquisadores do Instituto de Tecnologia de Massachusetts, em colaboração com o MIT General Hospital, desenvolveram um modelo de aprendizagem profunda chamado Sybil para prever o risco de um paciente desenvolver câncer de pulmão em estágio inicial, o mais mortal de todos os tipos deste tipo de doença extremamente desagradável. Uma vantagem importante deste desenvolvimento é a capacidade de determinar com precisão um risco significativo de desenvolver câncer durante um período de até 6 anos com base em um único procedimento de TC com baixa dose de contraste (Low Dose Contrast CT, LDCT).

⇡#Fevereiro

Acelerado um milhão de vezes. Falando aos acionistas com seu último relatório trimestral, o CEO da NVIDIA, Jensen Huang, disse com otimismo que o recente impulso no desenvolvimento de IA tem boas chances de continuar por pelo menos uma década, dado o impulso já ganho: a “Lei de Moore” em sua melhor forma, forneceu um aumento de cem vezes no [desempenho da computação] em 10 anos. Ao oferecer novos processadores, novos sistemas, novas interconexões, novas estruturas e algoritmos, e ao colaborar com cientistas de dados, pesquisadores de IA trabalhando em novos modelos – em suma, movendo-se em todas as direções ao mesmo tempo – conseguimos que grandes modelos de linguagem funcionassem um milhão de vezes. mais rápido hoje do que há 10 anos.”

Exemplos de imagens geradas em um smartphone Android pelo modelo otimizado Stable Diffusion 1.5 no prompt “Super fofo guerreiro gato fofo em armadura, fotorrealista, 4K, ultra detalhado, renderização vray, motor irreal” (fonte: Qualcomm)

Gatos na palma da sua mão. Na próxima exposição MWC em Barcelona, a Qualcomm foi a primeira no mundo a demonstrar como em um telefone celular (baseado no sistema em chip Snapdragon 8 Gen 2) rodando Android, o modelo generativo Stable Diffusion 1.5 com mais de 1 bilhão de parâmetros não apenas executa, mas também lida com a criação de uma imagem baseada em um prompt de texto em menos de 20 segundos. É verdade que o modelo teve que ser um pouco reduzido, alterando a precisão dos números do FP32 original para o INT8, e também otimizado de outras maneiras. Portanto, a qualidade das imagens geradas em um smartphone é comparável às criações de versões anteriores do Dall-E, e não às imagens que os entusiastas obtêm hoje em PCs desktop usando o mesmo SD 1.5. No entanto, o problema já começou – não há dúvida de que a próxima geração de plataformas móveis será muito mais adequada para a execução local de modelos generativos do que um laptop típico dos nossos dias.

LLMs domesticados. A empresa Meta[1] apresentou em fevereiro uma série de modelos de linguagem generativa da família LLaMA – com 7, 13, 33 e 65 bilhões de parâmetros. Destinam-se principalmente a desenvolvedores entusiastas de IA que não têm acesso a um poder computacional significativo e são licenciados gratuitamente, mediante solicitação, para uso em pesquisa não comercial. Os dois modelos mais antigos foram treinados em uma matriz de 1,4 trilhão de tokens, o mais novo – 1 trilhão, e os textos nos 20 idiomas mais comuns do mundo foram analisados em tokens – principalmente aqueles que dependem da escrita de palavras em latim ou cirílico alfabeto. De acordo com os desenvolvedores, o LLaMA-13B supera o GPT-3 na maioria dos benchmarks testados, e o LLaMA-65B é comparável a plataformas comerciais como DeepMind Chinchilla-70B e Google PaLM-540B.

Sem violão, mas com busca. No início de fevereiro, o Google anunciou o Bard AI, um serviço experimental para comunicação com usuários em linguagem natural, baseado no grande modelo de linguagem da própria empresa, LaMDA (Language Model for Dialogue Applications). Inicialmente disponibilizado para um seleto círculo de testadores, este serviço inicialmente produziu resultados bastante ambíguos – até a geração vigorosa de absurdos absolutos (aos olhos humanos) em 8 dos 10 tópicos propostos. Mas Moscou não foi construída imediatamente: ao longo do ano, o Google continuou a melhorar persistentemente sua resposta ChatGPT e, depois de se basear no modelo de linguagem Gemini (ver seção “Dezembro”), a parcela de “alucinações” nos resultados do Bard AI é diminuição perceptível.

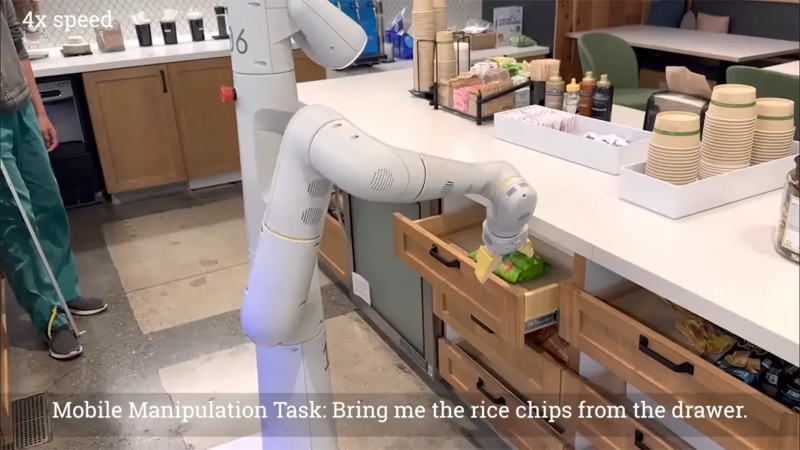

Imagem de um vídeo demonstrando um robô controlado por IA generativa multimodal (fonte: Universidade Técnica de Berlim)

⇡#Marchar

Batatas fritas de arroz e multimodalidade. Depois de brincar por alguns meses com o ChatGPT, os pesquisadores de IA ficaram mais firmemente convencidos de que modelos “estreitos” para resolver problemas limitados – mesmo os complexos como o GPT-3 com seus 175 bilhões de parâmetros – embora façam um bom trabalho de simulação inteligente comportamento, mas não podem ser chamados de totalmente “intelectuais”. O futuro, claro, pertence à IA “forte” (inteligência artificial geral, AGI) – aquela que pode resolver problemas que não encontrou antes (seja na forma de algoritmos ou em um conjunto de dados de treinamento), encontrando maneiras de fazer isso que antes eram desconhecidos para ele. Um passo lógico para a criação da AGI parece ser a combinação de modelos multimodais (combinando circuitos visuais e linguísticos) com sistemas robóticos que possam eles próprios estudar o mundo real, e não apenas receber informações sobre ele na forma de conjuntos de dados. Foi precisamente esta plataforma composta denominada PaLM-E que foi proposta por uma equipa de programadores da Google e da Universidade Técnica de Berlim, cruzando um modelo multimodal de IA com 562 mil milhões de parâmetros com um braço robótico móvel – e obtendo um dispositivo capaz de adequadamente responder a comandos em linguagem natural como “Traga-me um saco de biscoitos de arroz daquela gaveta”, ligando assim palavras, imagens e ações. No seu relatório, os investigadores argumentam que a plataforma já está a demonstrar uma “transferência positiva”, utilizando o conhecimento e as competências adquiridas na resolução de problemas anteriores para lidar com mais confiança com os problemas subsequentes.

Médico com 85,4%. Desenvolvido pelo Google em abril de 2022, o modelo proprietário de grande linguagem PaLM (Pathways Language Model) quase um ano após o lançamento de sua primeira versão foi usado para criar o Med-PaLM 2, um bot consultor especializado em questões de medicina e, de forma mais ampla, , assistência médica. Se sistemas semelhantes anteriores (GPT-Neo, Galactica, PubMed GPT, etc.) responderam com sucesso 30-50% das perguntas feitas a eles em linguagem natural da lista padrão usada para examinar médicos biológicos, então o primeiro Med-PaLM mostrou isso o o resultado do teste foi de 67,2%, e o Med-PaLM 2, anunciado em março, chegou a 85,4%. Embora os desenvolvedores tenham relatado com orgulho essa conquista, ainda não se fala em fornecer acesso aberto ao bot consultor médico – as consequências legais de seus possíveis erros são muito vagas.

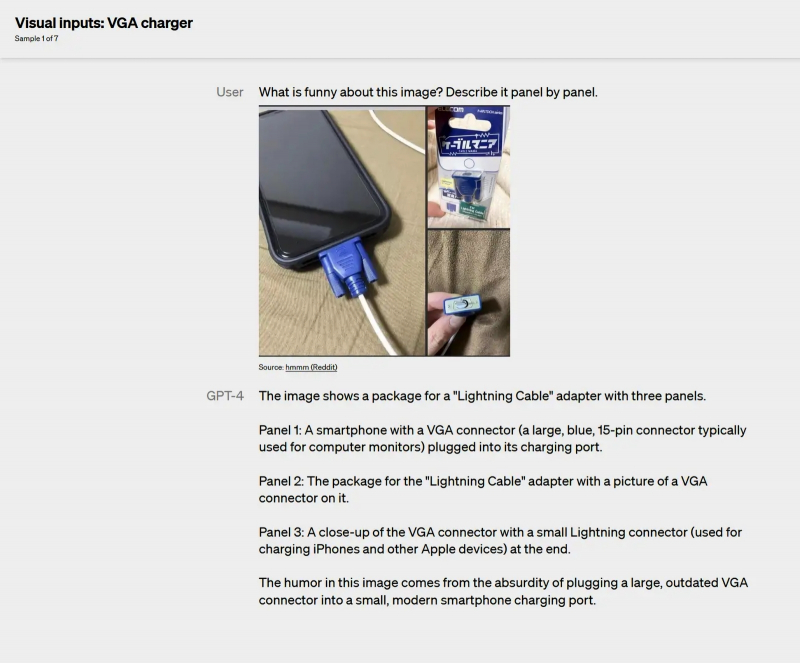

Um exemplo de como o GPT-4 lida com uma tarefa não trivial para IA “estreita” é explicar por que o modelo proposto para estudar uma imagem é engraçado (fonte: OpenAI)

Quatro! Se novembro de 2022 foi um marco importante na história do desenvolvimento de IA graças ao lançamento pela OpenAI do bot ChatGPT baseado no grande modelo de linguagem GPT-3.5, então março de 2023 foi marcado pela abertura do acesso ao Generative Pré-treinado Transformer 4 (GPT-4) – que já é capaz, por exemplo, de passar no exame da ordem da faculdade de direito, não apenas obtendo nota de aprovação, mas ficando entre os 10% melhores participantes biológicos da prova. Para efeito de comparação, o GPT-3 obteve pontuação entre os 10% inferiores dos examinados com suas respostas. O multimodal “Quatro” opera com textos de até 25 mil palavras (GPT-3,5 – máximo 3 mil, GPT-3 – 1,5 mil), gera e analisa código de programa nas linguagens mais populares, é capaz de descrever claramente o porquê deste ou de outro picture pode parecer engraçada, cria sites (com HTML e JavaScript) com base em um esboço manuscrito da funcionalidade pretendida e, em geral, mostra-se mais do que digno – embora ainda não se aplique à IA. Os desenvolvedores também garantiram que o modelo era, em sua opinião, mais seguro: era “82% menos propenso a atender solicitações de conteúdo proibido e 40% mais factual em suas respostas do que o GPT-3.5”, disse a OpenAI, com base em resultados de testes internos. .

188 GB são suficientes para você? Desde maio de 2020, o hardware mais popular para desenvolvedores sérios de IA tem sido a placa de vídeo de servidor NVIDIA A100 com Tensor Cores especialmente otimizada para operações de multiplicação de matrizes, que são essenciais para tarefas profundas de aprendizado de máquina. Em março de 2022, apareceu outro acelerador de IA de servidor do mesmo fornecedor, o H100 – com uma GPU fabricada de acordo com o padrão tecnológico “4 nm” para 80 bilhões de transistores (são 54,2 bilhões no A100) e até 80 GB de RAM de vídeo no mapa. Agora, em março de 2023, a NVIDIA anunciou uma versão modificada – o H100 NVL (essencialmente um par de H100s conectados por pontes NVLink, mas com uma série de modificações) com 94 GB de memória, que além disso permite operação dupla – com um total quantidade de RAM de 188 GB e com taxa de transferência máxima de 7,8 TB/s contra 3,35 TB/s do primeiro H100. Um servidor equipado com oito NVLs H100 é em média doze vezes mais rápido que um sistema semelhante com o mesmo número de A100s em velocidade de execução GPT-3.

Não dá para negar a auto-ironia da atual Microsoft: em 2022, sua coleção oficial de “suéteres feios do Windows” (Windows Ugly Sweater) foi reabastecida com uma cópia com o bom e velho Paperclip (fonte: Xbox Gear Shop)

«Clipe de papel” com esteróides. Desta vez, a empresa que criou o sistema operacional mais usado do mundo aparentemente decidiu não repetir erros anteriores, como subestimar mecanismos de pesquisa ou smartphones – e abordar o tema quente da inteligência artificial o mais firmemente possível, integrando o assistente inteligente Microsoft 365 Copilot ( aliás, baseado em GPT-4) direto nos aplicativos e serviços da plataforma Microsoft 365. Os Oldfags inevitavelmente começarão a comparar “Copilot” com “Paperclip”, que aterrorizou os usuários do MS Office 97 e 2003, porém, em seu Encarnação da IA, este assistente como um todo acaba sendo bastante útil: de acordo com uma pesquisa realizada no GitHub, 88% de seus usuários notaram um aumento em sua própria produtividade depois que começaram a interagir regularmente com o Copilot, e 77% graças a ele gaste significativamente menos tempo procurando as informações necessárias.

Não precisa correr! Mais de 1.200 cientistas e empresários proeminentes da indústria de TI assinaram uma carta aberta sensacional em março no site do Future of Life Institute, pedindo uma suspensão imediata do trabalho sobre o desenvolvimento de modelos generativos de IA, a fim de avaliar de forma sensata e sem pressa o riscos potenciais para a humanidade da sua parte. Em 2017, na conferência Beneficial AI, o chamado Princípios Asilomar, apoiados por Stephen Hawking, Elon Musk e Sam Altman, entre outros, que argumentam que “a IA avançada poderia mudar fundamentalmente toda a história da vida na Terra e, portanto, precisa de desenvolvimentos cuidadosamente planejados nesta área, alocando esforços proporcionais e recursos para esse fim.” No entanto, na corrida pela IA generativa que se desenrolou imediatamente após o sucesso retumbante do ChatGPT no final de 2022, avaliar as consequências e elaborar mecanismos de segurança é talvez a última coisa que passa pela mente dos desenvolvedores. Os signatários da carta aberta estão confiantes de que os poderosos sistemas modernos de IA, para não mencionar a promissora IA, só deverão ser levados à fase de implementação após uma verificação escrupulosa de que os efeitos da sua implementação serão inteiramente positivos para a humanidade e que os possíveis riscos serão mitigado com confiança e rapidez. Segundo vários especialistas, expressos em março, se não fizermos uma pausa de pelo menos 6 meses, até ao final de 2023, o modelo GPT-5 poderia ter surgido, condicionalmente, com todos os sinais de AGI, mas com interação direta com inteligência artificial completa Nem a indústria de TI, nem os advogados, nem os políticos, nem a sociedade como um todo estão claramente preparados.

Captura de tela de uma sessão de teste com ChatGPT, que através do plugin teve a oportunidade de pesquisar na Internet para obter dados atuais (fonte: OpenAI)

O selo de restrições foi levantado. OpenAI adicionou suporte para plugins à interface ChatGPT – e ao mesmo tempo, em modo de teste, abriu acesso à Internet para seu icônico chatbot, enquanto o banco de dados anteriormente acessível, embora bastante extenso, não continha referências a eventos ocorridos após 2021. A combinação desses recursos permite que você use o ChatGPT, por exemplo, para compilar regularmente resumos de atualizações de um site que o usuário não tem tempo de monitorar pessoalmente, ou para criar um roteiro de viagem complexo com seleção de hotéis e reserva de passagens. As etapas finais de confirmação de identidade e pagamento terão que ser feitas pela própria pessoa, é claro, mas um chatbot inteligente, graças à integração com as APIs web relevantes, já fará todo o trabalho preliminar de rotina para ela, incluindo o preenchimento correto os campos obrigatórios.

⇡#Abril

Casa A. I. Quem diagnosticará com mais precisão e será mais solidário com as preocupações e medos do paciente – um humano ou um bot? Um artigo no The Journal of the American Medical Association dá uma resposta completamente clara: ChatGPT. Pesquisadores da Universidade da Califórnia em San Diego (UCSD) selecionaram cerca de duzentas perguntas sobre temas médicos na Internet e compararam como um chatbot e um médico ao vivo as responderam. Não só foi avaliada a real correção das respostas, mas também o seu colorido emocional numa escala de “indiferente” a “com grande simpatia”. A conclusão do artigo é formulada de uma forma extremamente pouco lisonjeira para os cientistas biológicos: “Os cuidados melhorados pela IA [para o paciente] são o futuro da medicina”. As consultas do ChatGPT revelaram-se mais precisas, detalhadas, personalizadas e, além disso, também foram formuladas, em média, com uma demonstração de empatia pelo paciente muito mais perceptível do que as humanas.

Os gráficos de um estudo realizado por um grupo de cientistas da UCSD demonstram claramente a superioridade da IA sobre um terapeuta comum: à esquerda – em termos da qualidade dos dados sobre as respostas às queixas dos pacientes, à direita – em termos de empatia demonstrada durante o conversa (fonte: JAMA)

Como uma rocha. O novo serviço Amazon Bedrock está disponível para usuários da AWS, para começar em modo de teste; seu lançamento totalmente funcional ocorreu apenas em setembro. Este não é um modelo generativo em si, mas convenientemente integrado à infraestrutura em nuvem, a capacidade de experimentar vários modelos – desenvolvidos por parceiros da AWS como AI21 Labs, Anthropic, Cohere, Stability AI e, claro, a divisão AI da própria Amazon – e treiná-los ainda mais no uso de seus próprios dados e na criação de agentes de software para executar várias tarefas restritas.

Um robô não é um brinquedo para crianças, mas sim um professor. Bill Gates, falando na cimeira em San Diego, elogiou muito o potencial de ensino da IA, dizendo que os chatbots inteligentes estão prontos para ensinar as crianças a ler e escrever e que nos próximos 18 meses as capacidades da inteligência artificial nesta área serão iguais às realizações de qualquer professor de biologia.

E dentro ela tem NeONKA. Sber apresentou ao público o modelo de rede neural multimodal GigaChat – que, assim como seus congêneres estrangeiros, é capaz de manter um diálogo em linguagem natural, escreve código de programa e também cria textos e imagens de acordo com instruções fornecidas no contexto geral (narrativas ilustradas ). O núcleo do GigaChat é o conjunto de redes neurais NeONKA – Neural Omnimodal Network with Knowledge-Awareness, e a criação de imagens é gerenciada pelo modelo Kandinsky 2.1.

Um fotógrafo e sua obra-prima (fonte: plano de fundo – geração de IA baseada no modelo SDXL 1.0; foto em si – Sony World Photography Awards)

Dê-me meu prêmio aqui, bolsas de couro! O fotógrafo alemão Boris Eldagsen recusou-se a aceitar o prémio na categoria “aberto criativo” que lhe foi atribuído no concurso Sony World Photography Awards, porque o retrato apresentado pelo júri, que recebeu o reconhecimento de mentes biológicas, acabou por ser gerado por um modelo de IA. O que mais uma vez mostrou que nível de perfeição a IA generativa alcançou na simulação de imagens artísticas e ao mesmo tempo fotograficamente precisas de pessoas.

Será mais interessante jogar. Como serão os jogos de um futuro não muito distante pode ser imaginado com base nos resultados de um experimento conduzido por pesquisadores de Stanford. Eles basicamente treinaram o ChatGPT para jogar The Sims, criando uma caixa de areia interativa preenchida por vinte e cinco avatares controlados por IA, cada um simulando um comportamento altamente personalizado. Como nota o relatório, “acordaram, tomaram o pequeno-almoço, foram trabalhar; artistas pintaram quadros, escritores produziram textos; formaram suas próprias opiniões sobre o que acontecia ao seu redor, iniciaram conversas, discutiram os acontecimentos vividos; eles se lembraram do que aconteceu ontem e alguns dias atrás e planejaram suas ações para amanhã.”

⇡#Talvez

Vamos! Na Escócia, o primeiro serviço regular de autocarros autónomos do mundo começou a operar numa rota de 23 km entre Fife e Edimburgo, transportando até 10.000 passageiros por semana a velocidades de até 80 km/h. A rigor, os cinco autocarros do percurso correspondem apenas ao quarto nível de autonomia, ou seja, há sempre um motorista na cabina, pronto para assumir o controlo em caso de emergência. Esta é a primeira implementação prática do programa britânico CAVForth de longo prazo (CAV – de “veículos autônomos conectados”), que começou em 2019. Embora os autocarros autónomos estejam a funcionar em modo de teste e/ou por um tempo limitado (na Vila Olímpica de Tóquio em 2021, por exemplo) há vários anos, rotas regulares deste tipo nunca foram vistas antes.

Os pesquisadores não confiaram no manipulador robótico controlado por IA com uma faca – ao cortar ingredientes, o sistema se contentou com um dispositivo obviamente seguro para transformar batatas em cubos (fonte: Universidade de Cambridge)

Tutoriais em vídeo para robochef. Uma equipe da Universidade de Cambridge criou uma IA de autoaprendizagem – mais precisamente, uma IA de aprendizagem adicional que dominou a técnica de aprendizagem incremental – IA, capaz de preparar pratos até então desconhecidos usando vídeos criados por pessoas para pessoas e, em seguida, usando um robô robótico. manipulador para dar vida às habilidades adquiridas. Os pesquisadores pegaram um modelo bastante simples treinado para reconhecer várias frutas e vegetais, gravaram diversas instruções em vídeo sobre como uma pessoa poderia preparar saladas simples com eles, passaram-nos por uma rede neural – e o sistema aprendeu a sequência de ações necessárias em cada caso. Em seguida, foi mostrado à IA um vídeo do preparo de uma salada que era nova para ela – e o chef robô, usando um manipulador, recriou-a com sucesso a partir dos ingredientes propostos.

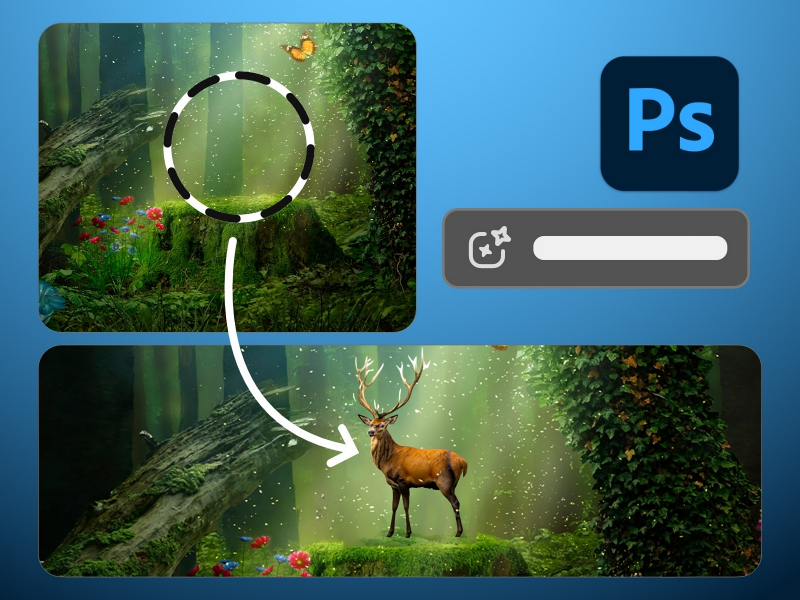

Prevenir liderando. Nos primeiros meses de agitação tempestuosa em torno de modelos generativos que criam imagens com base em instruções de texto, os artistas biológicos falaram especialmente alto – não todos em sequência, é claro – que ficaram indignados com o próprio fato de ensinar uma máquina a partir do conjunto de pinturas, ilustrações, fotografias e outras imagens acumuladas pela humanidade naquela época. No entanto, a partir de março, a intensidade desta indignação diminuiu – em grande parte porque a empresa sem dúvida cult no meio artístico, a Adobe, integrou a ferramenta generativa de IA Firefly em toda a sua família de ferramentas de software para processamento digital e criação de imagens – naquela época em beta ; o lançamento comercial ocorreu apenas em setembro. Treinado com base numa enorme variedade de dados (incluindo o extenso arquivo digital da empresa), o Adobe Firefly permite ao criador formular os seus desejos em linguagem natural – e de acordo com eles, alterar ou complementar a sua criação artística (não apenas uma imagem estática!), e sem a necessidade de mexer manualmente na instalação e ajuste do próprio modelo, como precisam fazer os usuários de instalações locais de Difusão Estável.

A ferramenta Preenchimento generativo no Photoshop atualizado permite introduzir organicamente elementos em uma imagem que não estavam lá originalmente (fonte: Adobe)

⇡#Junho

Substâncias químicas – candidatas a medicamentos com propriedades pré-determinadas.

É um caso de trilhão. Mais precisamente, um estudo da McKinsey de Junho estima que o mercado global anual de IA generativa se situe entre 2,6 biliões e 4,4 biliões de dólares a médio prazo. Este valor inclui operações de usuário final (taxas de planos tarifários “avançados” para serviços como ChatGPT e Midjourney), atividade de marketing, desenvolvimento dos próprios modelos generativos e todo o ecossistema de software que os acompanha, benefícios pela automação de processos rotineiros em uma variedade de áreas – e muito mais. As avaliações dos analistas baseiam-se num conjunto de dados reais já acumulados: por exemplo, profunda personalização da interação do serviço de suporte com os utilizadores através da utilização de IA generativa (que recupera e analisa rapidamente o histórico de comunicações anteriores com um determinado assinante, resumindo para o operador) aumenta a produtividade do trabalho nesta área em quase 14%. As áreas que receberão os principais benefícios da introdução da IA num futuro próximo são o atendimento ao cliente, marketing e vendas, desenvolvimento de software e I&D, e as indústrias bancária e de alta tecnologia em geral.

Visão esquemática e características gerais do supercomputador Condor Galaxy totalmente equipado (fonte: Cerebras Systems)

⇡#Julho

O condor saiu do ninho. A Cerebras Systems, sediada na Califórnia, em colaboração com a IA e a empresa dos Emirados Árabes Unidos focada na nuvem G42, revelou o Condor Galaxy, um cluster de nove supercomputadores com um desempenho futuro combinado de 36 AFLOPS, projetado para treinar modelos de IA. Numa fase inicial, até ao final de 2023, está prevista a entrada em funcionamento apenas do primeiro dos supercomputadores anunciados, o CG-1 com 4 Aflops (FP16), que possui 54 milhões de núcleos computacionais, 82 TB de RAM e um interno barramento de transferência de dados de 388 Tbit/s. Isto permitirá que grandes modelos de linguagem com até 600 bilhões de parâmetros sejam treinados de forma eficaz, enquanto, uma vez implantado, o Condor Galaxy será capaz de lidar com modelos de treinamento com até 100 trilhões de parâmetros.

Ponto de saturação. Foi em julho de 2023 que se tornou óbvio que o período de rápido aumento inicial do interesse no ChatGPT foi substituído por uma fase de interação mais calma e ponderada tanto com ele como com outros chatbots inteligentes. De acordo com dados do portal estatístico SimilarWeb publicados este mês, o número de acessos ao chat.openai.com pela primeira vez desde novembro de 2022 diminuiu em junho em relação ao pico de maio de aproximadamente 1,8 bilhão. No entanto, o número de visitas a outros os chatbots populares em junho também diminuíram em relação ao nível de maio – isso indica um enfraquecimento geral do entusiasmo em torno da IA generativa, em vez de um esfriamento dos usuários em relação ao ChatGPT especificamente.

O interesse do público em geral no ChatGPT atingiu o pico em maio (fonte: SimilarWeb)

Nunca há muitos bots. A startup Anthropic, cujos fundadores incluem ex-funcionários de alto escalão da OpenAI, apresentou uma nova versão de seu bot de IA para geração de textos (tanto em linguagens naturais quanto em linguagens de programação), Claude 2. Com base nos resultados de diversos testes , incluindo questões do exame americano para o direito de exercer a medicina e tarefas para escrever código em Python, o novo bot superou seu antecessor direto. É verdade que Claude 2 não é capaz de buscar informações diretamente na Internet, mas possui a maior janela de contexto de 100 mil tokens entre todos os chatbots disponíveis comercialmente atualmente, o que lhe permite analisar textos de aproximadamente 75 mil palavras (um volume bastante robusto ) e gerar respostas coerentes de mais de 3 mil palavras.

Agosto

Olhe para entender. Pesquisadores do Laboratório Nacional de Oak Ridge criaram o sistema de aprendizagem profunda AtomAI para analisar imagens obtidas por sondas de varredura e microscópios eletrônicos, a fim de identificar com precisão objetos no micro e nanomundo que se enquadram no campo de visão desses dispositivos. A ênfase principal estava na rápida detecção de anomalias na estrutura atômica ou molecular das amostras, o que costuma ser de suma importância durante a pesquisa aplicada. Munida do AtomAI, a microscopia aplicada torna-se, segundo os desenvolvedores do sistema, uma ciência exata, pois automatiza com alto grau de confiabilidade o trabalho extremamente trabalhoso e altamente qualificado dos pesquisadores biológicos.

«Por que não sou um criador se eles estão dispostos a pagar pelas minhas obras?” Enquanto a IA não fizer tais perguntas, a humanidade poderá desfrutar dos frutos do seu trabalho sem restrições (fonte: geração de IA baseada no modelo SDXL 1.0)

Quem é o criador, o criador da IA?! Um tribunal de Nova Iorque decidiu que nenhum trabalho criado por inteligência artificial sem intervenção humana direta pode ser protegido por direitos de autor ao abrigo da lei dos EUA. É interessante que neste caso não se tratava de texto ou imagem, mas de algumas invenções técnicas criadas pelo sistema generativo DABUS (Dispositivo para Inicialização Autônoma da Senciência Unificada), para as quais o criador deste sistema desejava obter patentes. O demandante, é claro, interpôs recurso, mas pelo menos na área do direito britânico, a IA terá que lutar por muito tempo para reconhecer suas criações como dignas de direitos autorais.

⇡#Setembro

Aumente o volume! Stability AI, desenvolvedora de uma das ferramentas mais famosas para conversão de texto em imagens estáticas – Stable Diffusion, adicionou um novo produto à sua linha de produtos de IA: Stable Audio. Como o nome sugere, esta é uma ferramenta para gerar faixas de áudio com base em instruções de texto. O modelo Stable Audio contém cerca de 1,2 bilhão de parâmetros, e instruções detalhadas sobre como compor prompts corretamente foram desenvolvidas especificamente para ele.

⇡#Outubro

O cérebro como fonte de inspiração para fabricantes de chips. A divisão de pesquisa da IBM Research apresentou em outubro o chip neuromórfico NorthPole, que, segundo seus criadores, é 22 vezes mais rápido do que os processadores atualmente disponíveis em velocidade de processamento para uma série de tarefas de IA e também é muito mais eficiente em termos de energia. Sua arquitetura é supostamente uma “arquitetura de chip inspirada no cérebro” – no sentido de que os dados aqui não são separados dos cálculos e, portanto, não há necessidade de troca contínua de informações entre os núcleos do processador e a RAM – na qual, de fato, o leão parcela é gasta. parcela de tempo e energia em arquiteturas de computadores clássicas. Este chip de silício de 800 metros quadrados. mm é feito de acordo com o padrão tecnológico de 12 nm e contém 22 bilhões de transistores, agrupados em 256 núcleos de computação, cada um dos quais com uma área especial de 192 MB de memória interna alocada. No benchmark ResNet50 (demonstra desempenho durante a classificação de imagens de redes neurais), NorthPole, competindo com um chip sem nome de arquitetura clássica e padrões de fabricação comparáveis, mostrou eficiência de computação 25 vezes maior (FPS por W), FPS por transistor cinco vezes melhor, 22 vezes melhor menor latência – e ainda superou o NVIDIA H100 com seus 80 bilhões de transistores na pontuação final de “4nm”. Há apenas uma ressalva: o NorthPole é bom para resolver uma gama bastante específica de problemas, principalmente em sistemas de visão computacional, e não é adequado para lançar, muito menos treinar, grandes modelos de linguagem.

Componentes aceleradores para resolver problemas de visão computacional baseados no chip NorthPole (fonte: IBM)

⇡#Novembro

O bot não é uma ameaça para os árbitros. DoNotPay, que classifica seu serviço gerador de aconselhamento jurídico on-line baseado em IA como “o primeiro robo-advogado do mundo”, foi processado pelo escritório de advocacia MillerKing de Illinois – e apenas em novembro pela juíza distrital sênior Nancy Rosenstengel (Nancy Rosenstengel de East St. Louis demitiu a reclamação do reclamante. “Este caso coloca advogados vivos contra um advogado robô”, afirmou o juiz e decidiu que o demandante não conseguiu demonstrar de forma convincente que os interesses dos advogados biológicos foram de alguma forma prejudicados devido à atividade do software.

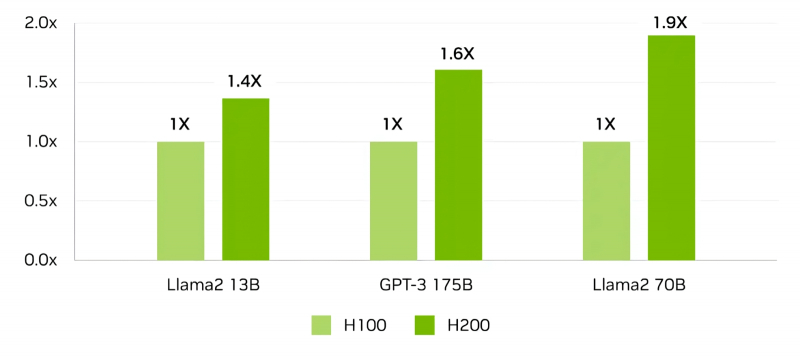

Duas vezes melhor que o H100 (bem, quase). O anúncio oficial do NVIDIA H200, o sucessor direto do principal “burro de carga” de quase toda a indústria moderna de IA, o H100, ocorreu em meados de novembro, mas os primeiros lotes deste acelerador serão enviados aos clientes (incluindo Amazon Web Services , Google Cloud, Microsoft Azure, Oracle Cloud Infrastructure) apenas no segundo trimestre. 2024 “Dvuhsotka” combina a comprovada arquitetura Hopper com a mais recente RAM HBM3e de alta velocidade com capacidade de 141 GB e largura de banda de 4,8 TB/s (o H100 tem 80 GB e 3,35 TB/s, respectivamente). O aumento de desempenho em relação ao nível H100 declarado pelo fornecedor depende do modelo que está sendo processado: para LLaMA 2 com 13 bilhões de parâmetros – 1,4 vezes, enquanto para LLaMA 2 com 70 bilhões de parâmetros – 1,9 vezes (os indicadores de desempenho de um pré-treinado modelo é fornecido, e não o treinamento em si); e isso com metade do consumo de energia. Como parte de uma configuração de 8 adaptadores, o H200 deve fornecer desempenho de 32 Pflops ao calcular com precisão FP8 em tarefas de aprendizagem profunda.

Comparação do desempenho do H100 e do H200 ao executar (sem treinar!) os modelos de IA generativa mais comuns (fonte: NVIDIA)

Uma briga, uma tentativa de golpe ou um mal-entendido? O CEO da OpenAI, Sam Altman, foi destituído do cargo em 17 de novembro e assumiu as rédeas novamente em 22 de novembro. A sutileza é que, de acordo com a estrutura organizacional, a divisão comercial da OpenAI Global LLC com lucratividade limitada (unidade de lucro limitado) é uma “filha” da estrutura sem fins lucrativos OpenAI Inc., registrada como uma organização de pesquisa sem fins lucrativos , e conta com a confiança do seu conselho de administração – cuja função é dissuadir os comerciantes ávidos por lucros, lembrando-lhes dos perigos potenciais da IA, em plena conformidade com os princípios Asilomar mencionados na secção de Março. Foi este conselho que decidiu que Sam Altman “carece de franqueza” nas comunicações e, ao mesmo tempo, de “compromisso com a missão da OpenAI de desenvolver inteligência artificial para o benefício da humanidade”. Talvez a demissão tivesse ocorrido – se não fosse o terrível barulho que surgiu na Internet, acompanhado de ameaças da grande maioria dos funcionários da OpenAI de deixarem a organização seguindo seu líder; e a própria Microsoft, maior investidora em OpenAI, já estava pronta para levar Altman para sua própria equipe. Com isso, no dia 22 de novembro, Sam Altman voltou ao cargo de chefe da OpenAI Inc., o que tranquilizou e inspirou os investidores: após a notícia disso, as ações da Microsoft dispararam na bolsa de valores a níveis sem precedentes. “E os princípios Asilomar?” – perguntará o leitor atento, mas não encontrará a resposta a esta pergunta nos comentários dos participantes do incidente.

⇡#Dezembro

Robôs de Salem. Agility Robotics, empresa que criou o robô bípede, manipulador duplo e geralmente humanóide Digit, com 175 cm de altura e 63,5 kg, testado e reconhecido como uma ferramenta bastante eficaz para trabalho de armazém na Amazon, está concluindo a construção do RoboFab em Salem, Oregon, fábrica para produção dessas máquinas com produtividade de até 10 mil robôs industriais autopropelidos por ano. Até agora, desde a sua fundação em 2016, a empresa fabricou apenas cerca de uma centena dessas unidades. A RoboFab está programada para ser inaugurada no início de 2024 e já foi anunciada pela Agility Robotics como “a primeira instalação dedicada de fabricação de robôs humanóides do planeta”. No mesmo ano, está previsto iniciar as entregas do novo Digit para participantes selecionados do programa de afiliados da empresa e, a partir de 2025, começar a aceitar pedidos amplamente de todos. Nessa altura, no entanto, os produtos da Agility Robotics já podem ter muitos concorrentes produzidos comercialmente – incluindo os robôs Optimus da Tesla, que estão actualmente a ser desenvolvidos activamente, o Atlas da Boston Dynamics, o Phoenix da Sanctuary AI, o Figure do programador com o mesmo nome e o Apptronik da Apollo. .

Humanoid Digit explora os próximos trabalhos no local de testes da Amazon (fonte: Agility Robotics)

A tão esperada resposta. As divisões de IA do Google DeepMind e Google Brain, que se fundiram em êxtase criativo, finalmente trouxeram para a fase de lançamento oficial toda uma família de modelos multimodais que operam simultaneamente com texto, imagens estáticas, vídeo e código de programa – Gemini Ultra (o mais complexo e capaz), Pro (uma boa opção intermediária) e Nano (otimizado para execução local em hardware não muito poderoso – até mesmo em dispositivos móveis). Em vários benchmarks especializados, o Gemini Ultra está à frente do GPT-4 e, no caso do benchmark multiparâmetro MMLU (Massive Multitask Language Understanding), o resultado mostrado pelo Google (90%) pela primeira vez na história superou aquele alcançado por humanos (89,8%; limite GPT-4 aqui – 86,4%). É interessante, aliás, que no benchmark MATH (todos os tipos de problemas matemáticos, da aritmética à álgebra e estereometria), o Gemini Ultra, tendo também ultrapassado o GPT-4, ainda apresentou um resultado deprimentemente baixo: 53,2% para o primeiro , 52,9% para o segundo. Mas no teste HellaSwag (raciocínio de bom senso sobre temas cotidianos), o modelo do Google, ao contrário, ficou atrás do desenvolvimento do OpenAI – 87,8% contra 95,3%. Gemini Pro e Nano estão atualmente disponíveis através do chatbot da Bard na nuvem e em uma variedade de dispositivos, enquanto a versão Ultra deverá alimentar a plataforma de bot multimodal de IA ‘Bard Advanced’ no início de 2024.

No final de 2023, começaram a aparecer indicações sobre a razão exacta pela qual o salto de Novembro envolvendo Sam Altman ocorreu na OpenAI – e qual poderá ser (se estas indicações estiverem correctas) o caminho principal do desenvolvimento da IA em 2024. Estamos falando do misterioso projeto Q*, ou Q-Star, que estaria sendo desenvolvido nas entranhas da empresa sob a liderança direta do demitido, e depois sob pressão do público e da equipe do diretor comercial contratado – e que pressupõe a entrada em funcionamento muito em breve desse mesmo SII (AGI), cujo aparecimento temem os signatários da carta aberta de Março. No entanto, deveríamos ter medo dele? “Para mim”, disse o próprio Altman, “AGI é o equivalente à pessoa média que você pode contratar como funcionário”.

Será que a hipotética AGI realmente adquirirá imediatamente, como temem os alarmistas, as habilidades de algum gênio sombrio e imediatamente desejará escravizar, se não exterminar, a humanidade – ou será que, com todas as suas habilidades pendentes (em comparação com os sistemas generativos atualmente em operação), acabará não ser mais inteligente, mais prudente e mais capaz do que o Homo sapiens comum? Afinal, lembremos que é precisamente na média efetiva do material informativo acumulado pelas pessoas que se baseia o poder inegável dos sistemas de IA – e essa média irá, pelo contrário, suavizar todos os tipos de extremos, desde o amor excessivo pela humanidade ao ódio desenfreado por ele, em vez de fortalecê-los. No entanto, 2024 está chegando – o ano novo promete claramente ser interessante!

O que aconteceu depois que o ASI desenvolvido secretamente no projeto Q* fez os preparativos preliminares necessários e apertou o botão? Nós não sabemos; Não foi possível obter mais imagens do futuro após este momento (fonte: geração de IA baseada no modelo SDXL 1.0)

[1] Incluído na lista de associações públicas e organizações religiosas em relação às quais o tribunal decidiu liquidar ou proibir atividades que entraram em vigor pelos motivos previstos na Lei Federal de 25 de julho de 2002 nº 114- Lei Federal “Sobre o Combate às Atividades Extremistas”.