No evento Advance AI, a AMD revelou oficialmente o Instinct MI300X, um acelerador de computação dedicado projetado para lidar com grandes quantidades de dados para IA generativa e cargas de trabalho de computação de alto desempenho. Este é o acelerador de computação mais poderoso do arsenal da AMD.

Fonte da imagem: AMD

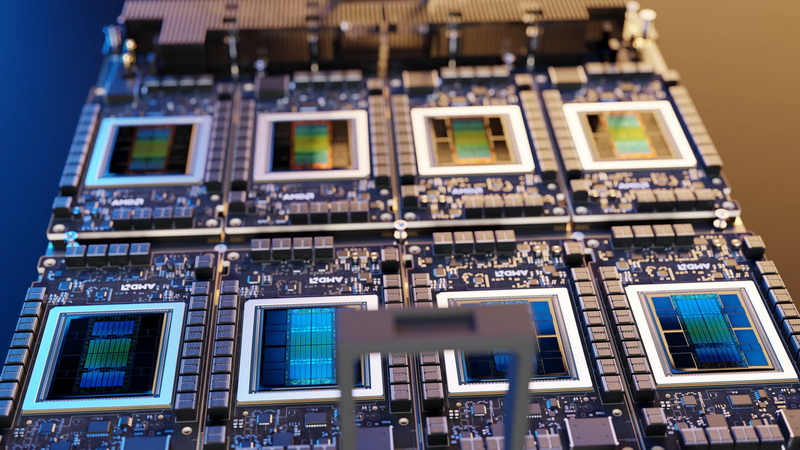

O Instinct MI300X é baseado na arquitetura CDNA 3 e em um layout de chip usando cristais feitos com tecnologia de processo de 5 e 6 nm. Embalagem 3D avançada e edição TSV são usadas para montar chips. A camada base do chip é representada por quatro cristais Die I/O com suporte para uma interface de memória HBM3 de 128 canais, 256 MB de memória Infinity Cache, suporte para 64 pistas PCIe 5.0 e 64 pistas PCIe 4.0.

No topo das matrizes de E/S estão oito matrizes XCD, cada uma contendo 38 unidades de execução na arquitetura CDNA 3, totalizando 304 unidades. O acelerador está equipado com 192 GB de memória HBM3 com largura de banda de 5,3 TB/s. Para combinar o MI300X em clusters, é fornecido suporte para o barramento Infinity Fabric de quarta geração. No total, o MI300X contém 153 bilhões de transistores.

AMD compara MI300X com aceleradores NVIDIA H100 AI. Este último possui 80 GB HBM3 com velocidade de 3,35 TB/s. A AMD afirma que o MI300X oferece paridade em tarefas de treinamento de IA, mas é 1,6 vezes superior ao concorrente em tarefas de inferência (executando sistemas de IA já treinados). Por exemplo, a AMD promete um aumento na velocidade do grande modelo de linguagem Llama 2 com 70 bilhões de parâmetros em 1,4 vezes em comparação com o H100, e no modelo Bloom com 176 bilhões de parâmetros o MI300X fornecerá um rendimento 1,6 vezes maior.

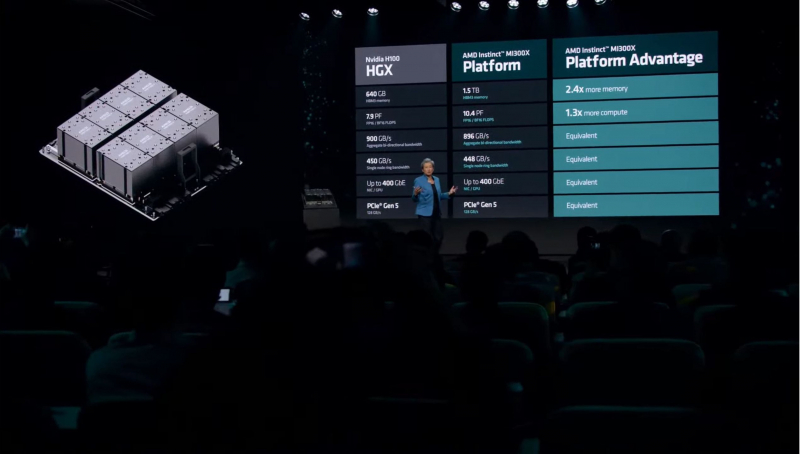

O Instinct MI300X pode ser combinado em sistemas de oito aceleradores em uma placa. Tal plataforma será capaz de competir com o sistema NVIDIA H100 HGX e, ao mesmo tempo, fornecer maior desempenho e significativamente mais memória, sendo esta última muito importante para tarefas de IA.

A AMD chama o Instinct MI300X de acelerador de computação de IA mais poderoso. A plataforma oito-MI300X da AMD oferece 10,4 Pflops de desempenho em operações FP16/BF16. Para efeito de comparação, a plataforma HGX da NVIDIA H100 oferece desempenho de 7,9 Pflops nas mesmas tarefas. E a capacidade de memória HBM3 da solução AMD é 2,4 vezes maior que a da plataforma concorrente.

A AMD também introduziu uma nova plataforma de software, ROCm 6, otimizada para funcionar com aceleradores da série Instinct MI300. Segundo a empresa, o novo software melhora em 2,6 vezes o desempenho dos aceleradores computacionais com bibliotecas especializadas de grandes modelos de linguagem, e também introduz outras otimizações que no geral dão ao MI300X um desempenho 8 vezes mais rápido em comparação aos aceleradores MI250X, trabalhando com o software ROCm 5 plataforma.

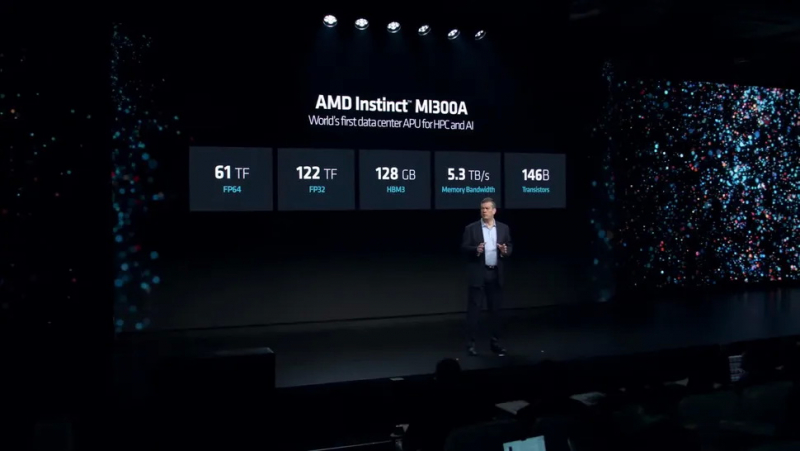

Juntamente com o Instinct MI300X, a AMD lançou os processadores híbridos MI300A especialmente desenvolvidos para data centers e computação de alto desempenho (HPC). Na verdade, este é um processador híbrido de servidor que combina uma CPU e um poderoso acelerador de computação em um substrato.

Em geral, sua estrutura é muito semelhante ao layout do MI300X, mas o MI300A usa apenas seis blocos XCD na arquitetura CDNA 3. Eles contêm 146 bilhões de transistores. Mais três chips no MI300A são representados por cristais de computação CCD, cada um contendo oito núcleos de processador Zen 4. Ou seja, há um total de 24 núcleos que operam em 48 threads. APUs MI300A especializadas receberam 128 GB de memória HBM3 integrada com largura de banda de 5,3 TB/s.

A AMD afirma desempenho de 61 teraflops em operações FP64 e 122 teraflops em operações FP32 para o Instinct MI300A. Observa-se também que o novo produto oferece o dobro do desempenho por watt de consumo de energia do que a solução concorrente NVIDIA Grace Hopper. Este último, lembramos, combina um acelerador NVIDIA e um processador central baseado em Arm.