A NVIDIA introduziu uma solução para a plataforma GB300 NVL72 que pode mitigar as flutuações de tensão causadas pela operação síncrona de milhares de aceleradores (GPUs) em sistemas de IA, reduzindo a carga de pico na rede em até 30%. Essas flutuações têm um impacto extremamente negativo na rede elétrica e em outros consumidores. A nova solução da NVIDIA também será usada em sistemas GB200 NVL72.

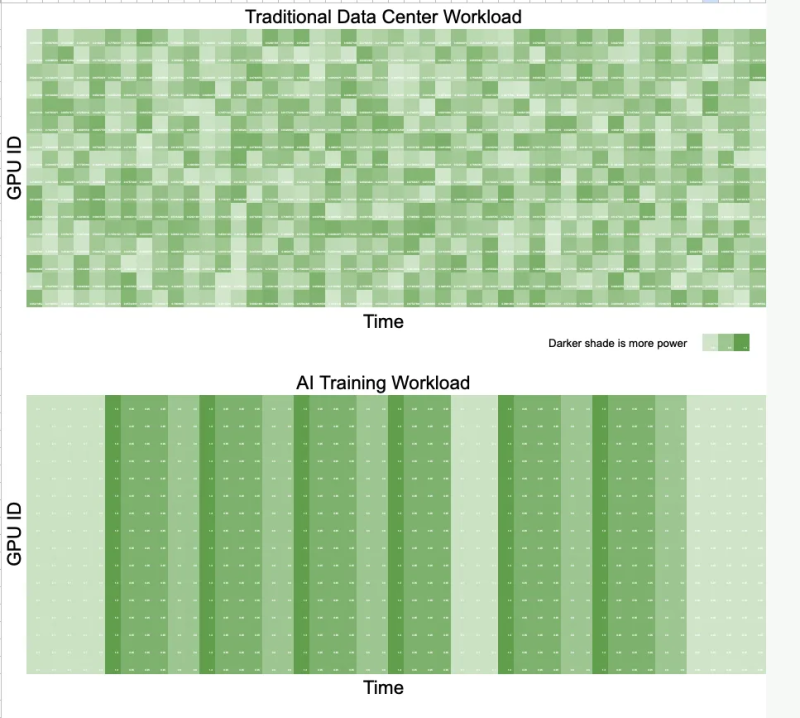

Durante o treinamento de modelos de IA, milhares de aceleradores trabalham em sincronia e realizam os mesmos cálculos em dados diferentes. Essa sincronização leva a flutuações de energia na rede — quedas de tensão ou excesso de energia durante períodos de inatividade repentinos, diferentemente das cargas de trabalho tradicionais de data center, onde os aceleradores trabalham de forma assíncrona e tarefas não correlacionadas “suavizam” a carga. A Meta✴ até precisou adicionar a opção PYTORCH_NO_POWERPLANT_BLOWUP ao PyTorch como medida temporária, o que sobrecarrega os aceleradores com trabalho sem sentido durante momentos ociosos.

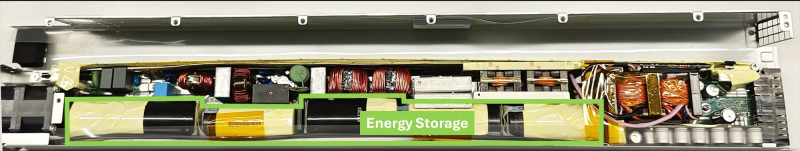

Para solucionar esse problema, a empresa equipou o NVIDIA GB300 com uma fonte de alimentação com capacitores, ou seja, dispositivos de armazenamento de energia, desenvolvidos com a ajuda da LITEON Technology, além do hardware e software necessários. Em diferentes estágios da operação do sistema, diversos mecanismos são utilizados, incluindo limitação de energia, acúmulo de energia e “queima” de energia — a função NVIDIA GPU Burn.

Fonte da imagem: NVIDIA

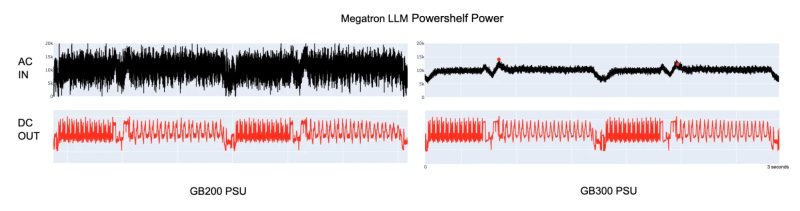

Capacitores eletrolíticos proporcionam consumo de energia uniforme diretamente no rack. Eles ocupam quase metade do volume da fonte de alimentação e fornecem 65 joules de armazenamento de energia para cada acelerador. O armazenamento (capacitor) é carregado quando o acelerador consome pouca energia e descarrega quando consome muita energia. Esse tipo de buffer ajuda a reduzir as flutuações no consumo de energia, o que foi demonstrado em testes comparativos do GB200 e do GB300 sob a mesma carga. O GB300 reduz a carga de pico na rede em 30%, enquanto fornece energia semelhante para os aceleradores.

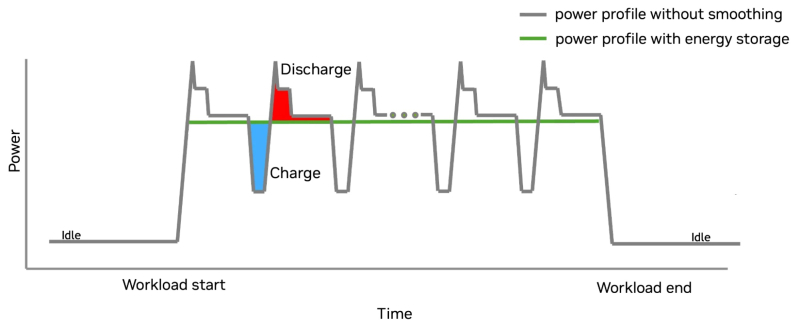

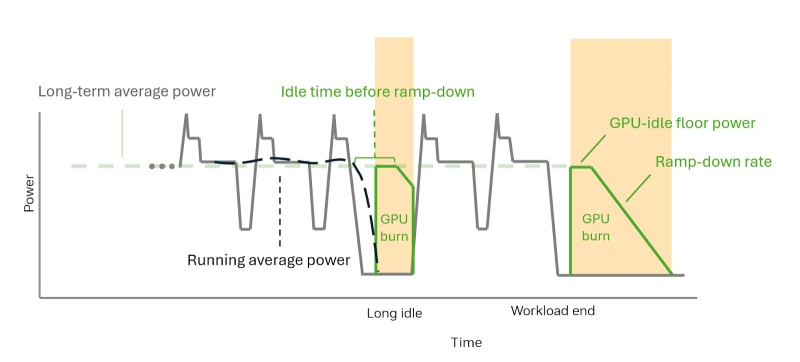

O GB300 limita os picos de energia aumentando o consumo de energia do acelerador de forma incremental. O limite de energia aumenta gradualmente, de acordo com a capacidade da rede. Quando a tarefa é concluída, o driver de software que implementa o algoritmo de suavização do consumo de energia ativa a redução de energia do hardware. O acelerador continua consumindo energia constante graças à função NVIDIA GPU Burn, aguardando a retomada da carga.

Se a carga não for retomada, o acelerador reduz gradualmente o consumo de energia. Se a carga do acelerador for retomada, o NVIDIA GPU Burn será desativado imediatamente. Após a conclusão da carga, o acelerador reduz gradualmente o consumo de energia usando o NVIDIA GPU Burn a uma taxa compatível com a capacidade da rede e, em seguida, desliga.

Esses parâmetros são controlados por configurações como consumo mínimo de energia em modo ocioso e tempo de redução gradual da carga, que podem ser configuradas usando NVIDIA SMI ou Redfish. Esse controle completo sobre o consumo de energia reduz a carga na rede elétrica e torna o agendamento de tarefas mais previsível.

Como observado pelo Futurum Group, o esquema de energia proposto pela NVIDIA significa que os data centers não precisam mais ser construídos considerando as necessidades de pico de energia. Em vez disso, eles podem ser dimensionados para mais perto do uso médio, o que significa que mais equipamentos podem ser colocados no mesmo espaço ou os custos gerais de energia podem ser reduzidos. A Siemens está propondo supercapacitores como um buffer de energia para toda a instalação, embora soluções mais compactas, do tamanho de racks, já estejam disponíveis.

Além disso, como a suavização de energia é limitada ao rack, sem reinseri-lo à rede, os operadores têm maior controle sobre o consumo de energia. Essa combinação de hardware e software permite escalabilidade e torna os data centers compatíveis com a rede, independentemente de utilizarem sistemas NVL72 GB200 ou GB300. Como observado pela ServeTheHome, o uso de módulos de armazenamento adicionais montados em rack, conforme proposto pela LITEON, também ajudará a distribuir a carga de forma mais uniforme entre grandes clusters de IA.

Santiago Grijalva, professor de engenharia elétrica e de computação no Instituto de Tecnologia da Geórgia, classificou a nova tecnologia como “um grande negócio”, dado o papel dominante da NVIDIA na área. “Mas esta solução se limita a sistemas NVIDIA de ponta”, disse ele à Utility Dive por e-mail. “Ela compete com as otimizações de hardware da Tesla e da Meta✴, oferecendo melhorias significativas, mas não revolucionárias, às técnicas de gerenciamento de energia existentes.”