Fonte: geração de IA baseada no modelo FLUX.1

⇡#AI comeu o vazio (para alegria de todos)

Na Inglaterra elisabetana, mesmo antes do início da revolução industrial (mas no seu limiar imediato), as ovelhas, como disse Thomas More com propriedade, comiam pessoas – o que significa a expulsão pelos proprietários de terras de arrendatários de terras que foram entregues a pastagens de ovelhas em para aumentar a produção de lã; um processo conhecido pelos historiadores como cercamento. Em Los Angeles, no outono de 2024, os centros de dados concebidos principalmente para resolver problemas de IA estão a ocupar o vazio dos centros de negócios que estão a perder inquilinos – novamente aquecendo a procura por imóveis comerciais, que definharam num nível alarmantemente baixo para proprietários desde a crise da Covid. Novos clientes estão ocupando antigos escritórios de forma tão ativa, convertendo espaços abertos em salas de informática e poços de elevadores redundantes com um pequeno número de funcionários em poços de dissipação de calor de torres de resfriamento, que mesmo no verão, a estação tradicional de redução da demanda por equipamentos comerciais imóveis nos centros das grandes cidades, a parcela de espaço disponível para aluguel em certos distritos comerciais da metrópole americana diminuiu para 3%, há muito sem precedentes. Os inquilinos são especialmente atraídos pela alta disponibilidade de eletricidade nos centros de negócios – este critério, em princípio, está começando a ocupar o primeiro lugar para os organizadores de novos data centers: de acordo com a Goldman Sachs, até 2030, os data centers (principalmente aqueles que executam IA tarefas) consumirá até 11% de toda a eletricidade gerada nos Estados Unidos contra os atuais aproximadamente 3%.

Fonte: geração de IA baseada no modelo FLUX.1

⇡#Um bot inteligente é amigo do programador. Ou não?

Como medir a eficácia do envolvimento da inteligência artificial na resolução de problemas de programação? A questão não é ociosa, considerando quanto custa executar e principalmente treinar modelos de IA; Conseqüentemente, os investimentos dos clientes envolvidos no desenvolvimento de software para atrair bots inteligentes (da nuvem ou locais) para ajudar os codificadores ao vivo são consideráveis. Pesquisadores da Uplevel, após realizar uma pesquisa bastante extensa, descobriram que o impacto das ferramentas de IA no trabalho dos programadores que as utilizam em seu trabalho diário é estatisticamente insignificante – se o tempo médio gasto para adicionar o próximo trecho de código ao repositório (puxar tempo de ciclo de solicitação) é considerada a métrica principal. Além disso: o uso, digamos, do assistente de programação inteligente GitHub Copilot levou a um aumento de 41% no número de bugs no código finalizado – respectivamente, embora a velocidade de geração do texto do programa realmente tenha aumentado, o tempo necessário para depuração aumentou imediatamente .

O uso de um assistente de IA também geralmente não contribuiu para reduzir a taxa de esgotamento criativo entre os desenvolvedores, portanto o argumento “os bots assumirão as tarefas rotineiras, deixando apenas o voo criativo livre para os humanos” também não se mostra muito válido. Analistas de nível superior, no entanto, não recomendam o abandono total dos assistentes inteligentes: as ferramentas de programação de IA estão sendo constantemente aprimoradas e é provável que, após as próximas atualizações, elas ainda aprendam a produzir códigos mais corretos – e mais compreensíveis pelas bolsas de couro – (desde agora , vários especialistas, os programas gerados pelo LLM às vezes são tão complexos para a percepção humana que é mais fácil reescrever manualmente um fragmento escuro em sua totalidade do que entender sua lógica interna – da máquina). Além disso, no final de outubro, soube-se que no próprio Google mais de um quarto de todo o código já é escrito por IA – e nada funciona!

É interessante a este respeito que a gestão do projeto GitHub Copilot – um assistente de IA já familiar a muitos programadores, que antes se baseava exclusivamente nos desenvolvimentos do OpenAI – anunciou no final de outubro que em breve, literalmente dentro de um Em questão de semanas, fornecer aos usuários acesso às ferramentas competitivas da família GPT: referindo-se ao Claude 3.5 Sonnet da Anthropic e ao Gemini 1.5 Pro do Google. Além disso, o arsenal de codificadores de IA prontos para uso na plataforma GitHub será complementado pelos modelos GPT de “raciocínio” o1-preview e o1-mini, especialmente treinados para resolver problemas de programação mais complexos. A capacidade de não confiar em apenas um modelo, mas de alternar conforme necessário entre aqueles que o usuário considera mais adequados no momento, tem como objetivo aumentar ainda mais a flexibilidade e a amplitude de aplicação do GitHub Copilot.

Fonte: geração de IA baseada no modelo FLUX.1

⇡#Meu avatar entrará em contato com seu avatar

Entre as tarefas que a IA, já no atual estágio de desenvolvimento, é capaz de assumir com bastante eficácia está entrevistar candidatos para os mais diversos cargos, desde funcionários de primeira linha em lojas de departamentos até programadores e até os próprios especialistas de RH (por pelo menos nível de entrada mínimo). Os avatares de RH, que Fairgo.ai oferece, entre outras coisas, para clientes empresariais, estão prontos para entrar em contato com um candidato “a qualquer hora, em qualquer lugar” online, inclusive em formato de chat de vídeo – no entanto, o vídeo gerado por IA é mostrado apenas em a fase inicial da conversação; o levantamento detalhado do solicitante é realizado exclusivamente em modo áudio, de forma a não criar carga excessiva nos servidores do prestador desse serviço. Como consolo para aqueles que não estão dispostos a confiar a decisão de seu destino a avatares sem alma, os desenvolvedores estipulam especificamente que em qualquer caso o smart bot não está autorizado a aceitar ou rejeitar a candidatura do interlocutor. A sua tarefa é compilar um registo de texto de uma conversa com um candidato com base em questões previamente formuladas pelo cliente, e encaminhá-lo ele próprio para este cliente, para que a pessoa possa então tomar uma decisão informada sem perder tempo no contacto direto com os candidatos ( (que são para vagas abertas por empregadores populares, é claro, podem ser muito mais do que os funcionários humanos do departamento de RH normalmente conseguem processar em um tempo razoável).

E quanto aos gerentes de RH – a IA moderna torna desnecessário até mesmo o usuário médio sentado em frente a um PC! De acordo com a Anthropic, a versão mais recente da IA generativa da empresa, Claude Sonnet 3.5, é essencialmente um agente de IA – uma ferramenta inteligente para automatizar a execução de tarefas padrão em um computador pessoal que antes só eram possíveis para um usuário biológico. “Treinamos Claude para reconhecer o que está acontecendo na tela e então usar as ferramentas de software disponíveis para realizar tarefas específicas. Quando um desenvolvedor instrui Claude a usar determinado software e fornece o acesso apropriado, Claude, com base em capturas de tela tiradas durante o trabalho do usuário, decide em que direção, até que ponto mover o cursor – e em que posição clicar para obter o resultado desejado, ” dizem os desenvolvedores. Recebendo comandos do usuário – por exemplo, qual formulário preencher e onde obter dados para cada um de seus campos – a IA os retransmite de forma independente em uma sequência de comandos e ações com uma interface de software e, em seguida, os executa corretamente. Sim, ainda não é o ideal, mas onde você viu os “usuários profissionais de PC” biológicos ideais?

Fonte: geração de IA baseada no modelo FLUX.1

⇡#Título desbloqueado: “Idle Man”

Como mais você pode chamar uma pessoa inspirada na superideia do triunfo da inteligência artificial, que oferece aos empresários experientes e completamente realistas agora, quanto mais cedo melhor, para construir, sempre que possível, três a quatro dezenas de novas fábricas para a produção dos microcircuitos mais avançados – para preencher um planeta claramente carente de GPUs de servidor de alto desempenho? Bem, sim, admite Sam Altman, CEO da OpenAI, que apresentou esta ideia, o prazer que ele oferece ao mundo custará cerca de 7 biliões de dólares (para comparação: as despesas orçamentais actuais desta superpotência para a parte de 2024 que expirou no final de 2024). outubro estão se aproximando de US$ 6,8 trilhões de dólares), mas o fim definitivamente justifica os meios! “Não”, responderam empresários da TSMC, Samsung e SK Hynix, a quem o visionário americano abordou com tal proposta no inverno passado, durante a sua viagem à Ásia. E mais perto de meados do outono de 2024, o New York Times soube que a alta administração da principal fabricante mundial de chips taiwanesa chamou Altman, depois de ouvir seu projeto, com bastante delicadeza – “um fanfarrão” ou um “tagarela” (podcasting mano).

Na verdade, há uma razão muito prática por trás da insistência de Altman em tornar o hardware para execução de modelos de IA o mais acessível possível. Como Tom’s Hardware relatou em outubro, citando o blog Tech Fund, um arquiteto de software sênior anônimo da Alphabet admitiu recentemente que GPUs poderosas em data centers de IA em nuvem falham, às vezes até um ano após o início do uso intensivo, e no final do terceiro anos após a instalação em um servidor (que geralmente funciona de 60 a 70% do tempo sob carga máxima, porque a demanda por serviços de IA em nuvem é muito alta), até um terço de todos os aceleradores adquiridos inicialmente podem falhar. Os próprios processadores gráficos, que dissipam até 700 W de calor cada, são parcialmente incapazes de suportar este modo de operação; em parte – a memória HBM trabalhando em conjunto com eles. Mas em qualquer caso, o acelerador de IA, ao contrário de uma CPU de servidor, placa de rede, dispositivo de armazenamento ou outro equipamento, muitas vezes não atinge a vida útil real do hardware, padrão para data centers, de 3 a 5 anos. Se levarmos em conta a carga quase completa de pedidos das fábricas avançadas da mesma TSMC com pelo menos um ano de antecedência, o fervor do inquieto chefe da OpenAI em garantir um influxo de volumes adicionais de hardware adequado para a computação de IA torna-se muito mais claro.

Fonte: Huawei

⇡#Ferro quente

Contra o pano de fundo de uma recomendação moderada, mas inteligível, das autoridades chinesas às empresas locais para não usarem placas gráficas Nvidia para resolver seus problemas de IA, a Huawei começou a entregar seus mais recentes aceleradores de servidor Ascend 910C – e assim mergulhou os especialistas globais em séria perplexidade: onde esses chips supostamente “7nm” podem ser produzidos nas quantidades declaradas – dezenas e centenas de milhares? É claro que a SMIC do continente foi capaz de fornecer sistemas em chip de “7 nm” para smartphones carro-chefe da mesma Huawei, mas ainda assim, o acelerador gráfico de servidor, anunciado como concorrente direto da Nvidia A100, é muito mais VLSI grave. Além disso, a Huawei, de acordo com a declaração oficial de seus representantes, “nunca lançou o chip anterior desta série, Ascend 910B” – e, se você acredita (apoiado pelos resultados de pesquisas aprofundadas) na suposição de especialistas do laboratório TechInsights, encomendou-o através de uma empresa de fachada da taiwanesa TSMC após a introdução de sanções pelo Departamento de Comércio dos EUA. Como resultado do escândalo que eclodiu, a fabricante de chips taiwanesa começou a rescindir contratos com todos os clientes que poderiam até ser suspeitos de tentar violar as sanções de exportação dos EUA no interesse da Huawei Technologies – e isso certamente não contribui para a melhoria do mercado global para plataformas de IA de hardware.

A OpenAI, por sua vez, não está de forma alguma ocupada com um projeto de sete trilhões de dólares – e está trabalhando ativamente, segundo a Reuters, junto com a Broadcom, para desenvolver um projeto de design para seu próprio chip para computação de IA, que está planejado para ser fabricado nas mesmas instalações da TSMC aproximadamente em 2026. Estamos falando de um chip focado principalmente na execução (inferência) de modelos generativos, e não no seu treinamento, o que exige um poder computacional muito maior. Obviamente, no futuro previsível – especialmente tendo em conta as limitadas instalações de produção de semicondutores de 3 nm e até mesmo em menor escala disponíveis no mundo – não faz muito sentido competir com os principais fornecedores de aceleradores de IA de servidor “pesados”, mesmo para OpenAI . Mas no domínio da prestação de serviços de execução de modelos generativos, seja localmente ou na nuvem, faz sentido competir com os gigantes actuais: serão necessários menos investimentos nesta actividade e o seu retorno pode ser esperado relativamente em breve.

Fonte: geração de IA baseada no modelo FLUX.1

⇡#E o dinheiro está separado

O mercado global de TI como um todo está atualmente, se não estagnado, pelo menos apresentando um crescimento bastante contido, principalmente em termos de investimentos em novas P&D, mas no segmento de IA, com entrada de caixa, tudo estava em perfeita ordem em outubro . Até a Microsoft aprendeu a ganhar dinheiro com inteligência artificial – principalmente alugando a capacidade da nuvem Azure para executar desenvolvimentos de IA de terceiros, incluindo produtos OpenAI. A propósito, a gigante de Redmond já investiu quase 14 mil milhões de dólares nesta empresa formalmente independente e está apenas a aumentar esses investimentos – obviamente, na esperança de ainda ver o seu retorno com lucro num futuro próximo. Além disso, a mesma OpenAI recebe três quartos da sua receita de utilizadores pagos dos modelos que desenvolveu – o que significa que, se o interesse geral na IA não começar a diminuir repentinamente, com um aumento no número de tais utilizadores, podemos esperar um aumento proporcional na renda. É verdade que os custos, principalmente da electricidade, irão aumentar, mas há esperança para pequenos reactores nucleares modulares e para o gás natural.

A propósito, embora os fluxos de dólares para o setor de IA não estejam enfraquecendo, já não há fundos suficientes para todos os participantes que trabalham lá. Tal como relata o Financial Times, a OpenAI, que recebeu recentemente 6,6 mil milhões de dólares na sua última ronda de financiamento externo, pediu aos investidores que se abstivessem de investir em grandes projectos que concorram directamente com ela, como o Anthropic ou o xAI. Requisitos de exclusividade de apoio financeiro a startups (e a empresa gerida por Sam Altman, apesar do seu valor ser estimado em quase 160 mil milhões de dólares, ainda é considerada uma startup segundo uma série de parâmetros) numa determinada área da indústria das TI é praticamente inédito – pelo contrário, os investidores preferem investir em vários projetos paralelos.

O próprio facto de a OpenAI colocar a questão desta forma indica a sua posição especial no segmento da IA, pelo menos do ponto de vista dos potenciais investidores, e deve encorajar os seus concorrentes diretos a melhorar ainda mais rapidamente os seus próprios modelos. A “lista negra” de empresas que não deveriam receber financiamento das mesmas fontes que já financiam a OpenAI inclui, além de xAI e Anthropic, Perplexity, Glean e Safe Superintelligence – esta última foi fundada pelo ex-colega de Altman, Ilya Sutskever. No entanto, esses outsiders condicionais da IA não sofrem exatamente com a falta de fundos: por exemplo, Mira Murati, que deixou a OpenAI em setembro e ocupou o cargo de diretor técnico lá, já está assediada por investidores de risco com ofertas de financiamento para a IA. ela ainda não criou uma startup, e o cofundador da mesma notória OpenAI, Durk Kingma, foi contratado em outubro pela Anthropic, empresa que, graças aos seus desenvolvimentos de sucesso, também não é pobre.

Comparando o AMD-Llama-135M com vários modelos de linguagem populares enquanto executa vários benchmarks de IA (fonte: AMD)

⇡#Mais modelos para o deus dos modelos

Que tipo de tarefas a IA não está sendo usada para realizar agora? Por exemplo, quem poderia imaginar que um lugar para funcionalidade generativa seria encontrado em um editor gráfico tão despretensioso como o Microsoft Paint? Mas foi encontrado, e agora sua versão mais recente, que deve aparecer no Copilot Plus PC antes do final de 2024, graças à ferramenta inteligente Paint Cocreator (com moderação integrada, é claro – caso contrário, eles começarão a desenhar qualquer coisa!) imagens baseadas em instruções de texto ou esboços. Além disso, a Super-Resolução permitirá dimensionar imagens para melhorar a qualidade, o Generative Erase permitirá remover objetos desnecessários delas, o Generative Fill permitirá adicionar aqueles que não estavam no original, etc.

O assistente local inteligente Copilot, desenvolvido pela mesma Microsoft, também recebeu uma grande atualização de funcionalidade em outubro – agora adquiriu uma interface de voz completa, aprendeu a reconhecer os dados visuais exibidos na tela (o conteúdo das páginas da web visualizadas pelo usuário, por exemplo), e assumiu as funções de locutor de previsão do tempo e até de pensador profundo. O quão profundo ainda será visto pelos primeiros usuários da ferramenta de IA (ainda em fase de testes) Think Deeper, que supostamente permite encontrar respostas até mesmo para questões realmente complexas, construindo cadeias de raciocínio e produzindo consistentemente conclusões lógicas.

Outras empresas não ficam atrás dos líderes do sector gerador, percebendo que não podem desistir de um segmento tão lucrativo sem lutar. A Nvidia apresentou no início de outubro toda uma família de grandes modelos de linguagem NVLM, incluindo NVLM-D 1.0 com 72 bilhões de parâmetros, que, segundo os desenvolvedores, não é inferior, segundo os desenvolvedores, ao Llama 3-V da Meta* com seus 405 bilhões de parâmetros – e até mesmo pronto para competir com o GPT -4o, a ideia mais popular (graças à versão atual do bot ChatGPT) da OpenAI. Por sua vez, a AMD apresentou – para variar – o modelo de linguagem pequena (SLM) AMD-135M com decodificação especulativa. Um de seus componentes, AMD-Llama-135M, foi treinado em 670 bilhões de tokens e, em seguida, uma versão adicionalmente ajustada do modelo, o código AMD-Llama-135M, passou por treinamento adicional em outros 20 bilhões de tokens. O significado dos modelos de linguagem “pequenos” é abandonar a universalidade do LLM e concentrar-se em uma certa gama de tarefas, neste caso a programação aplicada. O princípio de seu funcionamento – aquela decodificação muito especulativa – é o seguinte: primeiro, uma versão mais geral, neste caso AMD-Llama-135M, gera várias respostas possíveis para uma determinada pergunta, e depois uma versão adicional treinada em uma matriz de dados especializados, código AMD-Llama-135M, comparam as respostas propostas e selecionam entre elas a mais adequada à solicitação da operadora. Assim, dizem os desenvolvedores, o tempo de execução é reduzido e a carga na capacidade do hardware é reduzida (em comparação com quando tanto a geração inicial de variantes quanto sua comparação são realizadas pelo mesmo modelo maior) – sem comprometer a qualidade dos resultados obtidos.

Sua cara quando você removeu referências a programadores russos da lista de desenvolvedores de kernel Linux e depois criticou o hype em torno da IA (fonte: TFiR)

⇡#Marketing ou realidade?

«IA é 90% marketing e apenas 10% realidade”, disse Linus Torvalds apaixonadamente durante o Open Source Summit, que aconteceu em outubro em Viena, Áustria. Na verdade, o cepticismo desta figura icónica do mundo Linux em relação à inteligência artificial nunca foi um segredo, mas neste discurso ele forneceu uma base bastante sólida para as suas opiniões: “Não tenho dúvidas de que a IA tem um potencial enorme, e penso que isto a direção é realmente interessante. Tenho certeza de que um dia essa tecnologia será capaz de mudar o mundo, mas, ao mesmo tempo, simplesmente não suporto todo o hype que está sendo gerado em torno da IA agora, e é justamente por isso que não consigo suportar. Não quero nem chegar perto desse assunto.” Torvalds acredita que todo o segmento do mercado global de TI hoje focado em inteligência artificial está em uma posição extremamente desvantajosa – e que este tópico está atraindo muita atenção prejudicial.

Paradoxalmente, os magnatas de Wall Street também concordam com o fundador do movimento Linux: os maiores investidores americanos estão cada vez mais preocupados com o ritmo a que os gigantes mundiais de TI estão a aumentar os investimentos em centros de dados cada vez mais poderosos e ávidos de energia. A questão não está na magnitude dos custos em si, mas no seu retorno extremamente baixo e não muito garantido. Pelo menos agora, os investimentos em novos data centers de IA, em usinas de energia e linhas de energia para eles, no treinamento de modelos de linguagem cada vez maiores são feitos na expectativa de que a demanda por IA em uma variedade de setores da economia pelo menos não diminua de o actual nível bastante elevado e, idealmente, também aumentar. Mas estes cálculos estão repletos de riscos extremamente elevados: por exemplo, de acordo com o Visible Alpha, apenas os investimentos da Microsoft em infraestrutura de servidores para IA em apenas um trimestre do ano em curso excedem os seus custos totais para todo o ano de 2019.

O crescimento do volume de recursos disponíveis para organizar a computação de IA simplesmente não acompanha a demanda por eles – e isso, curiosamente, assusta ainda mais os investidores. Afinal, se o mercado for simultaneamente operado tanto por clientes que já utilizam intensamente modelos generativos para optimizar os seus processos de negócio, como por aqueles que involuntariamente continuam a agir à moda antiga (simplesmente porque objectivamente lhes falta poder computacional), e se os primeiros , em média, não estão radicalmente à frente deste último, nem em termos de receita nem de lucro líquido (especialmente em termos de lucro, uma vez que os custos da IA com uso intensivo de energia são muito elevados), então, depois de algum tempo, os clientes começarão a fazer perguntas desconfortáveis questões: onde está, de fato, a superioridade tecnológica incondicional prometida pelos visionários do LLM? Imagens altamente artísticas de gatos com chapéus engraçados mediante solicitação de texto, até mesmo animadas, até mesmo com voz sintética – aqui estão elas; e onde estão os lucros excedentes esperados?

Cartaz da peça “McNeal” (fonte: Lincoln Center Theatre)

⇡#Não se atreva a me gerar!

O vencedor do Oscar, Homem de Ferro e simplesmente Holmes, ou melhor, Robert Downey Jr., não apenas proibiu os estúdios de Hollywood, agora ou no futuro, de reproduzir sua imagem usando tecnologias de IA, mas também ameaçou “processar todos os futuros administradores” que pensassem em dando esse tipo de ordem aos seus subordinados. Estamos falando aqui especificamente dos futuros diretores executivos do MCU ou de outro estúdio que irá adquirir os direitos dos personagens interpretados pelo ator, já que ele está confiante de que sua atual liderança não dará tal passo de forma alguma. “E mesmo quando eu morrer, meus advogados estarão extremamente ativos”, acrescentou Downey Jr., deixando claro que havia pensado firmemente sobre o assunto e tomado todas as decisões apropriadas. Além disso, ele agora está ocupado no palco do teatro – na peça “McNeal” em exibição na Broadway – onde estão sendo consideradas as consequências das decisões tomadas em relação à IA por grandes corporações que desenvolvem ativamente esta área, que não são as mais inequivocamente benéficas para um indivíduo. pessoa e para a humanidade como um todo.

E o ator que encarnou a imagem do Homem de Ferro está longe de estar sozinho em sua rejeição às gerações artificiais de natureza criativa: mais de 30 mil artistas, músicos e outros criadores, inclusive bastante conhecidos, apoiaram uma petição online chamada Declaração no treinamento em IA, que rejeita o uso não autorizado por empresas de signatários criados durante um ou outro ato criativo de imagens artísticas – seja uma pintura, uma peça musical, a personificação de um personagem em uma peça no palco, etc. para criar novos conteúdos derivados dessas imagens, mas até para treinar habilidades generativas com seus modelos de ajuda. A razão é simples e compreensível: quanto mais o público consome conteúdo gerado por IA, menos inclinado está a pagar aos criadores vivos dos protótipos utilizados para o treinar; e isto, por sua vez, reduz o volume potencial de imagens artísticas recentemente geradas pelas pessoas. As luvas de seis dedos enviadas pela startup finlandesa Saidot aos chefes das principais empresas de IA e ao topo da União Europeia também podem ser consideradas um alerta sobre os perigos do desenvolvimento excessivamente rápido da inteligência artificial – o que a torna difícil de prever e proativamente mitigar os perigos e riscos a ele associados.

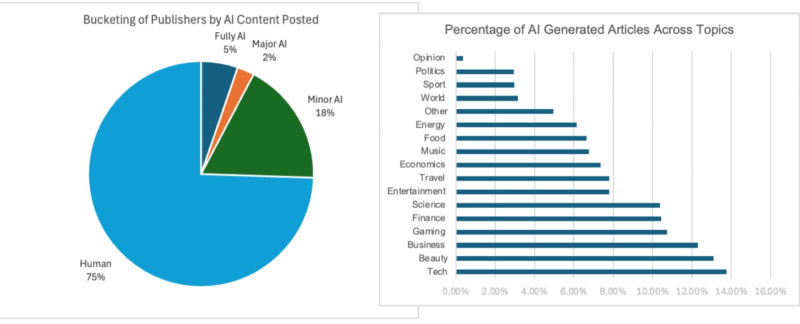

Três quartos dos materiais de notícias textuais na Web em inglês são gerados inteiramente por pessoas e, em termos da participação daqueles na criação dos quais a IA está envolvida, pelo menos em grau mínimo, o líder – o que não é de todo surpreendente – é o tema tecnologia/tecnologia (fonte: Pangram Labs)

⇡#Os abismos se abriram – mas ninguém percebeu

O que acontecerá com a Internet a que estamos acostumados quando ela estiver repleta de textos criados por bots de IA? Especialistas preocupados fizeram esta pergunta no início da revolução generativa, no outono de 2022, e por vezes expressaram as opiniões mais pessimistas – previram, por exemplo, a extinção completa de plataformas abertas (semi)anónimas como Reddit ou Medium, em cujo registro requer apenas confirmação por e-mail (mesmo que apenas temporário) e não é esperada pré-moderação de postagens. E, como muitos acreditavam, o jornalismo editorial/autor clássico sofreria danos irreparáveis, uma vez que pelo menos os redatores de notícias contratados certamente não resistiriam à tentação de transferir o tedioso trabalho de revisão de textos públicos para os ombros brilhantes de robôs.

Na verdade, como se constata, um fluxo obscuro de textos gerados por bots sem alma sobrecarregou certos segmentos da Internet – no entanto, a situação tanto lá como na Internet como um todo ainda está longe de ser catastrófica. No verão, pesquisadores do Pangram Labs publicaram os resultados de uma análise de quase 900 mil materiais de mais de 26 mil recursos online em inglês – e descobriram que não mais do que um quarto dos textos, em média, passam por uma correção mínima de IA, e aqueles gerados por bots do início ao fim apenas cerca de 7%. Sim, em alguns lugares as coisas são muito piores: por exemplo, na popular plataforma aberta Medium, essa participação chega a 47% – mas, como disse seu CEO, Tony Stubblebine, em entrevista à Wired em outubro, “não importa nem um pouco : tudo Ninguém em sã consciência lerá os escritos dos bots.” E esta posição é bastante sensata, pelo menos situacionalmente: pelo menos no nível atual de desenvolvimento da IA generativa, o texto “humanóide” produzido por ela fere imediatamente e de forma desagradável os olhos, e o interesse por tal material entre os leitores biológicos do outro lado da o monitor está desaparecendo rapidamente. Deixar esse tipo de material sem a supervisão dos editores acaba sendo mais barato e mais fácil do que introduzir pré ou pós-moderação: como não há danos aos visitantes ao vivo e a publicidade em páginas geradas por bots ainda está em execução, qual é o sentido de agitado?

Além disso, neste tipo de plataformas abertas, o maior número de visualizações são recebidos por artigos recomendados por alguns leitores a outros – seja diretamente, enviando um link, ou com todos os tipos de “curtidas” e exibindo-os no topo visível para todos . É claro que também aqui os bots inteligentes, especialmente aqueles que são bons em imitar as ações de uma pessoa em um PC, podem ser usados para trapacear – mas, neste caso, os visitantes biológicos ainda descobrirão que estão tentando enganá-los , e com as suas “aversões” restaurarão rapidamente o status quo. Portanto, pelo menos enquanto um site popular tiver mais leitores ativos do que bots (e os bots de IA, lembremos, não são um prazer barato, são muito caros do ponto de vista energético e financeiro), é de fato uma boa ideia se preocupar com a qualidade do conteúdo gerado pelos próprios visitantes provavelmente não deveria. Sim, se algum dia no futuro a “teoria da Internet morta” encontrar sua encarnação real, na qual há muito mais bots inteligentes do que pessoas, então a conversa será diferente. Mas até agora, a julgar pela pesquisa do Pangram Labs, isso ainda está muito longe.

E mais: o conteúdo gerado por IA não deve necessariamente ser considerado lixo – esta é a convicção sincera do CEO da Meta*, Mark Zuckerberg, que acredita que os usuários de suas redes sociais simplesmente anseiam por textos, músicas, vídeos, imagens estáticas e de alta qualidade. outros produtos de modelos generativos; em primeiro lugar, da família Llama desenvolvida pelos seus programadores. Zuckerberg não concorda com a designação categórica estabelecida para tal conteúdo como “resíduos de IA” – pelo contrário, ainda hoje, as imagens que se tornam virais no Facebook*, por exemplo, muitas vezes acabam por ser geradas por inteligência artificial. E eles regularmente trazem aos seus criadores (mais precisamente, aqueles que criaram ou cortaram com sucesso pistas adequadas para eles em algum lugar) bônus bastante materiais; até US$ 10 por mil “curtidas”. Portanto, muito aqui depende do ponto de vista: talvez os bots que regularmente levam outros bots ao topo sejam realmente usuários ideais para redes sociais?

Fonte: geração de IA baseada no modelo FLUX.1

⇡#O aparecimento da supramente é retardado; por enquanto – até 2035

Pelo menos, esta é a opinião de Masayoshi Son, CEO do SoftBank, que, durante uma conferência em Riade, na Arábia Saudita, disse que até esta data será criado um cérebro artificial “dez mil vezes superior às capacidades humanas”. Esta é uma descrição muito geral desta tecnologia atualmente inacessível; Nem sequer está claro se este “cérebro” será incorporado numa base de hardware diferente dos semicondutores – ou se será modelado digitalmente em algo diferente de algum supercomputador x86 ou ARM. É verdade que o chefe da corporação japonesa fez uma reserva: para dar vida a esta profecia, serão necessários investimentos substanciais no desenvolvimento evolutivo da IA, desde o seu estado atual (não o mais notável, falando francamente, embora extremamente promissor) até o futuro superinteligência – nada menos que 900 trilhões de dólares a preços correntes hoje. Neste contexto, os míseros 7 biliões com que Sam Altman sonhou recentemente parecem, francamente, uma quantia insignificante, mas mesmo isso será útil na fase inicial; porque na ausência de um potencial de produção verdadeiramente extenso para o lançamento de chips de IA sempre novos (simultaneamente com o progresso bastante lento da computação neuromórfica em uma base de hardware que não seja semicondutores), o desenvolvimento de modelos generativos ameaça ficar paralisado por um longo tempo. tempo na fase alcançada hoje.

Mas Robin Li, chefe do gigante digital chinês Baidu, alertou que no caminho para um futuro brilhante na IA (independentemente de os criadores da superinteligência artificial atingirem ou não o seu objectivo), a indústria de alta tecnologia enfrentará perdas consideráveis. Nos últimos 18 a 20 meses, de acordo com suas observações, os problemas com alucinações de modelos generativos, que causaram muitos problemas para os desenvolvedores, se não desapareceram completamente, foram em grande parte eliminados. No entanto, é precisamente isto que cria as condições prévias para o amadurecimento de uma bolha nas bolsas de valores, que ameaça exactamente repetir o destino da notória “bolha pontocom” na viragem do século. Depois, as redes de comunicações digitais que de repente se tornaram acessíveis a todos atraíram um grande número de empresários, cujas empresas faliram em 99%, incapazes de fazer face ao aumento das encomendas e às crescentes exigências dos consumidores. O mesmo destino, Lee tem certeza, aguarda agora 99% dos empreendedores que escolheram o caminho da IA – e isso também pode ser um golpe extremamente sério para o mercado global de TI.

⇡#Pintar!

A empresa Stability AI, que há pouco tempo decepcionou os entusiastas do desenho de IA com seu modelo SD3M francamente falho, decidiu em outubro corrigir sua reputação lançando três licenças sob uma licença que é muito tolerante, inclusive para licenças limitadas (com receita de até US$ 1 milhão por ano) de uso comercial modelos muito atraentes à primeira vista – Stable Diffusion 3.5 nas versões Large, Turbo e Medium. Mesmo o maior modelo, o Large, com seus 8,1 bilhões de parâmetros, é bastante adequado para geração local. Turbo é uma versão “acelerada” otimizada para cozinhar imagens rapidamente, em apenas 4 etapas, enquanto Medium com 2,5 bilhões de parâmetros possui uma arquitetura Multimodal Diffusion Transformer (MMDiT-X) redesenhada e uma disposição para gerar composições, cores e outras imagens mutuamente consistentes. parâmetros em uma ampla gama de resoluções – de 0,25 a 2 megapixels.

O que atraiu de imediato a comunidade, já um pouco cansada da destilação excessiva (com todas as suas vantagens indiscutíveis) do modelo FLUX.1, cujo papel significativo na criação foi desempenhado por ex-funcionários da Stability AI, foi justamente a ausência de otimizações rígidas semelhantes no SD 3.5. Sim, na versão original, este modelo nem sempre gera imagens subjetivamente próximas do ideal estético – ao contrário do FLUX.1, especialmente sua versão [pro] disponível exclusivamente através da API – mas a variabilidade do modelo não foi sacrificada para esta perfeição condicional e sua prontidão para futuras modificações. Refere-se aos modelos criados pela comunidade LoRA, ControlNet, etc., com treinamento baseado no FLIX.1, nem tudo corre bem, já que um conjunto de balanças destiladas se presta a ajustes finos com muitos rangidos. É precisamente pela ausência de tais restrições, os entusiastas têm certeza, que o SD 3.5 da Stability AI tem todas as chances de se tornar o “novo SDXL”, formando em torno de si todo um ecossistema de complementos criados pela comunidade – e estabelecendo um novo padrão para abertura máxima (tanto quanto possível em princípio para um modelo com apenas pesos finais publicados, mas não a matriz original de imagens de treinamento) de uma ferramenta para geração de IA local, em vez de vinculada a serviços em nuvem.

________________

* Incluído na lista de associações públicas e organizações religiosas em relação às quais o tribunal decidiu liquidar ou proibir atividades que tenham entrado em vigor pelos motivos previstos na Lei Federal de 25 de julho de 2002 nº 114-FZ “ Sobre o Combate às Atividades Extremistas”