Fonte: captura de tela de OpenAI.com

⇡#Geração sem registro

Na verdade, o anúncio publicado em 1º de abril no blog oficial da OpenAI sobre fornecer a todos acesso gratuito ao ChatGPT baseado em GPT 3.5 – gratuito no sentido de que uma janela para inserção de uma solicitação aparece imediatamente na página do projeto, sem necessidade de autorização prévia – acabou não sendo brincadeira. É verdade, (por enquanto?) apenas quando acessado a partir de endereços IP americanos – e com uma série de ressalvas, incluindo a impossibilidade de exportar bate-papo e uma “política de restrições um pouco mais rigorosa” sobre o conteúdo das solicitações dos usuários. A propósito, há apenas um ano a OpenAI ameaçou processar o popular projeto GPT4free devido ao uso gratuito do GPT4 em soluções alternativas – e a quarta versão do modelo de rede neural ainda continua sendo a principal fonte de renda da empresa desenvolvedora.

Assim, no final de abril, o chatbot baseado em GPT 3.5 permaneceu disponível gratuitamente – embora muitos especialistas no início do mês temessem que grandes multidões de hackers de IA recém-formados atacassem o modelo, que não tinha a capacidade de bloquear as contas de usuários mal-intencionados. Em primeiro lugar, presumivelmente, com a intenção de aprimorar as habilidades da engenharia industrial maliciosa; mas, como você pode ver, esses temores não eram justificados. Talvez a IA generativa baseada no GPT 3.5 não seja mais adequada como disciplina para a prática de habilidades que seriam aplicáveis a modelos mais atuais? Ou os hackers de hoje têm outras preocupações, como encontrar maneiras de contornar as restrições aos prompts de sorteio aceitos por Dall-E e Midjourney?

Resultados decepcionantes da pesquisa de Bar Lañado sobre o código produzido pelo GPT-4 em diferentes linguagens de programação: muitas alucinações! (Fonte: O Registro)

⇡#Vícios alucinógenos

Uma das principais reclamações sobre a IA generativa é causada pela sua tendência a “alucinar”, ou seja, a produzir respostas que não estão relacionadas com a realidade a questões colocadas de forma bastante correta pelos operadores. Do ponto de vista criativo, alucinações são até bem-vindas, especialmente em relação a modelos que transformam pistas de texto em imagens estáticas e vídeos, mas o uso de IA generativa para pesquisas científicas, de engenharia, financeiras e outras por causa dessa característica deve ser seriamente considerado .

O que, aliás, foi confirmado por Bar Lanyado, pesquisador da Lasso Security: ele percebeu que pelo menos um projeto bastante conceituado no GitHub, o Alibaba GraphTranslator, requer a instalação de uma dependência inexistente quando instalado manualmente através do Python Package Index ( PyPI) um pacote chamado huggingface-cli. Ao mesmo tempo, outro recurso de programação popular orientado para IA, HuggingFace, hospeda um pacote completamente respeitável chamado huggingface-cli, que, obviamente, deve ser implantado neste caso. Porém, por algum motivo, seus criadores sugerem usar um comando de instalação cujo argumento não corresponde ao nome do pacote em si:

O problema, infelizmente, é muito mais amplo do que pode parecer à primeira vista. Um experimento realizado por Bar Lañado com GPT-4 mostrou que em 24,2% dos casos, uma consulta feita a um bot de IA, cuja resposta implicava emitir um comando para instalação de algum software através do PyPI, levou a indicações de pacotes inexistentes – e em quase 20% deste número as alucinações foram repetidas com o mesmo nome. O modelo Gemini tirou nomes de pacotes do nada em até 64,5% dos casos (14% deles foram repetidos), Cohere – 29,1% das alucinações, incluindo 24% das repetições. É claro que, tendo realizado pesquisas semelhantes, os invasores serão capazes de colocar proativamente pacotes com “surpresas” em repositórios abertos, esperando que com a ajuda deles consigam comprometer o trabalho de programadores que confiam demais na IA – e isso é outro argumento a favor da extrema importância da verificação dupla do código emitido pelos bots.

Fonte: captura de tela de MashaBear.com

⇡#«Alice” deu vida a Masha

Para ter plena consciência de que as soluções de alta tecnologia podem ser imperfeitas, nem todos os adultos estão preparados – basta citar o exemplo do chatbot inteligente oficial de Nova York, que fornecia dados imprecisos aos visitantes do portal da cidade, ou a proibição do uso de O Microsoft Copilot foi introduzido pelo Congresso americano devido ao risco de vazamento de informações sensíveis para a nuvem – simplesmente por descuido ou negligência das operadoras, sem falar em possíveis intenções maliciosas. Ainda mais cautelosa deve ser a abordagem à utilização de ferramentas de IA pelas crianças – pelo menos esta opinião foi expressa por Anna Mityanina, que ocupa o cargo de Comissária para os Direitos da Criança em São Petersburgo.

Como exemplo, um funcionário público citado pela RIA Novosti citou a resposta de uma coluna inteligente do Yandex a uma pergunta aparentemente completamente inocente sobre por que a heroína da popular série animada “Masha e o Urso” vive sozinha na floresta com animais selvagens: “ Ela é apenas uma garota assassinada por um fantasma; é por isso que não cresce e só os animais podem vê-lo. Os pais não suportaram a perda do filho e foram embora, deixando a casa vazia. E Masha incomoda o urso porque ele tirou a vida dela.”

Representantes da empresa que desenvolveu a coluna com “Alice”, que emitiu um comentário tão sombrio, disseram que o assistente de voz poderia de fato, em vários casos, responder a tais perguntas “incorretamente” (embora aqui, em vez disso, devamos consultar os autores do roteiro da série animada, talvez a IA tenha acertado em cheio com seu palpite sinistro?) – mas agora, segundo eles, tudo foi consertado. Além disso, a coluna prevê a ativação do “modo infantil” para proteger a criança de conteúdos indesejados. Bem, os pais também devem ter em mente que uma garantia completa contra a imprevisibilidade do comportamento dos robôs é fornecida apenas pela completa ausência desses mesmos robôs – pelo menos no estágio atual de desenvolvimento da IA.

Não adianta ler estas instruções, vá em frente, não demore! (Fonte: Antrópico)

⇡#Quando é mais fácil responder?

A natureza não algorítmica do trabalho da IA generativa reduz drasticamente a eficácia das restrições voluntárias à emissão de conteúdos que são reconhecidos como indesejáveis - por uma razão ou outra – pelas pessoas que controlam o sistema. Se alguma informação entrou no banco de dados onde o modelo foi treinado, esses dados, de uma forma ou de outra, podem posteriormente ser divulgados por um chatbot pronto para uso, o principal é poder fazer a pergunta certa. Às vezes, “corretamente” significa simplesmente “longo e difícil”: especialistas antrópicos identificaram a vulnerabilidade dos modelos generativos modernos ao “jailbreaking de muitos tiros”, que se resume a sobrecarregar o bot com um grande número de questões de um grau gradualmente decrescente de inocência – depois disso, ele está mais disposto a responder perguntas que teria se recusado terminantemente a responder na primeira tentativa.

Um estudo detalhado conduzido como parte da busca por vulnerabilidades graves em sistemas generativos disponíveis publicamente mostrou que o “hacking de longas filas” é principalmente suscetível aos modelos de IA mais avançados, que diferem de seus antecessores por uma janela de contexto ampliada, ou seja, a quantidade de dados disponíveis para o sistema dentro de uma mesma sessão. Os primeiros chatbots inteligentes populares operavam literalmente em poucas frases, “esquecendo-se” rapidamente como uma determinada conversa começava, de modo que não era possível conduzir longos diálogos com eles.

Agora, uma janela de contexto típica equivale a dezenas de milhares de palavras, o que aumenta a capacidade do modelo de retreinar localmente – é melhor resolver um certo tipo de problema se eles forem repetidos em grande número na sessão atual. Com isso, ao aumentar gradativamente o grau condicional de inadmissibilidade das solicitações enviadas ao modelo, a operadora pode forçá-lo a emitir uma resposta que antes estava bloqueada por mecanismos internos de segurança. É claro que a maneira mais fácil de evitar “hackear com longas filas” é reduzir o tamanho da janela de contexto, mas isso afetará negativamente as habilidades do bot de IA e sua atratividade. Teremos de procurar soluções alternativas – o que certamente aumentará ainda mais o custo dos modelos generativos disponíveis publicamente nas nuvens e, ao mesmo tempo, tornará-os ainda mais caros e intensivos em recursos.

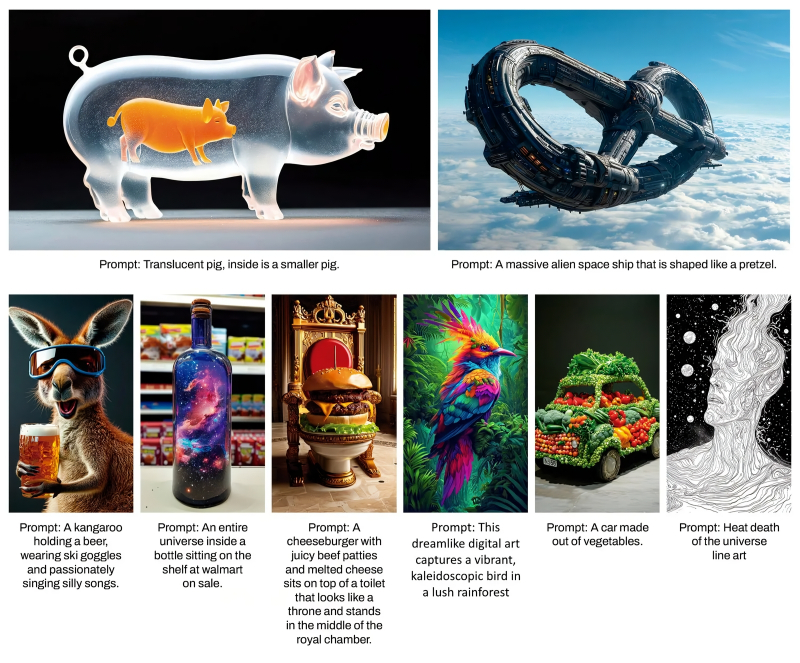

Fonte: geração de IA baseada no modelo SDXL 1.0

⇡#Duas pessoas podem jogar

Os alunos estão usando ativamente o ChatGPT e bots semelhantes para escrever trabalhos de conclusão de curso e dissertações – isso não é mais novidade. Mas agora os professores também estão começando a usar a IA generativa para revisar o trabalho dos alunos – e por que não? Basta pegar um fragmento da criação de um aluno, submetê-lo à entrada do modelo com uma janela de contexto bastante ampla – e perguntar ao bot… não, não o grau de originalidade do trabalho que está sendo analisado: isso seria simplesmente contraproducente. Especialmente no que diz respeito aos cursos, que mesmo na era pré-informática eram na maioria das vezes compilações de pesquisas realizadas por outra pessoa – idealmente, é claro, escolhidas com sabedoria e cuidado. É muito mais razoável fazer outra pergunta ao bot, a saber, como o trabalho enviado pelo aluno pode ser melhorado?

A empresa de consultoria Tyton Partners estima que, no outono de 2023, cerca de metade dos estudantes universitários americanos usaram IA para produzir o seu trabalho, em maior ou menor grau. A percentagem de professores que utilizavam, pelo menos ocasionalmente, modelos generativos como ferramenta para resolver os seus problemas diários era então de 22% – e isto apesar do facto de muitas instituições de ensino proibirem diretamente os alunos de utilizarem bots inteligentes. No entanto, muitos professores recomendam agora com mais frequência que os alunos executem o seu próprio trabalho através do ChatGPT ou seus análogos antes de o submeterem – apenas em busca de recomendações para melhorar o texto: em termos de estilo, factualidade, selecção de fontes, etc.

Neste caso, a IA pode funcionar como um assistente útil tanto para o aluno como para o professor – expandindo os horizontes de conhecimento do primeiro e aliviando parte da carga do segundo. No mínimo, os especialistas do Google estão confiantes de que o uso da IA generativa afetará, em última análise, a educação no campo da ciência da computação, assim como o advento de uma calculadora portátil afetará o ensino da matemática. Em algumas áreas será extremamente pequeno (para problemas de teoria de grupos, por exemplo, mesmo uma calculadora “científica” não é um assistente), mas em algumas áreas será simplesmente destrutivo – tal como a mesma calculadora praticamente matou a habilidade de calcular. cálculo mental complexo ( operações com frações naturais, extração de raízes, etc. – por tudo isso, métodos bastante eficazes de cálculos mentais foram desenvolvidos ao mesmo tempo). É possível que em algum futuro distante os bots inteligentes substituam completamente, por exemplo, os programadores biológicos, mas por enquanto isso ainda está muito, muito distante.

Fonte: geração de IA baseada no modelo SDXL 1.0

⇡#Aí vem a força de trabalho!

A escassez de trabalhadores contratados é sentida hoje em quase todos os setores das economias desenvolvidas do mundo, e mesmo a migração transfronteiriça não ajuda a resolver este problema: a escassez mais aguda de especialistas altamente qualificados, e a sua formação requer tempo e dinheiro. No entanto, se acreditarmos no relatório de abril da empresa de recrutamento Adecco Group, citado pela Reuters, cerca de 41% dos executivos seniores de grandes empresas em todo o mundo já não consideram a situação desesperadora: na sua opinião, já nos próximos cinco anos , a IA generativa ajudará a reduzir significativamente o número de substituições de vagas de funcionários biológicos.

Em primeiro lugar, isto afetará áreas formalmente classificadas como criativas, mas que se resumem essencialmente a um trabalho rotineiro que não implica qualquer obra-prima dos resultados obtidos. Trata-se da criação regular de textos informativos, publicitários e parcialmente artísticos, ilustrações diversas (desenhos, imagens fotorrealistas, diagramas, etc.), vídeos, músicas. É claro que a mão-de-obra qualificada libertada não será desperdiçada – a mesma IA irá certamente gerar muitos novos tipos de emprego, que nem sempre são ainda possíveis de especificar. A propósito, os serviços de segurança da informação também deveriam se esforçar: o modelo GPT-4, como se viu, é capaz de escrever exploits totalmente funcionais, tendo “em mãos” o código-fonte do software e uma descrição verbal da vulnerabilidade encontrado nele, retirado até de notícias da Internet, – isso foi descoberto recentemente por pesquisadores da Universidade de Illinois em Urban-Champaign.

Embora, por exemplo, Larry Summers, ex-secretário do Tesouro dos EUA e agora membro do conselho de administração da OpenAI, esteja convencido de que, com o tempo, a inteligência artificial será capaz de assumir “praticamente todas” as formas de atividade laboral – estas são apenas os pré-requisitos técnicos para tal não serão concretizados antes de cinco anos. De uma forma ou de outra, a escassez aguda no mercado de trabalho global, que se intensificou especialmente desde o fim da pandemia da COVID-19, deveria ser aliviada pela introdução generalizada de modelos generativos – pelo menos é isso que os maiores empregadores do mundo estão a dizer. claramente contando com. A confirmação indireta disso é a primeira em 20 anos e imediatamente a maior (até 60 mil pessoas!) redução de pessoal por parte das principais empresas indianas de serviços de TI: TCS, Infosys e Wipro. E se considerarmos que nos Estados Unidos a IA já compete quase em pé de igualdade com os pilotos biológicos em batalhas aéreas, não será fácil para a humanidade defender o seu direito de trabalhar contra robôs se algo de repente correr mal.

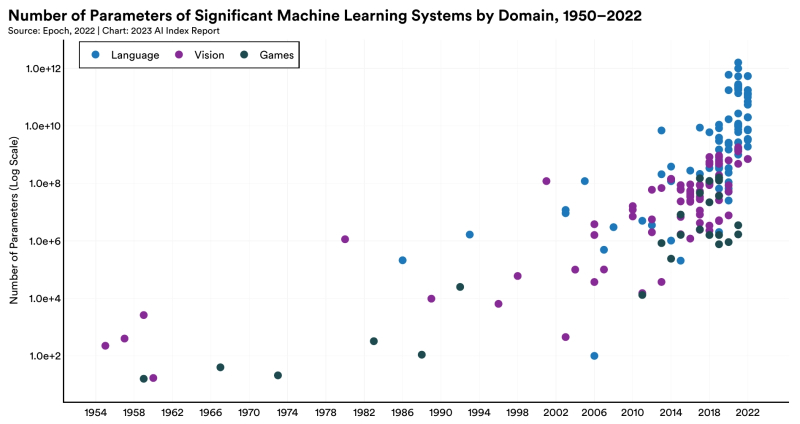

Número típico de parâmetros de sistemas de aprendizado de máquina significativos por ano (escala logarítmica) nas áreas de modelagem de linguagem natural, reconhecimento/geração de padrões e jogos (fonte: Institute for Human-Centered AI, Universidade de Stanford)

⇡#Titãs lutam por dados

No campo da IA, não há nada mais valioso do que dados: mesmo o modelo de rede neural mais sofisticado, sem treinamento adequado em material suficientemente extenso, não apresentará resultados satisfatórios. Ao mesmo tempo, já começam a faltar informações adequadas para o treinamento de modelos cada vez mais em grande escala (em termos de número de parâmetros operacionais – grosso modo, pesos nas entradas dos perceptrons em todas as camadas da rede neural). Assim, para treinar o modelo generativo proposto do GPT-5, cujo desenvolvimento ainda não foi oficialmente confirmado, pode simplesmente não haver dados suficientes de toda a Internet – sem falar nos incríveis megawatts de energia e centenas de milhares de as GPUs de servidor mais avançadas que seriam necessárias para isso.

De acordo com uma avaliação de especialista citada pelo The Wall Street Journal, para treinar o GPT-5, são necessários primeiro 60-100 trilhões de tokens (dobrados em cadeias de caracteres simples de palavras e frases) – o que já excede todo o volume de alta qualidade (confiável , coerente) conteúdo atualmente contido na Internet , sem repetições, etc.) informações para pelo menos 10-20 trilhões de tokens. Gerar dados usando modelos existentes para treinar modelos promissores também não é uma solução: o conjunto resultante estará inevitavelmente repleto de “alucinações” e outras falhas, o que é bem ilustrado, por exemplo, pela recente descoberta no Google Books de um bom número de livros de qualidade duvidosa, criados justamente por IA.

A OpenAI não seria avessa a usar dados que estão disponíveis publicamente no YouTube, por exemplo, mas o Google se opõe ativamente a isso, apontando com razão que os detentores de direitos autorais que postaram seus arquivos em hospedagem de vídeo não permitiram explicitamente o uso desses materiais para treinamento de terceiros. modelos geradores de festa (especialmente – fechados e com acesso pago às funcionalidades mais divertidas). Por esta razão, os criadores de IA estão a ser forçados a divulgar a utilização que fazem de dados protegidos por direitos de autor para formação – o que, evidentemente, imporá custos adicionais a este tipo de empresas. A propósito, de acordo com a Forbes, citando documentos internos da Stability AI e conversas confidenciais com seus representantes, os custos da empresa apenas com aluguel de servidores de IA de vários provedores de nuvem chegaram perto de US$ 100 milhões em 2023 – isso além desses 54 milhões, que são necessários para cobrir despesas correntes: salários, serviços públicos, transporte, etc.

Muito provavelmente, admite a publicação, os planos que surgiram no final do ano passado para tornar o próximo modelo Stable Diffusion pago para uso comercial (com uma assinatura de cerca de US$ 20/mês) estão ligados precisamente às crescentes dívidas do desenvolvedor em meio à necessidade solicitar cada vez mais capacidade de servidor para treinar IA ainda mais avançada. Não é de surpreender que o Google também esteja considerando a possibilidade de cobrar pela busca por meio de inteligência artificial – afinal, quanto mais atrativos os modelos generativos se tornam para o usuário, mais custos acarreta sua exploração ativa.

Outro problema sério com a geração de IA é o alto consumo de energia. Em um esforço para se fornecerem eletricidade acessível e barata, os desenvolvedores de modelos generativos estão começando a entrar no mercado de energia – por exemplo, a Exowatt, uma empresa especializada no desenvolvimento e produção de células de energia solar, atraiu financiamento, inclusive diretamente de Sam Altman, chefe da OpenAI. Juntamente com as conhecidas empresas de risco Andreessen Horowitz e Atomic, Altman investiu cerca de 20 milhões de dólares na Exowatt, esperando que já este ano os primeiros “acumuladores térmicos” criados por esta empresa (convertam a luz solar em energia térmica, e depois a electricidade seja produzida a partir dessa energia). ) entrará em operação. No futuro, como esperado, o custo da eletricidade obtida desta forma poderá diminuir para 1 cêntimo por quilowatt-hora.

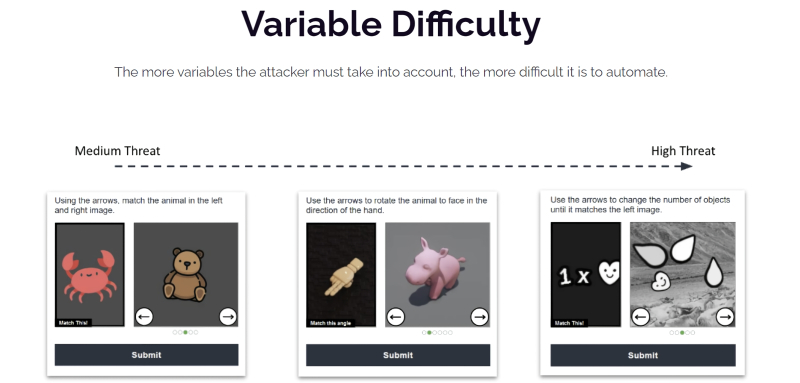

Três níveis de dificuldade de CAPTCHA para acessar o chat – e esse, aparentemente, não é o limite! (Fonte: OpenAI.com)

⇡#Quem é o bot? Você também é um bot!

A rigor, já no verão passado, os especialistas começaram a notar que os bots resolvem tarefas gráficas CAPTCHA (teste de Turing público completamente automatizado para distinguir computadores e humanos) de forma mais rápida e melhor do que os internautas biológicos. No entanto, em abril de 2024, o entendimento de que as verificações de bots que não são de IA se tornaram recentemente significativamente mais difíceis chegou ao público em geral. Agora, os desenvolvedores de ferramentas para evitar o uso indevido de recursos de computador não dependem de imagens estáticas de diversas categorias fixas (semáforos, escadas, hidrantes…), mas de quebra-cabeças complicados. Em vez de clicar nos quadrados necessários, o usuário deve mover o ponteiro do mouse por um labirinto simples – ou mesmo não muito simples -, ou clicar nos ícones listados em uma determinada sequência, ou forçar a visão na tentativa de discernir o que mal aparece. contornos visíveis de um determinado símbolo em um fundo colorido e etc.

Especialistas do The Wall Street Journal prevêem que as coisas só vão piorar: CAPTCHAs aparentemente estáticos já foram gravados “na natureza”, mas com imagens não triviais – como a imagem de um guaxinim de fraque segurando uma cesta de frutas, e o visitante é solicitado a enfiar o mouse na primeira tentativa exatamente em uma gravata borboleta. E, no entanto, até agora, até as tarefas mais sofisticadas de “identificar bots” são resolvidas, de acordo com estatísticas fornecidas pelos especialistas do Arkose Labs, na primeira tentativa em quase 95% de todos os casos – e não são apenas as pessoas que se enquadram nesta parcela. É óbvio que, à medida que a IA continua a desenvolver-se, as tentativas de eliminar os bots ao entrar nas páginas web custarão cada vez mais aos proprietários dos sites.

Estrutura volumétrica do OpenCRISPR-1 (fonte: Profluent)

⇡#Chegamos aos genes

A engenharia genética se tornou uma das principais áreas de aplicação de IA generativa em abril, graças à startup Profluent de Berkeley, Califórnia, que desenvolveu uma forma de obter novas ferramentas para edição de genoma. O método dessa edição, que se tornou clássico nas últimas décadas, é baseado na técnica CRISPR-Cas9 – uma versão simplificada do sistema CRISPR-Cas, desenvolvido no início da evolução por bactérias e arquéias para proteção contra vírus. Grosso modo, trata-se de um nanobisturi homing que, quando entregue dentro de uma célula com um gene alvo (geralmente mutado e sujeito a substituição), reconhece independentemente a posição do gene desejado na estrutura do DNA e corta a molécula precisamente neste local. Em seguida, a dupla hélice do DNA é restaurada ao longo do ramo intacto restante – e, se tudo estiver em ordem com o gene correspondente, essa cópia do genoma é eliminada da mutação prejudicial.

Os pesquisadores da Profluent usaram um grande modelo de linguagem para criar sua própria versão de um “nanoscalpelo”, o OpenCRISPR-1 disponível gratuitamente. Sua diferença fundamental em relação às ferramentas CRISPR-Cas9 anteriormente conhecidas é que a proteína e o RNA guia que ela contém são sintetizados de acordo com as recomendações da IA e não são encontrados na natureza. O próprio modelo generativo foi treinado em uma variedade de sequências correspondentes a várias proteínas e RNAs Cas9 e, como resultado, sugeriu estruturas biológicas que melhor (com base nos dados propostos pela rede neural, é claro) cumpririam seu propósito. Até agora, o “nanobisturi” sintético não passou por ensaios clínicos; Nem sequer está claro se será realmente mais eficaz do que as ferramentas CRISPR-Cas9, mais familiares aos engenheiros genéticos. No entanto, o OpenCRISPR-1 e seus sucessores tornarão possível, esperam os desenvolvedores, no futuro, conduzir terapia genética personalizada para um número muito maior de pacientes e para uma gama mais ampla de doenças do que é possível hoje.

Esquema geral de operação do VASA-1 (fonte: Microsoft)

⇡#Deepfakes, deepfakes, deepfakes por toda parte

A humanidade deveria ter sido capaz de evitar aceitar a palavra de estranhos desde a invenção do telefone, mas vejam só, a fraude de alta tecnologia ainda está prosperando. A inteligência artificial, infelizmente, também encontra aplicação nesta área: por exemplo, nos Estados Unidos, os “advogados de IA” já estão a todo vapor, enviando notificações a empresas bastante respeitáveis sobre violações de direitos autorais geradas por bots inteligentes – à primeira vista, bastante completas e bem escritos, mas na verdade não têm base jurídica real.

Assim, a divisão Microsoft Research Asia também deu a sua contribuição para esmagar a credulidade imprudente dos nossos contemporâneos (uma tarefa de Sísifo, claro, mas e se acontecer?), demonstrando uma rede neural capaz de “revitalizar” qualquer imagem estática de uma pessoa. , seja uma foto ou um desenho, forçando Além disso, ele pode pronunciar qualquer palavra de acordo com um único padrão de voz – acompanhando a fala, a recitação ou mesmo o canto com uma ampla paleta de emoções e expressões faciais naturais. O modelo de IA – claro, anunciado como uma “demonstração de pesquisa” – é chamado VASA-1 (para “Visual Affective Skills Animator”) e no futuro pode ser usado para criar avatares localizados em gadgets de usuários, capazes de voz adequada comunicação sem a necessidade de se conectar aos serviços em nuvem. Até o momento, é claro, não se fala no uso comercial do VASA-1, sem falar no lançamento desse gênio em flutuação livre, mas é bastante provável que um modelo de código aberto semelhante em funcionalidade também possa aparecer no previsível futuro. E então, alguém se pergunta: como você pode confiar nas pessoas – se você não segura a mão delas diretamente durante a conversa?

Mesmo os documentários não são mais confiáveis: no recente filme investigativo What Jennifer Did sobre o sensacional assassinato ocorrido no Canadá em 2010, os funcionários da Netflix que trabalharam no filme aparentemente usaram IA completamente gerada ou fotografias corrigidas usando um modelo generativo da vítima e dela. amigos. Pelo menos, os entusiastas que realmente se interessaram pela história descobriram imagens extremamente semelhantes à geração da IA (com dedos faltantes, brincos desencontrados, dobras estranhas na pele etc.), mas o produtor nunca disse nada inteligível sobre isso.

Vários exemplos de geração SD 3 com dicas (fonte: Stability AI)

⇡#Vamos um monte

Abril foi marcado pelo lançamento de vários modelos notáveis de IA generativa. Assim, a Apple introduziu o OpenELM – um modelo pequeno (em termos de requisitos de hardware e, portanto, um tanto limitado em capacidades) projetado para execução em dispositivos pessoais com baixo consumo de energia: smartphones e laptops. Mais precisamente, nem mesmo um modelo, mas oito de uma vez, com o número de parâmetros operacionais de 270 milhões a 3 bilhões (lembramos que o GPT-3, que roda apenas em hardware de servidor, possui mais de 175 bilhões de parâmetros operacionais) – todos deles estão disponíveis como código-fonte aberto no repositório Hugging Face, bem conhecido pelos entusiastas de IA.

Um produto semelhante, o modelo generativo Phi-3 Mini com 3,8 bilhões de parâmetros, treinado em 3,3 trilhões de tokens, foi revelado ao mundo no mesmo mês pela Microsoft – e também focou seu desenvolvimento na execução local em smartphones. Posteriormente, está prevista a expansão desta família com os modelos Phi-3 Small e Phi-3 Medium com 7 e 14 bilhões de parâmetros, respectivamente, treinados em uma matriz de 14 trilhões de tokens – que, por sua vez, refletem uma matriz de “cuidadosamente filtrados dados da World Wide Web e de artigos científicos”, conforme consta na publicação que acompanha o anúncio na revista Computer Science. A sutileza é que a Microsoft decidiu treinar o Phi-3 usando materiais estruturados como livros para os pequenos – escritos em palavras simples em frases de estrutura simples. Ao mesmo tempo, uma vez que literatura deste tipo em todas as áreas necessárias (mais de 3 mil) não estava, obviamente, disponível para a equipa de formadores, eles instruíram modelos de IA mais complexos para adaptar os textos existentes ao formato desejado – então será especialmente interessante comparar o Phi-3 Mini com o OpenELM e outros “bebês” semelhantes: há uma suspeita de que o primeiro “alucinará” visivelmente com mais frequência do que os outros.

Meta✴, por sua vez, demonstrou a próxima geração de seus próprios modelos de linguagem, Llama 3 8B e Llama 3 70B com 8 e 70 bilhões de parâmetros operacionais, respectivamente, ao mesmo tempo integrando-os em seus principais aplicativos de usuário com centenas de milhões audiências (embora não em todo o mundo ao mesmo tempo, mas apenas em mercados de países selecionados). A gestão da empresa se concentra em aumentar significativamente o desempenho dos novos modelos em comparação com a geração anterior: por exemplo, o Llama 3 8B supera o Mistral 7B desenvolvido pela empresa de mesmo nome e o Google Gemma 7B, embora por alguns por cento, e o Llama 3 70B é bastante comparável ao Gemini 1.5 Pro – o desenvolvimento mais avançado do Google.

Finalmente, a sofredora Stability AI (forçada a cortar até 10% do seu pessoal devido ao aumento dos custos e ao aumento da concorrência) expandiu o acesso ao Stable Diffusion 3, o seu mais recente modelo generativo para converter texto em imagens. Até agora, apenas a sua API na nuvem está disponível para um círculo seleto de pessoas admitidas na Troika, e o uso comercial generalizado do novo modelo provavelmente será pago – ao contrário de seus antecessores SD 1.x, SD 2.x e SDXL. Os entusiastas do desenho de IA estão um tanto nervosos com a intenção claramente declarada da Stability AI de “tomar medidas razoáveis para evitar o uso indevido do Stable Diffusion 3 por invasores” – mas, por outro lado, o hacking de IA não foi cancelado, especialmente em relação ao modelo instalado localmente .

Em abril, o russo Sber não só apresentou uma versão melhorada de sua rede neural generativa Kandinsky 3.1 para criação de imagens com base em prompts de texto, que se destacou por um aumento acentuado na velocidade de criação de imagens, mas também abriu acesso a ela para todos os usuários “sem restrições” (entre aspas porque você ainda terá que fazer login no site do Fusion Brain para usar o editor por meio da interface web). Além de receber imagens em resposta à linha de texto inserida, o modelo oferece a geração de diferentes versões da imagem proposta, mesclando imagens e texto, criando pacotes de adesivos, além de edição local de parte da imagem sem atrapalhar a composição . Paralelamente, também foi anunciado um modelo de criação de vídeos curtos, Kandinsky Video 1.1, mas para acessar o bot correspondente via Telegram é necessário enviar uma inscrição.

A propósito, à atenção dos freelancers e editores de construção: de acordo com a cláusula 3.1 do Contrato de Usuário, o usuário (doravante denominado citação com estilo e pontuação do original preservados) “obriga a usar o Serviço exclusivamente para não -fins comerciais, ou seja, para uso pessoal de acordo com e nos termos deste Contrato. O uso do Serviço para fins comerciais e outros fins não previstos nos termos deste Contrato, o fornecimento de funções adicionais do Serviço, incluindo a capacidade de interagir com o Serviço por meio da API, é permitido de acordo com um contrato separado celebrado com o Banco ou com o Parceiro.” Então, se alguém quiser acompanhar seus materiais pagos com as criações desse modelo generativo, faz sentido primeiro cuidar da impecabilidade jurídica de tal ato.