Uma maldição muito antiga “Para que você viva em uma era de mudança” corresponde plenamente aos eventos do ano passado. A pandemia teve um impacto profundo em todo o mundo, e nem sempre de forma óbvia. O setor de TI, tendo experimentado altos e baixos, acabou conseguindo se adaptar rapidamente às novas condições. Nem todos os problemas foram resolvidos, mas isso não impediu o lançamento de novos produtos e tecnologias, dos quais falaremos. O material acabou sendo grande, portanto, por conveniência, fornecemos links para as seções:

- CPU

- Aceleradores

- DPU и SPU

- Memória e armazenamento

- Ônibus e interfaces

- Redes

- HPC

- Nuvem e COD

- DE

- Ofertas e eventos

- Conclusão

No último relatório sobre o mercado de servidores, a IDC casualmente observou que, em uma base anual, a receita trimestral de vendas de servidores baseados em AMD aumentou 112,4%, e em chips ARM – aumentou 430,5%. Em ambos os casos, podemos dizer que é fácil crescer do zero. Além disso, para ARM, essa afirmação é mais verdadeira do que para AMD, que no meio do ano relatou uma participação de dois dígitos (ou seja, mais de 10%) no mercado de servidores, sem especificar, no entanto, o método de cálculo ou o número específico.

Parte do kernel AMD Zen 3. Foto: Fritzchens Fritz

O lançamento EPYC Roma baseado em Zen 2 da AMD em agosto passado viu uma resposta rápida (para os padrões corporativos, é claro) da Intel. No início de 2020, ela abandonou as versões M de segunda geração do Xeon Escalável (Cascade Lake-SP) e reduziu drasticamente os preços das versões L com suporte para mais memória, o que, no entanto, é mais relevante para sistemas com Optane DCPMM. Bem, alguns meses depois, a empresa lançou os processadores Cascade Lake Refresh, que em geral representam uma reformatação da linha de modelos existente com uma redução de preço múltipla.

O anúncio do Intel Xeon Cooper Lake é significativo apenas para um pequeno círculo de consumidores, uma vez que está longe de ser um produto de massa. Sim, eles têm memória mais rápida, frequências aumentadas, surgiu o suporte para bfloat16 para VNNI, que, segundo a Intel, torna possível usar a CPU não só para inferência, mas também para treinamento. Mas o principal deles é a presença de 6 links UPI, que permitem criar sistemas 4S / 8S perfeitos para plataformas como o HPE Superdome Flex 280 (224 núcleos + 24 TB de RAM). Além disso, essas são as primeiras CPUs com suporte Optane DCPMM (ou simplesmente PMem) na segunda geração do Barlow Pass.

A AMD não fez grandes anúncios este ano: expandiu ligeiramente a linha de EPYCs “comuns” e adicionou a série EPYC 7FX2 com um número relativamente pequeno de núcleos, mas com frequências significativamente aumentadas e cache L3. Além disso, a empresa atualizou sua série EPYC Embedded 3000 e finalmente introduziu o Ryzen Embedded V2000 baseado no Zen 2 – uma grande atualização do V1500. A Intel tem toda uma galáxia de chips na linha de SoCs industriais: Atom x6000E, Pentium e Celeron série N / J, bem como Core i3 / i5 / i7 de 11ª geração (Tiger Lake).

Dos fornecedores alternativos de processadores x86 para servidores, ainda há alguns, com esquemas de licenciamento complexos: VIA taiwanês e Hygon chinês. Na primavera, o chip VIA CenTaur “acendeu” novamente, cujos detalhes foram conhecidos antes. Perto do final do ano, a chinesa Zhaoxin, uma joint venture entre a Shanghai SASAC e a VIA, recebeu algumas patentes de x86 desta última. Após o “divórcio” final da AMD, Hygon permaneceu com Dhyana, clones dos primeiros EPYCs baseados no Zen 1. E sob ameaça de descontinuação da produção da GlobalFoundries prometeu transferir esses CPUs para Samsung 7nm ou tecnologia de processo TSMC, o que parece fantástico.

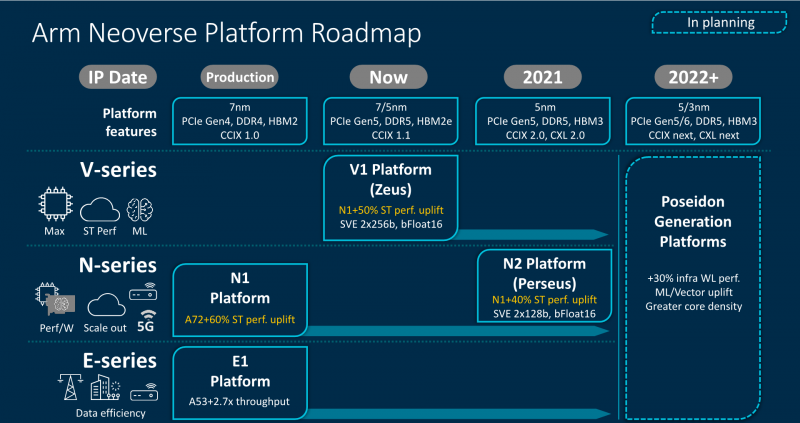

Mas houve muita empolgação no acampamento ARM este ano. No outono, a Arm anunciou os kernels Neoverse V1 Zeus e N2 Perseus, que finalmente têm instruções de Extensões Vetoriais Escaláveis (SVE, analógico do AVX moderno) – na versão básica SVE-256, mas os desenvolvedores SoC podem escolher o comprimento de 128 a 2048 bits – e suporte para bfloat16. O primeiro núcleo é focado no desempenho máximo, mesmo às custas da eficiência energética. O segundo é mais balanceado, mas é justamente isso, segundo Arm, que se tornará o mais demandado devido ao escalonamento fácil do SoC: de 8 a 192 núcleos por dado com um TDP de 20 a 350 W, respectivamente.

A Arm deu outro grande passo, não tanto técnico quanto psicológico, no final do ano, anunciando que mudaria a maior parte de suas tarefas de design (EDA), automação e desenvolvimento para a nuvem AWS. E não apenas para a nuvem, mas para instâncias com processadores ARM Graviton2, para os quais, aliás, a própria Amazon começou a transferir alguns serviços públicos da AWS. E tudo isso aconteceu no mesmo ano em que o legado da Calxeda, o primeiro desenvolvedor de CPU ARM para servidores a acabar por falta de fundos, foi finalmente removido do Linux.

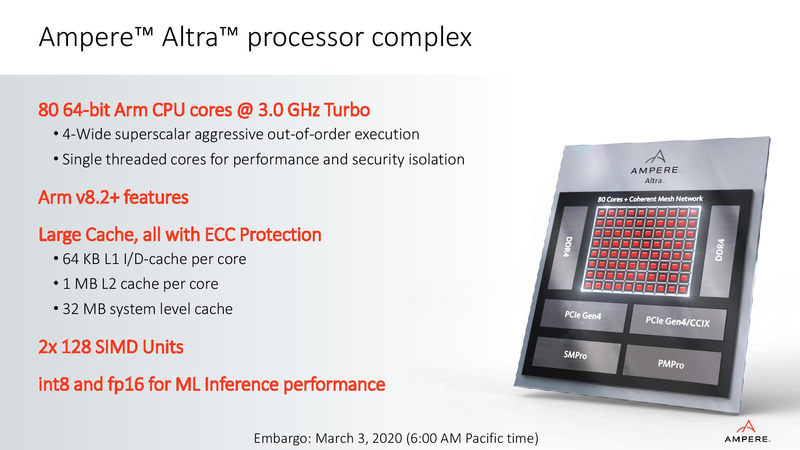

Os produtos notáveis neste segmento incluem processadores Ampere com Altra (até 80 núcleos) e Altra Max (até 128 núcleos). Os primeiros até conseguiram aparecer em várias plataformas, cujos testes inspiram otimismo e esperança por uma competição saudável com o x86-64. Das soluções não mais modernas, mas curiosas, você pode se lembrar da Bamboo. A NUVIA ainda não lançou nada, mas prometeu que o Phoenix vai contornar a AMD e a Intel. A “Baikal Electronics” doméstica não promete nada parecido, mas está desenvolvendo um Baikal-S com 48 núcleos.

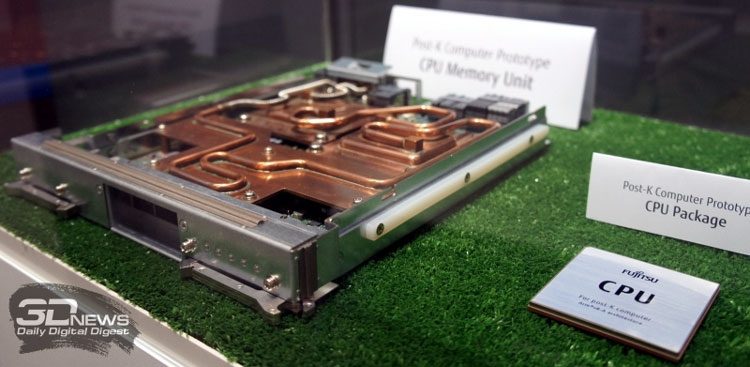

Entre as soluções de HPC baseadas em ARM, lembram-se a CPU européia SiPearl Rhea (72 núcleos), a chinesa Phytium Tengyun S2500 (64 núcleos), bem como a coreana K-AB21, que é um tanto semelhante ao invencível Fujitsu A64FX (48 núcleos). Este último, repetimos, dificilmente pode ser chamado de CPU clássico, já que é conceitualmente mais próximo do Xeon Phi, que finalmente morreu este ano: muita memória rápida a bordo, núcleos padrão e instruções SVE-512 “grudadas” neles na lateral.

Mas não sem perdas! A Marvell de repente desistiu dos muito interessantes ThunderX3s, despedindo a equipe de desenvolvimento quando os processadores estavam prontos. Essa família de CPUs como um todo tem um destino difícil, mas as posições não eram tão ruins: plataformas prontas, parcerias com grandes fornecedores, desenvolvimentos para o ecossistema de software e até mesmo alguns supercomputadores não os mais frágeis. Infelizmente, o destino do ThunderX4 agora está em questão.

O mesmo pode ser dito sobre o desenvolvimento do HiSilicon KunPeng, que se tornou o primeiro processador ARM de 7 nm de 64 núcleos e para o qual a Huawei passou a transferir não apenas seus servidores, mas também outras soluções, por exemplo, sistemas de armazenamento. Na primavera, testamos o sistema TaiShan 2280 v2 com a CPU Kunpeng 920, a mais poderosa da série, e observamos um recurso comum para todas as novas plataformas – não o melhor ecossistema de software, pelo menos no início. Mas a empresa está disposta a gastar dinheiro nisso, bem como no desenvolvimento de parcerias, incluindo a localização da produção de servidores na Rússia.

Uma série de sanções dos EUA ao longo de 2020 negou consistentemente à Huawei o acesso a vários recursos, incluindo a moderna tecnologia de processo TSMC. A empresa fez estoques de chips, mas ainda não está muito claro quanto eles vão durar e como KunPeng, Ascend e outras soluções de servidor Huawei serão desenvolvidas. Não vamos adivinhar, vamos lembrar melhor as arquiteturas de processador mais exóticas ou apenas menos comuns que surgiram no ano passado.

No outono, foram recebidas as primeiras amostras de engenharia do Elbrus-16S, cujo desenvolvimento, juntamente com o Elbrus-12S, deve ser concluído em 2021. E em 2025, atingirá o Elbrus-32C de 32 núcleos. E a novidade mais intrigante é, talvez, o Tachyum Prodigy – os desenvolvedores prometem até 128 núcleos que podem lidar com IA e computação convencional. E os sistemas baseados neles ainda serão capazes de executar binários x86, ARMv8 ou RISC-V (com uma penalidade de desempenho, é claro). Milagre, não arquitetura, mas nicho – como, por exemplo, a arquitetura do mainframe IBM z15.

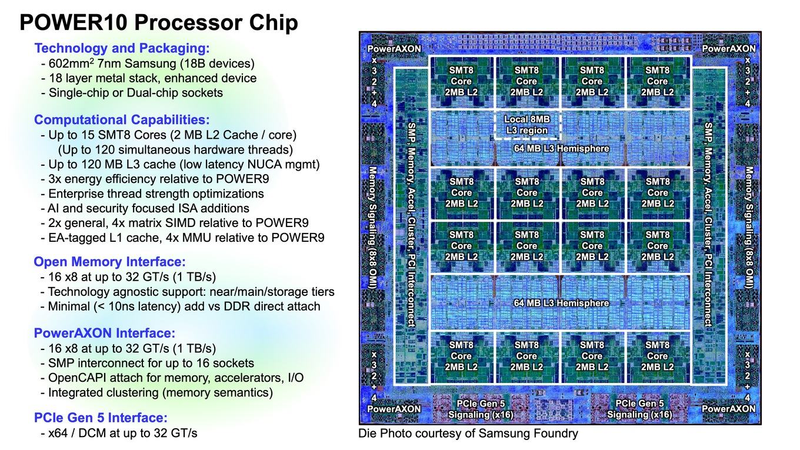

A IBM se destaca um pouco com seu POWER10. Estes são chips muito interessantes, especialmente em relação à memória OMI e barramentos PowerAXON 2.0 e PCI Express 5.0. Mas os sistemas POWER têm uma pequena participação de mercado, e nem a abertura do ISA, nem da organização OpenPOWER contribuíram para seu notável crescimento, embora tenham aberto, por exemplo, para a China a oportunidade de usar os desenvolvimentos da IBM. E parece que o único grande desenvolvedor de chips POWER, além da própria IBM, ainda é a Suzhou PowerCore Technology da China, e o fornecedor do sistema é o Inspur. Mas esses produtos estão mais voltados para o mercado interno.

Algumas pessoas geralmente acreditam que em 2030 apenas as arquiteturas x86-64, ARM e RISC-V serão massivas. Este último está se desenvolvendo rapidamente, mas tudo é muito jovem. E sua abertura pode ajudá-lo e prejudicá-lo até certo ponto devido à fragmentação. Ironicamente, a propósito, o Arm permitiu que os desenvolvedores de chips adicionassem suas próprias instruções (até agora apenas no ARMv8-M). Ou seja, ela fez exatamente o que criticou a RISC-V alguns anos atrás.

Por fim, no ano passado houve muitas novidades sobre a computação quântica, que não vai substituir os sistemas tradicionais, mas vai complementar – esse mercado foi estimado em 20 milhões em 2020 e em 2024 chegará a 30 milhões. A empresa mais intrigante é a IonQ, que em 2023 promete lançar computadores quânticos modulares para montagem em rack. Ela também abriu seu próprio data center quântico e propôs um benchmark para computadores quânticos. A Atos também apresentou sua versão do benchmark universal Q-Score.

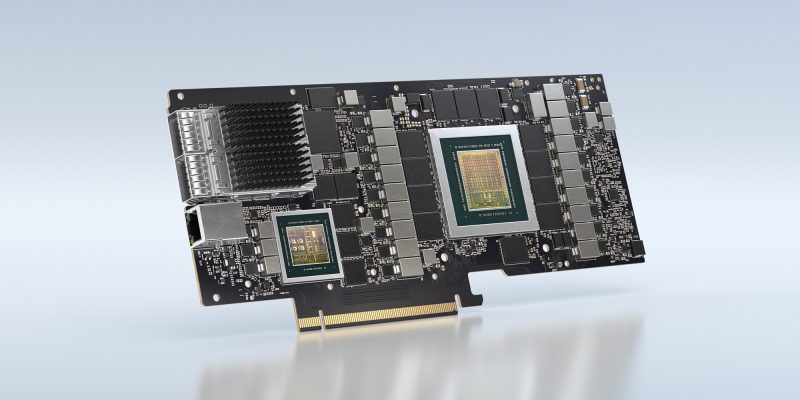

No ano passado, os dois principais fabricantes de GPU introduziram aceleradores que quase não faz sentido chamar de gráficos. A NVIDIA lançou o A100 baseado na arquitetura Ampere – primeiro uma versão SXM3 de 40 GB, depois uma placa PCIe “clássica” e depois uma versão SXM3 de 80 GB. Além de um simples aumento de performance, a característica mais interessante dos novos produtos é o suporte para MIG (Multi-Instance GPU) – capacidade de dividir o acelerador em vários virtuais (até 7 peças) para o aproveitamento mais completo dos recursos. Ao longo do caminho, a empresa também apresentou soluções baseadas nos sistemas A100: DGX / HGX, um projeto de referência do supercomputador DGX SuperPOD for Enterprise e uma estação de trabalho DGX STATION.

A AMD respondeu com o lançamento dos aceleradores Instinct MI100 baseados na nova arquitetura CDNA, que supera o A100 no desempenho do FP64, mas fica para trás no aprendizado de máquina. A Intel revelou formalmente sua primeira GPU de servidor baseada no Xe-LP Quad, mas ela não foi projetada para computação, mas para jogos em nuvem. Entre outros players bem conhecidos, podemos lembrar também a NEC, que não abandonou a ideia dos aceleradores vetoriais e no final do ano lançou a segunda geração do SX-Aurora TSUBASA.

Mas existem muitos aceleradores de aprendizado de máquina. E para treinamento, e principalmente para inferência (você se cansa de listar tudo isso). Entre os representantes mais proeminentes: chip da Cerebras do tamanho de um wafer de silício inteiro; Groq TSP com produtividade de 1 Petaops; processador fotônico Lightmatter; a criação do Tenstorrent, ao qual se juntou Jim Keller, a segunda geração IPU Graphcore Colossus Mk2, que será substituído por chips de 3nm; TPU v4 como parte do supercomputador de IA mais rápido do Google; Kunlun by Baidu finalmente, Habana Gaudi, que a Intel trocou pela Nervana, e o próximo AWS Trainium.

FPGAs também têm tensores e outras unidades de IA. Aqui você pode lembrar, por exemplo, Intel Stratix 10 NX ou soluções com Xilinx Versal AI. EASIC promete ser um elo de transição entre FPGA e ASIC – a Intel apresentou a primeira família N5X este ano. No entanto, refere-se à plataforma para computação de ponta e 5G, que inclui FPGAs e CPUs convencionais (Atom P5900). De modo geral, não se pode deixar de notar um aumento no número de vários tipos de aceleradores que cobrem tipos de problemas mais restritos, mas ainda tentam permanecer flexíveis. Isso levou ao nascimento de uma nova classe de dispositivos: o DPU.

DPU (Data Processing Unit) são (co-) processadores para processamento de dados, se traduzirem o termo literalmente. No entanto, não há uma definição clara para esses dispositivos. O que os une é que eles assumem uma série de tarefas típicas relacionadas a I / O e trabalham com dados: compactação e desduplicação, criptografia, controle de acesso, proteção, transcodificação e outros processamentos de informações. Mas eles fazem isso de maneiras completamente diferentes. E os objetivos também variam – desde o simples descarregamento da CPU até a tentativa de desagregar completamente os recursos, o que a AWS está parcialmente tentando alcançar com o Nitro.

Tais dispositivos, via de regra, possuem memória própria (rápida e / ou espaçosa), mecanismos de hardware para acelerar operações individuais, controladores adicionais, algum tipo de lógica programável (CPU, GPU, FPGA) e rede / interconexão rápida. Tudo isso de uma forma ou de outra estava em outros produtos, os SmartNICs, por exemplo, não foram a lugar nenhum. Em geral, os DPUs estão tentando construir toda a arquitetura em torno dos dados, e não da computação, como costumava ser.

O benchmark agora pode ser chamado de solução Fungible, que geralmente acredita que DPUs em servidores devem se tornar o “terceiro soquete” após a CPU e GPU. O chip F1 oferece dois tipos de interfaces: 8 × 100GbE e 4x PCIe 3.0 / 4.0 x16, e PCIe inclui seu próprio complexo de raiz de 2 partes. O primeiro produto, o sistema de armazenamento FS1600, provou ser muito valioso: 24 NVMe SSDs (até 576 TB) em um chassi 2U produzem 15 milhões de IOPS e 60 GB / s com uma latência de no máximo 110 μs. Ou seja, em média, é várias vezes mais rápido do que os armazenamentos all-flash normais, embora em termos de funcionalidade ainda não os alcance.

Infelizmente, a Fungible visa apenas provedores de nuvem e hiperscaladores. Soluções baseadas em produtos Intel são direcionadas aos mesmos segmentos: Silicom SmartNIC N5010 e Inventec SmartNIC C5020X. Em ambas as placas, a parte da rede é complementada com um FPGA, e a segunda também possui um processador Xeon-D. É ela, apesar do nome, que mais se parece com DPU. A NVIDIA, por outro lado, chama seus novos adaptadores de DPU: BlueField-2 e BlueField-2X são baseados em ConnectX-6 Dx com núcleos ARM e VLIW, e a versão X também é equipada com uma GPU baseada em Ampere. A empresa posiciona essas soluções, inclusive para computação de ponta na plataforma EGX.

Bem, para sistemas de armazenamento com RDMA (GPUDirect Storage), que são capazes de “alimentar” dados DGX / HGX, eles também são necessários. Além disso, as soluções Intel e NVIDIA são compatíveis com o Projeto Monterey da VMware, cuja tarefa é transferir algumas das funções – pelo menos para trabalhar com armazenamento e rede – da CPU para o DPU / SmartNIC. Também inclui uma versão do ESXi portado para ARM. O suporte de um grande fornecedor de software é muito importante para a promoção de ideias de DPU.

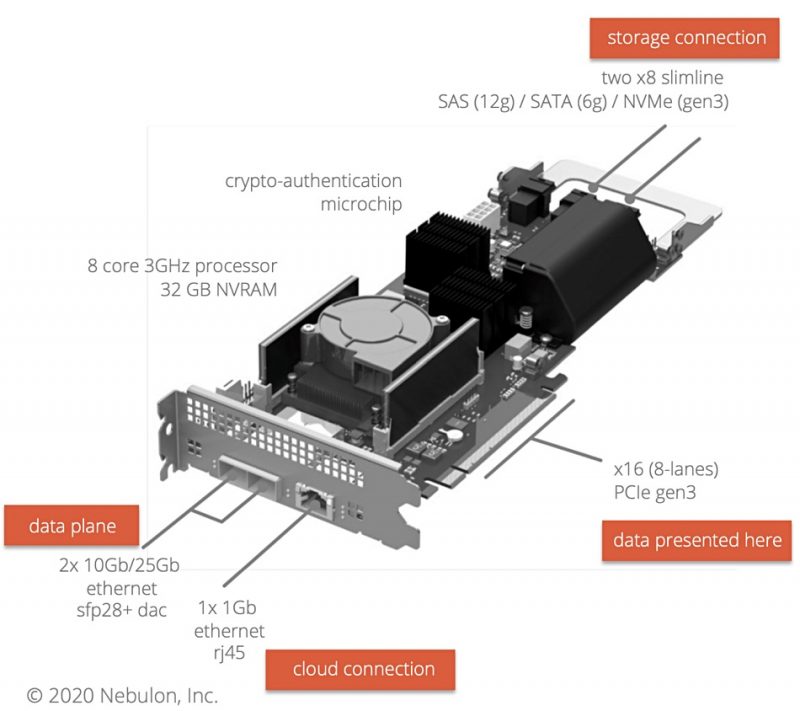

A SPU (Storage Processing Unit) pode ser considerada um tipo de DPU, mas com ênfase no subsistema de armazenamento. No entanto, mesmo aqui, a definição de uma classe de dispositivos é um tanto vaga. Por exemplo, a Nebulon está tentando combinar as funções de um controlador RAID / HBA e SAN: por um lado, possui interfaces SAS / SATA / NVMe, por outro, 2 × 25GbE. Pliops também chama seu produto de Storage Processosor, mas visa uma tarefa bastante estreita de otimizar a operação de um DBMS com um SSD – ele “esconde” uma série de drives atrás de si, fornecendo ao sistema uma interface NVMe.

As SPUs estão relacionadas ao conceito de armazenamento computacional, ou seja, processamento de dados diretamente no local de armazenamento. Não é novo, mas em 2020 surgiram alguns SSDs interessantes: da Samsung e ScaleFlux com FPGA e NGD com chips ARM. A própria Arm apresentou um novo Cortex-R82 SoC especificamente para essas unidades. A UPMEM foi ainda mais longe, incorporando coprocessadores em módulos DRAM, e não pretende desistir – a empresa continua aprimorando a tecnologia.

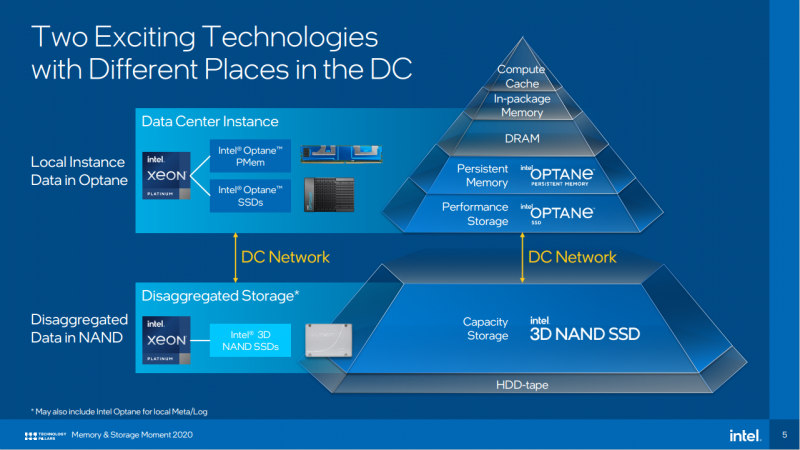

A abordagem reversa – trazer mais memória para perto da CPU – se mostrou mais viável. É claro que isso é sobre o Intel Optane. No verão, a empresa lançou a segunda geração de DIMMs, o PMem 200. É um pouco mais rápido que o primeiro, mas ainda é um componente exclusivo das plataformas Intel. Já dissemos mais de uma vez que a empresa deseja mudar a hierarquia da memória e sua versão mais recente é assim:

Optane (ou outra memória de classe de armazenamento, SCM) complementa a DRAM e ao mesmo tempo é um armazenamento de dados “quentes”. Mas NAND, frequentemente complementado por SCM novamente, se refere mais à “camada fria” junto com HDD e unidades de fita. A Intel prevê que em alguns anos o custo total de propriedade de um SSD será igual, e então ainda menor do que o de um HDD nearline. Ainda é sobre o TCO, e não sobre o custo dos SSDs em si, mas há motivos para tais previsões.

Em primeiro lugar, no final do ano passado, a IDC observou o crescimento do All-flash (AFA) e a queda no mercado de sistemas de armazenamento híbrido (SAN), e essa tendência continuou. No entanto, o que chamar de sistemas de armazenamento híbrido agora é outra questão: no outono, a NetApp apresentou o FAS500f, que formalmente pertence à série FAS, que tradicionalmente incluía sistemas de armazenamento híbrido, mas na verdade é AFA e é baseado em drives QLC. E em segundo lugar: os fabricantes de memória flash estão dominando ativamente a produção de QLC NAND com mais de 100 camadas, o que pode reduzir significativamente o preço e aumentar a capacidade e a densidade.

Sim, o QLC é menos confiável e mais rápido do que o TLC ou ainda mais o MLC, mas há uma resposta para isso – gerenciamento de dados adequado e o próprio flash. Em sua forma mais simples, isso significa usar um cache baseado em memória rápida (Optane SSD ou PMem, por exemplo) com análise de carga e ajuste para ela. Como, por exemplo, no StorONE S1. Mas você pode ir ainda mais longe adicionando compactação e desduplicação em tempo real, bem como otimizando o controlador. Entre os sistemas de armazenamento significativos deste tipo, podemos lembrar Pure Storage FlashArray // C e VAST Data, que prometem capacidades decentes e um preço baixo em combinação com alta velocidade, bem como um módulo Flash Core de nova geração no IBM FlashSystem 9200.

Os últimos são geralmente muito interessantes. Há STT-MRAM para o buffer, cache SLC, um controlador baseado em FPGA personalizado e uma série de outras otimizações. Tudo isso no total, segundo a IBM, permitiu “acabar” com as características do QLC ao nível do TLC. Outros fabricantes desenvolverão soluções semelhantes, mas não necessariamente da mesma maneira. Isso será ajudado pelo novo padrão NVMe 2.0, que agora está em desenvolvimento e alguns dos recursos dos quais já estão em versões anteriores. Ele se concentra em arquiteturas de armazenamento modernas e possui dois recursos principais.

O primeiro é o suporte obrigatório na versão básica do NVMe-over-Fabric (NVMe-oF), a transmissão de comandos NVMe pela rede e a abstração da camada de transporte. Ou seja, o NVMe não está mais estritamente vinculado ao PCIe e está tentando se tornar uma interface única para qualquer dispositivo de armazenamento. Na verdade, os sistemas de armazenamento NVMe-oF não são mais surpreendentes, mas geralmente ainda são hosts com uma CPU, cujas linhas PCIe são divididas por meio de switches entre SSDs e adaptadores de rede ou DPUs (ver Pavilion Data, por exemplo).

Mas você pode ir ainda mais longe e agora montar o adaptador e NVMe-oF diretamente nas unidades, que é o que Kioxia e Samsung fizeram. Para criar arrays JBOF, um switch Ethernet será suficiente com eles, o que, no entanto, também cria dificuldades adicionais. Bem, se você precisa abstrair ainda mais, o conjunto NVMe 2.0 também inclui uma especificação para unidades de valor-chave. É provável que outras extensões apareçam, por exemplo, para acesso a objetos. No entanto, mesmo sem quaisquer acréscimos, o NVMe pode transformar a aparência do SAN para que 64GFC possa se tornar a última versão em massa do Fibre Channel (embora haja também uma implementação de NVMe-oF sobre FC).

A segunda característica do padrão é o zoneamento, que já se tornou parte do NVMe 1.4 e foi incorporado ao Ultrastar DC ZN540. Em termos gerais, implica transferir a lógica de trabalho com memória flash do controlador de armazenamento para o host, o que permite aumentar a durabilidade, velocidade e previsibilidade do trabalho, mas impõe uma série de restrições. No futuro, esses dois recursos fornecerão suporte para SMR HDDs, para os quais o zoneamento também é mais do que relevante, bem como para QLC. E ambas as tecnologias (QLC e SMR) estão conosco agora, aparentemente, há muito tempo.

Os novos desenvolvimentos incluem X-NAND, que promete combinar densidade QLC e velocidade SLC. Uma alternativa à memória 3D XPoint, para a qual, aliás, a Micron prometeu assumir, só podem ser variações de SLC (Z-SSD e XL-Flash) e, em menor medida, MRAM, que é ativamente perseguida por Everspin e IBM. Também há novidades no extremo oposto do espectro da memória. Foi apresentado o padrão LTO-9, que permite criar dispositivos com menos capacidade do que o esperado: 18 TB em vez de 24. Mas, no futuro, dobrar o volume a cada nova geração continuará. Nos experimentos, a capacidade da “fita” foi elevada para 580 TB.

Entre as inovações de produto, não se pode deixar de lembrar o Intel P5800X – o SSD mais rápido do mundo no momento – e o Nimbus ExaDrive NL (3,5 “SATA / SAS, 64 TB QLC), um dos SSDs mais espaçosos, além do modelo de 100 TB. ExaDrive DC da mesma empresa. Mas essas unidades Nimbus são soluções muito específicas que estão tentando substituir o HDD nearline, que atingiu 20 TB este ano. É esse tipo de unidade que ajudará a manter o mercado de discos rígidos à tona em um futuro próximo.

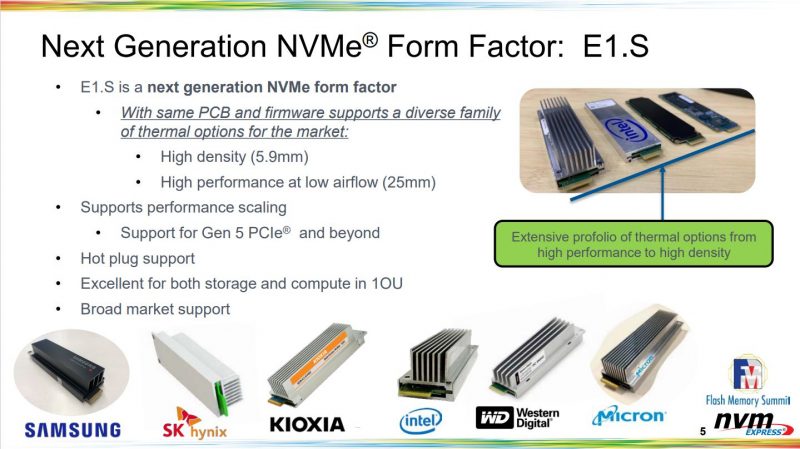

Finalmente, outra mudança importante diz respeito ao fator de forma – no ano passado, quase todos os fabricantes introduziram drives EDSFF. Em primeiro lugar, E1.S e E1.L. Os primeiros estão substituindo o M.2, que, aparentemente, terá apenas a função de boot, enquanto o último, junto com o E3.S, tentará deslocar o U.2. Em ambos os casos, estamos falando de mais flexibilidade ao escolher entre desempenho / dissipação de calor e capacidade / densidade. Os “roteadores” E.1L já permitem obter cerca de 1 PB de capacidade “bruta” em um chassi de 1U e podem ser complementados com DPU / SPU, e o E1.S pode ser usado não apenas para SSDs, mas também para aceleradores. Tudo isso agora é mais relevante para hiperscaladores, mas provavelmente também os veremos em sistemas corporativos.

Uma das tendências principais e mais do que esperadas em 2020 é o crescimento do ecossistema PCI Express 4.0. Muitos componentes surgiram: controladores, switches, adaptadores, drives e até fábricas. Mas isso é apenas o começo, pois o suporte a PCIe 4.0 se tornará muito mais relevante com o lançamento da próxima geração do Intel Xeon. No entanto, agora existem componentes funcionais do PCIe 5.0, e o PCIe 6.0 pode ser lançado já no próximo ano.

O PCIe 5.0 é interessante não por si só, mas como base para o padrão Compute Express Link (CXL), que este ano cresceu para a segunda versão e “fez amizade” com o padrão Gen-Z. Ambos redefinem a forma como os dispositivos se comunicam entre si para uma troca de dados e desagregação de recursos mais eficientes. No entanto, é muito cedo para falar sobre o suporte em massa para CXL 1.1 e PCIe 5.0. Bem como sobre o DDR5, cujos primeiros módulos surgiram em 2020.

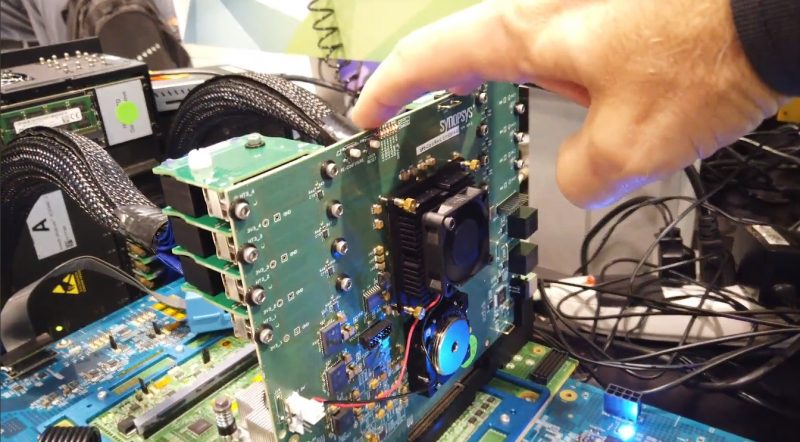

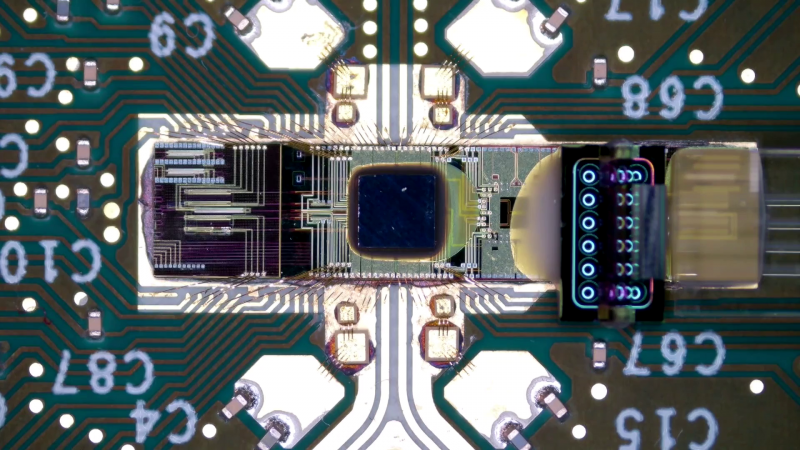

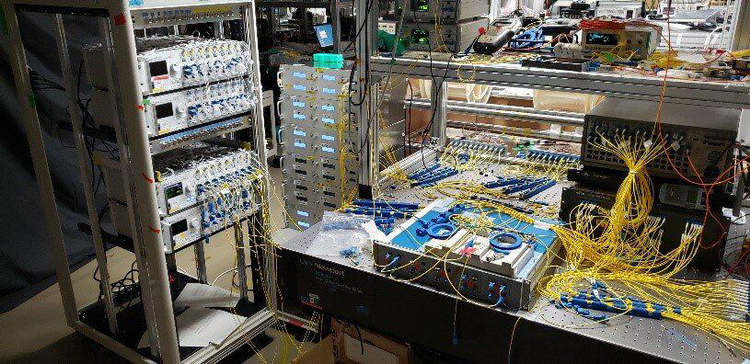

Infelizmente, mais cedo ou mais tarde, as interfaces elétricas não serão mais eficientes o suficiente, por isso grandes empresas já estão desenvolvendo soluções no campo da fotônica de silício integrada, que enfrenta o problema de redução do custo de produção (sem o uso de germânio ou índio, por exemplo) e integração com a eletrônica convencional. E para que tudo isso se encaixe nos processos tecnológicos de massa.

E em 2020, houve progresso nesta área. Em dezembro, a Ayar Labs anunciou o desenvolvimento do processo GlobalFoundries de 45 nm para wafers de 300 mm. Um pouco antes, a NVIDIA falou sobre a possibilidade de usar fotônica para combinar aceleradores em grandes clusters. A Intel conseguiu relatar seus sucessos atuais, sua visão do futuro e mostrou seu primeiro switch com transceptores ópticos de 400 Gbps integrados.

O switch Intel mencionado acima inclui o Tofino2 ASIC. É uma de uma série de soluções de 12,8 e 25,6 Tbps lançadas este ano, abrindo caminho para switches massivos de 200/400 GbE ou 800 GbE como o Xsight Labs, um novo player no mercado. Os analistas prevêem um aumento acentuado na demanda por modelos de 400GbE de hiperscalers e outras grandes operadoras de data center nos próximos anos. Outra tendência está se afastando do “silício” proprietário e popularizando NOS de código aberto como Cumulus (comprado pela NVIDIA), SONiC, Nokia SR Linux ou DentOS fresco.

O consórcio industrial 25G Ethernet Consortium já foi renomeado como Ethernet Technology Consortium e publicou a primeira versão das especificações 800GbE na primavera. No entanto, as portas de 25 GbE ainda são comuns e o máximo que a maioria dos fornecedores pode oferecer agora são adaptadores de 200 GbE – novamente devido às restrições PCIe. NDRs InfiniBand 400G já precisarão de 32 pistas PCIe 4.0 ou 16 pistas 5.0. A mesma quantidade será necessária para as gerações futuras do Omni-Path repentinamente renascido.

Se falamos de registros de velocidade absoluta, então em 2020 o NICT se distinguiu novamente: 172 Tbit / s para um cabo de fibra óptica multi-core com comprimento de 2040 km, 1 Pbit / s para uma fibra multimodo de 23 km e 10,66 Pbit / s para um cabo de 38 núcleos fibra multimodo com 13 km de comprimento. É verdade que a fibra não padrão é necessária para resultados de pico, por isso é muito mais interessante atingir velocidades de “apenas” 800 Gbps em um link “ao vivo”. Além disso, não se esqueça da fibra “escura” já depositada, que não vai a lugar nenhum nos próximos anos e cuja importância só vai crescer.

O segmento wireless pelo número de anúncios em 2020 foi liderado pelas tecnologias Wi-Fi 6 (E) e 5G. Ambos são interessantes não tanto para altas velocidades e baixas latências, mas para um aumento na densidade e capacidade, o que é importante para IoT, IIoT e agora também AIoT. Além disso, o 5G pode substituir parcialmente o Wi-Fi – por exemplo, ao criar redes privadas. Além disso, o 5G impulsionou o desenvolvimento de MVNOs empresariais e industriais e, claro, computação de ponta. Infelizmente, isso ainda não preocupa a Rússia – o 5G ainda é muito pequeno e a certificação do Wi-Fi 6 começou apenas em agosto do ano passado.

De acordo com as previsões, o mercado de ponta crescerá para 50 bilhões até 2024, e um total de US $ 1 bilhão será investido nele em 10 anos. As telecomunicações e as nuvens terão um papel importante nisso – tanto o primeiro quanto o segundo escalão. Os principais participantes já oferecem várias soluções complexas para monetização 5G – de CDN simples a análises e outros serviços em tempo real. Os centros de dados modulares e micro estão se tornando mais relevantes. Mas, em geral, tudo isso está mudando o cenário da rede (os provedores de nuvem já adotaram as comunicações por satélite), confundindo os limites e exigindo mais automação, telemetria e proteção.

Isso se aplica a redes locais e globais. Mas, como prevê a MTN Consulting, em 2025 a própria estrutura desta mudará significativamente: provavelmente será difícil para as telecomunicações tradicionais sem cooperação com os hiperscaladores. Sua receita até o final de 2020 cairá sensivelmente e as despesas crescerão. Isso é parcialmente responsável pela pandemia, que gerou picos de tráfego de curto prazo de até + 30%, mas com o tempo seu crescimento voltou ao normal. E o tráfego móvel, segundo a Ericsson, cresceu, mas seu crescimento se manteve dentro da faixa normal e até os picos de 2018-2019. tão distante.

As classificações TOP500 de junho e novembro estabeleceram um anti-recorde para o número de carros novos este ano. Mas temos um novo líder em várias disciplinas ao mesmo tempo – o supercomputador Fugaku. O motivo disso – é explicado na análise do mercado de HPC do Intersect360. Mas, em resumo, devido à pandemia, muitos projetos foram adiados ou cancelados, e parte da carga de trabalho mudou e será transferida para a nuvem. Muitas capacidades, incluindo Fugaku e outros supercomputadores, incluindo os russos, foram utilizadas na luta contra o coronavírus no ano passado.

No final do ano, veremos o aparecimento do primeiro computador ex-flop – será o Frontier, não o Aurora – e posteriormente uma série de outras máquinas superpoderosas. Muitos desses gigantes serão construídos pela HPE, que agora é líder e fortaleceu significativamente sua posição após adquirir a SGI e a Cray, e muitos usarão as novas soluções da AMD. Em geral, a primeira onda de sistemas exascale de comissionamento deve começar já em 2022-2023.

Observamos separadamente o fato óbvio – os sistemas HPC estão se tornando cada vez mais heterogêneos. Portanto, para simplificar o desenvolvimento para eles, a Intel e a AMD introduziram as plataformas oneAPI e ROCm 4.0, respectivamente, que tornam mais fácil escrever um único código para rodar em CPU, GPU, FPGA e outras arquiteturas de computação. Ambos, a propósito, oferecem a capacidade de portar aplicativos CUDA.

Ao contrário de muitos outros mercados que apresentaram crescimento e declínio em meio à pandemia, os mercados de data center e nuvem estabeleceram um recorde após o outro no ano passado. As fusões e aquisições (F&A) de data centers sozinhas foram responsáveis por quase 1 bilhão, e a demanda por novo espaço é tão grande que o espaço está sendo alugado em data centers ainda não concluídos. Hyperscalers gastou um total de 9 bilhões em investimentos de capital em três trimestres e abriu mais 26 centros de dados ultra-grandes. Ao mesmo tempo, os provedores de nuvem estão expandindo muito rapidamente a geografia de sua presença, abrindo cada vez mais novas regiões, mas o mercado de colocation ainda é bastante centralizado, mas as operadoras estão ativamente estabelecendo conexões com as nuvens.

Ao mesmo tempo, por um lado, os provedores estão tentando atrair novos clientes com a ajuda de uma variedade de opções de nuvem híbrida. Os hosts bare-metal e a computação confidencial estão disponíveis para os mais exigentes. Por outro lado, os fornecedores tradicionais estão cada vez mais oferecendo soluções HCI, soluções de assinatura e, novamente, a capacidade de integração com várias nuvens públicas ao mesmo tempo (vimos claramente que eles também podem “mentir” por várias horas), e isso se tornou muito relevante.

Na verdade, as “Big Four” tiraram o máximo proveito disso – o crescimento da receita foi de 40% ano a ano (o líder ainda é AWS). E a IDC prevê o volume de trilhões para todo o mercado de nuvem até 2024. Na Rússia, para efeito de comparação, segundo o IDC, só atingiu a marca do bilhão em 2019, mas em nosso país a pandemia impulsionou seu crescimento. Embora as especificidades locais sejam tais que IaaS está crescendo mais rápido (e mais rápido do que o mercado de TI em geral), enquanto no mundo eles são gastos principalmente em SaaS e, em menor grau, em PaaS. Além disso, no contexto da pandemia, o segmento DaaS cresceu drasticamente. Além disso, os clientes russos, se a lei não exigir o contrário, usam nuvens estrangeiras de boa vontade, que não têm pressa em implantar diretamente regiões ou zonas na Federação Russa.

A pandemia também destacou vários pontos importantes. Em primeiro lugar, ficou claro que as ferramentas de gerenciamento de data center remoto foram desenvolvidas de forma insuficiente, o que, como no caso das redes, levaria a um aumento nas ferramentas de automação, telemetria e proteção. Em segundo lugar, em muitos países, os data centers foram finalmente reconhecidos oficialmente como instalações de infraestrutura crítica.

E em 2020, os operadores de data center e os envolvidos conversaram ativamente sobre como cuidar da natureza. Muitos dos principais participantes têm planos formais para reduzir sua pegada de carbono a zero e de forma sustentável até o final da década. Isso geralmente implica em uma mudança para fontes de energia renováveis e verdes, resfriamento aprimorado, recuperação de calor residual, melhorias gerais de eficiência energética, reutilização de equipamento e assim por diante. Em alguns países, essas medidas devem se tornar obrigatórias para os centros de dados. Mas ainda há alguma astúcia nisso.

Por exemplo, no projeto Switch para combinar uma usina de energia solar e baterias Tesla MegaPack, é mais importante para a empresa que ela receberá uma fonte de energia independente excluída do sistema de energia geral. O Google agora também está experimentando substituir geradores a diesel por baterias, e a Microsoft está procurando células de combustível de hidrogênio, mas a razão é que essas tecnologias são mais baratas e confiáveis. A produção de baterias, hidrogênio e painéis também não é muito ecológica. Além disso, as três grandes nuvens, por exemplo, ainda compram RECs, incluindo “untethered”, que lhes permite reivindicar 100% do uso de energia renovável.

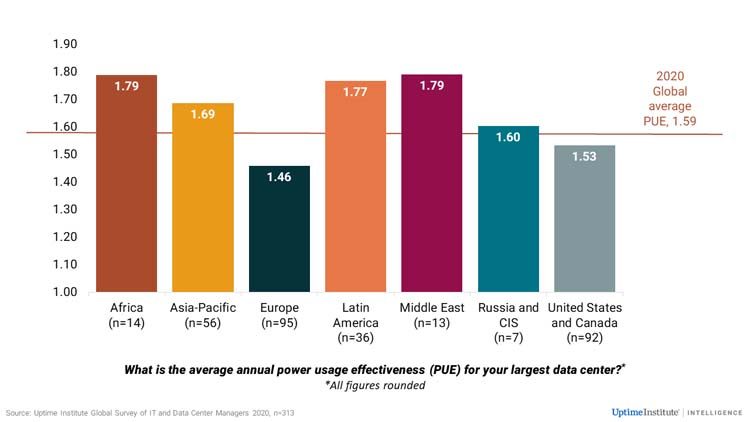

O retorno do calor residual à rede de aquecimento permite que você pense menos sobre sua utilização. Melhorar a eficiência energética é, por si só, economicamente benéfico a longo prazo. Mas se o PUE do Google está em torno de 1,1, em todo o mundo esse valor é em média de 1,59 e seu declínio diminuiu. Globalmente, o consumo de energia do data center ainda é responsável por apenas 1%, mas essa desaceleração na PUE pode mudar o quadro. Além disso, existem outros aspectos também. O Greenpeace, em particular, critica as grandes nuvens por cooperarem com empresas de petróleo, cujas atividades neutralizam em parte todos os esforços das nuvens para serem mais “verdes”. E grandes data centers, como fábricas reais, além de eletricidade, também requerem muita água.

O ano terminou de forma ruim – com a identificação de um dos ataques mais significativos à SolarWinds, cujas consequências nos “deliciarão” por muito tempo. Este não é o primeiro grande ataque à cadeia de suprimentos, e o ano também começou com a divulgação do incidente da Citrix. Infelizmente, não haverá menos ataques desse tipo no futuro – a aceleração da transformação de TI das empresas devido à pandemia não as torna mais seguras. Em geral, 2020 se tornou um ano recorde em termos de número de vulnerabilidades identificadas.

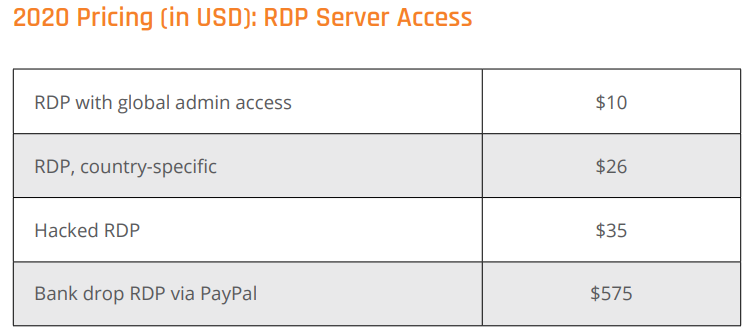

A transição para “remoto” provocou, por um lado, um aumento dos ataques aos serviços de colaboração e, por outro, um aumento dos ataques ao RDP e outros serviços de acesso remoto. Portanto, os fabricantes são forçados a desenvolver soluções para proteger essa força de trabalho distribuída. A tendência dos cibercriminosos de usar ferramentas legítimas também continuou, dificultando a detecção de ataques.

Outro desastre de 2020 é o surgimento de ransomware e ransomware, especialmente nos setores industrial e médico. Isso levou a um aumento nas ofertas de backup e recuperação. Neste contexto, os preços subiram na darknet e surgiram novos serviços. Por fim, o crescimento das nuvens também levou ao desenvolvimento ativo de meios de sua proteção – por exemplo, a startup Lacework recebeu investimentos no valor de 25 milhões e agora está estimada em mais de um bilhão. Muitas vezes há um problema com configurações incorretas e, como resultado, vazamentos de dados.

Ao mesmo tempo, as próprias nuvens também estão mudando e oferecem cada vez mais soluções gerenciadas e sem servidor. Eles estão prontos para abrigar sistemas “antigos”, mas estão pressionando os desenvolvedores a criar software nativo da nuvem, o que na maioria das vezes significa usar contêineres. Uma linha separada deve ser notada o surgimento de suporte para cargas VMware em grandes nuvens e, ao mesmo tempo, a unificação do suporte para virtualização e conteinerização nos produtos da própria VMware.

Em geral, a atividade em torno dos contêineres é muito alta agora. Eles ajudarão a IBM a implementar a estratégia de nuvem e a SUSE, depois de abandonar o Openstack, comprou o Rancher Labs para o mesmo propósito. O Kubernetes, a plataforma mais popular para gerenciamento de contêineres, finalmente mudou para o CRI, o que o torna mais aberto. Um efeito colateral é que a função do sistema operacional como tal é um pouco reduzida, uma vez que a distribuição de software está gradualmente mudando para imagens prontas para VMs ou contêineres, e a orquestração se torna mais importante.

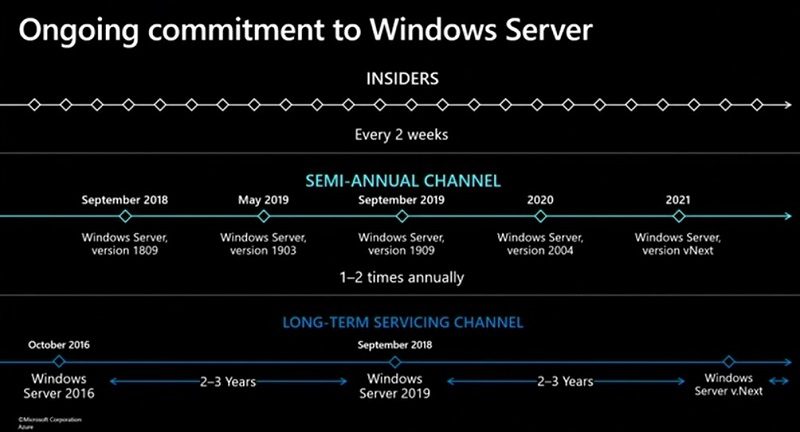

Havia poucas notícias do mundo do SO, além dos lançamentos regulares, mas dois deles são importantes. Em primeiro lugar, a Microsoft, apesar da aposta na nuvem, mais uma vez confirmou que não vai abandonar o Windows Server e que tem planos para, pelo menos, três grandes lançamentos, o primeiro dos quais será lançado em 2021. Em segundo lugar, a Red Hat abandonou o desenvolvimento do CentOS em sua forma usual e vai torná-lo, de fato, uma versão beta eterna do RHEL.

As explicações da empresa por que tomou tal medida não foram muito convincentes para a comunidade, e as propostas de alternativas apareceram quase imediatamente após o anúncio: o fundador do CentOS apresentou o projeto Rocky Linux, o CloudLinux anunciou o Lenix e a Oracle novamente lembrou a todos que seu fork baseado em RHEL é gratuito. Outros possíveis candidatos para substituir o CentOS incluem Springdale Linux e ClearOS. É improvável que a Red Hat abandone o novo CentOS Stream, mas ainda pode revisar sua política de licenciamento RHEL.

Entre outros eventos importantes, destacamos os importantes lançamentos do kernel Linux 5.8 e 5.10 – o primeiro tornou-se o maior em termos de número de alterações, e o segundo, também bastante grande, trouxe suporte para “hardware” novo, que aparecerá em grandes quantidades no mercado este ano. Ao mesmo tempo, decidiu-se estender o suporte para vários lançamentos de kernel LTS antigos. Desde as pequenas coisas: uma versão unificada para Linux e FreeBSD do OpenZFS 2.0.0 foi lançada, suporte completo para NTFS no kernel está sendo preparado e o Wireguard rapidamente se fundiu nos ramos principais do Linux, FreeBSD, OpenBSD, NetBSD e kernels Android, o que abre a oportunidade para se tornar o padrão de fato para muitas VPNs. Infelizmente, as “velhas feridas” de Spectre e outras vulnerabilidades semelhantes não cicatrizaram completamente.

Os lançamentos GCC 11 e LLVM 12 têm uma habilidade muito útil para contabilizar as diferenças nos conjuntos de instruções x86-64 para uma otimização mais eficiente. E o RHEL 9 planeja aumentar os requisitos mínimos para x86-64-v2. Esta é uma troca entre o desejo de melhorar o desempenho e o desejo de manter a compatibilidade com uma ampla gama de plataformas de hardware. Ou seja, para permanecer o mais versátil possível, ao contrário, por exemplo, do Intel Clear Linux, que continua liderando em desempenho.

No outono, aconteceu o maior IPO da história de uma empresa de software – Snowflake foi estimado em 3,6 bilhões, e agora sua capitalização cresceu para 5 bilhões. Não só o valor é interessante aqui, mas também a especialização: a empresa oferece um data warehouse na nuvem. Outro IPO recorde não ocorreu – Kioxia esperava receber cerca de 9 bilhões, mas adiou a colocação. Talvez aconteça este ano. Bem como o IPO da SUSE, para o qual tem potencial para se tornar um caminho para a independência.

Entre os negócios de M&A, os principais, é claro, são a aquisição da Arm pela NVIDIA por US $ 0 bilhão e a aquisição pela AMD de um grande desenvolvedor de FPGAs, Xilinx, cujos ativos são estimados em US $ 5 bilhões. O primeiro negócio atraiu muita atenção dos reguladores do Reino Unido e da China, mas a NVIDIA está confiante em sua aprovação e promessas desenvolver Arm. Em terceiro lugar está talvez a aquisição de US $ 0 bilhões pela Marvell do desenvolvedor de rede Inphi, que se acredita refletir uma mudança nas prioridades e fazer com que o ThunderX seja abandonado. O maior negócio na Rússia até agora é a compra da IKS Holding pela USM holding por 17 bilhões.

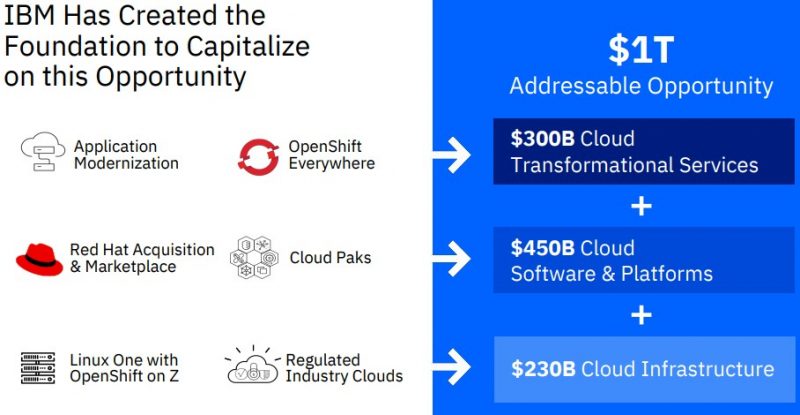

Mas as empresas não apenas se fundiram, mas também se separaram. O principal acontecimento desse tipo é a saída da IBM de quase toda a divisão de Global Technology Services, que presta diversos serviços relacionados à infraestrutura de clientes. E a IBM e a Red Hat se concentrarão na construção de uma nuvem híbrida de US $ 1 trilhão. Essa reestruturação, conforme o esperado, levará à redução de pessoal. E neste ano podemos esperar um evento ainda mais significativo – a divisão da VMware em uma empresa separada.

Segurança e resiliência, automação e IA, 5G e sistemas distribuídos – temas diretamente relacionados à transformação digital, continuarão relevantes em 2021. Infelizmente, o principal será a segurança, tanto virtual quanto física. A transformação levará a uma maior dependência do setor de TI, que tentará se tornar mais amigável em resposta. O cliente será cada vez menos importante no hardware e software específicos em que o serviço se baseia. E esta é uma grande chance para novos jogadores derrotarem os ex-gigantes. Mas a transformação abrigará uma complexidade cada vez maior – e aqui nos apresentará as principais surpresas no futuro.

Para não perder nada no ano novo, siga-nos no Twitter, Telegram, LinkedIn ou Zen.