O aumento do uso de NVMe em infraestrutura de nuvem pública e privada facilitou uma transição gradual da arquitetura de data center verticalmente escalável para a chamada commodity, isto é, para o uso de sistemas de scale-out não especializados e prontos para uso, que tem permitido que novos paradigmas de computação distribuída sejam implementados.

A evolução das especificações e recursos de armazenamento NVMe ™ destacou questões relacionadas à eficiência, escalabilidade e taxas de utilização. A busca por soluções para os problemas acima criou as pré-condições para o surgimento de uma tecnologia mais nova – NVMe-over-Fabrics ou NVMe-oF ™ para breve. Vamos dar uma olhada nas possíveis implicações de sua aparência nas arquiteturas de sistema.

Conforme observamos o mundo ao nosso redor, notamos consistentemente um aumento na quantidade de dados criados e consumidos. O crescimento no volume de dados e o consequente aumento na complexidade dos aplicativos aumentam significativamente a importância de onde, quando e como as informações são armazenadas e processadas.

Blog.westerndigital.com

As infraestruturas de TI tradicionais são principalmente estáticas. Eles foram projetados para lidar com cargas de trabalho extremas ocasionais (não necessariamente em uma base diária). A infraestrutura de tais sistemas deve ter sempre uma certa margem de segurança e incluir uma frota de equipamentos “para crescimento”. No entanto, essa abordagem geralmente se resume ao crescimento de toda a infraestrutura como um todo: um aumento no poder de computação também leva a um aumento no armazenamento e na memória, largura de banda da rede, etc. independentemente de ser realmente necessário.

Com essa abordagem, os sistemas desenvolvidos no paradigma de aumento de escala anteriormente dominante frequentemente permanecem subutilizados. O equipamento instalado não é totalmente utilizado e alguns sistemas ficam completamente ociosos na maior parte do tempo.

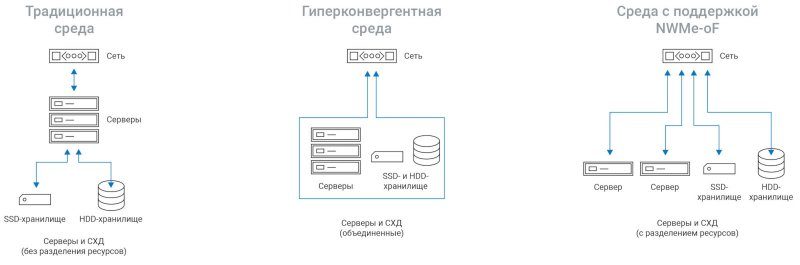

Os sistemas modernos com dimensionamento horizontal (scale out) permitem que você aumente simultaneamente a capacidade de computação, a memória e o armazenamento. Os sistemas virtualizados permitiram provisionamento e compartilhamento flexíveis de recursos. Os sistemas hiperconvergentes (HCI) deram o próximo passo, permitindo que o armazenamento seja compartilhado e compartilhado em toda a infraestrutura (consulte a Figura 1). No entanto, apesar do aumento da flexibilidade e adaptabilidade, essa abordagem não permite que todos os recursos da infraestrutura em si sejam dimensionados de forma independente.

FIG. 1 – Ambientes: Tecido tradicional, hiperconvergente, em rede

Portanto, no processo de criação de arquiteturas mais eficientes que possam lidar com o aumento do volume e da complexidade dos dados, houve a necessidade de uma infraestrutura de dados mais flexível e escalonável. Como os data centers hiperescalador, os data centers corporativos e em nuvem de amanhã devem ser escalonados independentemente de três componentes críticos da infraestrutura: computação, memória e armazenamento.

Para que os componentes sejam escalonados independentemente uns dos outros, a capacidade de computação, a memória e o armazenamento devem ser isolados uns dos outros e conectados por meio de algum tipo de rede. No entanto, para garantir o desempenho ideal, tal rede, ou melhor, a malha de rede, deve ser o mais discreta possível, ou seja, não deve ter grandes custos indiretos associados, por exemplo, com trânsito de dados ou atrasos no nível do protocolo.

No mundo do armazenamento, a noção de uma fábrica não é radicalmente nova. Há muito tempo, o suporte para SCSI sobre Ethernet e Fibre Channel foi implementado, e as SANs ganharam popularidade devido à sua alta velocidade e confiabilidade de transferência de dados.

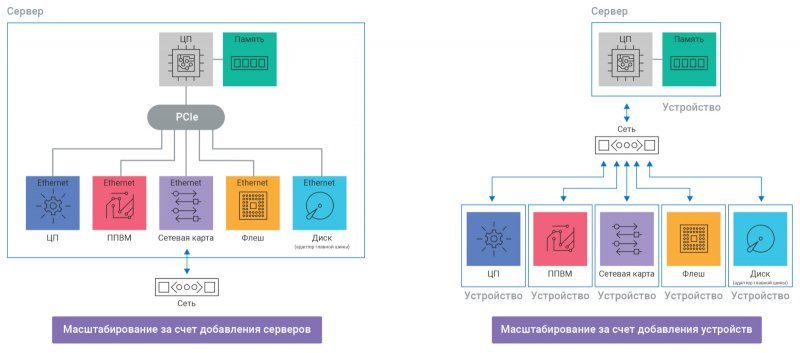

FIG. 2 – Sistema de expansão versus infraestrutura desagregada compostável

No entanto, com NVMe-oF, novas infraestruturas desagregadas podem separar recursos de computação e armazenamento uns dos outros. Além disso, tanto o nível de desempenho é preservado – a velocidade de trabalho com o armazenamento é a mesma da conexão direta dos drives NVMe – quanto o acesso compartilhado aos dados com alto nível de paralelismo.

Além disso, o uso de fábricas de rede em infraestruturas desagregadas permite expandir as capacidades de sistemas composíveis, ou seja, aqueles onde você pode facilmente usar quaisquer recursos de hardware necessários através da orquestração de software, o que simplifica a (re) configuração de sistemas para tarefas específicas.

Uma variedade de configurações de hardware e recursos de rede estão disponíveis para criar uma arquitetura adaptável, flexível e desagregada que pode ser dimensionada de forma independente, enquanto oferece alto desempenho.

O padrão de transferência de dados NVMe é um protocolo de comunicação não apenas entre uma unidade flash e um controlador de armazenamento, mas também, em fábricas em rede, entre um host e um controlador de armazenamento. A única questão é como implementar tudo isso.

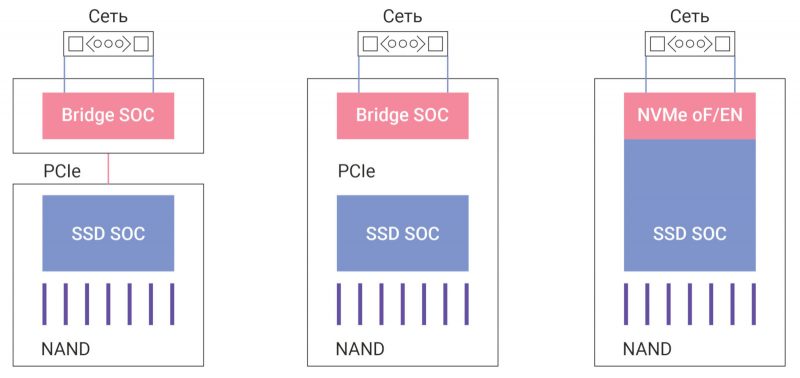

Uma maneira é adicionar conectividade de rede diretamente aos dispositivos de armazenamento (Figura 3). Quando conectado diretamente à malha de rede via PCIe, Ethernet ou Infiniband, os drives NVMe podem suportar protocolos de baixa latência, abrindo a porta para novos sistemas desagregados. No entanto, esta abordagem levanta várias questões tecnológicas interessantes:

FIG. 3 – Conectando dispositivos de armazenamento à estrutura de rede

Considerando as diferentes opções de controladores, devemos avaliar a função do SSD no sistema, levando em consideração suas capacidades e características de memória flash. Deve, por exemplo, trazer um SSD com conectividade de rede integrada para o mercado? Em caso afirmativo, como as responsabilidades para lidar com o tráfego de rede serão distribuídas entre o SSD e a malha de rede? Como isso afetará o software host, a proteção de dados e o gerenciamento de armazenamento?

Ao estudar essas questões, devemos também prestar atenção ao aumento da eficiência dentro do quadro da nova arquitetura, em particular, a transferência de algumas tarefas da CPU para outros núcleos computacionais disponíveis. Nossa abordagem para integrar várias características de malhas e núcleos de rede com dispositivos de armazenamento pode ser o ponto de partida para um novo paradigma de computação com NVMe-oF.

Um exemplo de implementação de NVMe-oF é a plataforma de armazenamento Western Digital OpenFlex Data24, que permite que você use totalmente a largura de banda de um SSD Ultrastar NVMe de uma vez por vários nós de computação combinados em uma malha Ethernet (NVMe-oF 1.0a) com baixo latências.

O sistema em um fator de forma 2U inclui até 24 NVMe Ultrastar DC SN840 SSDs com capacidades de até 368 TB. De acordo com os testes de laboratório conduzidos pela Western Digital, o desempenho do OpenFlex Data24 com seis adaptadores de rede é de aproximadamente 13,2 milhões de IOPS, taxa de transferência de 70,7 GB / s e latência de gravação de apenas 42 μs.

O OpenFlex Data24 é compatível com a API Open Composable e pode ser implementado como parte de uma infraestrutura desagregada combinável. A implementação do OpenFlex Data24 não acarreta custos adicionais. Por outro lado, a Western Digital estima uma economia de custo de 17% em relação aos DAEs baseados em SAS.