A tecnologia NVMe-over-Fabrics (NVMe-oF) tomou seu lugar firmemente em sistemas de armazenamento de desempenho. No caso do NVMe / TCP, a Fungible declarou um recorde mundial, que usa seu DPU proprietário em matrizes flash FS1600 – recebeu 10 milhões de IOPS em operações aleatórias, enquanto sem DPU conseguiu atingir apenas 6,55 milhões de IOPS com uma carga completa de um Servidor de 128 núcleos … A NVIDIA respondeu com seu próprio benchmark.

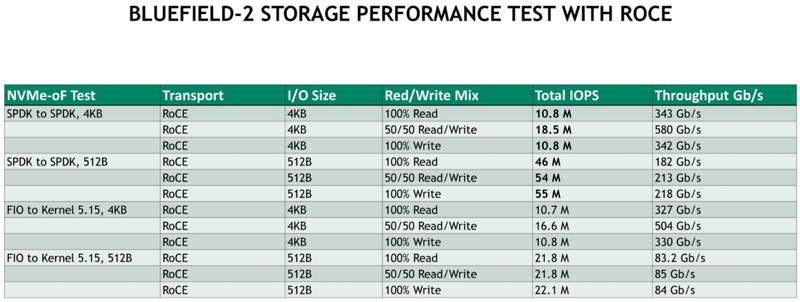

Ontem, a empresa divulgou resultados chocantes – DPU BlueField-2 atingiu 41,4 milhões de IOPS, mais de quatro vezes o recorde da Fungible. O nome do concorrente não é mencionado diretamente, mas nenhum outro fornecedor anunciou qualquer outro indicador de 10 milhões de IOPS. A NVIDIA alcançou mais de 5 milhões de IOPS em blocos de 4 K, com blocos de 512 bytes espalhados de 7 a mais de 20 milhões de IOPS.

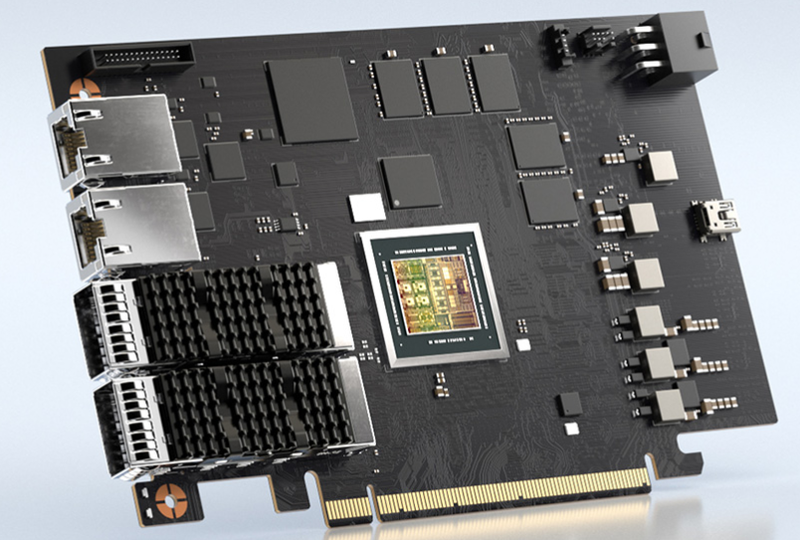

Imagens: NVIDIA

A NVIDIA usou um par de servidores HPE Proliant DL380 Gen 10 Plus, cada um com dois processadores Intel Xeon Platinum 8380 (Ice Lake-SP, 40C / 80T, 2,3-3,4 GHz, 60 MB L3 cache, 270 W TDP) e 512 GB de DRAM. Em cada nó, duas placas NVIDIA BlueField-2P (versão Performance) com duas portas de 100 GbE cada foram conectadas ao barramento PCIe 4.0 – a largura do canal entre os nós foi de 400 Gb / s. O switch não foi usado, os servidores foram conectados diretamente com cabos de cobre passivos. O sistema operacional era RHEL 8.3 com kernels Linux 4.18 e 5.15. Foram usados iniciadores completos e do SPDK.

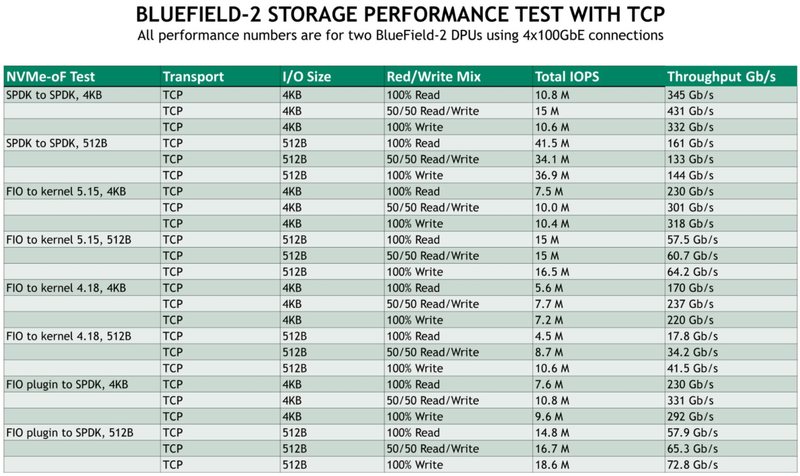

Resultados do teste para o modo TCP

Testado com NVNe / RoCE e NVMe / TCP em cenários de 100% leitura, 100% gravação e 50/50% leitura / gravação. Os melhores resultados foram obtidos ao usar o SPDK em ambos os sistemas (mas às custas do aumento da carga da CPU). O desempenho linear é realmente impressionante, se aproximando do limite do canal de 4 × 100GbE, e no modo 50/50 para 4K com RoCE, conseguimos chegar a 550 Gbps (afinal, duplex). Parece que a NVIDIA tem um novo e brilhante recorde mundial em seu bolso, mas há uma série de dúvidas sobre a metodologia de teste.

…E para RoCE

Em primeiro lugar, a falta de dados sobre a configuração dos subsistemas de disco nas especificações é suspeita. Considerando que o servidor usado possui 24 baias SFF, poderíamos falar sobre o número correspondente de Intel Optane P5800X – um desses SSD produz cerca de 1,5 milhões de IOPS em blocos de 4K e até 5 milhões de IOPS em blocos de 512B. Os números parecem concordar bem, embora esta configuração exija todas as 128 pistas PCIe 4.0 (x4 para cada um dos 24 SSDs hipotéticos e dois x16 para DPUs).

SSDs mais rápidos no fator de forma padrão hoje: Intel Optane P5800X (Imagem: Intel)

Um triunfo completo das idéias NVMe-oF? Na verdade, não. Serve The Home esclareceu alguns dos detalhes de teste da NVIDIA. Então, descobriu-se que nos cenários de teste a empresa não utilizava o subsistema de armazenamento, enviando tudo para / dev / null. Basicamente, a transferência de dados foi medida “de Xeon para Xeon”, ou seja. principalmente a velocidade da rede. Além disso, a NVIDIA confirmou que os núcleos do Array of Arm a bordo do BlueField-2 não foram realmente usados e todo o tráfego passou pelo silício ConnectX padrão, que também está disponível neste DPU.

É difícil dizer o quão útil é esse teste. Claro, ele demonstra o excelente desempenho de rede do BlueField-2, desempenho em um ambiente de servidor padrão, prontidão de pilha de software e sistemas baseados em Xeon Ice Lake-SP com periféricos PCIe 4.0. No entanto, a questão de como o BlueField-2 interage com um subsistema de disco físico real permanece em aberto, uma vez que é difícil comparar os testes atuais com o resultado do Fungible.