A empresa norte-americana Cloudflare, que fornece serviços CDN, usará aceleradores NVIDIA em sua rede global de borda para processar cargas de trabalho de IA com uso intensivo de recursos, em particular modelos de linguagem grande (LLM), de acordo com a Datacenter Dynamics. Como observa a NetworkWorld, a iniciativa se chama Workers AI. Os clientes poderão acessar o poder dos dispositivos NVIDIA para implementar seus projetos de IA.

A Cloudflare também utilizará switches Ethernet NVIDIA e um conjunto completo de software de inferência NVIDIA, incluindo TensorRT-LLM e Triton Inference. Não há planos para oferecer suporte a modelos de IA personalizados inicialmente: os clientes terão acesso apenas ao Meta✴ Llama 2 7B e M2m100-1.2, OpenAI Whisper, Hugging Face Distilbert-sst-2-int8, Microsoft Resnet-50 e Baai bge-base- en-v1.5. Esta lista está planejada para ser expandida no futuro.

Nada é dito sobre os modelos de aceleradores que a Cloudflare utilizará. Mas note-se que até ao final de 2023, as soluções NVIDIA serão implementadas em mais de 100 cidades, e durante 2024 aparecerão em quase todas as áreas de presença da Cloudflare. A rede global da empresa utiliza data centers em mais de 300 cidades ao redor do mundo.

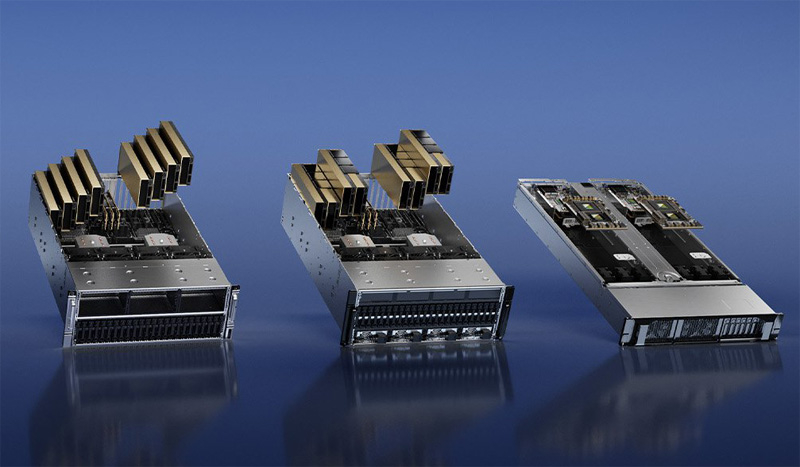

Fonte da imagem: NVIDIA

Outra nova iniciativa de IA da Cloudflare é o Vectorize, um banco de dados vetorial. Isso ajudará os desenvolvedores a criar aplicativos baseados em IA inteiramente na plataforma Cloudflare. Diz-se que Vectorize receberá integração com Workers AI. Por fim, está sendo preparado o AI Gateway, um sistema de otimização e gerenciamento de desempenho projetado para funcionar com aplicações de IA implantadas na rede Cloudflare.