O Google anunciou que seus mais recentes aceleradores de IA TPU v6, codinome Trillium, estão disponíveis para clientes para análise como parte da plataforma de nuvem GCP. Afirma-se que hoje o novo produto é a solução mais eficaz do Google em termos de relação preço/desempenho.

A apresentação oficial do Trillium aconteceu em maio deste ano. O produto é equipado com 32 GB de memória HBM com largura de banda de 1,6 TB/s, e a interconexão entre chips ICI oferece a capacidade de transferir dados em velocidades de até 3,58 Tbit/s (quatro portas por chip). São usados blocos SparseCore de terceira geração, projetados para acelerar o trabalho com modelos de IA usados em sistemas de classificação e recomendação.

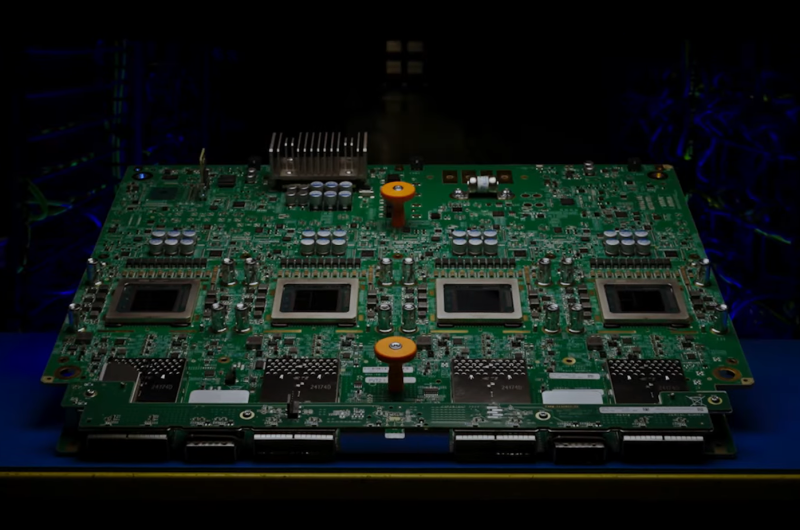

Fonte da imagem: Google

O Google destaca uma série de vantagens significativas do Trillium (TPU v6e) sobre os aceleradores TPU v5e:

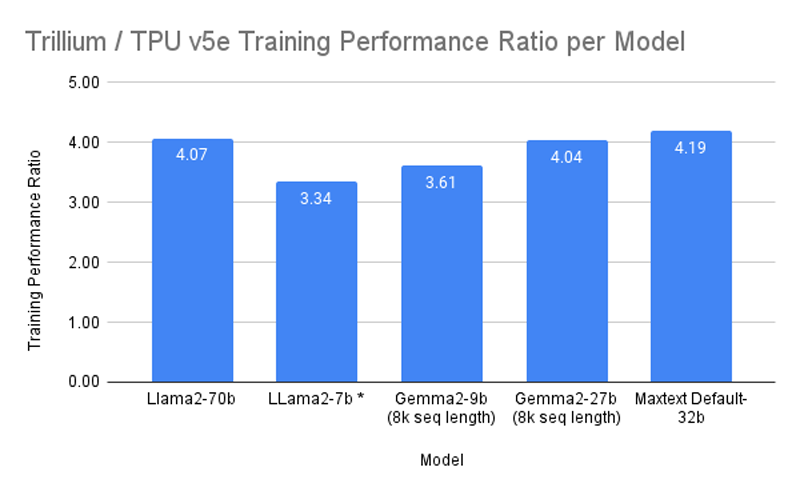

- Aumento de mais de quatro vezes no desempenho ao treinar modelos de IA;

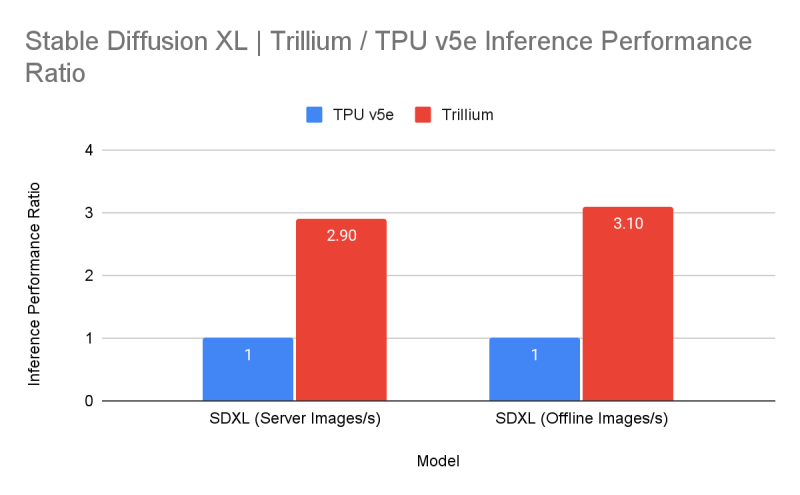

- O desempenho da inferência aumenta até três vezes;

- Melhoria da eficiência energética em 67%;

- Aumento no desempenho máximo de computação por chip em 4,7 vezes;

- Aumento duplo na capacidade da HBM;

- Dobrando o rendimento da interconexão entre chips ICI.

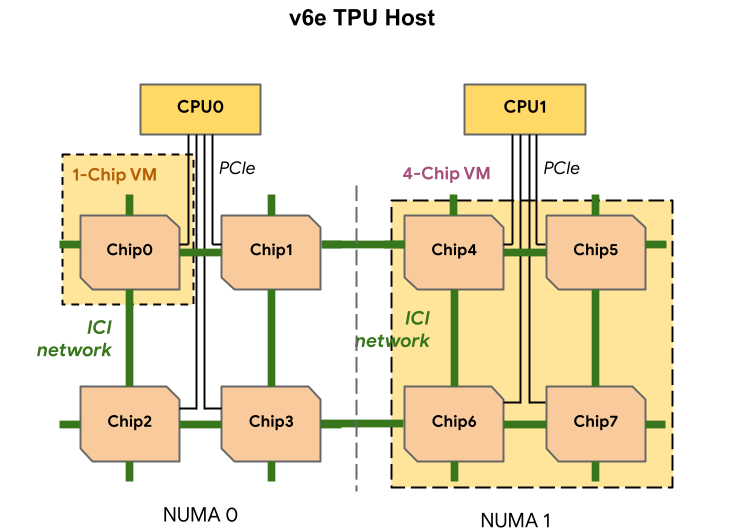

Um nó inclui oito aceleradores TPU v6e (em dois domínios NUMA), dois processadores sem nome (180 vCPUs no total), 1,44 TB de RAM e quatro adaptadores 200G (dois por CPU) para comunicação com o mundo exterior. Observa-se que até 256 produtos Trillium podem ser conectados diretamente por meio de ICI, e a velocidade de conexão de rede agregada de tal cluster (Pod) é de 25,6 Tbit/s. Dezenas de milhares de aceleradores podem ser conectados em um cluster de IA em grande escala graças à plataforma de comutação óptica Júpiter do Google, com uma taxa de transferência combinada de até 13 Pbps. Trillium está disponível como parte da plataforma de IA integrada AI Hypercomputer.

Diz-se que o software Multislice Trillium fornece escalonamento de desempenho quase linear para cargas de trabalho de treinamento de IA. Clusters baseados em Trillium podem fornecer até 91 Eflops de desempenho de IA, quatro vezes mais rápido do que as maiores implantações de TPU v5p. O desempenho do BF16 de um único chip TPU v6e é de 918 Tflops e INT8 – 1836 Tops.

Nos benchmarks Trillium, comparado ao TPU v5e, ele mostrou um aumento de mais de quatro vezes no desempenho ao treinar os modelos Gemma 2-27b, MaxText Default-32b e Llama2-70B, bem como um aumento de mais de três vezes para LLama2 -7b e Gemma2-9b. Além disso, o Trillium fornece um aumento de três vezes no desempenho de inferência para Stable Diffusion XL (em relação ao TPU v5e). Em termos de relação preço/desempenho, a TPU v6e demonstra um aumento de 1,8 vezes em comparação com a TPU v5e e aproximadamente 2 vezes o aumento em comparação com a TPU v5p. Não foi especificado se uma modificação mais produtiva do TPU v6p aparecerá.