GigaIO anunciou um acordo para criar infraestrutura para a nuvem de IA especializada TensorNODE, que está sendo criada pelo provedor TensorWave. A plataforma utilizará aceleradores AMD Instinct MI300X equipados com 192 GB de memória HBM3.

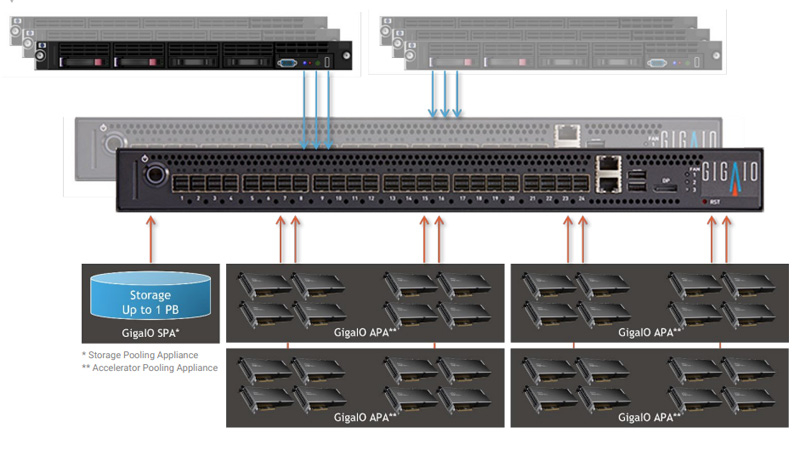

O TensorNODE será baseado em miniclusters SuperNODE, que estreou no verão deste ano. A peculiaridade desta solução é que ela permite conectar 32 e até 64 aceleradores através de uma interconexão distribuída baseada em PCI Express.

TensorWave usará FabreX para formar pools de memória em escala de petabytes. Na primeira fase, no início de 2024, a plataforma TensorNODE integrará até 5.760 aceleradores Instinct MI300X em um domínio. Assim, ao resolver problemas complexos, será possível acessar mais de 1 PB de memória de qualquer nó. Isto, conforme observado, permitirá processar até mesmo as cargas que consomem mais recursos em tempo recorde.

Fonte da imagem: GigaIO

Existem planos para implantar vários sistemas TensorNODE no próximo ano. A arquitetura GigaIO proporcionará maior flexibilidade em relação às soluções tradicionais: a infraestrutura pode ser otimizada dinamicamente para atender às necessidades atuais e futuras de IA e de modelo de linguagem grande (LLM).

Observa-se que o TensorNODE é inteiramente baseado nos principais componentes da AMD. Além dos aceleradores Instinct MI300X, são processadores EPYC Genoa. A nuvem TensorWave reduzirá o consumo de energia e o custo total de propriedade, eliminando da configuração servidores redundantes e equipamentos de rede associados.