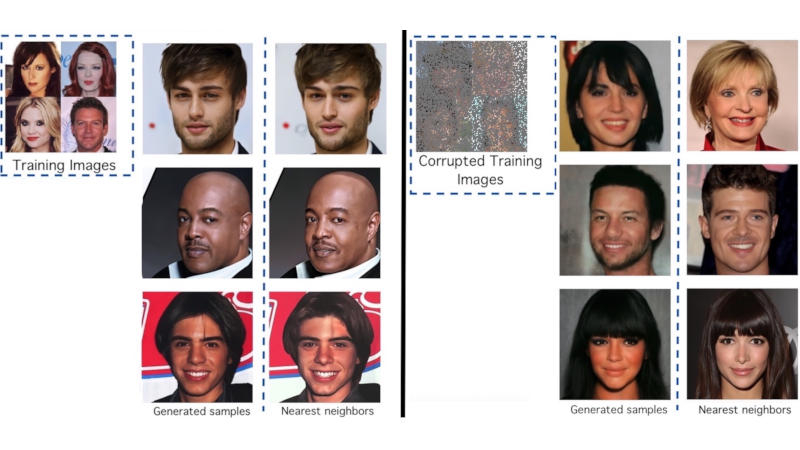

Modelos de inteligência artificial que geram imagens baseadas em descrições de texto, quando treinados em imagens originais, podem “lembrar” delas, levantando assim a questão da violação de direitos autorais. Para proteger contra reivindicações de detentores de direitos autorais, o sistema Ambient Diffusion foi desenvolvido para treinar modelos de IA apenas em dados danificados.

Fonte da imagem: github.com/giannisdaras

Os modelos de difusão são algoritmos avançados de aprendizado de máquina que geram recursos de alta qualidade introduzindo gradualmente ruído em um conjunto de dados e, em seguida, revertendo o processo. Estudos mostraram que tais modelos são capazes de lembrar amostras da matriz de treinamento. Este recurso pode ter consequências desagradáveis em termos de privacidade, segurança e direitos autorais. Por exemplo, se a IA for treinada para trabalhar com raios X, não precisará lembrar imagens de pacientes específicos.

Para evitar esses problemas, pesquisadores da Universidade do Texas em Austin e da Universidade da Califórnia em Berkeley desenvolveram a estrutura Ambient Diffusion para treinar modelos de difusão de IA apenas em imagens que foram danificadas de forma irreconhecível, tornando virtualmente impossível para a IA “lembrar” e reproduzir a obra original.

Para confirmar a sua hipótese, os cientistas treinaram um modelo de IA em 3.000 imagens de celebridades da base de dados CelebA-HQ. Ao receber uma solicitação, esse modelo passou a gerar imagens quase idênticas às originais. Depois disso, os pesquisadores treinaram novamente o modelo usando 3.000 imagens com danos graves – até 90% dos pixels estavam mascarados. Então ela começou a gerar rostos humanos realistas e muito diferentes dos originais. Os autores publicaram os códigos-fonte do projeto no GitHub.