Ao falar sobre os desafios enfrentados pelos desenvolvedores de modelos generativos cada vez mais complexos e capazes, as pessoas costumam mencionar as incríveis demandas de energia dos servidores especializados nos quais esses modelos geralmente são executados. É claro que recentemente tem havido um desenvolvimento ativo de modelos prontos para rodar localmente em PCs e até mesmo em smartphones, porém, eles também possuem menos capacidades do que as versões em nuvem, que os superam significativamente em número de parâmetros operacionais, e até mesmo em tais de forma reduzida, ainda consomem energia mais clássica (para a era pré-gerativa) de programas de computador e aplicativos móveis. O desejo de equipar qualquer robô aspirador de pó, cortador de grama ou mesmo sensor inteligente de Internet das Coisas com algum tipo de IA coloca os desenvolvedores de tais dispositivos em um dilema: reduzir deliberadamente a funcionalidade de modelos executados localmente para se adequar às capacidades do hardware von Neumann disponíveis em tais dispositivos, ou o princípio de abandonar o desejo de autonomia – e confiar em redes avançadas como 5G para comunicar com IA na nuvem “verdadeiramente inteligente”, em vez de um futuro tão distante e 6G.

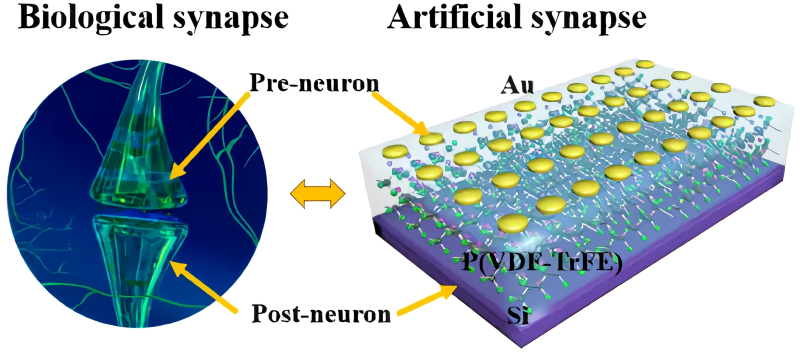

Sinapse de tecido nervoso biológico (esquerda) e uma estrutura de polímero ferroelétrico em um substrato de silício reproduzindo sua funcionalidade com alguma aproximação (fonte: Universidade Fudan)

E embora o segundo caminho seja o mais previsível, por se basear em tecnologias já bem dominadas, do ponto de vista dos custos energéticos parece a muitos especialistas um beco sem saída. De acordo com a Agência Internacional de Energia, se um pedido típico a um motor de busca web custa ao centro de dados que o alimenta aproximadamente 0,3 Wh, então o mesmo pedido dirigido ao ChatGPT custa 2,9 Wh (e não é um facto que em resposta o utilizador irá receber dados correspondentes à verdade, e não outra alucinação generativa). Todos os dias, em todo o mundo, só o mecanismo de busca Google recebe cerca de 9 bilhões de solicitações, e se todas elas fossem processadas por bots inteligentes, o aumento no consumo global no ano seria de cerca de 10 TWh – esta é a quantidade de energia consumida em média para o mesmo ano 1,5 milhões de europeus. Só podemos imaginar o quanto a necessidade de eletricidade aumentará se os modelos generativos baseados na nuvem começarem a ser regularmente acedidos por dispositivos inteligentes, dos quais já existem muitos à nossa volta, e que só se tornarão mais numerosos a cada ano. Além disso, fornecer comunicações sem fio confiáveis e universalmente disponíveis para essas conexões máquina a máquina provavelmente custará muito dinheiro às operadoras.

⇡#Será mais fácil complicar

Em artigos anteriores da série dedicada aos sistemas neuromórficos, apontamos repetidamente a principal diferença entre os computadores da arquitetura von Neumann e o tecido nervoso biológico: a separação física fundamental entre armazenamento de dados e processadores. O barramento de informações entre o processador e a RAM pode ser tão amplo quanto desejado (embora quanto mais canais, mais caro será esse projeto e menor será sua confiabilidade), mas ainda haverá tempo – e principalmente energia – para mover informações da RAM para a CPU e vice-versa é consumido bastante: 2 a 3 ordens de magnitude decimais a mais do que uma operação computacional típica no próprio processador. Especialmente considerando os volumes de dados, os modelos generativos modernos, com centenas de bilhões de parâmetros operacionais, precisam ser analisados. As operações de multiplicação de matrizes (às quais, em essência, o trabalho de uma rede neural artificial é reduzido do ponto de vista matemático) não é um binômio de Newton, mas a calculadora de von Neumann claramente não é ideal para isso, especialmente quando a dimensão de ambos os fatores é muito grande.

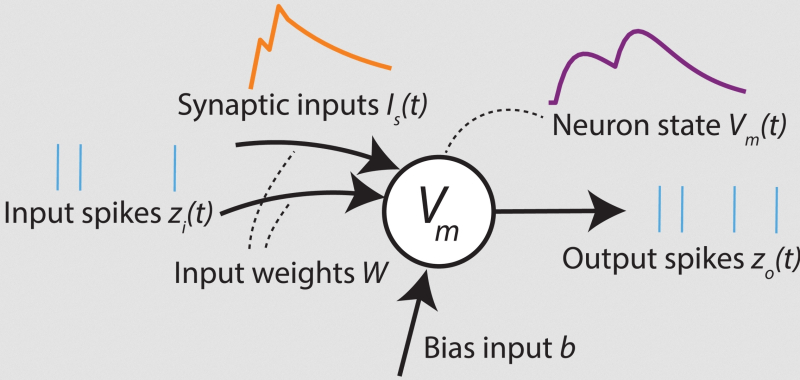

Um modelo simples de um neurônio em uma rede neural com picos (fonte: SynSense)

Mas o tecido nervoso biológico, pelo contrário, armazena e processa sinais nos mesmos nós de hardware, o que levou Carver Mead, em 1990, a introduzir o termo “neuromórfico”, isto é, “funcionalmente semelhante ao tecido nervoso”, em aplicação ao tecido nervoso”. promissor nesse sentido, mas naquela época ainda não existiam sistemas de computação. Nesses mesmos anos, formou-se a ideia de “engenharia neuromórfica” – um campo de pesquisa interdisciplinar na intersecção da ciência de dados, microeletrônica, neurobiologia e muitas outras áreas, cuja principal tarefa é a construção de sistemas de computação, em no nível do hardware, se não um a um, emulando o funcionamento de um sistema nervoso vivo, pelo menos usando em seu design soluções ótimas sugeridas pela natureza. As redes neurais de impulso (pico), SNNs, que examinamos nesta série de artigos são apenas uma delas: destinadas ao processamento de sequências de sinais, elas reproduzem de forma bastante próxima a funcionalidade dos neurônios biológicos.

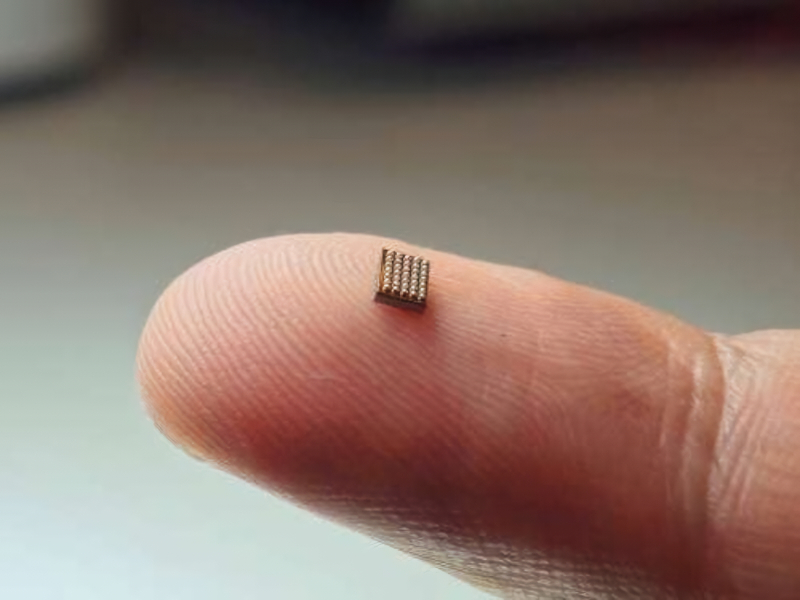

A disposição dos sistemas de von Neumann em emular arquiteturas de computação fundamentalmente diferentes contribui grandemente para o desenvolvimento de neuromórficos – os modelos digitais são uma boa maneira de elaborar os princípios gerais de organização e operação de novos dispositivos. Porém, para realmente concretizar as vantagens dos SNNs de hardware, é necessário criar o hardware adequado – começando, claro, pelos sistemas semicondutores, uma vez que as tecnologias para a sua produção já foram desenvolvidas da melhor forma possível. Processadores neuromórficos Loihi (agora duas gerações), ODIN, SpiNNaker, Xylo, Akida e muitos outros, cujos circuitos (incluindo memória local para armazenar os estados anteriores de neurônios individuais, bem como circuitos de atraso de sinal e ajustes de peso em sinapses artificiais) são formados por micro e nanoestruturas de silício, já demonstram excelentes resultados nas tarefas para as quais são mais adequados. É verdade que, na sua maior parte, esses computadores estão agora disponíveis como protótipos de laboratório ou, na melhor das hipóteses, como produtos de pequena escala com um âmbito de aplicabilidade limitado. Citamos as razões para isso no final do artigo anterior, e (se ignorarmos as dificuldades puramente práticas da implementação de sistemas neuromórficos em hardware) as principais entre elas são talvez duas: um conjunto bastante limitado de software – e o próprio natureza complexa deste próprio campo do conhecimento, o que estreita drasticamente o leque de potenciais especialistas prontos para lidar com ele.

O microcontrolador neuromórfico Spiking Neural Processor T1 da startup holandesa Innatera contém cerca de 500 neurônios artificiais e cerca de 60 mil sinapses, e consome menos de 1 mW na potência de pico (fonte: Innatera)

Ainda assim, os benefícios potenciais da computação neuromórfica mantêm os investigadores ocupados. Além da eficiência energética alucinante (especialmente no contexto de GPUs de servidor que consomem muita energia) e – em teoria – desempenho extremamente alto devido à combinação de um nó de computação e memória em uma única unidade física, sem separação em CPU e RAM com um barramento relativamente estreito entre eles, os especialistas indicam pelo menos dois. O primeiro desses benefícios adicionais é a promessa brilhante do processamento paralelo em SNNs assíncronos: em essência, os sistemas neuromórficos podem lidar simultaneamente com tantos fluxos de transformação de informações quanto o número de neurônios artificiais que eles contêm. E a segunda é a adaptabilidade extremamente alta (em neurofisiologia, o termo “plasticidade” é usado) dos computadores neuromórficos à natureza mutável dos problemas que resolvem. As capacidades de autoaprendizagem dos sistemas, cujo próprio princípio de funcionamento é emprestado do tecido nervoso biológico, são potencialmente tão grandes que muitos investigadores duvidam seriamente que robôs verdadeiramente inteligentes – aqueles que respondem de forma adequada e atempada às realidades em mudança da o mundo ao seu redor – poderão aparecer antes que seja possível equipá-los com sistemas analíticos neuromórficos integrados.

⇡#Histerese, mudança de fase

Embora as tecnologias clássicas de semicondutores sejam geralmente adequadas para a construção de sistemas neuromórficos de hardware, elas apresentam uma série de limitações sérias. Em particular, não será possível escalar computadores neuromórficos de silício na direção de unidades de nanômetros convencionais com a mesma facilidade com que os processadores x86 ou RISC permitem isso, por exemplo, pela razão de que o neurônio artificial SNN deve incluir pelo menos um número limitado de células de memória. Colocar memória em um único substrato de silício próximo à unidade de processamento é uma tarefa trivial; Um exemplo disso é o cache SRAM como componente integrante dos processadores centrais há várias décadas. No entanto, como devem lembrar os leitores da nossa série de artigos sobre os desafios da produção de semicondutores, as células de memória são muito mais difíceis de miniaturizar do que os circuitos lógicos, o que significa que é improvável que reduza significativamente a escala dos padrões de produção de chips neuromórficos semicondutores do os atuais de aproximadamente “28 nm têm sucesso com custo mínimo”. Ou seja, no atual estágio de desenvolvimento, os neuromórficos semicondutores obviamente superam as plataformas mais exóticas em termos de implementação de hardware – simplesmente pela excelente suavidade dos processos de produção utilizados para sua fabricação. No entanto, à medida que estas próprias plataformas exóticas começam a ganhar impulso suficiente no seu desenvolvimento, têm todas as hipóteses de alcançar e ultrapassar os sistemas neuromórficos de silício – simplesmente porque sem uma redução acentuada na escala dos padrões de produção, será difícil competir comoutras arquiteturas, tanto em termos de eficiência energética quanto de desempenho.

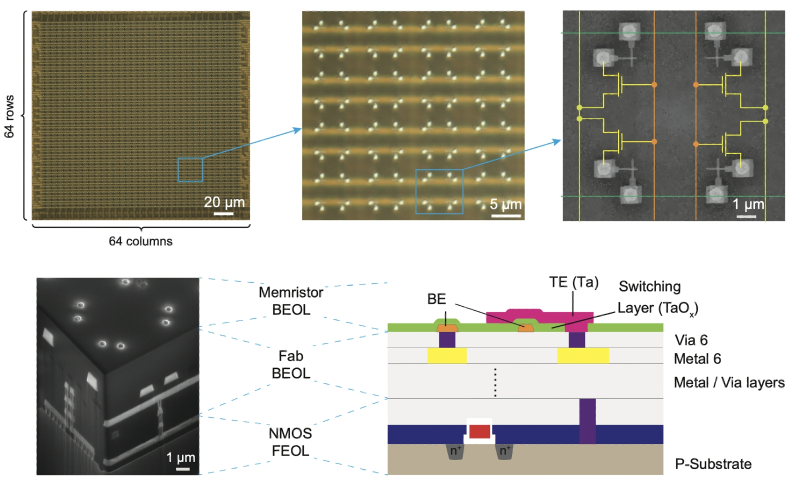

Circuito integrado Memristor: fotografias, micrografias eletrônicas e seção esquemática (fonte: Universidade de Hong Kong)

As implementações mais próximas de semicondutores de computadores neuromórficos são, talvez, as de memristor – construídas não em transistores clássicos (cujas portas permitem ou não a passagem de carga – “abrir” ou “fechar” – sob a influência da tensão de controle), mas nos próprios memristores (de memória + transistor), cuja condutividade elétrica é alterada pela corrente que passa por eles. O comportamento de um memristor determina seu fenômeno inerente de histerese: a resposta instantânea do sistema a um estímulo (neste caso, à corrente que passa por ele) depende não apenas da força desse estímulo em si, mas também, de forma não linear, de o estado do próprio sistema em um determinado intervalo de tempo anterior. Podemos dizer que esta reação se manifesta com algum atraso (a palavra grega ὑστέρησις significa precisamente “atraso”), mas apenas até um certo limite, após o qual ocorre a saturação – e um maior crescimento na magnitude da reação em resposta ao estímulo não ocorre mais. Este fenômeno de histerese é fundamentalmente diferente da inércia, que também se manifesta como um atraso na resposta, mas geralmente é linear e não limitado na força da reação (exceto talvez pela força física do sistema que está sendo estimulado).

Os memristores podem assim ser usados como base para a criação de neurônios e sinapses artificiais neuromórficos, embora esses elementos elétricos passivos tenham sido inicialmente estudados por sua aplicabilidade em sistemas de memória de computador. O fato é que a mudança na condutividade do memristor sob a influência da passagem da corrente ocorre bastante rapidamente e, portanto, no futuro tais dispositivos poderão competir em velocidade de operação não apenas com a memória NAND, mas também com a memória DRAM. . Além disso, quando a tensão é removida dos contatos, o memristor permanece em um estado inalterado – o que permite reiniciar quase instantaneamente o sistema imediatamente a partir do momento anterior ao desligamento durante a próxima inicialização, sem perder tempo salvando o conteúdo de Células RAM para o arquivo de troca e, em seguida, recuperá-lo de lá.

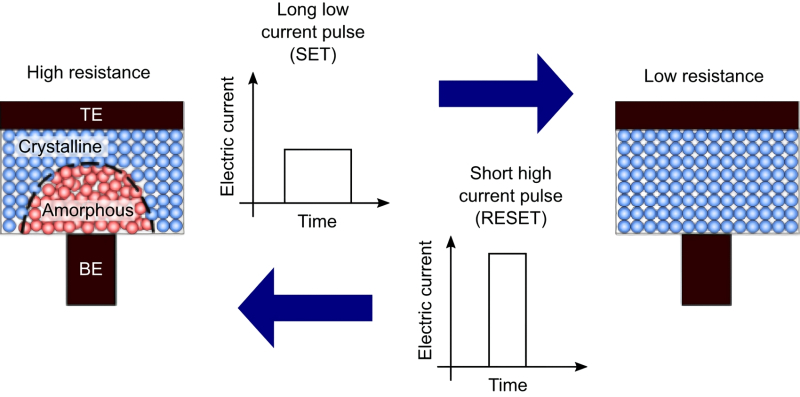

O princípio de funcionamento de uma célula de memória com mudança de estado de fase: um pulso longo de baixa intensidade (SET) leva à formação de uma estrutura amorfa com resistência elétrica significativa na região limítrofe ao eletrodo; curto e intenso (RESET) – para retornar a amostra ao estado policristalino (fonte: IBM)

À medida que crescia o interesse pela computação neuromórfica, ficou claro que os processos físicos com histerese – ou seja, aqueles que garantem a preservação de um determinado valor após uma influência externa por um longo tempo, e então também são capazes, também induzidos, de retornar ao estado original – não são tão poucos. Por exemplo, são conhecidos compostos químicos como os calcogenetos, entre outras propriedades interessantes dos quais há uma mudança no estado de fase (de policristalino para amorfo e vice-versa), que pode ser provocada, por exemplo, por aquecimento – e que, por sua vez, é gerado pela aplicação de tensão ao eletrodo dissipador de calor da célula de calcogeneto. A memória de mudança de fase (PCM) é baseada neste princípio. Aliás, não é difícil aquecer um calcogeneto com laser e, além da condutividade, a transição de um estado de fase para outro pode ser acompanhada em certas substâncias por uma mudança nas propriedades ópticas, e não apenas nas propriedades elétricas. Portanto, a base, digamos, dos bem conhecidos – embora do ponto de vista moderno quase na mesma prateleira dos fonógrafos e daguerreótipos antediluvianos – (re)graváveis CDs e DVDs também reside no mecanismo de transição de fase em ligas de calcogeneto. .

As células PCM são caracterizadas por uma confiabilidade extremamente alta – amostras experimentais de várias composições mostraram os primeiros sinais de degradação somente após 108, ou mesmo 1.012 ciclos de reescrita. Além disso, suas dimensões físicas podem muito bem ser calculadas em nanômetros, o que abre um enorme espaço para a miniaturização da memória do computador e dos sistemas neuromórficos criados a partir delas – especialmente se processos fotolitográficos finos forem usados para fabricar ônibus que conectam essas células. Atrasos na escrita/leitura de dados em PCM chegam a dezenas de nanossegundos, portanto a latência dos computadores neuromórficos construídos com base neles acaba sendo bastante aceitável. Infelizmente, esta tecnologia extremamente atraente também tem uma desvantagem significativa, nomeadamente, uma mudança na resistência eléctrica que se acumula ao longo do tempo devido a mudanças estruturais durante ciclos regularmente repetidos de mudança dos estados de fase dos calcogenetos. Tal mudança pode ser levada em consideração e controlada, entretanto, se o nível de resistência de uma célula PCM individual codificar um determinado valor em uma matriz ou vetor (e o trabalho das redes neurais modernas, em essência, como já dissemos mais de uma vez , se resume a multiplicá-los), a mudança introduzirá um erro nos cálculos – que terá de ser compensado, por exemplo, no nível do software usando um computador clássico de von Neumann. O que, é claro, torna sem sentido o próprio fato de mudar para uma plataforma de hardware neuromórfica.

⇡#Espere por uma resposta

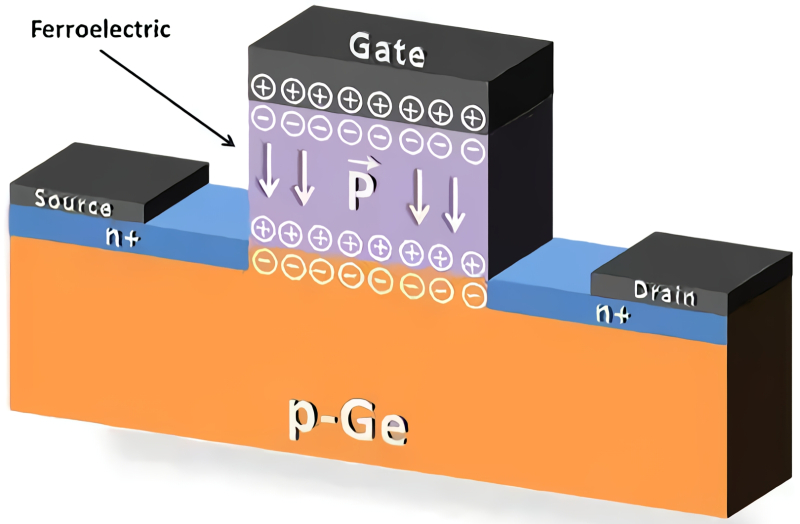

Se nos memristores a condutividade elétrica muda sob a influência da corrente que passa pela amostra, e nas células de calcogeneto o efeito de controle (transição de um estado de fase para outro) é exercido pela temperatura, então outros sistemas demonstram fenômenos de histerese semelhantes – e em relação a suas propriedades muito diferentes. Assim, na ferroelétrica (também conhecida como ferroelétrica), ocorre uma transição de fase entre dois estados cristalinos com polarizações diferentes sob a influência de um campo elétrico externo. Conseqüentemente, tais cristais podem ser usados para registrar e armazenar dados: um valor de polarização codificará um “1” lógico, o outro – “0”. A memória de computador baseada nesse efeito, FeRAM, de ferroelétrico, foi proposta na década de 1950, junto com capacitores FeCAP e até mesmo transistores de efeito de campo FeFET construídos com base nos mesmos princípios. Neste caso, como o estado do ferroelétrico após “programação” por um campo externo não muda se a temperatura permanecer adequada, o FeFET mantém o estado que lhe foi atribuído pelo tempo desejado até que um novo sinal de comando seja enviado através do controle ônibus. Isso apenas dá a oportunidade potencial de treinar redes neurais em base ferroelétrica e, em seguida, utilizá-las já treinadas para realizar tarefas aplicadas (inferência).

Parece ser o transistor de efeito de campo mais comum em seção transversal, mas a porta neste caso é formada por um material ferroelétrico (fonte: Universidade do Texas, Austin)

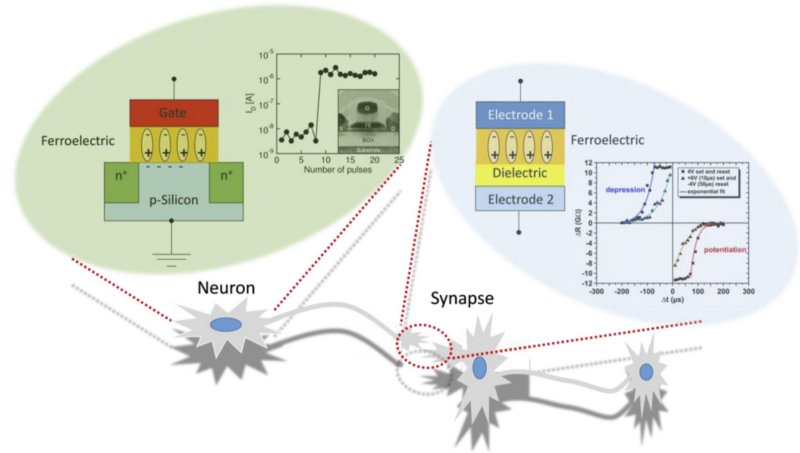

É importante que a polarização inicial (espontânea) do ferroelétrico não seja induzida, mas surja naturalmente devido ao deslocamento de cargas positivas e negativas em relação às posições neutras dentro do cristal em uma determinada faixa de temperatura. Ou seja, materiais desse tipo podem atuar tanto como células de memória quanto como elementos básicos de sistemas neuromórficos. Um único cristal ferroelétrico é um sistema binário (com dois estados de polarização), mas se você usar uma amostra policristalina, poderá, aplicando um campo externo especialmente selecionado, alterar suas propriedades físicas como um todo quase continuamente e dentro de limites bastante amplos. – obtém-se uma espécie de circuito analógico, capaz de atuar como sinapse (e armazenar o valor do peso em uma das entradas de um neurônio artificial, por exemplo). Particularmente encorajador do ponto de vista do projeto de circuitos de futuros computadores neuromórficos ferroelétricos é o fato de que, na mesma base de hardware, eles permitem a formação de células de memória e de circuitos lógicos.

Outra opção para usar ferroelétricos envolve confinar uma amostra com tais propriedades entre um par de eletrodos para implementar uma junção de tunelamento ferroelétrico probabilística, FTJ. Ao influenciar o fino filme ferroelétrico policristalino (alguns nanômetros) que separa os eletrodos, é possível criar condições para o tunelamento quântico de portadores de carga através dele. Desta forma, forma-se uma célula de memória FTJ, cuja gravação é realizada aplicando-se uma tensão aos eletrodos conectados ao filme (criando assim condições para o tunelamento), e a leitura é feita medindo a corrente gerada pelo efeito de tunelamento.

A vantagem indiscutível da implementação ferroelétrica da computação neuromórfica é a capacidade de organizar análogos artificiais de neurônios e sinapses nesta base de hardware comum (fonte: Royal Society of Chemistry)

A ferroelétrica como uma base de hardware promissora – primeiro para um novo tipo de memória e, mais tarde, para a computação neuromórfica – tornou-se objeto de intensa atenção de pesquisa desde 2011, quando excelentes propriedades ferroelétricas foram descobertas acidentalmente em filmes finos de sílica (SiO2) dopados com pequenos quantidades de dióxido de háfnio (HfO2). Do ponto de vista da evolução da tecnologia informática, os menos de quinze anos que se passaram desde aquele momento são um período de tempo insignificantemente curto: como outras tecnologias neuromórficas não semicondutoras, a tecnologia ferroelétrica hoje sofre de muitas “doenças infantis”. E irá, aparentemente, sofrer durante pelo menos mais uma década, embora uma certa proximidade com tecnologias bem desenvolvidas (em particular, fotolitografias em série são usadas para deposição de filmes ferroelétricos) dê esperança de um progresso bastante rápido.

De uma forma ou de outra, os neuromórficos de hardware além do puramente semicondutor (onde as mesmas sinapses, por exemplo, ainda precisam ser emuladas com circuitos de transistores bastante complexos) continuam a ser uma questão de amanhã, se não depois de amanhã. Além das tecnologias que listamos, são consideradas outras ainda mais exóticas, como a utilização do mecanismo químico da reação redox para alterar o estado de valência e, consequentemente, as propriedades elétricas dos meios com íons metálicos para criar sinapses artificiais ( memória de mudança de valência, VCM, um subtipo de memória resistiva com acesso arbitrário, memória de acesso aleatório resistiva, RRAM), metalização eletroquímica programável (ECM), redes neuromórficas; nanotubos (redes de nanofios neuromórficos), etc. Existem muitas direções e muitas dificuldades em avançar em cada uma delas – nós as listamos no final do artigo anterior desta série.

No entanto, provavelmente nos próximos 3-5 anos, entre esta série de caminhos condicionalmente promissores, mas ainda não muito trilhados, um máximo de dois ou três se destacarão, e então resultados mais tangíveis podem ser esperados dos neuromórficos de hardware. Enquanto isso, a emulação de modelos generativos (e outros) de IA na memória das máquinas de von Neumann continua a ser, embora cara, mas sem dúvida uma realidade alcançável, enquanto quase todas as tentativas de fornecer uma base de “hardware” diferente para redes neurais artificiais não dão um resultado economicamente justificado. O que resta a felicitar são os trabalhadores da energia de todo o mundo – obviamente, graças à procura sempre presente de uma variedade de aplicações de inteligência artificial, eles não ficarão sem trabalho e sem superlucros durante muito tempo.