No centro da inteligência artificial está o cálculo matricial, que acaba de experimentar seu maior aumento em mais de uma década. Quase simultaneamente, foram publicados dois artigos nos quais matemáticos explicavam como aumentar a eficiência da multiplicação de matrizes. Com a ajuda de novos algoritmos, a inteligência artificial será capaz de aprender mais rápido em hardware menos potente e resolver problemas com mais rapidez da mesma maneira.

Fonte da imagem: geração AI Kandinsky 3.0/3DNews

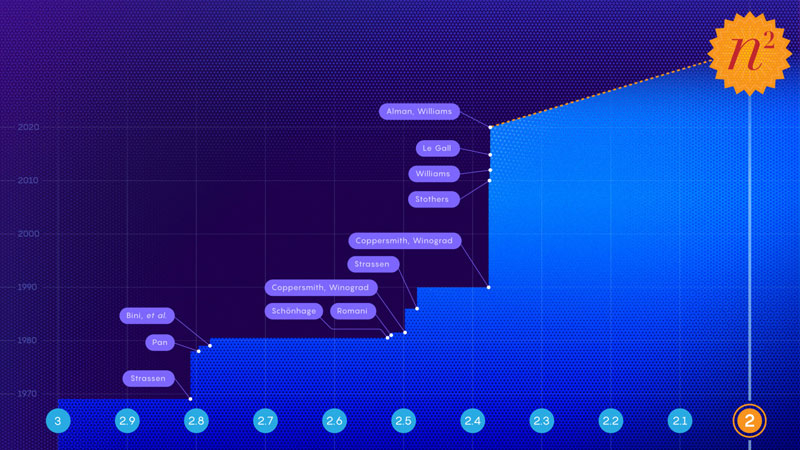

A essência do problema é que, até há relativamente pouco tempo, a humanidade, representada pelos matemáticos, não imaginava outra forma de multiplicar matrizes senão realizando n3 operações (onde n é a dimensão das matrizes). Para uma matriz 3×3, por exemplo, foi necessário realizar 27 multiplicações. Num mundo ideal para os matemáticos, a multiplicação de matrizes seria realizada em n2 operações. E no início da década de 70 começou a busca por um algoritmo adequado. Não é difícil adivinhar o que motivou isso com a disseminação dos computadores.

Progressos significativos nesta área foram feitos em 1981 pelo matemático Arnold Schönhage. Ele provou que a multiplicação de matrizes pode ser realizada em n2.522 passos. Mais tarde, esse método foi chamado de “método laser”. Todos os avanços subsequentes em direção ao cobiçado “segundo grau” foram baseados em melhorias no método laser.

O avanço anunciado nos novos artigos, feitos em 2023, ocorreu em decorrência da descoberta de “perdas ocultas” no método laser. Em novembro de 2023, Ran Duan e Renfei Zhou, da Universidade de Tsinghua, apresentaram um método que eliminou a ineficiência do método a laser, estabelecendo um novo limite superior para o número de operações necessárias em aproximadamente n2,371866. Esta conquista marcou o progresso mais significativo nesta área desde 2010. Mas apenas dois meses depois, Virginia Wasilewski Williams, Yingzhang Xu e Zixuan Xu do MIT publicaram um segundo artigo detalhando outra otimização que reduziu o limite superior do número de operações para n2,371552.

Etapas do caminho para o “segundo grau” e os nomes dos cientistas que fizeram descobertas

É claro que o impacto exato na velocidade dos modelos de IA depende da arquitetura de hardware específica do sistema de IA e do quanto as tarefas de um modelo específico dependem da multiplicação de matrizes. Portanto, a melhoria da eficiência dos algoritmos será combinada com a otimização do hardware para concretizar plenamente os ganhos potenciais de velocidade. Mesmo assim, à medida que as melhorias nos métodos algorítmicos se acumulam ao longo do tempo, a inteligência artificial se tornará mais rápida – isso é um fato.