A OpenAI revelou o GPT-4o, um poderoso modelo multimodal generativo de inteligência artificial (IA) que será implementado em suas soluções para desenvolvedores e consumidores nas próximas semanas. O “o” no nome do GPT-4o significa omni (abrangente), indicando que o GPT-4o é multimodal.

Fonte da imagem: OpenAI

Mira Murati, CTO da OpenAI, disse durante apresentação do produto no escritório da OpenAI em São Francisco (EUA) que o GPT-4o possui inteligência de “nível GPT-4”, mas maiores capacidades no trabalho com texto e imagens, e também com áudio. “O GPT-4o entende voz, texto e imagens visuais”, disse Murati. “E isso é extremamente importante quando pensamos sobre o futuro das interações entre nós e as máquinas.”

Seu antecessor, GPT-4 Turbo, foi treinado em uma combinação de imagens e texto. Ele pode analisar imagens e texto para realizar tarefas como extrair texto de imagens e até descrever o conteúdo dessas imagens. Por sua vez, o GPT-4o adicionou fala a esses recursos.

É relatado que o GPT-4o melhorará significativamente o desempenho do chatbot AI ChatGPT. Este último há muito suporta um modo de voz, no qual as respostas do chatbot são transcritas usando um modelo de conversão de texto em fala, mas o GPT-4o fortalecerá esse recurso, permitindo que os usuários interajam com o chatbot mais como um assistente. Por exemplo, você pode fazer uma pergunta e interrompê-lo quando ele responder. Segundo a OpenAI, o modelo GPT-4o fornece resposta em “tempo real” e pode até capturar emoções na voz do usuário, gerando uma voz em resposta “em diferentes estilos emocionais” de acordo com a situação atual.

O GPT-4o também melhorará os recursos visuais do ChatGPT. Com base em uma foto sugerida ou na tela do desktop, o ChatGPT agora poderá responder rapidamente a perguntas relacionadas, desde “O que está acontecendo neste código” até “Que marca de camisa essa pessoa está vestindo?”

No futuro, as capacidades do modelo serão ampliadas. Se o GPT-4o agora permite, por exemplo, traduzir um menu fotografado para outro idioma, então no futuro, com a sua ajuda, o ChatGPT poderá “assistir” a um jogo desportivo ao vivo e explicar-lhe as regras, diz Murati.

A partir de hoje, o GPT-4o está disponível no nível gratuito do ChatGPT, bem como para assinantes dos planos ChatGPT Plus e Team premium da OpenAI com limites de mensagens “5x”. Se o limite for excedido, o ChatGPT mudará automaticamente para GPT-3.5.

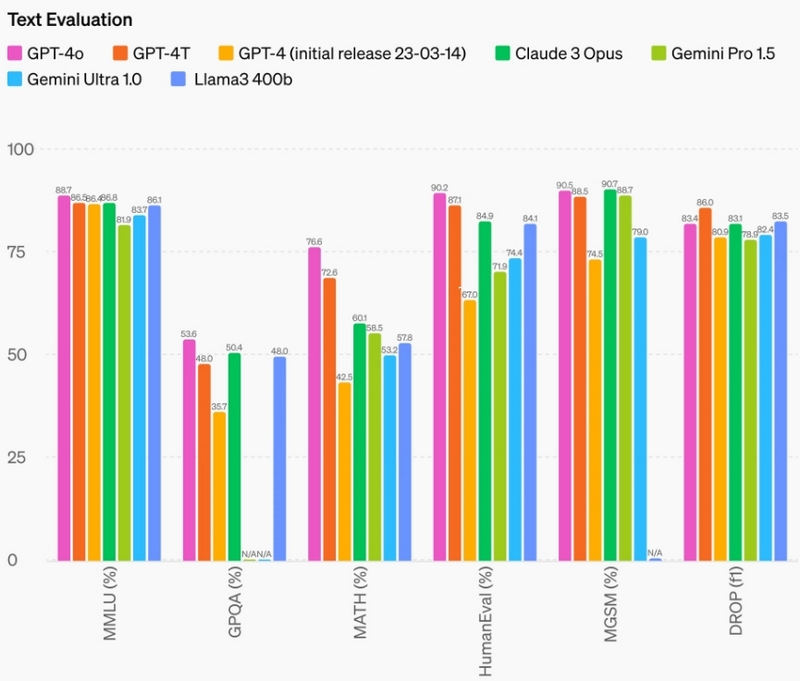

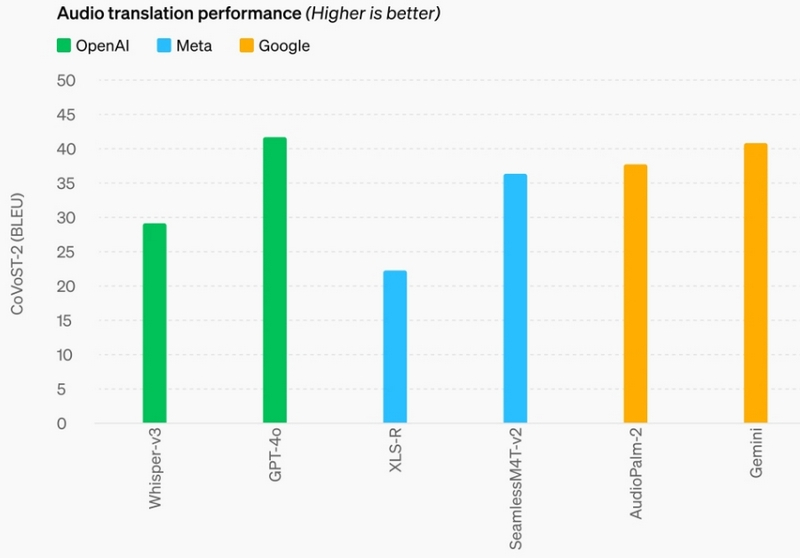

A OpenAI disse que o GPT-4o oferece suporte a mais idiomas, com desempenho aprimorado em 50 idiomas diferentes. Na API OpenAI, o GPT-4o é duas vezes mais rápido que o GPT-4 (especificamente o GPT-4 Turbo), metade do preço e tem limites de velocidade mais altos.

Atualmente, o suporte de voz não está incluído na API GPT-4o para todos os clientes. A OpenAI explicou que, devido ao risco de uso indevido, planeja lançar suporte para os novos recursos de áudio GPT-4o pela primeira vez nas próximas semanas para um “pequeno grupo de parceiros confiáveis”.