Em um esforço para levantar a tampa das redes neurais de caixa preta, a Universidade de Stanford, em colaboração com o MIT e Princeton, desenvolveu o Índice de Transparência do Modelo Fundamental (FMTI). O novo sistema de pontuação classifica os 10 maiores modelos de IA com base em informações publicamente disponíveis sobre eles. Os resultados são deprimentes, apenas os modelos de código aberto oferecem alguma esperança.

Fonte da imagem: Pixabay

«Embora a influência social dos modelos de IA esteja a crescer, a sua transparência está a diminuir, refletindo o sigilo que acompanhou as tecnologias digitais anteriores, como as redes sociais”, afirma o coautor do estudo, Sayash Kapoor. E a baixa transparência, segundo os cientistas, torna difícil para “os consumidores compreenderem as limitações do modelo ou repararem os danos causados”.

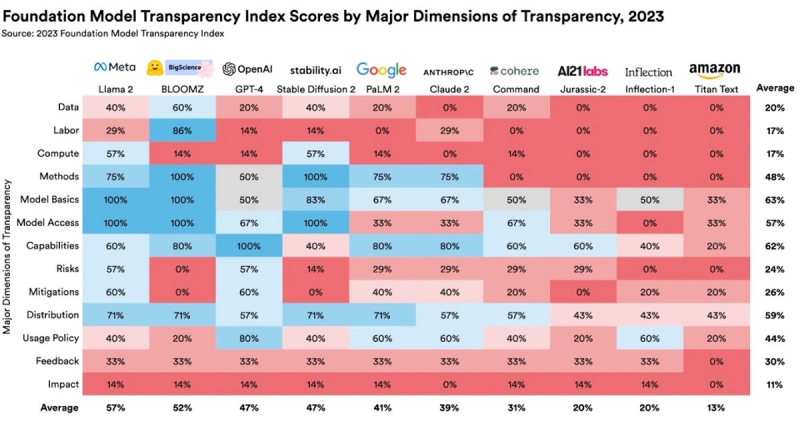

A FMTI avalia os 10 maiores modelos de IA em 100 critérios diferentes relacionados à transparência e abertura. Isso inclui, por exemplo, sua estrutura, as informações sobre as quais foram treinados e a necessidade de recursos computacionais. Políticas de uso de modelos, proteção de dados e mitigação de riscos também são levadas em consideração. A lista completa de métricas e metodologia pode ser encontrada no documento de 110 páginas que acompanha o estudo.

Fonte da imagem: Universidade de Stanford, Centro de Pesquisa em Modelos de Fundação

Antes de publicar o relatório, os pesquisadores discutiram os resultados dos testes com os líderes de cada empresa, dando-lhes a oportunidade de argumentar com argumentos sobre avaliações dos quais discordam. Se a equipe considerasse os argumentos dos criadores de IA convincentes, as classificações eram ajustadas. Mesmo tendo em conta uma abordagem tão equilibrada, a pontuação média para todos os modelos foi de apenas 37 pontos em 100 (37%). Com base neste resultado, os investigadores concluíram que nenhum dos modelos até à data proporciona transparência adequada.

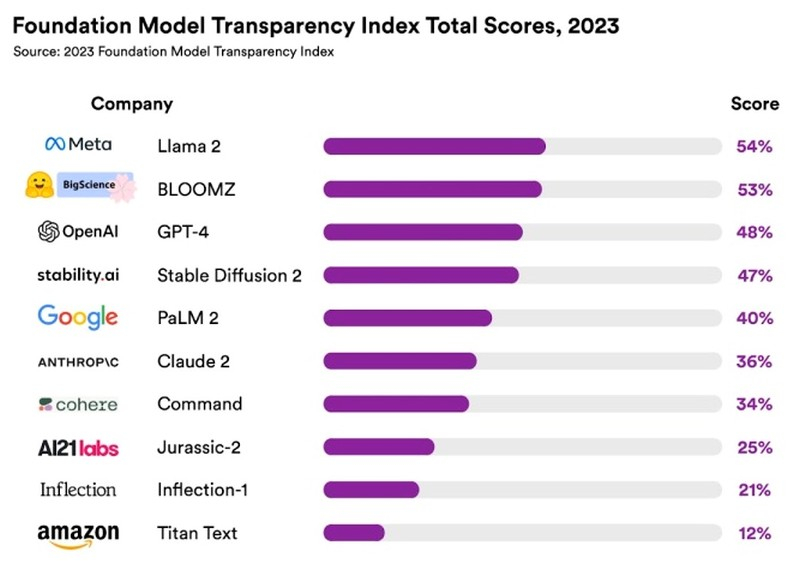

O modelo Llama 2 da Meta✴ ficou em primeiro lugar com pontuação de 54%. O Bloomz da Hugging Face ficou em segundo lugar com 53%, seguido pelo GPT-4 da OpenAI com 48%. “OpenAI, que tem a palavra “aberto” em seu nome, demonstrou claramente uma falta de transparência em relação à maioria dos aspectos de seu modelo carro-chefe GPT-4”, comentaram os pesquisadores sobre este resultado. O modelo Stable Diffusion 2 da Stability AI ficou em quarto lugar com 47%. O modelo PaLM2 do Google, no qual o chatbot de Bard se baseia, completa os cinco primeiros, com pontuação de 40%.

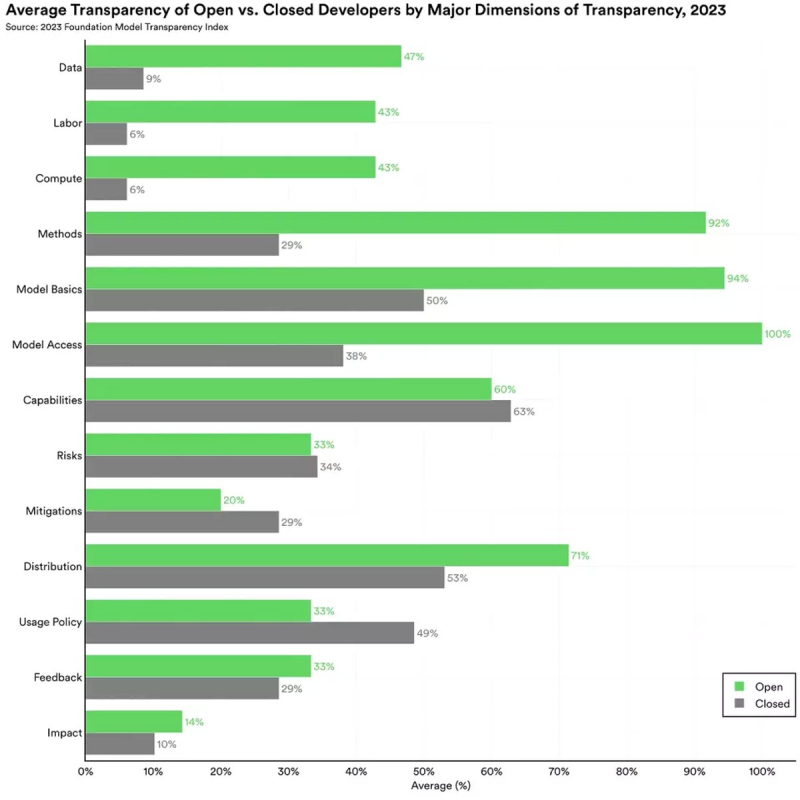

«Um dos debates políticos mais acalorados em IA hoje é se os modelos de IA devem ser abertos ou fechados”, dizem os pesquisadores. Os modelos abertos geralmente receberam classificações mais altas do que os fechados. Um modelo é considerado “aberto” se seu código for divulgado publicamente como software de código aberto. Os modelos abertos incluem modelos de IA como Llama 2 e Bloomz, os fechados incluem GPT-4. A Universidade de Stanford demonstrou os benefícios dos modelos abertos criando seu próprio modelo de IA, Alpaca, baseado no código-fonte aberto Llama da Meta✴.

Os pesquisadores esperam que o FMTI tenha um impacto positivo nas políticas dos criadores de IA e planejam publicar anualmente o ranking do FTMI no futuro. Nove em cada dez participantes do ranking já aderiram a iniciativas do governo dos EUA para o uso responsável da IA. A FMTI pode ser um factor adicional de motivação para que cumpram as suas obrigações.

Os dados de classificação da FMTI também podem ser úteis para a União Europeia no desenvolvimento da próxima edição da Lei de Inteligência Artificial. Os investigadores acreditam que a utilização do novo índice dará aos legisladores maior clareza sobre o estado da IA e o que podem potencialmente mudar através da regulamentação.