Com vídeos falsos se tornando cada vez mais difíceis de detectar, pesquisadores da Universidade Cornell revelaram uma nova tecnologia forense que pode ajudar especialistas a verificar a autenticidade de vídeos. O método envolve a inserção de marcas d’água digitais invisíveis diretamente nos feixes de luz usados para filmar uma cena, como a de um crime.

Fonte da imagem: Cornell University

O conceito de “iluminação codificada por ruído” foi apresentado em 10 de agosto na conferência SIGGRAPH 2025 por Peter Michael, aluno de pós-graduação do Departamento de Ciência da Computação da Universidade Cornell. A abordagem foi proposta e desenvolvida inicialmente pelo Professor Associado Abe Davis (foto à esquerda).

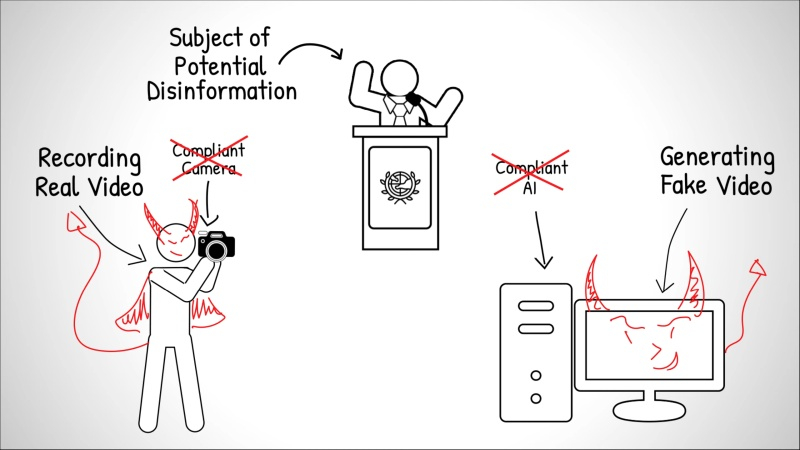

Marcas d’água são normalmente incorporadas diretamente em arquivos de vídeo, alterando pequenos elementos da imagem para criar um identificador oculto. Esses sistemas são eficazes em ambientes controlados, mas exigem interação com o dispositivo ou plataforma que cria o vídeo. Se você usar uma câmera ou software incompatível, a marca d’água digital simplesmente não aparecerá.

Os desenvolvedores propuseram “embutir” uma marca d’água diretamente no fluxo luminoso das fontes de luz durante a gravação. Isso garante que qualquer câmera — de equipamentos profissionais a smartphones — a capture durante a filmagem de uma cena.

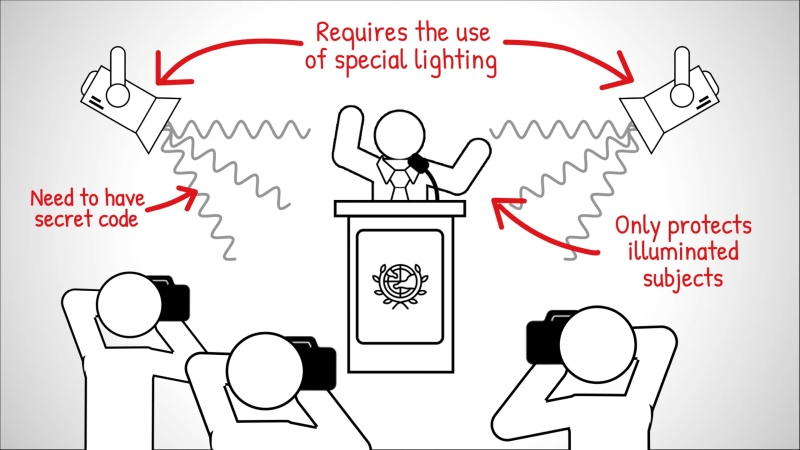

Fontes de luz programáveis, como monitores de computador, equipamentos de estúdio ou algumas luminárias de LED, podem ser programadas com padrões de brilho codificados por meio de software. Lâmpadas comuns também podem ser personalizadas equipando-as com um chip compacto, do tamanho de um selo postal, que altera suavemente a intensidade da luz de acordo com um código secreto.

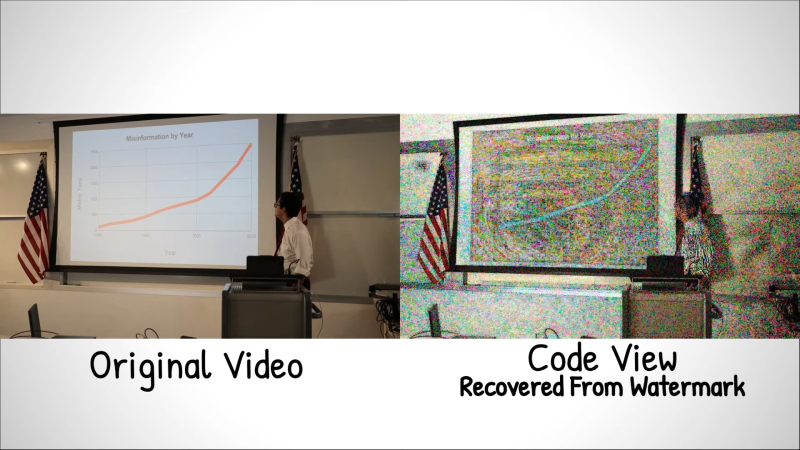

O código incorporado, baseado em pesquisas sobre a visão humana, consiste em pequenas variações na frequência e no brilho da luz, quase imperceptíveis a olho nu e percebidas pelo cérebro como ruído luminoso insignificante. O código exclusivo de cada fonte de luz fornece efetivamente uma gravação paralela, de baixa resolução e com registro de data e hora da cena, o que Davis chama de “códigos de vídeo”.

«”Quando alguém manipula um vídeo, as partes alteradas começam a contradizer o que vemos nesses códigos de vídeo”, explicou Davis. “E se alguém tentar gerar um vídeo falso usando IA, os códigos de vídeo resultantes parecerão apenas variações aleatórias de iluminação.”

Ao analisar imagens de vídeo, especialistas podem detectar sequências ausentes, objetos inseridos ou cenas alteradas. Por exemplo, um fragmento removido de uma entrevista aparecerá como uma lacuna visual no código de vídeo reconstruído, e elementos fabricados aparecerão como áreas pretas sólidas. Pesquisadores demonstraram que até três códigos de iluminação independentes podem ser usados em uma única cena. Essa sobreposição aumenta a complexidade da marca d’água e dificulta a tarefa de potenciais falsificadores.

«Mesmo que um invasor conhecesse essa técnica e conseguisse descobrir os códigos, sua tarefa ainda seria muito mais difícil, acrescentou Davis. “Em vez de falsificar a luz para apenas um vídeo, ele teria que falsificar cada vídeo com códigos separadamente, e todas as falsificações teriam que ser consistentes entre si.”

Testes de campo demonstraram que o método é eficaz em determinadas condições e funciona de forma confiável em uma variedade de tons de pele. Os pesquisadores observam que a tecnologia de iluminação com codificação de ruído é um avanço promissor, mas não é uma panaceia para vídeos falsos. À medida que as ferramentas de IA generativa evoluem, também evoluem os métodos para contornar as ferramentas de autenticação.

«”O vídeo costumava ser visto como uma fonte de informação confiável, mas agora não podemos ter certeza”, disse Davis. “Hoje em dia, é possível gerar quase qualquer vídeo. É interessante, mas também problemático, porque está cada vez mais difícil distinguir o real do falso.”