Na conferência Google I/O, o Google anunciou o supercomputador AI baseado em nuvem Compute Engine A3, que poderá oferecer até 26.000 aceleradores NVIDIA H100 aos clientes da empresa. Esta é mais uma prova de quanta importância o Google dá à batalha competitiva com a Microsoft pela supremacia da IA. Curiosamente, o supercomputador público mais rápido do mundo, o Frontier, é alimentado por 37.000 aceleradores AMD Instinct 250X.

Fonte da imagem: NVIDIA

«Para nossos clientes, podemos fornecer supercomputadores A3 com até 26.000 GPUs em um único cluster e estamos trabalhando para criar vários clusters nas maiores regiões”, disse um porta-voz do Google, acrescentando que “nem todos os nossos locais serão dimensionados para um tamanho tão grande tamanho.” Assim, qualquer cliente de nuvem do Google pode ter à sua disposição um supercomputador aprimorado para IA com até 26.000 aceleradores de computação.

Os clientes do Google Cloud poderão treinar e executar aplicativos de IA por meio de máquinas virtuais A3 e usar os serviços de desenvolvimento e gerenciamento de IA do Google disponíveis por meio da Vertex AI, Google Kubernetes Engine e Google Compute Engine. As máquinas virtuais A3 são baseadas nos chips Intel Xeon de quarta geração (Sapphire Rapids), que funcionam em conjunto com os aceleradores H100. Ainda não está claro se as CPUs virtuais suportarão os aceleradores de inferência embutidos nos chips Sapphire Rapids.

O Google afirma que o A3 oferece até 26 exaflops de desempenho para tarefas de IA, reduzindo bastante o tempo e o custo do treinamento de IA. Lembre-se de que a empresa lista o desempenho de treinamento de precisão única TF32 Tensor Core AI, que é cerca de 30 vezes mais rápido que a matemática de ponto flutuante de precisão dupla FP64 usada na maioria dos aplicativos clássicos.

O número de GPUs tornou-se um cartão de visita importante para os provedores de nuvem promoverem seus serviços de IA. O supercomputador AI da Microsoft no Azure, construído em colaboração com a OpenAI, possui 285.000 núcleos de CPU e 10.000 aceleradores de GPU. A Microsoft também anunciou seu supercomputador AI de próxima geração com ainda mais GPUs. O Oracle Cloud Service fornece acesso à nuvem para clusters de até 512 GPUs e está trabalhando em uma nova tecnologia para acelerar a troca de dados entre eles.

Fonte da imagem: unsplash.com

Enquanto o Google continua a anunciar seus próprios chips de IA TPU v4 usados para executar aplicativos internos de IA, como o Google Bard, os aceleradores de GPU da NVIDIA se tornaram o padrão de fato para a construção de infraestrutura de IA. A ferramenta de programação paralela NVIDIA CUDA oferece os resultados mais rápidos com núcleos AI dedicados e núcleos gráficos H100.

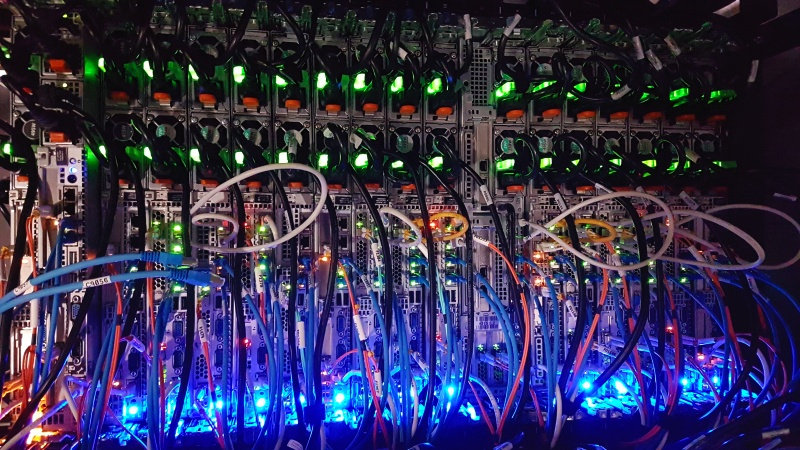

Os provedores de nuvem perceberam que uma abordagem de tamanho único não é suficiente – requer uma infraestrutura criada especificamente para treinamento de IA. Portanto, os sistemas baseados em aceleradores H100 estão sendo implantados massivamente, e a NVIDIA lançou seu próprio serviço de nuvem DGX em março, cujo custo de aluguel é significativamente maior em comparação com os sistemas de aluguel baseados em aceleradores A100 da geração anterior. O H100 é considerado 30% mais econômico e 3 vezes mais rápido que o NVIDIA A100, por exemplo, no treinamento de um grande modelo de linguagem MosaicGPT com sete bilhões de parâmetros.

O A3 é o primeiro supercomputador de IA baseado em nuvem a ter GPUs conectadas por meio da Mount Evans Infrastructure Processing Unit (IPU), desenvolvida em conjunto pelo Google e pela Intel. “O A3 usa IPUs de 200 Gb/s, a transferência de dados de uma GPU para outra ignora a CPU por meio de interfaces separadas. Isso permite até 10 vezes a largura de banda da rede em comparação com nossas VMs A2, com baixa latência e alta estabilidade de largura de banda”, disse o Google.

Fonte da imagem: Pixabay

O supercomputador A3 é baseado na estrutura de rede Júpiter, que conecta clusters de CPU dispersos geograficamente por meio de canais de comunicação de fibra óptica. Uma máquina virtual A3 inclui oito aceleradores H100 interconectados usando a tecnologia patenteada da NVIDIA. Os aceleradores serão conectados via switches NVSwitch e usarão NVLink com taxas de dados de até 3,6 Tbps.

A Microsoft logo estará pronta para oferecer uma velocidade semelhante em seu supercomputador AI, construído com as mesmas tecnologias da NVIDIA. Ao mesmo tempo, o supercomputador da Microsoft possui recursos de rede do fabricante de chips Quantum-2 com velocidades de até 400 Gbps. A Microsoft está mantendo o número de aceleradores H100 em seu supercomputador AI de próxima geração em segredo por enquanto. Mas é improvável que seja menor que o do principal concorrente.