Sensores de profundidade estão se tornando uma solução popular. De uma forma ou de outra, eles são usados em sistemas de visão computacional, por exemplo, nos smartphones da Apple para desbloquear o reconhecimento de rosto do usuário ou como câmeras TOF em carros autônomos, em fones de ouvido de realidade virtual e aumentada e muito mais. Um problema, todas essas soluções requerem um poder computacional relativamente grande para o processamento de dados, pois todas elas usam o princípio de calcular os atrasos entre o envio de um feixe de varredura para o objeto e o retorno na forma de reflexão.

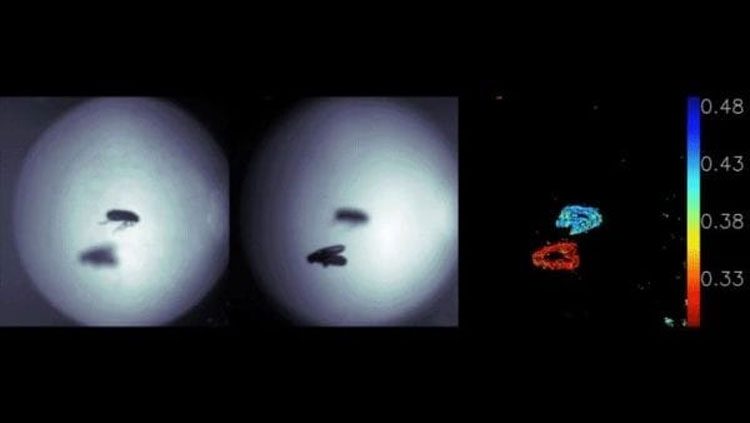

Aranha saltadora usa visão desfocada para estimar a distância (Qi Guo e Zhujun Shi / Universidade de Harvard)

Uma abordagem um pouco diferente para avaliar a distância do objeto usa o cérebro humano e o cérebro dos animais – essa é a visão estereoscópica. Essa opção também requer um poder computacional significativo para analisar imagens de cada olho. Mas na natureza existem cérebros tão pequenos que eles não têm recursos para essa análise. Por exemplo, jumpers. Mas esses insetos impressionam pelo tamanho do corpo e saltos extremamente precisos sobre a vítima. Como eles avaliam a distância do objeto de ataque e é possível levar esse método a serviço?

Pesquisadores da Harvard School of Engineering and Applied Sciences. John A. Paulson (SEAS) estudou a estrutura dos olhos de aranhas saltadoras e incorporou o resultado em um sensor de profundidade simples e compacto. A natureza e a evolução criaram os olhos principais desses insetos na forma de uma retina multicamada. Em cada uma das camadas, a imagem é projetada com um grau diferente de desfoque, dependendo da distância do objeto. Por qual camada está a imagem mais nítida, a aranha entende a que distância o alvo está dela. Os cientistas não repetiram cegamente a natureza e criaram um conjunto horizontal de lentes (lentes de metal) com uma projeção em um único sensor de imagem. Imagens com diferentes graus de desfoque são formadas no sensor. Sim, é necessário um determinado algoritmo para o processamento de imagens, mas é mais simples que para as câmeras ToF. Além disso, o sistema de projeção parece ser o mais simplificado e barato possível, o que aumentará ainda mais a popularidade dessa tecnologia quando ela for levada ao estágio de produção comercial. Tais sensores prometem encontrar aplicação em várias áreas onde é necessário avaliar a distância dos objetos – da vida cotidiana à robótica e astronomia. .