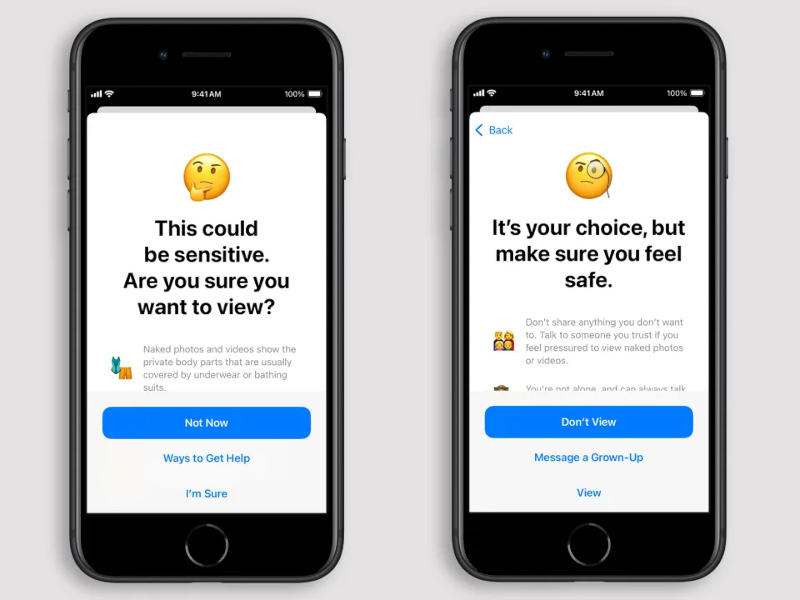

A Apple adicionou um novo recurso ao iOS 18.2 que visa proteger a moralidade e a saúde mental de menores. Ao detectar uma imagem de nudez, o sistema adiciona desfoque a ela, exibe um aviso e exige confirmação para continuar trabalhando com esses materiais – é necessário inserir uma senha. Ao mesmo tempo, a nova função não invade a criptografia ponta a ponta e não implica backdoors para as autoridades

Fonte da imagem: apple.com

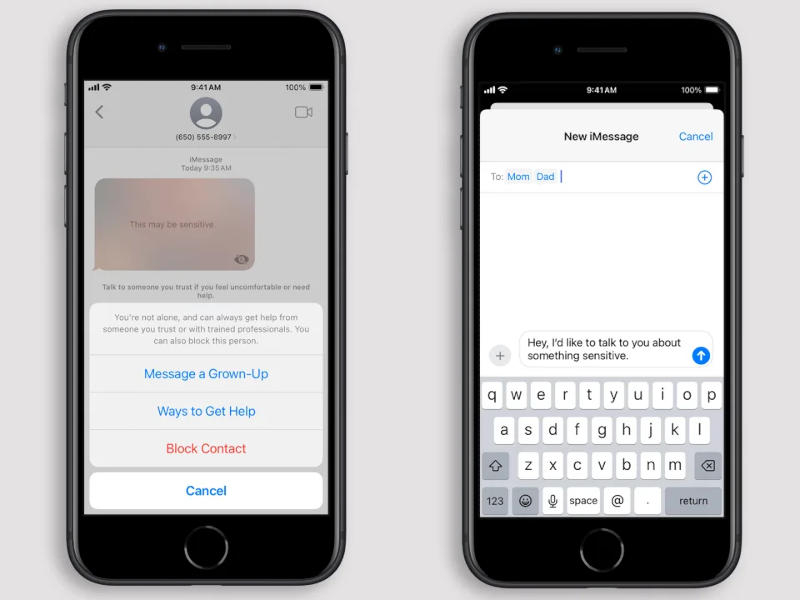

A função é baseada em algoritmos de aprendizado de máquina. Ao detectar nudez, adiciona automaticamente um efeito de desfoque, exibe uma mensagem sobre a possível natureza sensível do conteúdo e oferece opções para outras ações: deixar correspondência pessoal ou em grupo, bloquear o interlocutor ou acessar recursos de segurança online. Também existe a opção de enviar um alerta aos pais ou responsáveis.

No iPhone e iPad, o recurso analisa imagens em Mensagens, AirDrop, pôsteres de contatos, mensagens de vídeo FaceTime e “certos aplicativos de terceiros” com a capacidade de compartilhar fotos ou vídeos. Recursos semelhantes aparecerão em PCs, smartwatches e no fone de ouvido Vision Pro – você precisará instalar iOS 18, iPadOS 18, macOS 15 Sequoia ou visionOS 2. A função estreou na Austrália, onde as autoridades pretendem adotar regulamentos obrigando os gigantes da tecnologia a controlar materiais relacionados com o terrorismo e o tratamento violento de crianças – “quando for tecnicamente viável”.

Em 2021, a Apple queria implementar um sistema nos telefones que analisasse localmente todo o conteúdo desse tipo de material e notificasse automaticamente as autoridades sobre possíveis incidentes, mas havia preocupações de que isso violaria a privacidade do usuário e que regimes autoritários tentariam abusar do recurso. Um ano depois, a empresa abandonou a iniciativa.