O novo projeto caro de Elon Musk, o supercomputador xAI Colossus para sistemas de inteligência artificial, abriu suas portas ao público pela primeira vez. Jornalistas do recurso ServeTheHome foram autorizados a entrar nas instalações. Eles falaram detalhadamente sobre o cluster nos servidores da Supermicro, cuja montagem durou 122 dias – está funcionando há quase dois meses.

Fonte da imagem: servethehome.com

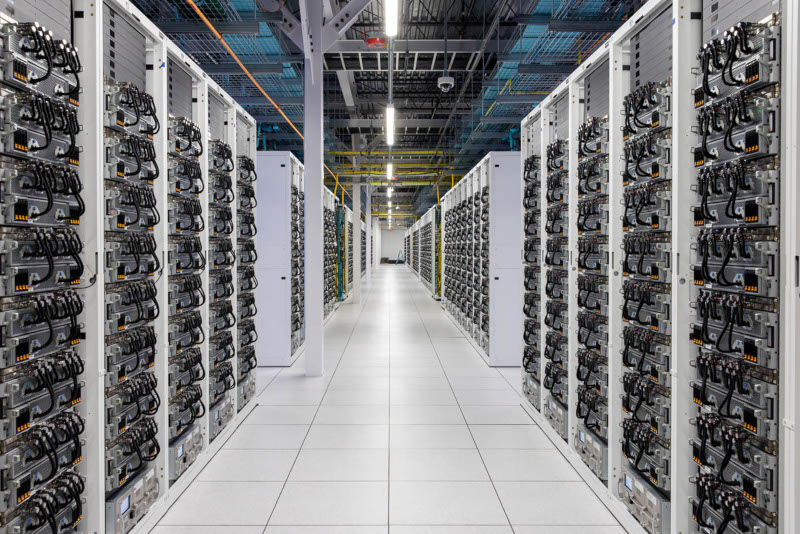

Servidores com GPUs são construídos na plataforma Nvidia HGX H100. Cada um deles inclui oito aceleradores Nvidia H100 e um sistema universal de refrigeração líquida Supermicro 4U com componentes hot-swap para cada GPU individualmente. Os servidores são instalados em racks de oito, resultando em 64 aceleradores por rack. Na parte inferior de cada rack há outra unidade Supermicro 4U com sistema de bombeamento redundante e sistema de monitoramento de rack.

Os racks são agrupados em grupos de oito, totalizando 512 GPUs por array. Cada servidor possui quatro fontes de alimentação redundantes; na parte traseira dos racks você pode ver fontes de alimentação trifásicas e switches Ethernet; também existem coletores do tamanho de rack que suportam refrigeração líquida. O cluster Colossus contém mais de 1.500 racks ou cerca de 200 arrays. Os aceleradores nesses arrays foram instalados em apenas três semanas, disse o CEO da Nvidia, Jensen Huang, anteriormente.

Devido aos altos requisitos de rendimento do superaglomerado de IA, que treina modelos continuamente, os engenheiros de xAI tiveram que fazer esforços em termos de rede. Cada placa gráfica está equipada com um controlador de rede dedicado de 400 GbE com um adaptador de rede adicional de 400 GbE por servidor. Ou seja, cada servidor Nvidia HGX H100 possui Ethernet de 3,6 Tbps – sim, todo o cluster roda em Ethernet, não em InfiniBand ou outras interfaces exóticas padrão em supercomputadores.

O supercomputador requer não apenas GPUs, mas também armazenamento e CPUs para treinar modelos de IA, incluindo Grok 3, mas xAI divulgou informações apenas parcialmente sobre eles. Os vídeos censurados mostram servidores alimentados por chips x86 em gabinetes da Supermicro – eles também são equipados com refrigeração líquida e são projetados para atuar como armazenamento de dados ou cargas de trabalho centradas na CPU.

Baterias Tesla Megapack também estão instaladas no local. Quando o cluster está em operação, são possíveis mudanças bruscas no consumo de energia, por isso essas baterias, com capacidade de até 3,9 MWh cada, tiveram que ser instaladas entre a rede elétrica e o supercomputador como buffer de energia.