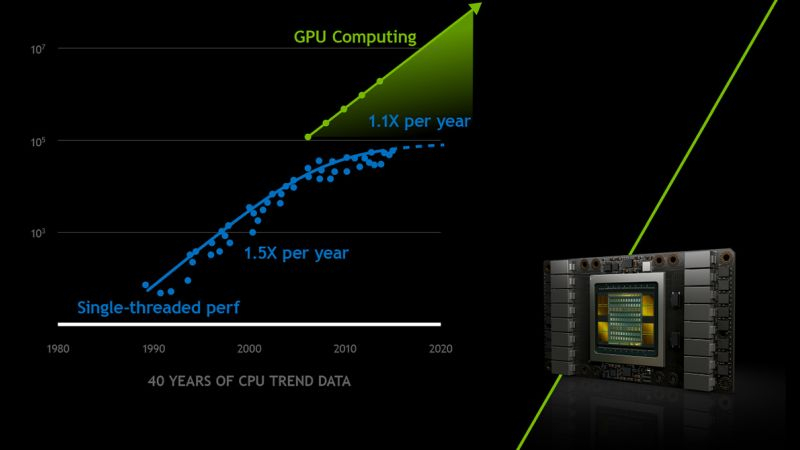

A capacidade das GPUs de dimensionar bem o desempenho da computação diante das clássicas desacelerações da Lei de Moore tem sido retratada há muito tempo pela administração da Nvidia como uma tábua de salvação para toda a humanidade. À medida que o crescimento explosivo dos sistemas de inteligência artificial começa a abrandar, novos desafios de escala de desempenho surgem no horizonte.

Fonte da imagem: NVIDIA

Como observa o Financial Times, para muitos no Vale do Silício, a Lei de Moore foi suplantada por um novo conceito: a “lei de escala” da inteligência artificial. Até recentemente, acreditava-se que dimensionar a infraestrutura computacional e saturá-la com maiores volumes de dados levava a mudanças qualitativas nos sistemas de inteligência artificial. Essencialmente, esperava-se que a IA se tornasse “mais inteligente” devido a isto. Como resultado, todas as grandes empresas do sector tecnológico têm-se concentrado em aumentar activamente o poder computacional dos seus centros de dados durante vários trimestres consecutivos.

Anteriormente, acreditava-se que o atual ritmo de crescimento da produtividade dos data centers continuaria até que fosse criada uma “superinteligência”, capaz de superar a inteligência humana, mas baseada em algoritmos e dependências de software. Somente nas últimas semanas os especialistas começaram a expressar preocupação com o fato de os mais recentes modelos de grandes linguagens da OpenAI, Google e Anthropic não estarem fazendo o progresso necessário em relação às tendências anteriores.

O cofundador da OpenAI, Ilya Sutskever, disse recentemente: “A década de 2010 foi a era da expansão, mas agora estamos de volta à era da descoberta e da admiração”. Notavelmente, Sutskever estava confiante há um ano que toda a superfície da Terra precisaria de ser coberta com painéis solares que alimentariam igualmente numerosos centros de dados.

Muitos participantes no mercado concordam que a fase de formação activa de modelos linguísticos está a chegar ao fim, mas para manter o actual ritmo de progresso, a próxima fase deve ser abordada. O CEO da Microsoft, Satya Nadella, acredita que a desaceleração no treinamento de grandes modelos de linguagem não limita particularmente o ritmo do progresso à medida que os sistemas de inteligência artificial ganham a capacidade de raciocinar. Segundo o fundador da Nvidia, Jensen Huang, mesmo uma redução na necessidade de recursos computacionais para treinar modelos de linguagem não significará uma redução na demanda por seus produtos. Os desenvolvedores de sistemas de IA se esforçarão para reduzir o tempo de resposta do sistema às perguntas feitas pelos usuários. Essa corrida exigirá ainda mais recursos de hardware, segundo o líder permanente da Nvidia, e isso é bom para os negócios da empresa. O presidente da Microsoft, Brad Smith, está convencido de que a demanda do mercado por chips aceleradores continuará a crescer por pelo menos mais um ano.

No entanto, a transição dos sistemas de IA para uma nova fase de desenvolvimento deve ser assegurada pelo surgimento de áreas reais de aplicação úteis para as empresas. Ainda há problemas com isto, porque qualquer inovação deve trazer benefícios materiais, e o efeito da utilização da IA na sua forma actual em muitos sectores da economia ainda não é tão óbvio. Isso não impediu que os gigantes da tecnologia investissem enormes quantias de dinheiro na expansão dos seus recursos computacionais. Este ano, as despesas de capital combinadas da Microsoft, Amazon, Google e Meta✴ deverão exceder os 200 mil milhões de dólares, e no próximo ano provavelmente ultrapassarão os 300 mil milhões de dólares, de acordo com representantes do Morgan Stanley.