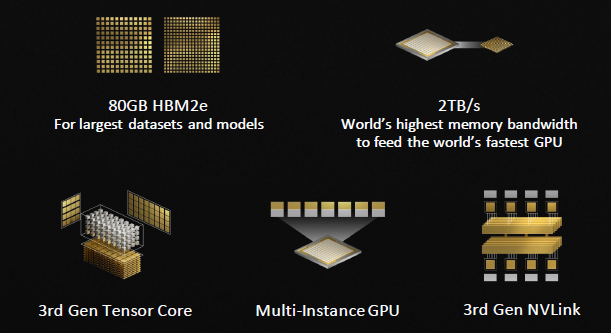

Menções sobre a versão NVIDIA A100 com interface PCI Express 4.0 e 80 GB de memória HBM2e começaram a piscar na documentação do desenvolvedor alguns dias antes do anúncio, então o próprio fato da estreia deste acelerador de computação não foi uma grande surpresa. A novidade oferece largura de banda de memória no nível de 2 TB / s.

Fonte da imagem: NVIDIA

Lembre-se que até hoje era possível obter o NVIDIA A100 com 80 GB de memória apenas na versão SXM4, que tem como foco o uso em sistemas servidores. A versão PCI Express 4.0 do A100 até agora só foi oferecida com 40 GB de memória HBM2e. Agora a lacuna foi eliminada e a placa PCI Express 4.0 coloca a GPU A100 com arquitetura Ampere e 80 GB de memória HBM2e ao lado dela.

Fonte da imagem: NVIDIA

A GPU NVIDIA A100 de 7 nm da TSMC contém 54 bilhões de transistores por chip de 826 mm2, possui 6912 núcleos CUDA, 432 núcleos de tensor e oferece até 9,7 teraflops de desempenho de ponto flutuante de precisão dupla (FP64) … A nova versão do A100 não apenas dobrou a quantidade de memória HBM2e, mas também aumentou sua largura de banda em 25% – até 2 TB / s. A interface NVLink de terceira geração permite que esses aceleradores sejam combinados em pacotes para melhorar o desempenho do sistema, e a tecnologia de virtualização permite que uma GPU divida os recursos físicos em sete segmentos independentes, o que é muito conveniente para alugar capacidade em sistemas em nuvem.