Uma das principais desenvolvedoras de chips para trabalhar com sistemas de inteligência artificial, a Cerebras Systems, juntamente com o provedor de nuvem G42, apresentou um projeto para criar nove supercomputadores poderosos sob medida para tarefas de IA. O primeiro deles será o sistema CG-1 (Condor Galaxy 1), que será o primeiro no mundo a atingir uma performance de 4 Eflops. Isso acontecerá até o final deste ano.

Fonte da imagem: cerebras.net

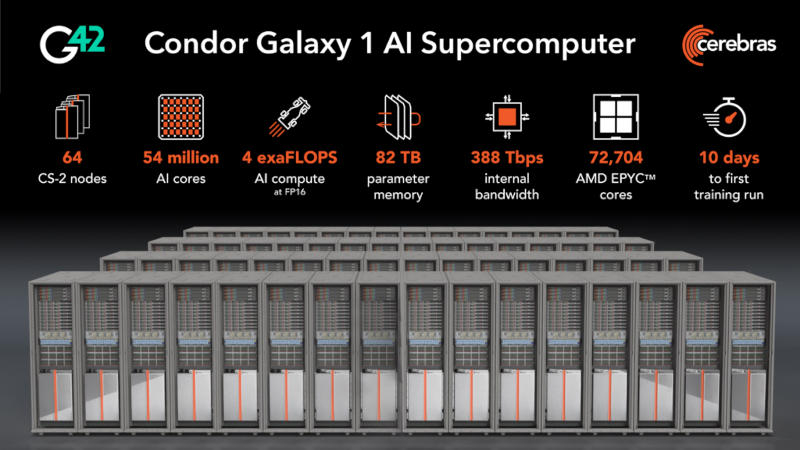

O supercomputador Condor Galaxy 1 apresenta as seguintes especificações:

- Desempenho 4 Eflops (FP16);

- 54 milhões de núcleos otimizados para IA;

- 64 sistemas Cerebras CS-2;

- 82 TB de armazenamento de parâmetros;

- Suporte para 600 bilhões de parâmetros na configuração básica com possibilidade de expansão para 100 trilhões;

- Largura de banda interna do cluster 386 Tbps;

- 72.804 núcleos de processador AMD EPYC Gen 3;

- Suporte de hardware integrado para aprendizado com uma sequência de até 50.000 tokens sem bibliotecas de terceiros;

- Modelo de programação paralela com escalonamento de desempenho linear.

A Cerebras Systems é mais conhecida por sua plataforma CS-2, alimentada por chips gigantes Wafer-Scale Engine 2 (WSE-2) com 2,6 trilhões de transistores, feitos de um único wafer de silício e contendo 850.000 núcleos tensores de IA. Na primeira etapa, o Condor Galaxy 1 receberá 32 sistemas Cerebras CS-2, que lhe darão desempenho de 2 Eflops, e até o final deste ano, seu número dobrará, assim como o desempenho do supercomputador, que crescerá para 4 Eflops (segundo estágio).

A Cerebras Systems decidiu não parar por aí: além disso, está prevista a criação dos supercomputadores CG-2 e CG-3, que na terceira etapa do primeiro semestre de 2024 serão combinados na primeira rede distribuída de supercomputadores baseada em 192 sistemas CS-2 com desempenho total de 12 Eflops. Por fim, na quarta etapa, mais seis supercomputadores serão conectados a essa rede, garantindo a operação conjunta de 576 sistemas CS-2 e 36 Eflops.

A empresa enfatizou que os clusters Wafer-Scale foram originalmente projetados para funcionar como um único acelerador. Com uma única unidade de memória CG-1 de 82 TB, até mesmo os maiores modelos AI podem ser colocados diretamente na memória sem a necessidade de soluções de software adicionais. Ou seja, na infraestrutura do Cerebras, modelos com 1 bilhão e 100 bilhões de parâmetros operam com base em um único código suportando longas sequências de 50.000 tokens.

Como resultado, uma implementação padrão do GPT no CG-1 exigirá apenas 1.200 linhas de código – 30 vezes menos que os análogos existentes. E o dimensionamento do sistema é realizado alocando um múltiplo da quantidade de recursos em uma relação linear simples. Ou seja, um modelo com 40 bilhões de parâmetros é treinado 40 vezes mais do que um modelo com 1 bilhão de parâmetros com os mesmos recursos – ou no mesmo tempo, se a quantidade de recursos for aumentada em 40 vezes.