A OpenAI e a Nvidia são amplamente consideradas as principais beneficiárias do boom da IA e mantêm uma forte parceria que deverá ser reforçada pelo acordo de US$ 100 bilhões. Fontes, no entanto, indicam que a OpenAI pode não estar satisfeita com o desempenho dos aceleradores da Nvidia em inferência e, portanto, está buscando uma alternativa adequada.

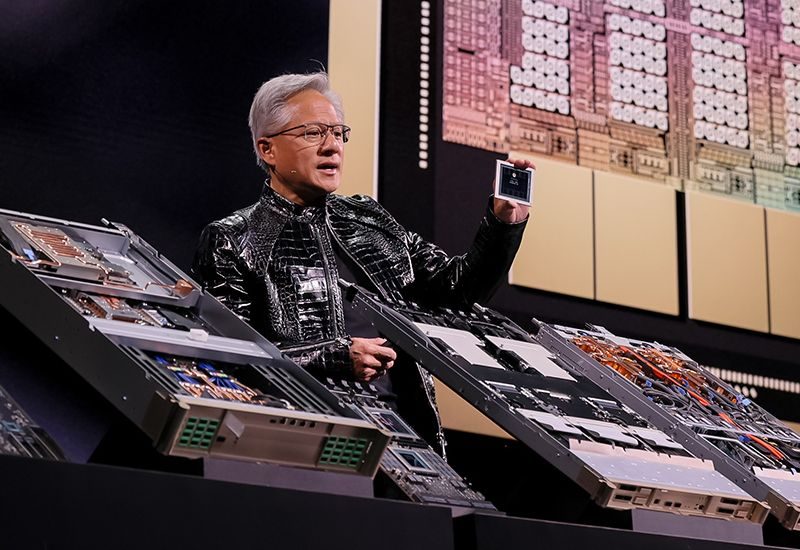

Fonte da imagem: Nvidia

A Reuters obteve essa informação por meio de seus próprios canais, embora a OpenAI e a Nvidia continuem a expressar publicamente extrema lealdade mútua. Segundo a fonte, a OpenAI gostaria de substituir até 10% dos aceleradores em sua infraestrutura de computação por soluções de terceiros que apresentem melhor desempenho em tarefas de inferência — ou seja, que trabalhem de forma mais eficiente com grandes modelos de linguagem já treinados.

A OpenAI chegou a considerar o fornecimento de chips desenvolvidos pela Cerebras e pela Groq para essas startups, mas a Nvidia decidiu antecipar o negócio adquirindo a Groq por US$ 20 bilhões no ano passado. A Groq já havia negociado com outros investidores para investir até US$ 14 bilhões, mas a Nvidia ofereceu mais, garantindo uma estrutura de negócio bastante específica. Pelos termos, a Groq manteve a opção de licenciar seus desenvolvimentos para outras empresas, mas a Nvidia efetivamente incorporou os principais desenvolvedores de aceleradores da Groq. A Groq agora pode oferecer a outras empresas apenas software em nuvem. Ao mesmo tempo, surgem questionamentos sobre a viabilidade do negócio, no qual a Nvidia se ofereceu para investir até US$ 100 bilhões no capital da OpenAI. Até o momento, as partes negaram qualquer problema nessa área, embora a Nvidia enfatize que seus compromissos não são rígidos.

A OpenAI concluiu com sucesso um acordo com a Cerebras e agora adquirirá os chamados “aceleradores rei” da empresa, que apresentam bom desempenho em tarefas de inferência. O problema da OpenAI até então era sua forte dependência de aceleradores da Nvidia e da AMD, que utilizam hardware externo, embora muito rápido.A memória HBM, por exemplo, oferece melhor desempenho em inferência, enquanto chips com memória integrada maior apresentam melhor desempenho. Essas soluções são oferecidas pela Groq e Cerebras, bem como pela concorrente Google. Curiosamente, a Anthropic conseguiu fechar um acordo com o Google, o que obrigou a OpenAI a buscar alternativas.

Segundo alguns relatos, a OpenAI encontrou ineficiência nos aceleradores da Nvidia ao criar o agente de IA Codex, que auxilia desenvolvedores na escrita de código. Usuários comuns do ChatGPT, por exemplo, não enfrentam esses problemas, mas a OpenAI buscará oferecer outras soluções de hardware para programadores, como as da Cerebras, para melhorar o desempenho das ferramentas de software correspondentes.