Este ano, a Nvidia lançará uma família de aceleradores computacionais Blackwell de última geração, que incluirá soluções apenas com GPUs, como o B100 e B200, e soluções que combinam uma GPU e um processador central Arm de design próprio, o Blackwell GB200. . O lançamento de novos chips Nvidia aumentará significativamente a demanda por embalagens de chips usando a avançada tecnologia TSMC CoWoS, estão confiantes os analistas da TrendForce.

Fonte da imagem: nvidia.com

Embora os aceleradores GH200 representassem apenas 5% das remessas de GPU de alto desempenho da Nvidia, com o GB200 esse número aumentará para 40-50% até 2025. A Nvidia planeja lançar o GB200 e o B100 no segundo semestre do ano, e o empacotamento dos chips exigirá tecnologia CoWoS-L complexa e de alta precisão, o que tornará o processo de teste trabalhoso. Será necessário mais tempo para otimizar a série Blackwell para sistemas de servidores de IA em áreas como conectividade de rede e desempenho de refrigeração. Espera-se que a produção dos produtos GB200 e B100 comece em volumes significativos não antes do quarto trimestre de 2024 ou do primeiro trimestre de 2025.

O lançamento dos aceleradores GB200, B100 e B200 exigirá um aumento na capacidade das linhas de embalagem de chips CoWoS. A expectativa é que a TSMC aumente sua produtividade para quase 40 mil chips por mês até o final do ano – um aumento de 150% em relação ao ano passado. Até 2025, a capacidade total planeada poderá quase duplicar, prevendo-se que a procura da Nvidia represente mais de metade dessa capacidade. Outros fornecedores, como Amkor e Intel, estão atualmente se concentrando na tecnologia CoWoS-S, visando principalmente a série H da Nvidia.

Fonte da imagem: trendforce.com

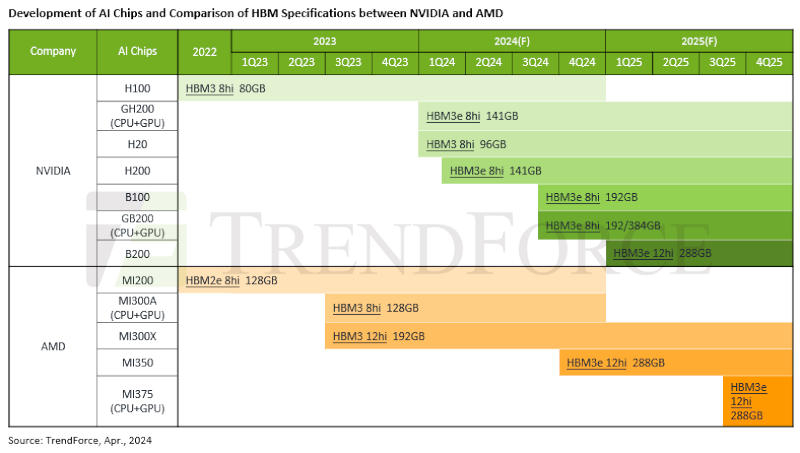

Os analistas da TrendForce também identificaram três tendências principais no desenvolvimento de memória HBM para produtos Nvidia e AMD após 2024. Primeiro, espera-se uma transição do HBM3 para o HBM3e. No segundo semestre de 2024, a Nvidia começará a aumentar as remessas de aceleradores H200 equipados com HBM3e, que substituirá o H100 como seu principal produto. Seguirão os modelos GB200 e B100 também com HBM3e. Até o final do ano, a AMD lançará um novo acelerador MI350, que poderá ser precedido por modelos intermediários, como o MI32x, voltados para competir com o H200 – todos receberão HBM3e.

Em segundo lugar, a capacidade da HBM aumentará. Hoje, os aceleradores Nvidia H100 com 80 GB de memória são usados principalmente – no final de 2024 serão 192–288 GB. O acelerador AMD MI300A recebeu 128 GB de memória, mas os “vermelhos” também aumentarão a capacidade para 288 GB. Em terceiro lugar, a memória HBM3e mudará sua configuração de pilhas 8Hi (8 chips DRAM empilhados uns sobre os outros) para 12Hi. O B100 e o GB200 da Nvidia apresentam atualmente um HBM3e 8Hi de 192 GB, enquanto o B200 contará com um HBM3e 12Hi de 288 GB em 2025. O acelerador AMD MI350, que chegará até o final deste ano, e a série MI375 prevista para 2025, deverão receber o HBM3e 12Hi, também com capacidade de 288 GB.