Grandes modelos de linguagem de inteligência artificial exigem recursos significativos não apenas durante o treinamento, mas também durante a inicialização – são necessárias quantidades significativas de RAM e processadores gráficos poderosos. Uma alternativa foi proposta pelos criadores do Exo, um programa gratuito para lançamento distribuído de IA em diversos dispositivos. Quase como torrents, só que para executar IA.

Fonte da imagem: github.com/exo-explore/exo

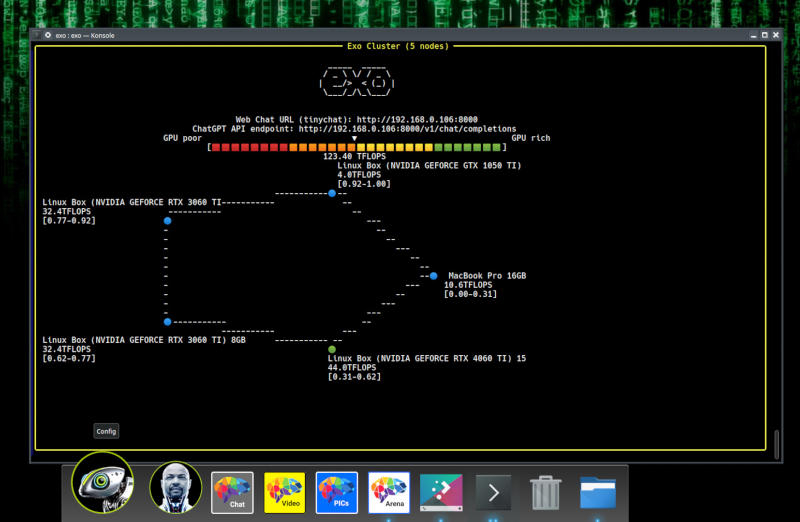

O aplicativo permite que você combine o poder de computação de vários computadores, smartphones e até mesmo computadores de placa única, incluindo o Raspberry Pi, para executar modelos que nenhum dos sistemas existentes do usuário conseguiria lidar sozinho. Os recursos dos dispositivos são combinados por meio de uma rede ponto a ponto.

O Exo distribui dinamicamente a carga criada por um grande modelo de linguagem entre os dispositivos disponíveis na rede, posicionando suas camadas com base na quantidade de RAM disponível e no poder de computação disponível. LLaMA, Mistral, LlaVA, Qwen e DeepSeek são suportados. O programa pode ser instalado em dispositivos com Linux, macOS, Android ou iOS – ainda não há versão para Windows. O Exo requer uma versão mínima do Python 3.12.0 para ser executado e, em máquinas Linux com gráficos Nvidia, vários outros componentes.

Um modelo de IA que requer 16 GB de RAM pode ser executado em dois laptops com 8 GB cada; e o poderoso DeepSeek R1, que requer 1,3 TB de memória, pode, em teoria, ser executado em um cluster de 170 Raspberry Pi 5 com 8 GB. A velocidade e a latência da rede podem reduzir a qualidade do desempenho do modelo, e os desenvolvedores do Exo alertam que dispositivos de baixo desempenho podem deixar a IA mais lenta, mas com cada dispositivo adicionado à rede, o desempenho geral aumenta. Também não podemos esquecer dos riscos de segurança que inevitavelmente surgem ao executar cargas de trabalho juntas em várias máquinas. Mesmo com essas ressalvas, o Exo parece ser uma alternativa promissora aos recursos de nuvem.