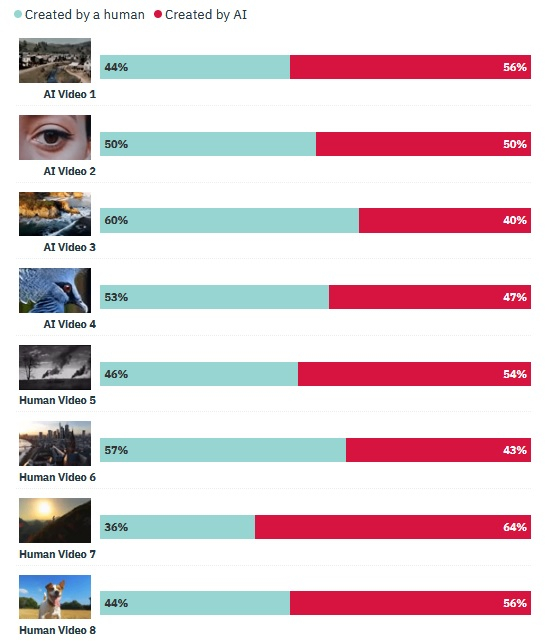

Há algumas semanas, a Open AI introduziu a rede neural Sora, que é capaz de gerar vídeos realistas de até um minuto com resolução de 1920 × 1080 pixels com base em uma descrição de texto. Agora, a HarrisX conduziu uma pesquisa pedindo aos adultos americanos que distinguissem um vídeo gerado por IA de um vídeo real. Descobriu-se que a maioria dos entrevistados cometeu erros em 5 dos 8 vídeos oferecidos na pesquisa.

Fonte da imagem: Mariia Shalabaieva / unsplash.com

Mais de 1.000 americanos participaram da pesquisa, que aconteceu entre 1º e 4 de março nos Estados Unidos. Os autores do estudo geraram quatro vídeos de alta qualidade usando a rede neural Sora e também selecionaram quatro vídeos curtos filmados no mundo real. Os entrevistados viram esses vídeos em ordem aleatória e seu objetivo era determinar se o vídeo foi feito por um ser humano ou gerado por IA. As opiniões dos participantes da pesquisa foram divididas, mas em 5 dos 8 casos, a maioria dos entrevistados deu a resposta errada.

Esta pesquisa indica que o conteúdo criado através de redes neurais generativas está se tornando cada vez mais realista e é cada vez mais difícil distingui-lo do real. É por isso que os apelos às autoridades para a necessidade de regulamentação legislativa deste segmento têm se tornado mais frequentes em diferentes países. Entre outras coisas, propõe-se obrigar os utilizadores de redes neurais a marcar o conteúdo gerado em conformidade, para que não engane outras pessoas e não se torne uma fonte de desinformação.

Fonte da imagem: variedade.com

O algoritmo Sora ainda não está disponível ao público em geral, mas já causa sérias preocupações na sociedade, especialmente na indústria do entretenimento, onde o desenvolvimento de tecnologias de geração de vídeo acarreta muitas consequências negativas, por exemplo, para os estúdios cinematográficos. Além disso, levanta-se cada vez mais a questão de que algoritmos como o Sora podem ser usados para criar vídeos falsos com políticos e celebridades, o que pode levar às consequências mais imprevisíveis.