Um grande laboratório na sede do Google em Mountain View, Califórnia, abriga centenas de racks de servidores, executando outras tarefas além do mecanismo de busca ou cargas de trabalho do Google Cloud. Unidades de processamento de tensores (TPUs) desenvolvidas pelo próprio Google são testadas aqui. Os jornalistas da CNBC conseguiram dar uma olhada dentro deste laboratório.

Fonte da imagem: alban/unsplash.com

As TPUs do Google surgiram em 2015 e foram disponibilizadas para clientes em nuvem em 2018 – elas são usadas, em particular, para treinar modelos Apple Intelligence e Google Gemini. O Google foi o primeiro provedor de nuvem a construir seus próprios chips de IA – a Amazon só anunciou seu Inferentia três anos depois, e a Microsoft só revelou o Maia no final de 2023. Mas essa primazia não ajudou o Google a se tornar líder na corrida da IA generativa: o Gemini foi lançado mais de um ano depois do OpenAI ChatGPT. Ao mesmo tempo, as ofertas na área de IA ajudaram o Google Cloud a ganhar impulso: este segmento da empresa apresentou um crescimento de 29% e a receita trimestral ultrapassou os 10 mil milhões de dólares pela primeira vez, de acordo com o último relatório trimestral da Alphabet.

O Google teve a ideia de criar seu próprio chip quando em 2014 pensaram quais recursos deveriam ter para que todos os usuários dos serviços da empresa pudessem utilizar a interface de voz por pelo menos 30 segundos por dia. No final das contas, o número de computadores nos data centers precisava ser duplicado. O Google TPU ajudou a melhorar a eficiência em algumas tarefas em até 100 vezes. A empresa ainda usa CPUs tradicionais e GPUs Nvidia. Mas o Google TPU é um circuito integrado de propósito especial (ASIC) projetado apenas para um tipo específico de tarefa. A empresa tem à sua disposição outro chip – Video Coding Unit, que é utilizado para processamento de vídeo.

O Google, seguindo o exemplo da Apple, passou a usar chips próprios em aparelhos de design próprio: nos smartphones Pixel 9 é o processador Tensor G4 de quarta geração, e nos fones de ouvido Pixel Buds Pro 2 é o Tensor A1. Mas o grande diferencial do Google é seu servidor TPU, que agora detém 58% do mercado entre seus próprios aceleradores de IA em nuvem. As GPUs da Nvidia são mais flexíveis, mas também mais caras e escassas no ambiente atual, quando o boom da IA fez as ações da empresa dispararem e agora ela compete com a Apple e a Microsoft para ser a empresa pública mais valiosa do mundo. O verdadeiro teste da TPU do Google ocorrerá quando a plataforma Apple Intelligence for lançada no iPhone e Mac no próximo ano.

Desenvolver uma alternativa aos aceleradores Nvidia é quase uma façanha. O processo é tão complexo e caro que nem o Google consegue fazer isso sozinho. Desde o lançamento da primeira TPU, a empresa contou com o apoio da fabricante de chips Broadcom, que ajuda a Meta✴ a resolver o mesmo problema. O design do chip totalmente desenvolvido é enviado para um fornecedor de semicondutores – TSMC, que produz 92% dos produtos semicondutores avançados do mundo.

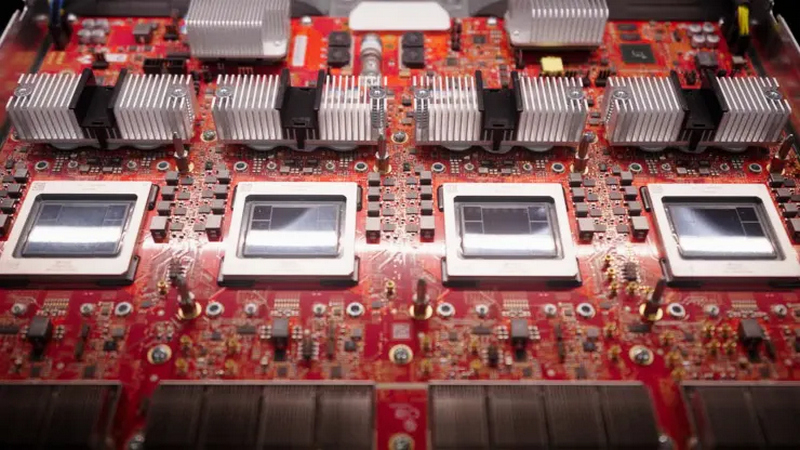

Trílio. Fonte da imagem: CNBC/Marc Ganley

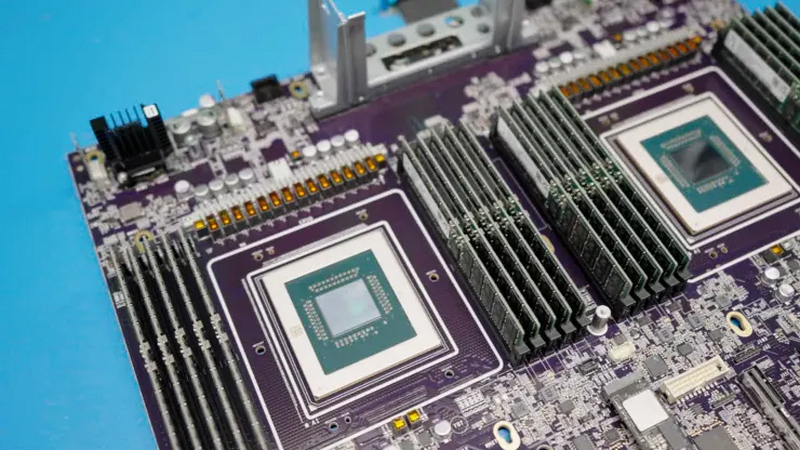

Este ano o Google lançará a sexta geração do Trillium TPU; Além disso, em abril passado a empresa anunciou o Axion, seu primeiro processador central, que aparecerá no final do ano. E o Google não é o primeiro aqui: a Amazon lançou seu Graviton em 2018, o Alibaba da China fez o mesmo em 2021 e a Microsoft lançou o chip Cobalt 100 em novembro do ano passado. Todos são baseados na arquitetura Arm, que é mais flexível e eficiente em termos de consumo de energia do que o x86 com o qual a Intel e a AMD estão comprometidas.

CPU Axion. Fonte da imagem: CNBC/Marc Ganley

A eficiência é fundamental: até 2027, os servidores de IA consumirão tanta energia por ano como a Argentina, de acordo com as projeções. O último relatório ambiental do Google mostrou que as emissões da empresa de 2019 a 2023. cresceu 50%, em parte devido ao crescimento no número de data centers de IA. O resfriamento de servidores para treinamento e execução de IA requer enormes volumes de água, portanto, a partir da terceira geração do Google TPU, o resfriamento é feito diretamente no chip – a Nvidia recorreu ao mesmo esquema com o mais recente Blackwell. E apesar das dificuldades decorrentes, o equipamento de IA do Google continua a ser muito procurado e a empresa ainda não percebeu o seu enfraquecimento.