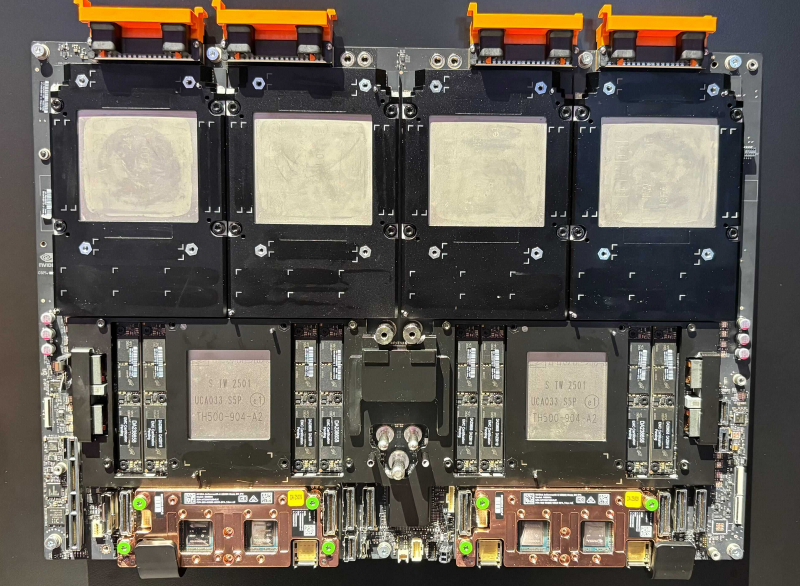

Micron, Samsung e SK hynix anunciaram novos módulos de memória SOCAMM baseados em chips LPDDR5X empilhados, com capacidades de até 128 GB. A tecnologia é voltada para servidores e sistemas de baixo consumo que utilizam inteligência artificial. O primeiro SOCAMM aparecerá em sistemas com o superchip Nvidia Grace Blackwell Ultra GB300.

Fonte da imagem: Micron

O consumo de energia da memória é um dos principais fatores que afetam a eficiência energética geral dos servidores. Em sistemas com terabytes de memória DDR5 por soquete, o consumo de energia da DRAM pode exceder o consumo de energia da CPU. A Nvidia levou esse aspecto em consideração ao projetar seus processadores Grace, que são projetados para usar memória LPDDR5X de eficiência energética. Entretanto, nas máquinas GB200 Grace Blackwell, a empresa teve que usar módulos LPDDR5X soldados, pois os módulos padrão não conseguiam fornecer a capacidade necessária.

O SOCAMM da Micron resolve esse problema oferecendo uma solução modular padrão que pode acomodar quatro pilhas LPDDR5X de 16 camadas, proporcionando alta capacidade. De acordo com a empresa, seus módulos SOCAMM de 128 GB consomem um terço menos energia do que os módulos DDR5 R-DIMM de mesma capacidade. Ainda não está claro se o SOCAMM se tornará um padrão da indústria suportado pelo JEDEC ou permanecerá como uma solução proprietária desenvolvida pela Micron, Samsung, SK hynix e Nvidia para servidores baseados nos processadores Grace e Vera.

A Micron lançou agora a produção em massa do SOCAMM. Eles aparecerão em sistemas baseados no Nvidia GB300 Grace Blackwell Ultra Superchip no segundo semestre deste ano. Vale ressaltar que o design modular simplifica a produção e a manutenção de servidores, o que provavelmente terá um impacto positivo nos preços dos sistemas, principalmente para as necessidades de inteligência artificial.