A plataforma de nuvem Microsoft Azure continua a adotar tecnologias de HPC e IA. A Microsoft anunciou uma nova série de máquinas virtuais ND A100 v4. Essas são as instâncias de dados de IA escaláveis mais poderosas, combinando de oito a milhares de aceleradores NVIDIA em centenas de máquinas virtuais.

O administrador de projeto sênior Ian Finder disse em uma postagem de blog que a série ND A100 v4 começa com uma máquina virtual (VM) e oito GPUs de tensor NVIDIA Ampere A100. Os clusters baseados em ND A100 v4 podem ser escalonados para milhares de GPUs com largura de banda de 1,6 Tbps por VM.

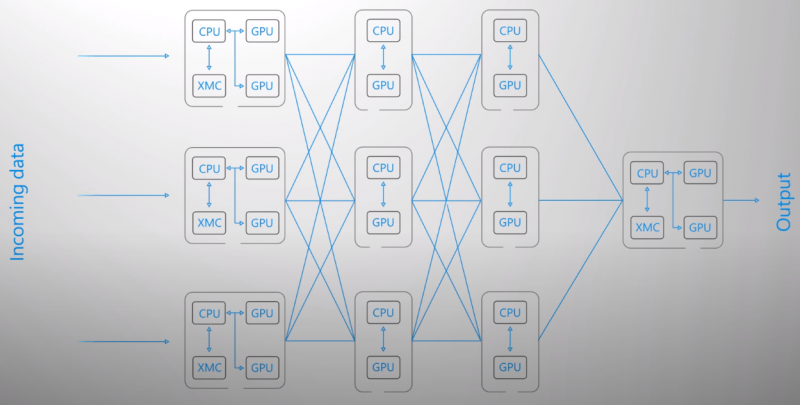

Cada acelerador é equipado com sua própria conectividade NVIDIA Mellanox HDR InfiniBand de 200 Gbps. Dezenas, centenas ou mesmo milhares de GPUs podem trabalhar juntas como parte de um cluster com uma malha InfiniBand. Qualquer desafio de IA, seja treinar um modelo do zero, retreinar com seus próprios dados ou ajustar uma carga de trabalho específica, será alcançado muito mais rápido com uma conexão GPU↔GPU dedicada que é 16 vezes mais rápida do que qualquer outra solução de outros provedores de nuvem pública.

A série ND A100 v4 de máquinas virtuais usa a nova plataforma AMD EPYC Rome com suporte PCIe Gen 4. De acordo com o Finder, o PCIe 4.0 e o barramento NVIDIA NVLink de terceira geração mais do que dobraram a velocidade de movimentação de dados no sistema em comparação com a geração anterior de máquinas virtuais. Os clientes que aproveitarem as vantagens dos novos recursos do A100, como Tensor Cores e Multi-instance GPU (MIG), terão uma melhora de até 20 vezes no desempenho.

A série de máquinas virtuais ND A100 v4 está atualmente em estágio de pré-lançamento e aparecerá no portfólio do Azure como uma oferta padrão. Anteriormente, os aceleradores A100 apareciam no Google Cloud e a AWS promete adicioná-los à nuvem em breve.