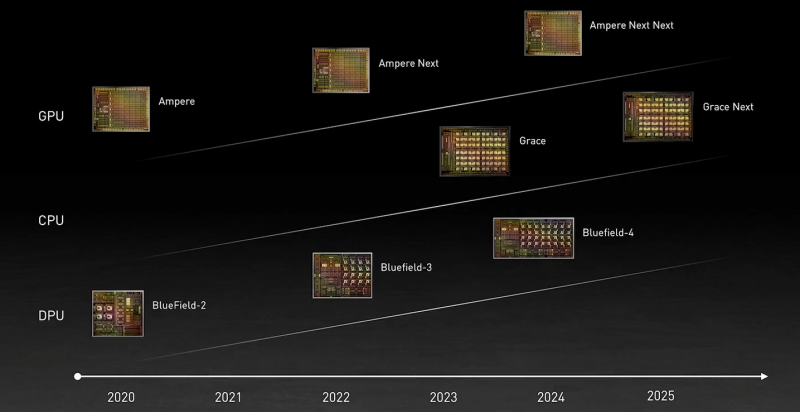

Durante a abertura do GTC’21, a maior atenção é atraída, é claro, o anúncio do processador de braço do próprio servidor NVIDIA. Eles dizem, por causa disso, até mesmo as ações da Intel viram, embora nas últimas decisões da NVIDIA, os processadores X86-64 eram necessários apenas para apoiar os aceleradores diretamente. Sim, a NVIDIA tem três pontos de apoio, três pilares para o desenvolvimento futuro: GPU, DPU e CPU. E a localização deles é de tal maneira que não é coincidência.

O processador Grace, que será lançado apenas em 2023, mesmo em padrões modernos “Nu” de desempenho não é tão alto – no especrato2017_int Sua classificação será de 300. Mas isso não importa, como agora, é necessário apenas para apoiar Os aceleradores (que para a brevidade serão chamados de GPU, embora eles sejam cada vez menos correspondentes a essa definição), que assumirá a carga computacional principal.

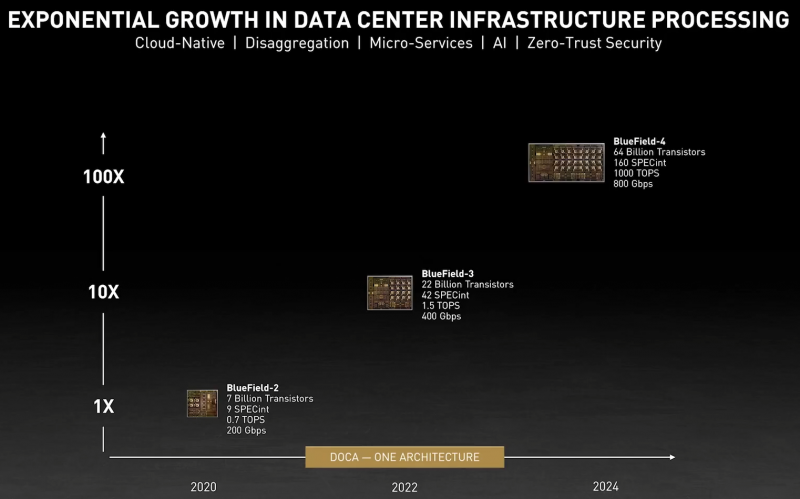

É muito mais interessante que em 2024, o Bluefield-4 aparecerá, para o qual o nível de desempenho reivindicado no mesmo espectro2017_int será 160. isto é, o DPU (unidade de processamento de dados, o coprocessador para dados) será formalmente apenas duas vezes. Como mais lento que a graça da CPU, mas neste caso incluem 64 bilhões de transistores. Os aceleradores A100 atuais são “total” 54 bilhões, e este é um dos maiores batatas fritas produzidos hoje.

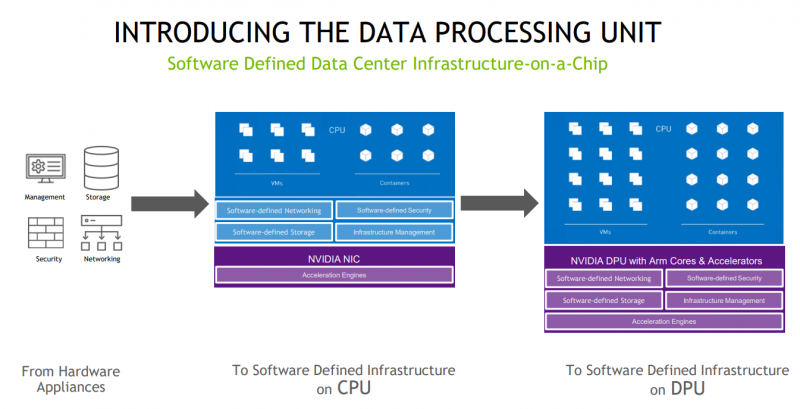

O volume significativo do orçamento transistor irá obviamente ir em sua própria parte de rede, mas no núcleo do braço e vários aceleradores. Anunciado no ano passado e ficou disponível agora DPU Bluefield-2 muito mais modesto. Mas é com a ajuda de sua ajuda, a Nvidia prepara um ecossistema para decisões abrangentes futuras, onde o DPUs se tornará realmente um “terceiro soquete”, como uma vez proclamou a inicialização fubegível, que foi organizada para o GTC’21 e o seu próprio armazenamento, e um próprio armazenamento. solução para data centers. No entanto, a abordagem de duas empresas é diferente.

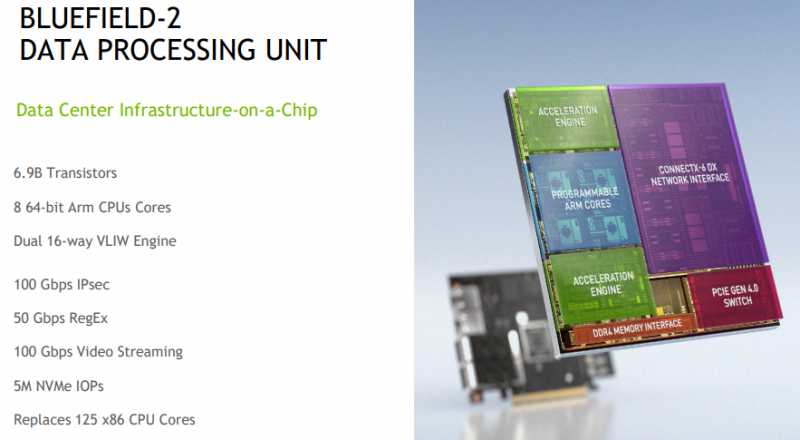

Lembre-se das principais características de Bluefield-2. A parte de rede apresentada pelo Mellanox ConnectX-6 DX oferece até duas portas de 100 Gbit / s, e opções e com Ethernet e com o InfiniBand estão disponíveis. Existem motores separados para acelerar a criptografia, expressões regulares, (de) compressão, etc. Tudo isso complementa 8 kernels CORTEX-A78 (até 2,5 GHz), de 8 a 32 GB DDR4-3200 ECC, seu próprio interruptor PCIE e a capacidade de conectar a unidade M.2 / U.2. Além disso, haverá um GPU Bluefield-2x C a bordo. Características de adaptadores específicos com base em Bluefield-2 diferem, mas, em geral, temos um computador com pleno direito. E a própria NVIDIA chama de doca (datacenter em uma arquitetura chip), o data center no chip.

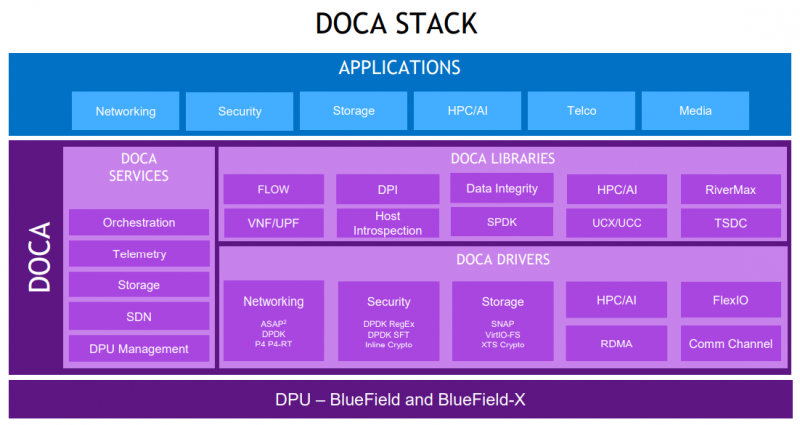

Para trabalhar com ele, é oferecido um conjunto extensivo de desenvolvedor Doca SDK, que inclui drivers, estruturas, bibliotecas, apis, serviços e realmente mídia. Todos eles cobrem quase todas as cargas e tarefas de servidores padrão padrão, bem como serviços que, com o SDK, são relativamente fáceis de traduzir em uma categoria de definida por software, para a qual, na verdade, tanto tempo. A NVIDIA promete que o DOCA se tornará para o DPU o mesmo que o CUDA tornou-se para a GPU, economizando compatibilidade com versões subseqüentes do software e “ferro”.

Com base nesta pilha de software e hardware, a empresa agora oferece várias soluções. A primeira é a plataforma NVIDIA AI Enterprise para implementação simples, rápida e conveniente de soluções AI. O VMware vSphere é usado como base, onde máquinas virtuais e contêineres são implantados, o que simplifica o trabalho com infraestrutura, enquanto o desempenho é prometido quase o mesmo que no caso de metal descoberto.

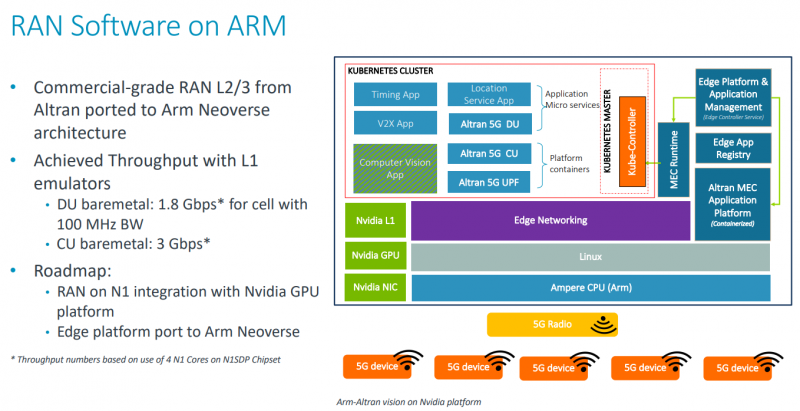

DPU e no formulário atual Suporta a capacidade de descarregar algumas tarefas, mas a VMware junto com a NVIDIA tolera parte do tipo de hipervisor com a CPU diretamente no DPU. Além disso, a VMware continua a trabalhar na transferência de suas soluções com o X86-64 no braço, que é totalmente empilhado no desenvolvimento do ecossistema do braço da NVIDIA. Uma das direções é 5G, e o trabalho é realizado em várias direções. Primeiro, o próprio braço está desenvolvendo uma plataforma periférica baseada em Ampere Altra, complementada pela GPU e DPU.

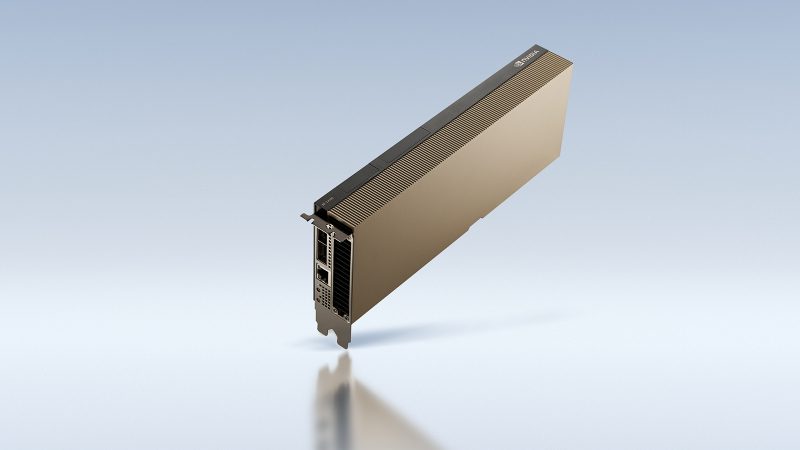

A100 A100 da NVIDIA.

Em segundo lugar, a Nvidia tem uma solução convergente – o acelerador A100 aéreo, que combina A100 e DPU em um mapa. Ao mesmo tempo, pode ser usado tanto para acelerar o trabalho de radiofrequências em si como para o processamento do próprio tráfego e a implementação de vários serviços de fronteira. No mesmo lugar onde a alta densidade não é necessária (como na estação base), a NVIDIA propõe usar uma plataforma EGX mais familiar com GPUs separados (de A100 e A40 para A30 / A10) e DPU.

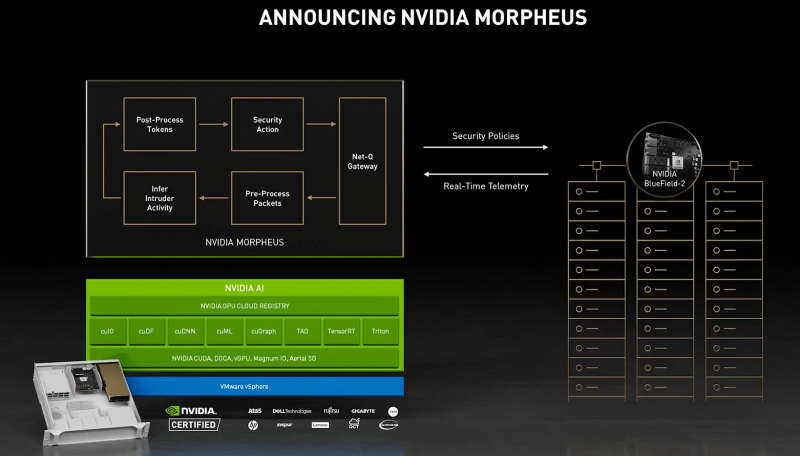

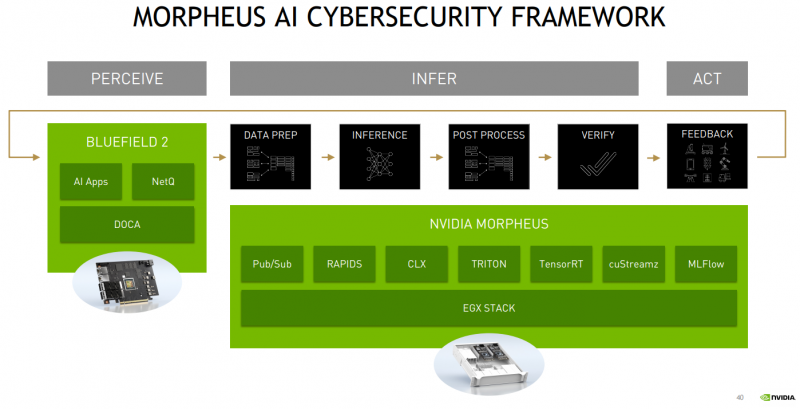

Uma das opções para o uso integrado de tais plataformas é o projeto Morpheus. Supõe-se em instalar o DPU para cada servidor no data center. As capacidades de DPU, em particular, são suficientes para inspeção de tráfego, que permite acompanhar a interação de servidores, aplicativos, VM e contêineres dentro do data center, bem como, obviamente, aplicar várias políticas de tráfego. DPU neste caso atuam como sensores, dados dos quais rebanho em EGX e, juntamente com os gateways de segurança local.

Configuração manual do político e rastreamento do comportamento de todo o Parque CDA é possível, mas não muito eficaz. Portanto, a NVIDIA oferece tanto a possibilidade de aprendizagem e modelos prontos (com a adesão à vontade), que são executados na GPU dentro do EGX e permitem identificar rapidamente o comportamento anômalo, notificar e cortar aplicativos ou nós suspeitos do resto da rede. Na era do microsserviço, diz a empresa, mais do que relevante para monitorar o estado da infraestrutura dentro do data center, e não apenas em sua fronteira, como antes, quando tudo dentro do data center, o padrão foi confiável.

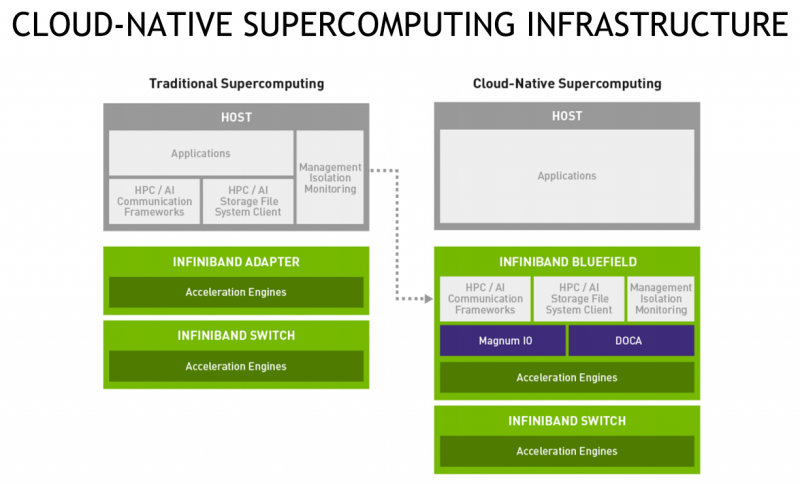

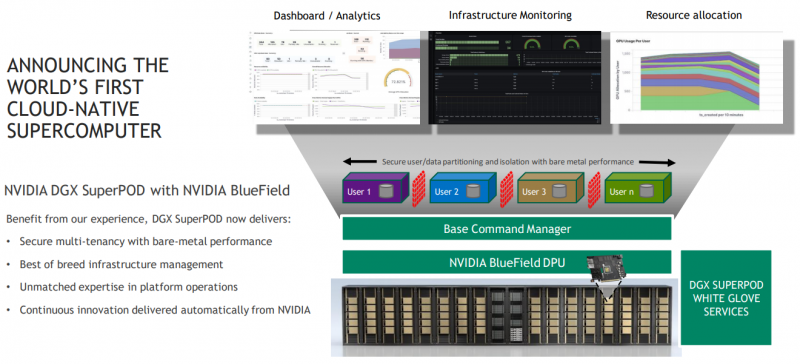

Além disso, usando DPU e DOCA, você pode transferir a infraestrutura de data center para um modelo de nuvem e simplificar a orquestração. Mas não apenas o código – o superpod DGX atualizado para superprise corporprise superprise superprise, agora também tem um comando DPU (com infiniband) e base, que permite “cortar” a máquina em instâncias isoladas com a configuração necessária, simplificando assim o uso da articulação e monitoramento. E isso, por sua vez, aumenta a eficiência do carregamento do supercomputador. O comando base cresceu do sistema interno de controle da EME, o próprio supercomputador da NVIDIA, no qual, por exemplo, a empresa ensina modelos.

DPUs estão disponíveis para dispositivos separados e como parte de plataformas NVIDIA certificadas e soluções de parceiros da empresa, e o espectro é grande. Assim, a empresa está tentando construir uma abordagem integrada, oferecendo soluções de software e hardware para os dados com dados (modelos). Semelhante à sua essência confessar a Intel e a AMD com uma absorção de Xilinx, é necessário acreditar, também olhará nessa direção. E a “ameaça” para eles não é apenas GPU, mas agora DPU. Mas a nova CPU da NVIDIA provavelmente permanecerá apenas como parte de seus próprios produtos, independentemente de a empresa ter permissão para absorver o braço.