A Fujitsu anunciou a disponibilidade de middleware projetado para otimizar o uso de aceleradores de IA. Tal como referido no comunicado de imprensa, esta solução permite aumentar a eficiência dos aceleradores, o que é especialmente importante num contexto de escassez de recursos computacionais deste tipo.

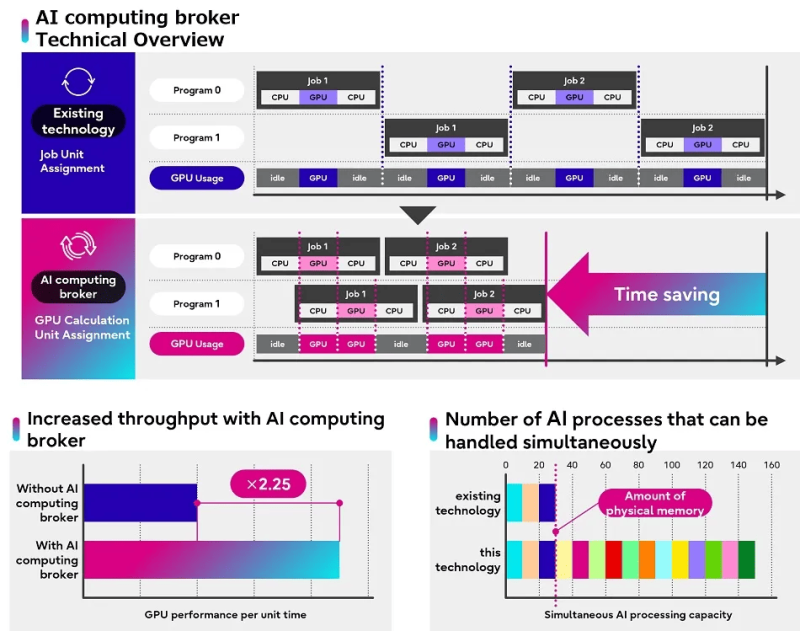

O software distingue entre código que requer uma GPU para ser executado e aquele que pode ser executado apenas na CPU, otimizando a alocação de recursos e o gerenciamento de memória em diferentes plataformas e aplicativos de IA. Além disso, o software controla a prioridade de execução dos cálculos, dando preferência a processos mais eficientes. Curiosamente, a alocação não utiliza a abordagem tradicional de basear a seleção de recursos na tarefa inteira.

Fonte da imagem: Fujitsu

A empresa anunciou a solução (Adaptive GPU Allocator) em novembro de 2023. Em seguida, falaram sobre a necessidade de usar um framework proprietário baseado em TensorFlow e PyTorch. O anúncio atual não menciona isso explicitamente, mas é relatado que o produto combina a tecnologia de alocação adaptativa de recursos de cada acelerador individual com algum tipo de otimização baseada em IA. Além disso, o novo produto permite processar com eficiência até mesmo aquelas tarefas que não cabem inteiramente na memória do acelerador. Durante os testes, conseguimos processar 150 GB de dados de IA em uma GPU com aproximadamente 30 GB de RAM livre.

A Fujitsu disse que a solução aumentou a eficiência da computação de IA em 2,25 vezes em testes reais em AWL, Xtreme-D e Morgenrot. E dois grandes clientes, Tradom e Sakura Internet, já começaram a implementar a nova ferramenta. “Ao abordar o acelerador e a escassez de energia causada pela crescente procura global por IA, a Fujitsu pretende contribuir para aumentar a produtividade empresarial e a criatividade dos seus clientes”, afirmou a empresa.

Porém, até o momento a solução só consegue agilizar o funcionamento dos aceleradores em um servidor, mas a empresa está trabalhando para garantir que ela possa atender múltiplas GPUs instaladas em vários servidores. Em outras palavras, ainda não permitirá acelerar um cluster inteiro de IA, mas ainda é uma maneira conveniente de “extrair mais” de um servidor GPU, observou o recurso The Register.