Embora muitas empresas vejam a nuvem como a melhor escolha para treinar e executar grandes aplicativos de IA, apenas uma pequena parte da infraestrutura de nuvem existente atualmente tem o poder de computação para fazer isso, escreve o The Wall Street Journal (WSJ). “Existe um grande desequilíbrio entre oferta e demanda no momento”, disse Chetan Kapoor, diretor de gerenciamento de produto do AWS EC2. Nidhi Chappell, gerente geral da Azure AI Infrastructure, observou que há uma demanda “insaciável” para executar grandes modelos de linguagem (LLMs).

No entanto, a maior parte da infraestrutura de nuvem atual não foi projetada para executar sistemas tão grandes e complexos. A nuvem foi posicionada como uma alternativa conveniente aos servidores locais, que podem ser facilmente dimensionados para atender às suas metas com pagamento conforme o uso. Grande parte do espaço de nuvem atual é composto por servidores com CPUs de uso geral projetadas para executar várias cargas de trabalho simultaneamente. E há muito menos servidores e clusters de GPU otimizados para IA e grandes cargas de trabalho. Ao mesmo tempo, AWS, Google, Meta* e Microsoft já aumentaram a vida útil de seus equipamentos existentes de três para quatro anos para seis anos.

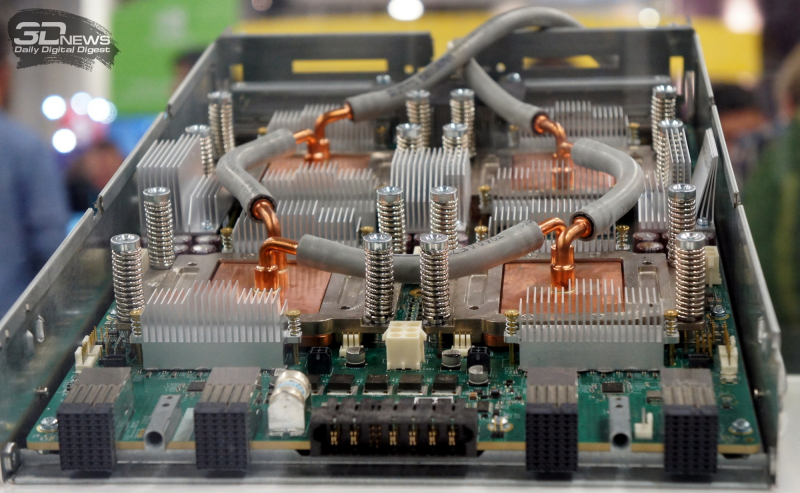

Fonte da imagem: Google

A infraestrutura otimizada para IA representa apenas uma pequena porcentagem dos recursos totais de nuvem da empresa, diz Kapoor, embora esteja crescendo a uma taxa muito mais alta do que outros segmentos. Kapoor disse isso nos próximos 12 meses. a empresa implantará vários clusters de IA. O Microsoft Azure e o Google Cloud Platform disseram ao WSJ que também estão trabalhando para tornar a infraestrutura de IA uma parte maior de sua frota. Ao mesmo tempo, a Microsoft observou que não vai abandonar os servidores de uso geral, que ainda são valiosos para as empresas.

Mas a Dell espera que o alto custo da computação em nuvem possa levar as empresas a implantar sistemas localmente. “Os modelos econômicos existentes, principalmente a nuvem pública, não foram otimizados para o tipo de demanda e nível de atividade que veremos quando as pessoas mudarem para sistemas de IA”, disse o CTO da Dell, John Roese. Em um ambiente local, as empresas podem economizar em custos de rede e armazenamento, diz ele. Os provedores de nuvem discordam, alegando que têm ofertas acessíveis e que os sistemas locais custarão mais a longo prazo devido a atualizações de hardware.

A HPE está construindo seu próprio serviço público de nuvem de treinamento de IA baseado em supercomputador, que estará disponível no segundo semestre de 2023. “Ele foi desenvolvido especificamente para casos de uso de IA em grande escala”, disse Justin Hotard, vice-presidente executivo e chefe de HPC e IA. No entanto, os fornecedores de hardware concordam que a indústria de IA ainda está engatinhando e que a solução pode eventualmente ser híbrida, onde apenas parte da computação é feita na nuvem.

* Está incluída na lista de associações públicas e organizações religiosas em relação às quais o tribunal tomou uma decisão final para liquidar ou proibir atividades com base na Lei Federal nº 114-FZ de 25 de julho de 2002 “No combate a extremistas atividade”.