A divisão de pesquisa da Apple, juntamente com pesquisadores da Universidade da Califórnia, em Santa Bárbara, lançou o MGIE, um modelo multimodal de inteligência artificial projetado para edição de imagens. Para fazer alterações em um instantâneo, o usuário só precisa descrever em linguagem natural o que deseja obter como saída.

Fonte da imagem: Apple

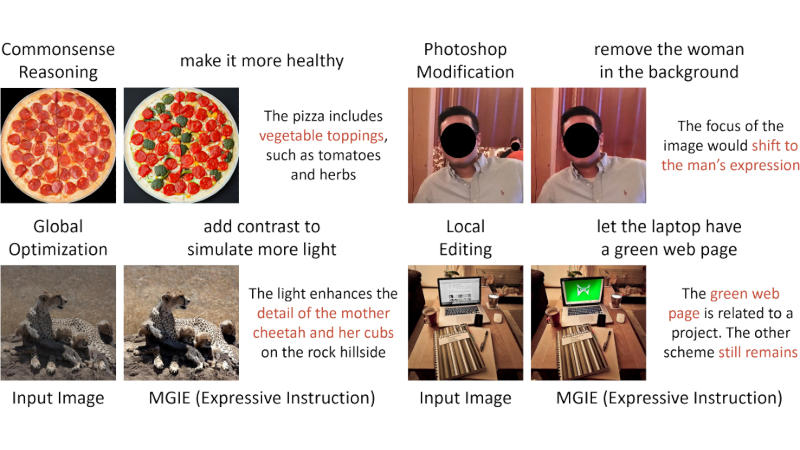

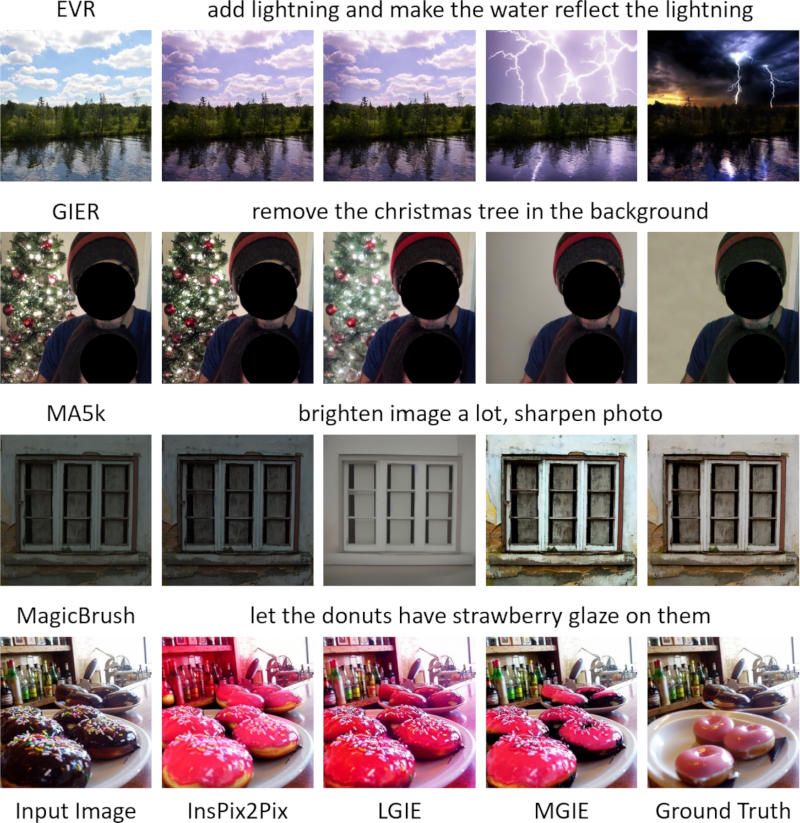

MGIE (Edição de imagem guiada por modelo de linguagem grande multimodal) pode ser usado para tarefas de complexidade variada relacionadas à edição de imagens: você pode adicionar vários objetos, removê-los ou alterá-los. Ao receber um comando, o modelo interpreta as palavras do usuário, e então “imagina” como ficará a imagem quando modificada de acordo com elas.

O artigo que descreve o MGIE fornece vários exemplos do seu trabalho. Quando a modelo recebeu uma foto de pizza para editar e foi solicitada a “torná-la mais saudável”, ela acrescentou coberturas vegetais. Em seguida, ela recebeu uma fotografia excessivamente escura de uma chita no deserto e foi solicitada a “adicionar contraste, simulando mais luz” – a imagem ficou mais clara. MGIE está disponível para download gratuito no GitHub, e você pode experimentá-lo na plataforma Hugging Face Spaces. A Apple não especificou quais são os planos da empresa para o modelo fora do projeto de pesquisa.

A edição de imagens é suportada por vários geradores de IA, incluindo OpenAI DALL-E 3; Os recursos de IA generativa também estão presentes no Photoshop graças ao modelo Adobe Firefly. A Apple não se posiciona como um player importante em IA como Microsoft, Meta✴ ou Google, mas o CEO Tim Cook disse recentemente que o fabricante adicionará novos recursos de IA aos seus dispositivos este ano. Em dezembro passado, a empresa lançou a plataforma aberta MLX para treinar modelos de IA em chips Apple Silicon.