A OpenAI lançou dois modelos de IA de raciocínio em escala aberta que, segundo o desenvolvedor, possuem capacidades semelhantes às de seus modelos da série “o”. Ambos os novos modelos de IA em escala aberta estão disponíveis na plataforma Hugging Face.

Fonte da imagem: Mariia Shalabaieva / unsplash.com

A empresa tem dois projetos: o gpt-oss-120b, mais potente, requer uma placa de vídeo Nvidia para funcionar, enquanto o gpt-oss-20b, mais leve, requer um laptop com 16 GB de RAM. A última vez que a OpenAI lançou um projeto de código aberto foi há mais de cinco anos, quando se tratava do GPT-2. Os novos modelos, segundo a empresa, podem enviar consultas excessivamente complexas para sistemas baseados em nuvem, caso não consigam lidar com algumas consultas por conta própria.

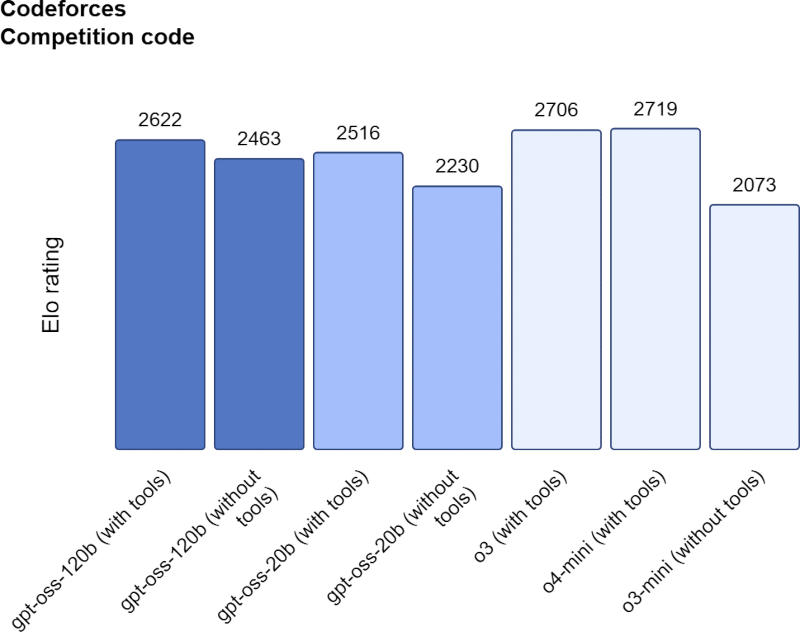

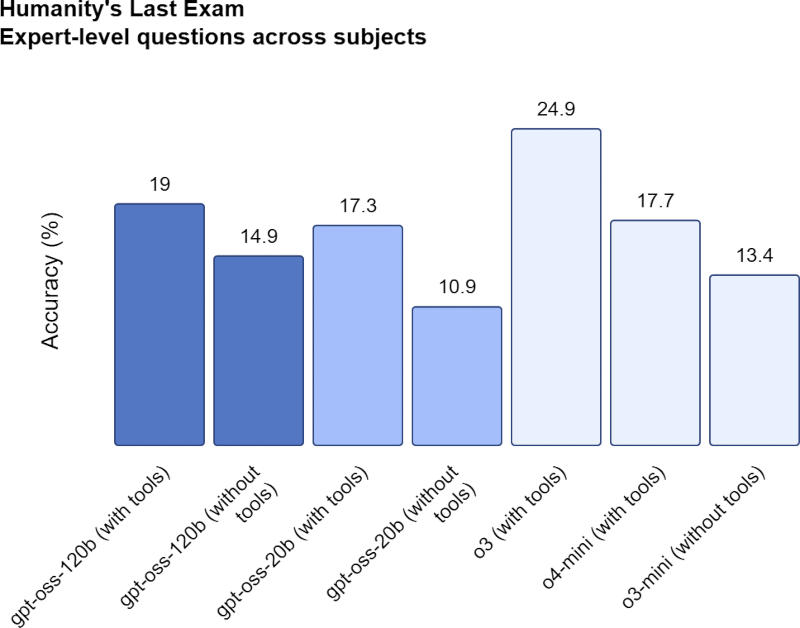

Como líder global reconhecida no setor de IA, a OpenAI buscou tornar seus modelos de código aberto mais poderosos do que os modelos existentes e afirma ter obtido sucesso. Nos testes de codificação da Codeforces, os modelos gpt-oss-120b e gpt-oss-20b obtiveram 2.622 e 2.516 pontos, respectivamente, superando o DeepSeek R1, mas ficando atrás do o3 e do o4-mini. No benchmark Humanity’s Last Exam (HLE), o gpt-oss-120b e o gpt-oss-20b obtiveram 19% e 17,3%, respectivamente — resultados inferiores ao o3, mas superiores aos modelos líderes de código aberto DeepSeek e Alibaba Qwen.

Fonte da imagem: openai.com

Observa-se que os novos modelos abertos OpenAI apresentam alucinações, ou seja, dão respostas que são inverídicas, com mais frequência do que os modelos fechados o3 e o4-mini. O desenvolvedor chamou esse resultado de “esperado, visto que modelos menores têm menos conhecimento do mundo do que modelos avançados maiores e são propensos a alucinações mais pronunciadas”. No teste PersonQA, os modelos gpt-oss-120b e gpt-oss-20b apresentaram alucinações em suas respostas em 49% e 53% dos casos, respectivamente; para comparação, para o3 e o4-mini, esses números são de 16% e 36%, respectivamente.

A OpenAI treinou os modelos abertos usando os mesmos processos dos modelos fechados, ambos utilizando um método de Mistura de Especialistas (MoE) para usar menos parâmetros para responder às perguntas. O modelo gpt-oss-120b, por exemplo, possui 177 bilhões de parâmetros, mas ativa apenas 5,1 bilhões por token, o que ajuda a melhorar a eficiência. Ele também utilizou aprendizado por reforço de alta computação, um processo para distinguir o certo do errado em ambientes simulados; ele é usado para treinar os modelos da série O. Os modelos abertos também usam um processo semelhante para processar respostas, o que requer tempo e recursos adicionais.

Fonte da imagem: openai.com

A OpenAI afirma que modelos abertos são adequados para uso em agentes de IA e são capazes de acessar ferramentas de busca na web e execução de código Python. Ressalta-se que eles não são multimodais, ou seja, são projetados para trabalhar apenas com texto e não podem processar ou gerar imagens ou som. Os modelos estão disponíveis sob a licença Apache 2.0, considerada uma das mais democráticas. Ao mesmo tempo, a empresa se recusou a divulgar quais dados foram usados para treiná-los.

A OpenAI conduziu um estudo separado para verificar se invasores hipotéticos poderiam usá-los em ataques cibernéticos ou para desenvolver armas biológicas ou químicas. Com a ajuda de especialistas externos, descobriu-se que eles ainda poderiam fornecer alguma assistência menor no campo da ciência biológica, mas não havia evidências de que eles poderiam potencialmente exceder o “limite de capacidade” estabelecido, mesmo após um procedimento de ajuste fino.