O Google apresentou o Lumiere, um “modelo de difusão espaço-temporal para geração de vídeo realista” baseado em inteligência artificial. Como a prática tem mostrado, este é talvez o gerador de vídeo de IA mais poderoso até hoje, criando imagens dinâmicas com base em descrições de texto.

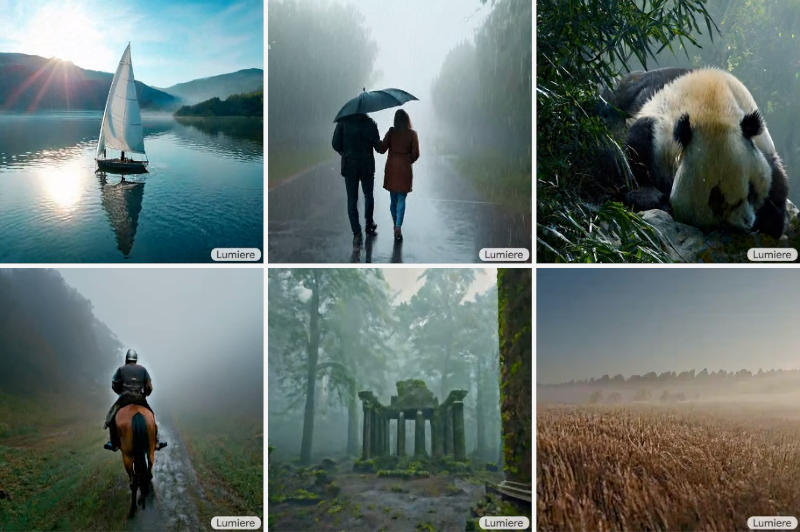

Fonte da imagem: lumiere-video.github.io

A diferença mais importante entre o Google Lumiere e os análogos existentes é a arquitetura única do modelo – o vídeo durante toda a sua duração é gerado em uma única passagem. Outros modelos funcionam com um princípio diferente: eles geram vários quadros-chave e depois interpolam ao longo do tempo, o que dificulta a consistência do filme gerado. O Lumiere funciona em vários modos, por exemplo, converte texto em vídeo, converte imagens estáticas em dinâmicas, cria vídeos em um determinado estilo com base em uma amostra, permite editar um vídeo existente usando instruções escritas, anima certas áreas de um estático imagem ou edita um vídeo em fragmentos – por exemplo, pode trocar uma peça de roupa de uma pessoa.

«Treinamos nosso modelo T2V [text-to-video] em um conjunto de dados de 30 milhões de vídeos com descrições de texto. Os vídeos têm 80 quadros de duração a 16 quadros por segundo. O modelo básico é treinado com uma resolução de 128 × 128 pixels”, explicou o Google. A saída são vídeos de 5 segundos com resolução de 1024 × 1024 pixels.

O Google Lumiere, obviamente, não é o primeiro gerador de vídeo de IA. O próprio Google demonstrou anteriormente um modelo Imagen Video que gerava vídeos com resolução de 1280 × 768 pixels a 24 quadros por segundo, mas suas criações eram muito mais modestas. Os resultados de projetos como Meta✴ Make-A-Video, Runway Gen2 e Stable Video Diffusion foram menos realistas. O Google entende a ameaça que tais projetos podem representar: “Nosso principal objetivo neste trabalho é dar aos usuários novatos a capacidade de gerar conteúdo visual de forma flexível e criativa. No entanto, existe o risco de falsificações inadequadas ou conteúdo prejudicial usando a nossa tecnologia, e acreditamos que é fundamental desenvolver e implementar ferramentas para detectar preconceitos e uso malicioso para garantir a operação segura e justa do [modelo].”