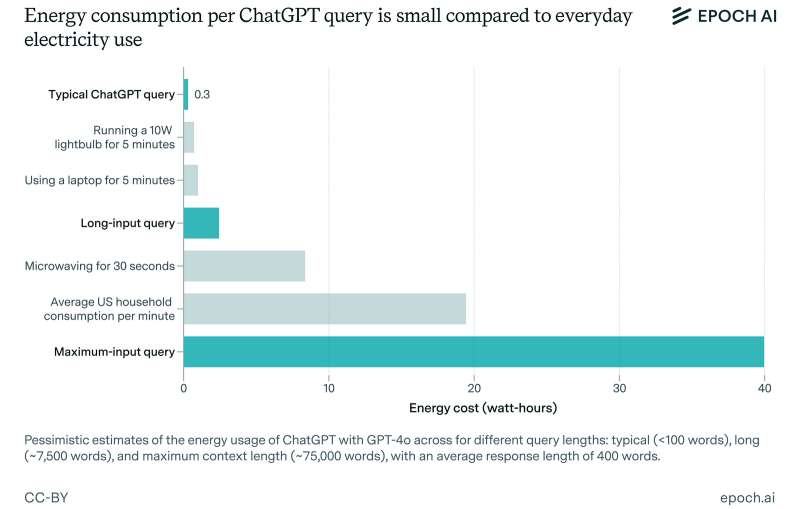

Estimativas anteriores sugeriram que o ChatGPT consome cerca de 3 Wh de energia para responder a uma única consulta, o que é 10 vezes a energia média necessária ao usar a pesquisa do Google. No entanto, um novo relatório da Epoch AI, um instituto de pesquisa que estuda as principais tendências e questões que moldarão a trajetória da inteligência artificial, desafia essas estatísticas e sugere que o consumo de energia do chatbot da OpenAI é significativamente menor do que se pensava anteriormente.

Fonte da imagem: OpenAI

O relatório da Epoch AI afirma que o ChatGPT, equipado com o modelo GPT-4o, consome apenas 0,3 Wh de energia ao gerar uma resposta. Em declarações ao TechCrunch, o analista de dados da Epoch AI, Joshua You, observou: “O consumo de energia não é tão grande quando comparado ao uso de aparelhos comuns, aquecimento ou resfriamento da casa ou uso do carro”.

Segundo o especialista, estimativas anteriores dos custos de energia do ChatGPT eram baseadas em dados desatualizados. O especialista observa que as supostas estatísticas de consumo de energia “universais” do ChatGPT foram baseadas na suposição de que a OpenAI estava usando chips antigos e ineficientes para executar e operar sua IA.

«Além disso, alguns dos meus colegas apontaram que a estimativa mais amplamente utilizada de 3 Wh por consulta era baseada em pesquisas bastante antigas. E se julgarmos por alguns cálculos aproximados, essas estatísticas pareciam muito altas”, acrescentou Yu.

Deve-se acrescentar, no entanto, que a estimativa da Epoch AI sobre o consumo de energia do ChatGPT também não é definitiva, pois não leva em consideração alguns recursos importantes da IA, como a geração de imagens do chatbot.

O especialista disse que não espera que o consumo de energia do ChatGPT aumente, mas à medida que os modelos de IA se tornam mais avançados, eles exigirão mais energia para operar. As principais empresas de IA, incluindo a OpenAI, estão se movendo em direção ao desenvolvimento dos chamados modelos de IA de raciocínio que não apenas respondem a uma pergunta, mas também descrevem todo o processo que levou a essa resposta, o que, por sua vez, exige muita energia.

Vários relatórios nos últimos anos mostraram que tecnologias como o Microsoft Copilot e o ChatGPT (ou melhor, o hardware em que são executados) consomem o equivalente a uma garrafa de água gelada ao gerar uma resposta a uma consulta. As descobertas seguem um relatório anterior que descobriu que o uso combinado de energia da Microsoft e do Google excede o consumo de eletricidade de mais de 100 países no mundo todo.

Um dos estudos mais recentes detalhou como o modelo GPT-3 da OpenAI consome quatro vezes mais água do que se pensava anteriormente, enquanto o GPT-4 consome até três garrafas de água para gerar apenas 100 palavras. É bastante claro que os modelos de IA começam a consumir mais recursos à medida que se tornam mais avançados. No entanto, as descobertas do estudo mais recente sugerem que o mesmo ChatGPT pode não ser tão glutão quanto se pensava anteriormente.