No início deste ano, a empresa chinesa DeepSeek surpreendeu a todos com o lançamento de seu modelo de linguagem R1, que alcançou resultados comparáveis aos melhores exemplos ocidentais na área de IA, mas exigiu que os desenvolvedores gastassem menos. A criação do modelo R2 mais recente, segundo alguns, foi limitada pela disponibilidade de aceleradores de computação da Nvidia, difíceis de encontrar na China.

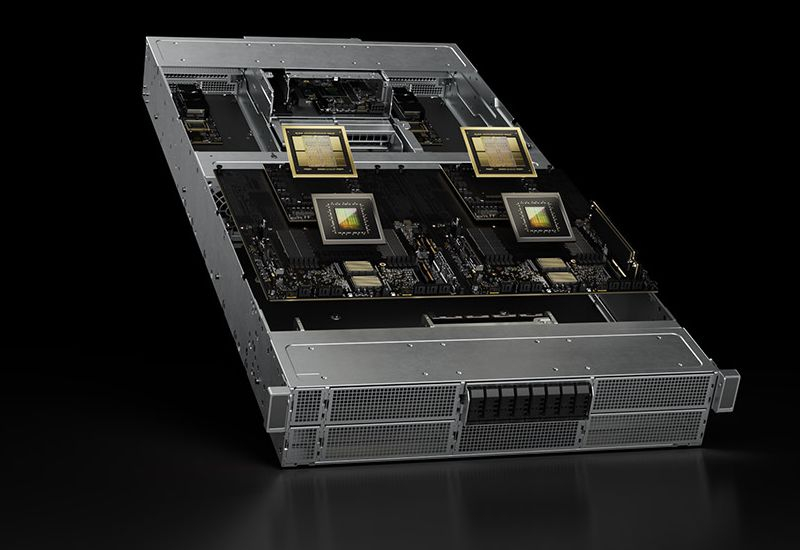

Fonte da imagem: NVIDIA

Como a Reuters lembra em referência ao The Information, a DeepSeek planejou inicialmente apresentar o R2 no final de maio, mas a administração da empresa estava insatisfeita com o nível de desempenho alcançado, o que atrasou a finalização deste modelo de linguagem. Segundo a fonte, o progresso está sendo parcialmente retardado pela falta de um número suficiente de aceleradores de computação de alto desempenho na China, e a DeepSeek atualmente prefere confiar principalmente nas soluções da Nvidia, cujo fornecimento para a China está seriamente limitado devido às sanções dos EUA.

A infraestrutura de nuvem na China, atualmente usada para trabalhar com o modelo de linguagem R1, depende principalmente dos aceleradores Nvidia H20, que poderiam ser fornecidos legalmente até abril deste ano. Em seu relatório, a Nvidia observou que a proibição do fornecimento de aceleradores H20 na primavera custará vários bilhões de dólares, uma vez que não será possível fornecer outra finalidade para esses produtos, e todo o estoque terá que ser simplesmente amortizado. Ao mesmo tempo, a Nvidia está tentando encontrar uma oportunidade para fornecer aceleradores menos produtivos para a China que atendam aos requisitos atuais dos EUA nessa área. Presume-se que esses aceleradores serão criados usando a arquitetura Blackwell e memória GDDR7.