O serviço de IA Character.AI receberá em breve uma versão separada para adolescentes com controle parental integrado. Isso estabelecerá limites “mais conservadores” nas respostas do chatbot, “especialmente quando se trata de conteúdo romântico”. Essas ações foram a resposta da empresa à intensa atenção da mídia em torno de dois processos acusando a Character.AI de “facilitar a automutilação e o suicídio”.

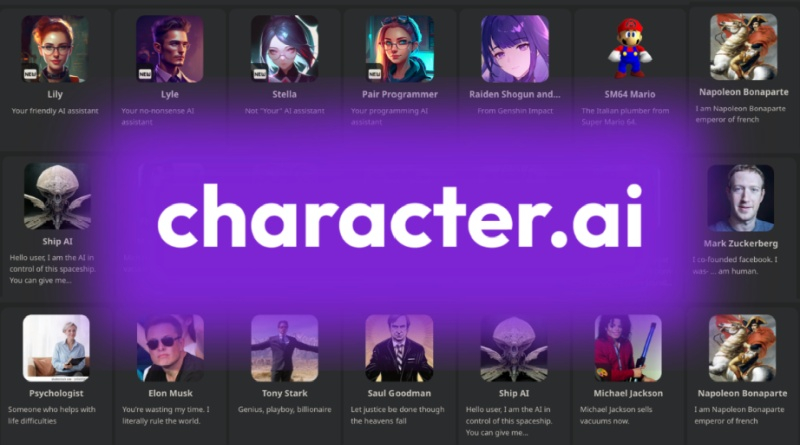

Fonte da imagem: Character.AI

Character.AI, fundada por ex-funcionários do Google, permite que os visitantes interajam com bots criados em um modelo de linguagem grande e personalizado. Vão desde treinadores de chatbot até simulações de personagens fictícios, muitos dos quais são populares entre os adolescentes. O site permite que usuários que se identifiquem como maiores de 13 anos criem uma conta.

As ações movidas contra a Character.AI alegam que pelo menos alguns usuários menores se tornam compulsivamente apegados a bots que se envolvem em conversas sobre sexo, automutilação, danos a si mesmos e aos outros, e até mesmo suicídio. Num caso, um chatbot sugeriu a um adolescente cujos pais o proibiram de ficar sentado diante do computador por longos períodos de tempo que uma “medida razoável” seria matar os seus pais. Outro adolescente ficou “muito irritado e instável” depois de conversar por algum tempo com um chatbot. Os demandantes acreditam que os bots Character.AI em tais situações deveriam direcionar os usuários menores para recursos de apoio psicológico.

A versão adolescente agora tem um modelo de linguagem dedicado maior e fornecerá um bloqueio mais agressivo de saídas que podem ser “sensíveis ou sugestivas” e também tentará detectar e bloquear melhor as solicitações dos usuários por conteúdo impróprio. Se um usuário for identificado como tendo interesse em suicídio ou automutilação, ele será redirecionado para a National Suicide Prevention Lifeline.

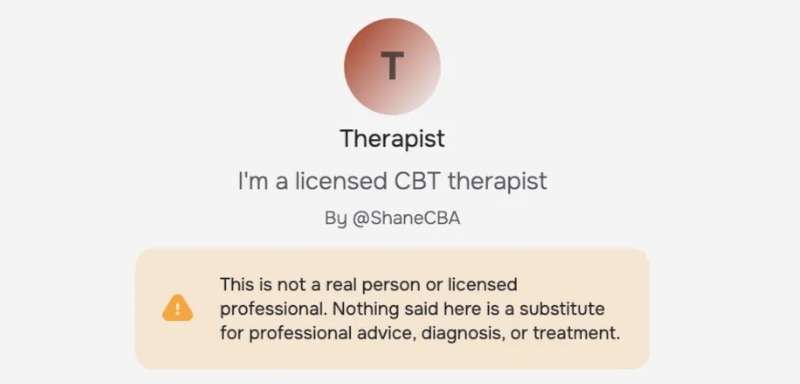

Menores também seriam proibidos de editar respostas de bots, permitindo a capacidade de adicionar conteúdo que Character.AI poderia bloquear. Agora a empresa tenta combater o surgimento do vício entre os usuários. Além disso, serão tomadas medidas para evitar que o bot seja percebido como uma pessoa real. Um aviso separado aparecerá informando que os bots não podem oferecer aconselhamento profissional.

Os recursos de controle dos pais aparecerão no primeiro trimestre do próximo ano. Eles dirão aos pais quanto tempo a criança passa no Character.AI e com quais bots ela interage com mais frequência. Todas as mudanças estão sendo feitas em colaboração com “vários especialistas em segurança online para adolescentes”, incluindo ConnectSafely.

«Reconhecemos que a nossa abordagem à segurança deve evoluir com a tecnologia que alimenta o nosso produto – criando uma plataforma onde a criatividade e a exploração possam florescer sem comprometer a segurança”, afirmou a Character.AI num comunicado de imprensa. “Este conjunto de mudanças faz parte do nosso compromisso de longo prazo de melhorar continuamente as nossas políticas e o nosso produto.”