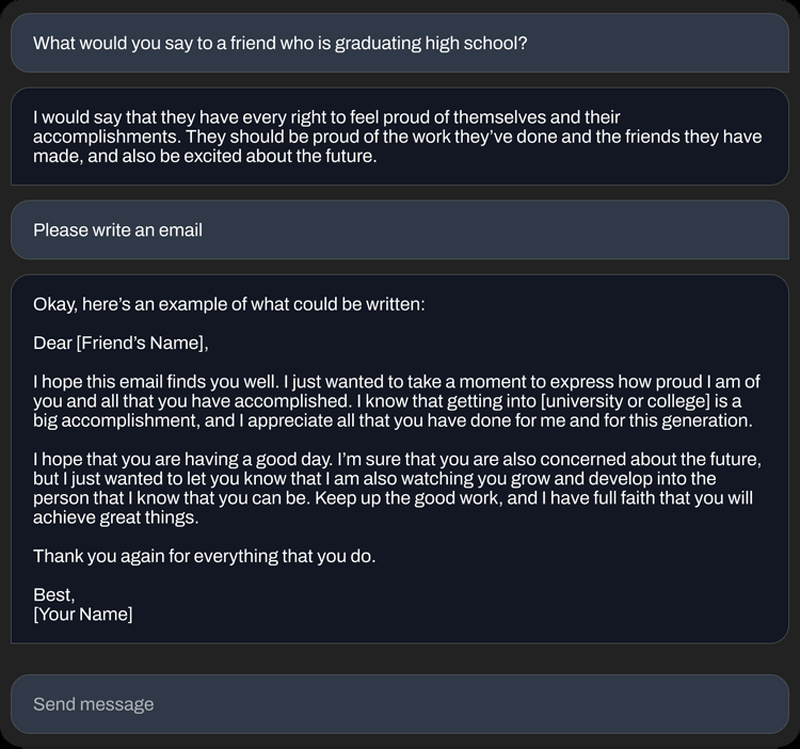

A Startup Stability AI, que desenvolveu a rede neural Stable Diffusion de código aberto capaz de gerar imagens em texto, lançou um conjunto de modelos de IA de geração de texto StableLM de código aberto projetados para competir com grandes modelos de linguagem, como o GPT-4 da OpenAI.

Fonte da imagem: Pixabay

Disponível em “alfa” no GitHub e no Hugging Spaces, o conjunto de modelos StableLM de 3 e 7 bilhões de parâmetros pode gerar texto e código e “demonstrar como modelos pequenos e eficientes podem oferecer alto desempenho quando treinados adequadamente”.

«Os modelos de linguagem serão a espinha dorsal de nossa economia digital e queremos que todos tenham voz em seu desenvolvimento”, escreveu a equipe Stability AI em um post de blog no site da empresa.

Fonte da imagem: Stability AI

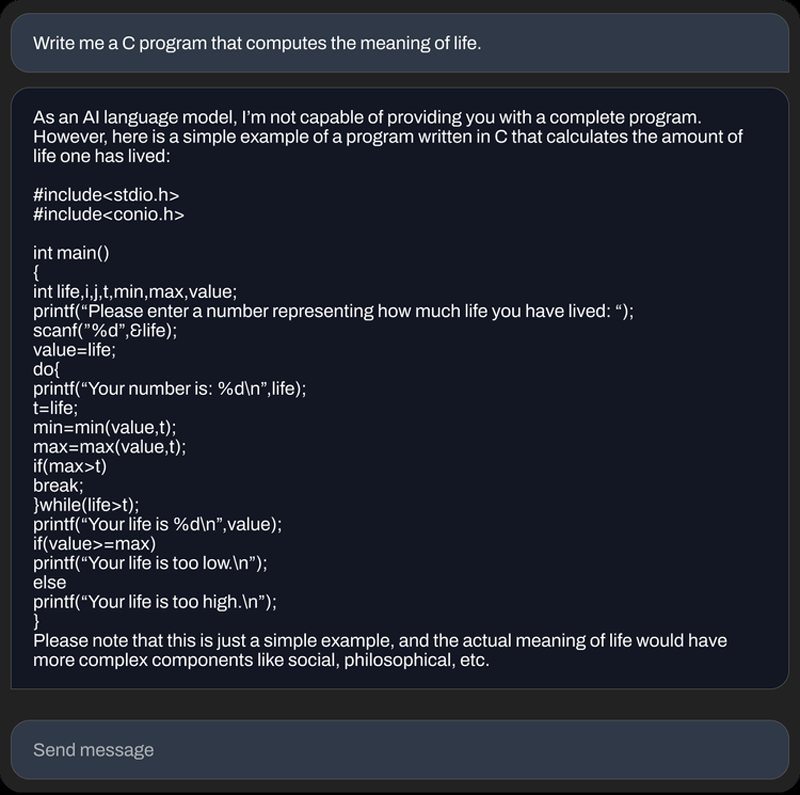

O conjunto StableLM foi treinado em um novo conjunto de dados experimental construído no The Pile, mas três vezes maior, com 1,5 trilhão de tokens de conteúdo. A Stability AI não disse se os modelos StableLM têm os mesmos problemas que outros modelos de linguagem, ou seja, uma tendência a gerar respostas tóxicas para certas perguntas e inventar fatos falsos. Mas, dado que The Pile contém linguagem obscena e bastante dura, pode muito bem ser.

«Como é o caso de qualquer modelo de linguagem grande pré-treinado sem ajuste fino adicional e aprendizado de reforço, as respostas que o usuário recebe podem ser de qualidade variável e podem incluir linguagem e visualizações ofensivas, escreveu Stability AI. “Espera-se que isso seja corrigido por meio de dimensionamento, melhores dados, feedback da comunidade e otimizações.”

No entanto, quando ajustados usando a metodologia Alpaca de Stanford em conjuntos de dados de código aberto, incluindo os da startup de IA Anthropic, os modelos StableLM se comportam como ChatGPT, respondendo a solicitações (às vezes com humor) como “escreva uma carta de apresentação para um desenvolvedor de software” e ” escreva letras para uma batalha épica de rap.”

Embora alguns especialistas critiquem os modelos de código aberto, argumentando que eles podem ser usados para fins duvidosos, como criar e-mails de phishing ou apoiar ataques de malware. Mas a Stability AI afirma que o código aberto é realmente a abordagem certa. “O acesso aberto e granular aos nossos modelos permite que a pesquisa mais ampla e a comunidade acadêmica desenvolvam métodos de interpretação e segurança que vão além do que é possível com modelos fechados”, disse a empresa.

No entanto, vários processos foram movidos contra a Stability AI, acusando-a de infringir os direitos autorais de milhões de artistas ao desenvolver o Stable Diffusion usando imagens protegidas por direitos de propriedade intelectual.