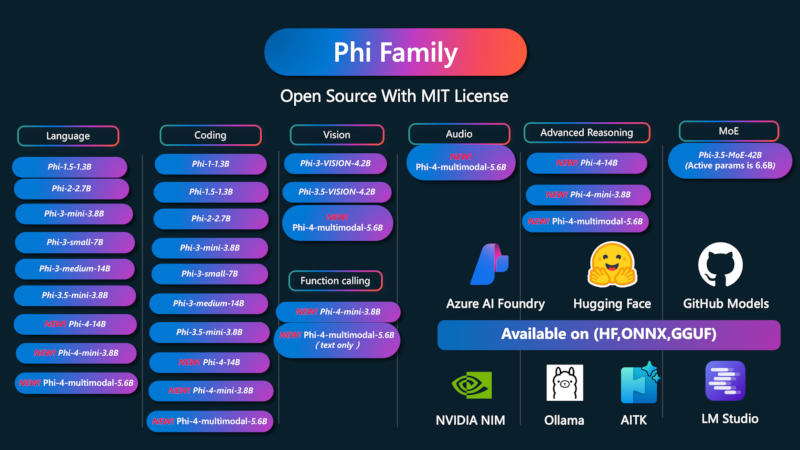

A Microsoft expandiu sua linha de grandes modelos de linguagem de inteligência artificial Phi-4 com dois novos projetos com requisitos de sistema relativamente modestos. Uma delas é multimodal, ou seja, trabalha com diversos formatos de dados.

Fonte da imagem: microsoft.com

O modelo Microsoft Phi-4-mini é somente texto, enquanto o Phi-4-multimodal é uma versão aprimorada que também pode lidar com consultas visuais e de áudio. Ambos os modelos, afirma o desenvolvedor, superam significativamente alternativas de tamanho comparável ao executar determinadas tarefas.

O Microsoft Phi-4-mini tem 3,8 bilhões de parâmetros, o que significa que é compacto o suficiente para ser executado em dispositivos móveis. O modelo é baseado em uma versão especial da arquitetura Transformer. Na versão padrão, os modelos transformadores analisam o texto antes e depois de cada palavra para entender o significado; Ao desenvolver o Phi-4-mini, a Microsoft usou uma versão do Decoder-Only Transformer que analisa apenas o texto que precede uma palavra, reduzindo a carga nos recursos de computação e aumentando a velocidade do processamento de dados.

Para otimização adicional, foi usada a tecnologia Grouped Query Attention – esse mecanismo ajuda o modelo a determinar quais fragmentos de dados são mais relevantes ao processar a tarefa atual. Phi-4-mini pode gerar texto, traduzir documentos e controlar aplicativos externos; O modelo, de acordo com seus desenvolvedores, se destacou na resolução de problemas matemáticos e na escrita de códigos de computador, mesmo quando era necessário “raciocínio complexo”. A precisão das respostas do Phi-4-mini, de acordo com a própria Microsoft, é “significativamente” superior aos resultados fornecidos por vários outros modelos de tamanho semelhante.

Phi-4-multimodal é uma versão estendida do Phi-4-mini com 5,6 bilhões de parâmetros; Ele aceita não apenas texto, mas também imagens, áudio e vídeo como consultas. Para treinar ainda mais o modelo, a Microsoft usou um novo método chamado Mistura de LoRAs. Normalmente, adaptar uma IA a uma nova tarefa requer a alteração de seus pesos — parâmetros de configuração que determinam como ela processa os dados. Para facilitar essa tarefa, o método LoRA (Low-Rank Adaptation) é usado: um pequeno número de novos pesos otimizados para essa tarefa são adicionados ao modelo para executar uma tarefa desconhecida. O método Mixture of LoRAs adapta esse mecanismo ao processamento de dados multimodais: ao desenvolver o Phi-4-multimodal, o Phi-4-mini original foi complementado com pesos otimizados para trabalhar com áudio e vídeo. Como resultado, disse a Microsoft, foi possível suavizar alguns dos comprometimentos associados a outras abordagens para a construção de modelos multimodais.

Em testes envolvendo processamento visual, o Phi-4-multimodal obteve 72 pontos, um pouco atrás dos principais modelos da OpenAI e do Google. No processamento simultâneo de vídeo e áudio, ele superou “por uma ampla margem” o Google Gemini-2.0 Flash, bem como o InternOmni de código aberto. Phi-4-mini e Phi-4-multimodal estão disponíveis na plataforma Hugging Face sob uma licença do MIT, que permite seu uso comercial.